AIにおける透明性の重要性

AIを知りたい

先生、「AIの透明性」って、なんだか難しいです。具体的にどういうことか、教えてもらえますか?

AIエンジニア

そうだね、少し難しい言葉だね。「AIの透明性」とは、AIがどのように考えて答えを出したのか、その過程が誰にでも分かるようにすることだよ。 例えば、コンピューターがどうやって計算しているか、中身が見えるようなイメージだね。

AIを知りたい

なるほど。中身が見えるようにする、ということですね。でも、なぜそれが大切なのですか?

AIエンジニア

大切な理由はいくつかあるよ。例えば、AIが間違った答えを出した場合、その原因を特定しやすくなる。 また、AIが公平な判断をしているかを確認するためにも、透明性は重要なんだ。

透明性とは。

人工知能にまつわる言葉である『透明性』について説明します。『透明性』とは、本来、ガラス箱の中身がすけて見えるように、中身がはっきりと見える状態のことを指します。人工知能や機械学習でも同じ意味で使われます。つまり、機械学習の過程全体や、それぞれの段階の内容が、誰にとっても分かりやすい状態のことを『透明性』といいます。

透明性とは

透明性とは、物事の様子や内容がはっきりと分かることを指します。まるで澄んだ水のように、底まで見通せる状態を想像してみてください。例えば、ガラスのコップにジュースを注げば、何のジュースが入っているか、どれくらいの量が入っているかすぐに分かります。これが透明性です。

人工知能の分野でも、同じように透明性の考え方が大切です。人工知能がどのように考え、どのように答えを出したのかが分かる状態を透明性が高いといいます。人工知能は、大量のデータから特徴を学び、それをもとに判断や予測を行います。この学習の過程や判断の理由が分かることが、人工知能の透明性を高める上で重要です。

もし、人工知能がどのように動いているのか分からなければ、まるで中身の見えない黒い箱のようです。このような状態では、人工知能が出した答えが本当に正しいのか、なぜそのような答えになったのか分かりません。その結果、人工知能に対する信頼が得られにくくなります。例えば、病気の診断を人工知能に任せる場合、どのように診断したのか分からないと不安ですよね。

透明性を高めるためには、人工知能がどのようなデータを使って学習したのか、どのような計算で答えを出したのかを明らかにする必要があります。そうすることで、人工知能の判断の根拠を理解し、信頼性を高めることができます。また、人工知能が間違った判断をした場合でも、その原因を特定しやすく、改善に繋げられます。さらに、意図しない差別や偏見がないかを確認し、より公平で倫理的な人工知能を開発するためにも、透明性は欠かせない要素です。透明性のある人工知能は、人々の生活をより豊かに、より安全にするために不可欠です。

| 項目 | 説明 |

|---|---|

| 透明性とは | 物事の様子や内容がはっきりと分かること |

| AIにおける透明性 | AIがどのように考え、どのように答えを出したのかが分かる状態 |

| AIの透明性の重要性 | AIの信頼性を高めるため。判断の根拠を理解し、誤りの原因を特定しやすく、改善に繋げられる。また、差別や偏見の確認にも役立つ。 |

| 透明性を高める方法 | AIが使用したデータや計算方法を明らかにする |

| 透明性のメリット | 信頼性の向上、誤り原因の特定と改善、公平で倫理的なAI開発 |

透明性の必要性

近ごろ、機械の知恵ともいうべき技術が、目覚ましい進歩を遂げています。暮らしの様々な場面で、この技術の活躍が見られるようになりました。それと同時に、この技術の判断の筋道を明らかにすること、すなわち透明性を確保することの大切さが、一層増しています。

特に、病気を診たり、車を自動で走らせたり、お金の取引をしたりといった、私たちの生活や安全に直結する分野では、この技術がどのように考えて答えを出したのかを、はっきりと理解することが欠かせません。もし、この技術が間違った答えを出してしまった場合、なぜ間違えたのかを突き止め、二度と同じ間違いを繰り返さないようにするためにも、透明性は必要不可欠です。

また、この技術による不公平な扱いや、偏った考え方を防ぐためにも、判断の筋道が分かる仕組みを作ることが大切です。この技術は、学習に使った情報に含まれる偏りをそのまま反映してしまうことがあります。そのため、どのような情報を学習に使ったのか、また、どのような仕組みで答えを出しているのかを明らかにすることで、偏りを抑え、公平な判断を促すことができます。

さらに、この技術を使う人々が、その判断を理解し、納得した上で使うためにも、透明性は必要です。難しい計算や複雑な仕組みで答えを出すこの技術は、まるで魔法の箱のように思えるかもしれません。しかし、魔法ではなく、明確な根拠に基づいて判断していることを示すことで、人々の信頼を得ることができ、安心して技術を活用できるようになります。透明性を高めることで、この技術はより安全で、より信頼できるものとなり、私たちの暮らしをより豊かにしてくれるでしょう。

| 観点 | 説明 |

|---|---|

| 安全性 | 誤作動の原因究明や再発防止のため、判断過程の理解が不可欠。特に医療、自動運転、金融など、生活や安全に直結する分野で重要。 |

| 公平性 | 学習データの偏りによる不公平な判断や差別を避けるため、学習データと判断メカニズムの透明化が必要。 |

| 信頼性 | 利用者が技術の判断根拠を理解し納得することで、信頼感が向上し、安心して技術を活用できる。 |

透明性確保の難しさ

人工知能の働きを分かりやすく示すことは、想像以上に難しい問題です。特に、深層学習という複雑な仕組みを使った人工知能の場合、判断の過程がとても入り組んでいて、人が理解するのは容易ではありません。

深層学習では、莫大な量のデータから複雑な繋がりを学びます。そのため、なぜそのような結果になったのかを説明することが難しくなります。これは、人が何かの判断をするときに、論理的な説明が難しい「直感」に頼るのと似ています。説明を求められても、なぜそう思ったのかを明確に言葉にするのが難しいのと同じです。

また、会社にとって、人工知能の仕組みは重要な企業秘密です。他社に差をつけるためには、詳しい内容を公開したくありません。人工知能の開発には多大な費用と時間がかかっているため、簡単に公開してしまうと、競合他社に真似されてしまう恐れがあります。これは、会社の利益を守る上で重要な点です。

しかし、分かりやすさを軽視してしまうと、人工知能に対する不信感が生まれてしまい、社会に広く受け入れられることを妨げる可能性があります。人工知能がどのように判断しているのか分からないと、人は不安を感じ、使うことをためらってしまいます。例えば、自動運転車に安全を任せられるのか、あるいは、人工知能を使った医療診断を信頼できるのか、といった不安です。

そのため、分かりやすさと企業秘密の両立は、人工知能開発における大きな課題となっています。社会に受け入れられる人工知能を実現するためには、どのようにバランスを取っていくのか、真剣に考える必要があります。今後の技術開発やルール作りにおいて、この点が重要な鍵となるでしょう。

| 課題 | 説明 |

|---|---|

| 説明の難しさ | 深層学習の複雑な仕組みと、人間の「直感」に似た判断過程のため、説明が困難。 |

| 企業秘密の保護 | 人工知能の仕組みは企業の競争優位に関わるため、公開は避けたい。 |

| 社会の理解と信頼 | 分かりやすさが不足すると、人工知能への不信感や不安につながる。 |

| 両立の必要性 | 分かりやすさと企業秘密のバランスが、社会に受け入れられる人工知能の実現には不可欠。 |

透明性向上の取り組み

人工知能の利用が広まるにつれて、その判断の過程が不透明であることが懸念されています。まるで魔法の箱のように、入力すると結果が出てくるだけで、なぜそのような結果になったのかが分かりにくいのです。この問題に対処するために、人工知能の透明性を高めるための様々な研究開発が行われています。

その一つが、説明可能な人工知能、分かりやすく言えば説明できる人工知能の技術です。これは、人工知能の判断の道筋を人が理解できる形に説明できるようにする技術です。例えば、家の値段を予測する人工知能があるとします。従来の方法では、家の広さや築年数などの情報を入力すると、予測価格が出てくるだけでした。説明できる人工知能では、どの情報が価格に大きく影響したか、例えば「駅からの近さが価格に最も影響を与え、次いで広さが影響を与えている」といった形で示すことができます。これにより、人工知能の判断の根拠が分かりやすくなり、利用者は安心して使うことができます。

また、人工知能の仕組み自体を分かりやすくする取り組みも進んでいます。複雑な計算式を何層にも重ねた従来の人工知能は、専門家でも理解が難しいものでした。そこで、より単純で解釈しやすい仕組みにすることで、なぜそのような判断に至ったのかを理解しやすくする試みがなされています。

さらに、人工知能の学習内容や設計に関する情報を公開することも、透明性を高める上で重要です。どのような情報を元に学習したのか、どのような考え方に基づいて作られたのかが分かれば、利用者はその人工知能の特性を理解し、適切に利用することができます。まるで製品の成分表示のように、人工知能の中身を公開することで、利用者の理解と信頼を得ることが期待されます。これらの取り組みによって、人工知能はより信頼できる技術となり、社会にとってより有益なものになると考えられています。

| 対策 | 説明 | 例 |

|---|---|---|

| 説明可能なAI | AIの判断の道筋を人が理解できる形に説明する技術 | 家の価格予測AI:駅からの近さ、広さなどが価格に与える影響を提示 |

| AIの仕組みの簡素化 | 複雑な計算式を何層にも重ねた従来のAIを、より単純で解釈しやすい仕組みにする | – |

| AIの学習内容・設計情報の公開 | AIの学習データや設計思想を公開し、利用者の理解を促進 | 製品の成分表示のようにAIの中身を公開 |

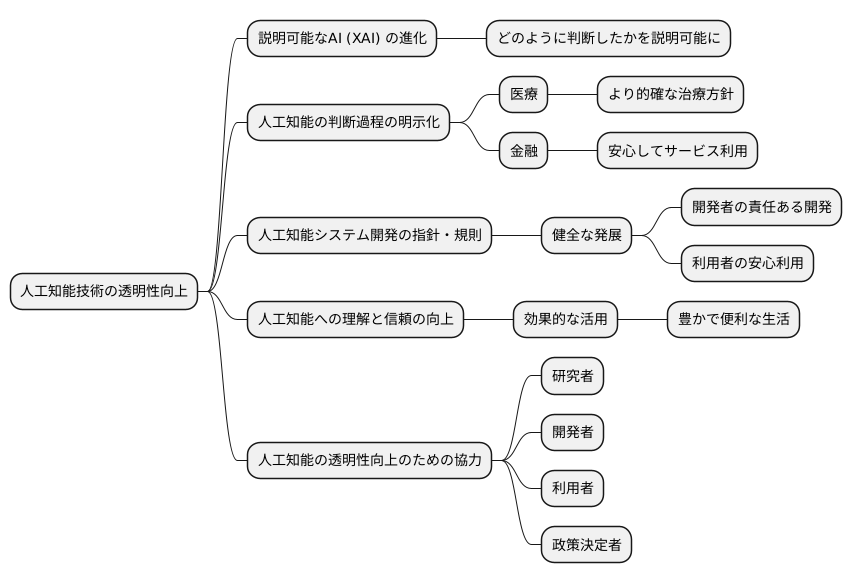

今後の展望

人工知能技術は、まるで毎日新しく生まれ変わるかのように急速な発展を遂げており、同時に、その仕組みを誰にでも分かるようにするための技術開発も、絶え間なく続けられています。説明可能な人工知能(エックスエーアイ)技術がさらに進化することで、人工知能がどのように判断を下したのかを、より詳しく説明できるようになると期待されています。

人工知能の判断過程を明らかにすることは、私たちの生活に大きな影響を与えます。例えば、医療の分野では、人工知能が診断を下した根拠が分かれば、医師はより的確な治療方針を立てることができます。また、金融の分野では、融資の可否を判断する際に、人工知能がどのような要素を重視したのかが分かれば、利用者は安心してサービスを利用することができます。

人工知能システムを作る際に、その仕組みを分かりやすくするための指針や規則も必要となるでしょう。これは、人工知能技術の健全な発展を促す上で非常に重要です。明確なルールがあれば、開発者はより責任を持って人工知能システムを開発することができますし、利用者も安心して人工知能技術を利用することができます。

人工知能の仕組みが分かりやすくなれば、社会全体の人工知能に対する理解と信頼は深まり、より効果的に活用できるようになります。人工知能は、私たちの生活をより豊かに、より便利にするための強力な道具です。しかし、その力を最大限に発揮するためには、人々の理解と協力が不可欠です。人工知能がどのように機能し、どのような影響を与えるかを理解することで、私たちはより積極的に人工知能技術を活用し、その恩恵を享受することができます。

人工知能が社会にとって本当に役立つものとなるためには、その仕組みを分かりやすくし、人々の理解と協力を得ることが欠かせません。そのためには、研究者や開発者、利用者、そして政策を決める人など、様々な立場の人々が協力し、人工知能の透明性を高めるための努力を続けていく必要があります。人工知能の未来は、私たちがどれだけその仕組みを分かりやすくすることに取り組むかによって大きく変わってくるでしょう。

まとめ

人工知能の透明性を確保することは、信頼できる、公平な、倫理にかなった、そして社会に受け入れられる人工知能を実現するために、欠かすことのできない要素です。人工知能がどのように判断を下すのか、どのような情報に基づいて結論に至るのかを明らかにすることで、人々は人工知能を安心して利用できるようになります。もしも人工知能の内部の仕組みが不透明であれば、その判断の正当性を検証することが難しく、誤った判断や偏った結果につながる可能性も懸念されます。

人工知能の透明性を高めるためには、技術的な課題を克服する必要があります。複雑なアルゴリズムや膨大なデータを扱う人工知能の内部構造を分かりやすく説明する技術や、判断の根拠を明確に示す技術の開発が重要です。同時に、倫理的な側面や社会的な影響についても深く考える必要があります。例えば、個人情報保護の観点から、どこまで情報を公開することが適切なのか、透明性を追求することでプライバシーが侵害されるリスクはないかなどを慎重に検討する必要があります。また、人工知能が社会に与える影響についても、多角的な視点から議論を深め、潜在的なリスクを最小限に抑える対策を講じる必要があります。

人工知能技術の進歩に伴い、透明性確保のための技術開発や規則作りも進展していくことが望まれます。研究者、技術者、政策立案者、そして私たち一般市民が協力し、人工知能の健全な発展に向けて取り組むことが大切です。人工知能は社会に大きな恩恵をもたらす可能性を秘めた強力な道具です。しかし、その可能性を最大限に引き出し、恩恵を享受するためには、透明性を何よりも重視し、責任ある人工知能の開発と活用を推進していく必要があります。私たち一人ひとりが人工知能の透明性について理解を深め、人工知能とどのように共存していくかを考えていくことが、より良い未来を築くために不可欠です。人工知能の透明性を確保することで、私たちは人工知能を信頼し、その恩恵を享受しながら、共に未来を創造していくことができるでしょう。

| 項目 | 説明 |

|---|---|

| 人工知能の透明性の重要性 | 信頼できる、公平な、倫理にかなった、そして社会に受け入れられるAIを実現するために不可欠。AIの判断根拠を明らかにすることで、人々は安心してAIを利用できる。 |

| 透明性確保のための課題 | 技術的な課題:複雑なアルゴリズムや膨大なデータを扱うAIの内部構造を分かりやすく説明する技術、判断根拠を明確に示す技術の開発が必要。 倫理的・社会的側面:個人情報保護の観点からの情報公開範囲、プライバシー侵害リスク、AIの社会への影響、潜在的リスクへの対策など、多角的な視点からの検討が必要。 |

| 透明性確保のための取り組み | AI技術の進歩に伴い、透明性確保のための技術開発や規則作りも進展していく必要性。研究者、技術者、政策立案者、一般市民の協力が重要。責任あるAIの開発と活用を推進。 |

| 期待される成果 | AIの恩恵を最大限に引き出し、AIと共存する未来を創造。 |