AMSBound:最適化の新たな挑戦

AIを知りたい

先生、『AMSBound』って、AMSGradに何か制限を加えたものですよね?AdaBoundと似たようなものですか?

AIエンジニア

そうだね。『AMSBound』はAMSGradの学習率に上限と下限を設けたものだよ。AdaBoundがAdamに制限を加えたように、AMSBoundはAMSGradに同じような制限を加えているんだ。

AIを知りたい

AMSGradはAdamの欠点を解消しようとしたんですよね? なぜAMSBoundが必要なのですか?

AIエンジニア

AMSGradは学習率が大きすぎるのを抑えることはできたけど、今度は小さすぎる学習率が問題になったんだ。そこで、AMSBoundで学習率に上限と下限を設けることで、その問題を解決しようとしたんだよ。

AMSBoundとは。

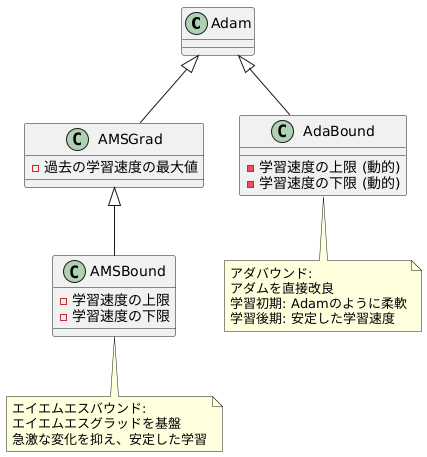

人工知能で使われる言葉「AMSBound」について説明します。AMSBoundは、AMSGradという学習方法の学習速度に上限と下限を設定したものです。機械学習の最適化手法の一つであるAdamは、最初の学習は速いのですが、なかなか最終的な答えにたどり着かないという欠点がありました。この欠点を解消するために作られたのがAMSGradです。AMSGradは大きすぎる学習速度を抑えましたが、今度は小さすぎる学習速度が問題となり、Adamとほぼ同じくらいの精度になってしまいました。ちなみに、Adamにも同じような制限を加えたものがAdaBoundです。

はじめに

機械学習は、多くの情報から規則性を見つけ出し、未来の予測や情報の分類といった作業を行う強力な方法です。この学習の過程で、学習の効率や正確さを左右するモデルのパラメータ調整は非常に重要です。この調整を行うのが最適化アルゴリズムで、モデルの性能を高める役割を担っています。近年、様々な最適化アルゴリズムが提案されています。その中で、Adamは広く使われている手法の一つです。Adamは、学習の初期段階ではパラメータ調整の速度が速く、効率的に学習を進められるという利点があります。しかし、学習が進むにつれて速度が落ち、最終的な精度に達するまで時間がかかるという弱点も抱えています。つまり、最初は勢いよく学習が進むものの、最後の方はなかなか目標にたどり着かないイメージです。このAdamの弱点を克服するために、AMSGradという改良版が提案されました。AMSGradは、Adamの速度を維持しつつ、最終的な精度を高めることを目指した手法です。しかし、パラメータ調整の幅を制限しすぎた結果、学習の柔軟性が失われ、場合によってはAdamよりも性能が劣るという新たな問題が生じました。これは、慎重になりすぎて、最適な調整を見逃してしまうことに例えられます。そこで、これらの問題を解決するために、AMSBoundという新たな手法が開発されました。AMSBoundは、Adamの初期の学習速度の速さを維持しつつ、AMSGradのようにパラメータ調整の幅を過度に制限することなく、安定した学習を実現します。つまり、適切な範囲で調整を行うことで、効率と精度を両立させることを目指した手法と言えるでしょう。本稿では、このAMSBoundについて詳しく説明していきます。

| 手法 | 特徴 | 利点 | 欠点 |

|---|---|---|---|

| Adam | 学習初期は高速、後期は低速 | 初期学習速度が速く、効率的に学習を進められる | 学習が進むにつれて速度が落ち、最終的な精度に達するまで時間がかかる |

| AMSGrad | Adamの改良版、パラメータ調整幅を制限 | Adamの速度を維持しつつ、最終的な精度を高めることを目指す | パラメータ調整の幅を制限しすぎた結果、学習の柔軟性が失われ、Adamよりも性能が劣る場合がある |

| AMSBound | AdamとAMSGradの利点を組み合わせた手法 | Adamの初期の学習速度の速さを維持しつつ、AMSGradのようにパラメータ調整の幅を過度に制限することなく、安定した学習を実現 | (本文中には欠点は明記されていない) |

課題と解決策

機械学習において、最適な結果を得るためには、学習過程における調整が重要です。この調整役を担うのが最適化アルゴリズムであり、その一つにAdamがあります。Adamは、過去の変化の勢い(モーメンタム)と、状況に応じた学習速度の調整を組み合わせることで、効率的な学習を目指します。しかし、Adamには初期の学習速度が速すぎるという問題点があります。これは、例えるなら、山を登る際に一歩が大きすぎて、頂上を通り過ぎてしまうようなものです。最適な解を飛び越えてしまう可能性があり、結果として精度の低下につながることがあります。また、目的とする精度への到達が遅いことも課題です。

これらの問題に対処するために開発されたのがAMSGradです。AMSGradは、過去の変化の最大値を記録し、それを基に学習速度を調整します。急な坂道で一歩の大きさを制限するように、学習速度が大きくなりすぎるのを防ぎます。しかし、AMSGradは学習速度を過度に制限してしまう場合があります。これは、山を登る際に一歩が小さすぎて、なかなか頂上に辿り着けないようなものです。結果として、Adamと同程度かそれ以下の精度しか得られない場合もありました。

そこで、AMSGradの弱点を克服するために、AMSBoundが提案されました。AMSBoundは、AMSGradの学習速度に上限と下限を設定することで、適切な範囲内に学習速度を収めることを目指します。山を登る際に、一歩の大きさを適切な範囲に保つことで、効率的に頂上を目指せるように、AMSBoundはより安定して最適な解へと近づくことを期待されています。これにより、Adamの速度とAMSGradの安定性を兼ね備え、より高精度な学習を実現できる可能性を秘めています。

| アルゴリズム | 特徴 | メリット | デメリット |

|---|---|---|---|

| Adam | モーメンタムと学習速度調整の組み合わせ | 効率的な学習 | 初期学習速度が速すぎる、精度低下、収束速度が遅い |

| AMSGrad | 過去の変化の最大値に基づいた学習速度調整 | 学習速度の急激な増加を抑える | 学習速度を過度に制限、Adamと同等以下の精度になる場合も |

| AMSBound | AMSGradの学習速度に上限と下限を設定 | Adamの速度とAMSGradの安定性を兼ね備える、高精度学習の可能性 | – |

仕組み

学習をうまく進めるための方法のひとつとして、AMSバウンドというものがあります。これは、AMSグラッドという方法をさらに改良したものです。AMSグラッドは、学習の進み具合を調整する値である学習率を、過去の情報をもとに調整することで、より良い結果を得ようとする方法です。しかし、AMSグラッドでは、学習率が大きくなりすぎたり、小さくなりすぎたりすることがあり、これが学習の妨げになる場合があります。

そこで、AMSバウンドでは、学習率に上限と下限を設けることで、この問題を解決しています。

学習の初期段階では、学習率を大きめに設定することで、学習を速く進めます。まるで、目的地まで早く着くために、最初は大きな一歩で進むようなものです。そして、学習が進むにつれて、学習率を徐々に小さくしていきます。目的地に近づくにつれて、小さな一歩で慎重に進むようなものです。これにより、最初は速く学習を進めつつ、最終的にはより正確な結果を得ることができます。

また、学習率の下限を設定することで、学習が停滞するのを防ぎます。これは、目的地まであと少しというところで、足が止まってしまうのを防ぐようなものです。学習率の下限を設定することで、常に一定の速度で学習を進めることができます。

このように、AMSバウンドは、学習率を動的に調整することで、AMSグラッドよりも安定した学習を実現します。Aダムという方法も学習率を調整する方法ですが、AMSバウンドはAダムよりもさらに安定した学習を実現することができます。これは、AMSバウンドが、学習率の上限と下限を動的に調整することで、より適切な学習率を維持することができるためです。

AMSバウンドは、AMSグラッドやAダムといった従来の方法よりも、より安定して効率的に学習を進めることができるため、様々な場面で活用が期待されています。

| 学習方法 | 説明 | 学習率 | 長所 | 短所 |

|---|---|---|---|---|

| AMSGrad | 過去の情報に基づき学習率を調整 | 可変(大きくなりすぎたり、小さくなりすぎたりする可能性あり) | 過去の情報を活用 | 学習率の不安定さ |

| AMSBound | AMSGradを改良。学習率に上限と下限を設定 | 可変(上限と下限あり) | 安定した学習、AMSGradより効率的、Adamより安定 | – |

| Adam | 学習率を調整 | 可変 | – | AMSBoundより不安定 |

AdaBoundとの比較

学習の進め方を調整する手法として、よく知られているものにアダムがあります。このアダムを改良した手法に、エイエムエスバウンドとアダバウンドがあります。どちらもアダムの学習速度に制限を加えることで、より安定した学習を実現しようとしています。

エイエムエスバウンドは、アダムをさらに改良したエイエムエスグラッドを基盤としています。エイエムエスグラッドは、過去の学習速度の最大値を記憶することで、急激な変化を抑え、より安定した学習を可能にします。このエイエムエスグラッドに学習速度の上限と下限を設定することで、エイエムエスバウンドはさらに安定性を高めています。

一方、アダバウンドはアダムを直接改良した手法です。エイエムエスバウンドと同様に学習速度の上限と下限を設定しますが、その設定方法が異なります。アダバウンドでは、学習が進むにつれて、学習速度の上限と下限が徐々に近づいていきます。学習の初期段階では、アダムと同様に柔軟に学習速度を調整し、学習が進むにつれて、徐々に安定した学習速度へと収束させていきます。

どちらの手法が優れているかは、扱う問題やデータの種類によって変わってきます。例えば、画像認識のような複雑な問題では、エイエムエスバウンドの方が良い結果を出す場合もあります。一方、比較的単純な問題では、アダバウンドの方が効率的に学習を進められる場合もあります。そのため、実際にどちらの手法を使うかは、試行錯誤しながら最適な手法を選ぶ必要があります。それぞれの特性を理解し、適切に使い分けることが重要です。

利点

{学習の安定化と収束性の向上という二つの大きな利点が、AMSBoundにはあります。}まず、学習の安定性について説明します。学習率は、機械学習モデルの学習において重要な役割を果たす要素の一つです。この学習率が適切に設定されていないと、学習過程が不安定になり、最適な結果を得ることが難しくなります。AMSBoundは、学習率に上限と下限を設けるという独自の仕組みを持っています。これにより、学習率が大きくなりすぎて学習が振動する事態や、小さくなりすぎて学習が進まなくなる事態を防ぐことが可能です。結果として、安定した学習を実現し、より良い結果へと導きます。

次に、収束性の向上について説明します。機械学習モデルの学習は、最適解を目指す旅のようなものです。AMSBoundは、学習率の調整を通じて、この最適解への到達をよりスムーズにします。学習率の上限と下限を設定することで、モデルは最適解付近で迷うことなく、効率的に最適解へと収束していきます。これは、特に複雑なモデルや大規模なデータセットを扱う場合に大きな効果を発揮します。従来の手法では、学習が停滞したり、発散したりするリスクがありましたが、AMSBoundはこれらの問題を効果的に回避し、安定した収束を実現します。

さらに、AMSBoundは高い汎用性を備えています。画像認識、自然言語処理、音声認識など、様々な種類の機械学習タスクに適用できます。そのため、特定のタスクに特化した手法と異なり、幅広い分野で高い性能を発揮することが期待されます。AMSBoundは、複雑なモデルや大規模なデータセットにも対応できるため、今後の機械学習の発展に大きく貢献することが期待されています。

| 利点 | 説明 |

|---|---|

| 学習の安定化 | 学習率に上限と下限を設けることで、学習率が大きすぎることによる学習の振動や、小さすぎることによる学習の停滞を防ぎ、安定した学習を実現する。 |

| 収束性の向上 | 学習率の調整を通じて最適解への到達をスムーズにし、複雑なモデルや大規模なデータセットでも効率的に最適解へと収束させる。 |

| 高い汎用性 | 画像認識、自然言語処理、音声認識など、様々な機械学習タスクに適用可能。 |

今後の展望

機械学習の分野において、学習を効率的に進めるための最適化手法は大変重要です。様々な手法が提案されていますが、その一つにAMSBoundがあります。AMSBoundは比較的新しい手法であり、今後の研究によって更なる発展が期待されています。

まず、学習率の調整機構の改良が挙げられます。AMSBoundは学習率の上限と下限を設定することで、学習の安定化を図っています。しかし、この上限と下限の値は、扱う問題によって適切な値が異なります。そのため、問題の種類に応じて自動的に調整する仕組みが開発されれば、より使い勝手が向上するでしょう。

次に、様々な課題への適用事例を増やすことが重要です。現在、AMSBoundは画像認識や自然言語処理など、限られた分野での適用事例しか報告されていません。今後、様々な分野の課題に適用し、その有効性を検証することで、AMSBoundの適用範囲の拡大につながると期待されます。具体的には、音声認識や時系列データ解析など、他の分野への適用が考えられます。

さらに、他の最適化手法との組み合わせも研究の余地があります。例えば、モーメンタム法やAdamなどの既存の手法と組み合わせることで、それぞれの長所を生かし、短所を補うことが期待できます。この相乗効果によって、より高い性能の最適化手法が実現する可能性があります。

このように、AMSBoundは今後の発展が期待される最適化手法です。更なる研究開発によって、機械学習の最適化アルゴリズムの進化に大きく貢献する可能性を秘めていると言えるでしょう。

| 改良点 | 内容 | 期待される効果 |

|---|---|---|

| 学習率の調整機構の改良 | 学習率の上限と下限の値を、問題の種類に応じて自動的に調整する仕組みの開発 | 使い勝手の向上 |

| 様々な課題への適用事例を増やす | 画像認識や自然言語処理以外の分野(音声認識、時系列データ解析など)への適用 | AMSBoundの適用範囲の拡大 |

| 他の最適化手法との組み合わせ | モーメンタム法やAdamなどの既存の手法との組み合わせ | それぞれの長所を生かし、短所を補う相乗効果による、より高い性能の最適化手法の実現 |