AIと安全保障:軍事技術の未来

AIを知りたい

先生、「自律型兵器」って難しそうでよくわからないんですけど、どういうものなんですか?

AIエンジニア

そうだね、難しいよね。簡単に言うと、人間が操作しなくても、AIが自分で判断して攻撃する兵器のことだよ。例えば、ドローンが自分で標的を見つけて攻撃するようなものを想像してみて。

AIを知りたい

えー、怖いですね。それって安全なんですか?

AIエンジニア

まさにそこが問題なんだ。AIの判断が常に正しいとは限らないし、誤作動で人を傷つけてしまう可能性もある。だから、国連などでも議論されているんだよ。倫理的な問題もたくさんあるんだね。

AIと安全保障・軍事技術とは。

人工知能に関わる言葉である「人工知能と安全保障・軍事技術」について説明します。人工知能と安全保障や軍事技術に関する話し合いでよく取り上げられるのは、自分で判断して攻撃を行う兵器のことです。この種の兵器の研究は中止するべきだという議論が2017年から国際連合で始まりました。また、グーグルでもアメリカ国防総省と共同で研究していた人工知能技術を使った無人飛行機について、社員からの反対を受けて2018年に計画から撤退しました。

AI兵器の倫理的課題

人工知能(AI)技術の急速な発展は、安全保障と軍事のあり方に大きな変化をもたらしています。中でも、人間の判断を介さずに標的を選び、攻撃を実行できる自律型兵器システム(AWS)の登場は、様々な倫理的問題を提起しています。この技術がもたらす潜在的な危険性について、専門家や市民団体から多くの懸念の声が上がっており、世界規模での議論の必要性が高まっています。

自律型兵器システムは、プログラムの誤りや外部からの不正アクセスによって制御を失う可能性があり、想定外の被害を生み出す危険性が懸念されています。人間が操作する兵器とは異なり、機械の判断で攻撃が行われるため、責任の所在が曖昧になるという問題も存在します。誰が誤作動による被害の責任を負うのか、明確な基準を設けることが重要です。また、AI兵器の開発競争が激化すると、各国が軍事力を増強しようと競い合い、世界全体の緊張が高まる可能性も指摘されています。歴史的に見ても、新たな兵器の登場は軍拡競争を招き、国際関係を不安定化させる要因となってきました。AI兵器も例外ではなく、無制限な開発競争は避けるべきです。

さらに、AI兵器は人間の命を奪うという究極の判断を機械に委ねることになります。これは、人間の尊厳や生命の価値といった倫理的な根幹に関わる問題です。戦争における人間の役割や、倫理的な責任について、改めて深く考える必要があります。AI兵器の開発と使用に関する明確な国際的なルールや規制の策定は、喫緊の課題と言えるでしょう。早急に国際社会が協力し、AI兵器の開発と使用に関する明確なルール作りに取り組む必要があります。人道的な観点から、AI兵器の使用に関する倫理的な指針を確立し、国際的な合意を形成することが不可欠です。未来の平和と安全保障のために、今こそ真剣に取り組むべき重要な課題です。

| 懸念事項 | 詳細 |

|---|---|

| 制御不能の危険性 | プログラムの誤りや不正アクセスにより、AWSが制御不能になり、想定外の被害が発生する可能性。 |

| 責任所在の曖昧さ | 機械の判断で攻撃が行われるため、誤作動による被害の責任の所在が不明確。 |

| 軍拡競争の激化 | AI兵器の開発競争が、国家間の軍事力増強競争を招き、世界全体の緊張を高める可能性。 |

| 倫理的問題 | 人間の命を奪う判断を機械に委ねることの倫理的な問題。人間の尊厳、生命の価値への影響。 |

| 国際ルール・規制の欠如 | AI兵器の開発と使用に関する明確な国際的なルールや規制が不足。 |

自律型兵器をめぐる国際的な議論

近年、戦闘の場で人間の判断を介さずに標的を選定し攻撃する兵器、いわゆる自律型兵器に関心が集まっています。正式には自律型兵器システム(AWS)と呼ばれ、人工知能(AI)技術の急速な発展とともに、その実現可能性が高まってきました。これに伴い、国際的な議論も活発化しています。

2017年より、国連の特定通常兵器使用禁止制限条約(CCW)の枠組みにおいて、自律型兵器に関する公式な協議が始まりました。この条約は、人道上の観点から過度に危害を与えたり、無差別に被害をもたらしたりする兵器の使用を制限することを目的としています。自律型兵器もこの条約の対象となる可能性があるとして、各国が議論を続けてきました。

しかし、各国の立場は大きく分かれています。自律型兵器の開発に積極的な国は、将来の戦闘において優位に立つために必要だと主張し、開発を進めています。一方で、多くの国や非政府組織(NGO)は、機械が人間の生死を決定することの倫理的な問題や、誤作動による予期せぬ被害の拡大などを懸念し、国際的な規制を求めています。法的拘束力のある規制を作るべきだという意見と、技術革新を阻害するとして規制に反対する意見が対立し、議論は難航しています。

国際的な合意形成にはほど遠いのが現状です。自律型兵器の定義や、どこまでを人間の制御下に置くべきかなど、基本的な事項についても意見の一致を見ていません。また、仮に規制ができたとしても、すべての国が遵守する保証はなく、実効性を確保するための課題も残されています。自律型兵器をめぐる国際的な議論は、国際社会の安全保障とAI技術の倫理的側面の両方に大きな影響を与えるため、今後の動向を注意深く見守る必要があります。

| 項目 | 内容 |

|---|---|

| 自律型兵器システム(AWS) | 人間の判断を介さずに標的を選定し攻撃する兵器。AI技術の発展により実現可能性が高まっている。 |

| 国際的な議論の場 | 国連の特定通常兵器使用禁止制限条約(CCW) |

| 議論の焦点 | 自律型兵器が人道上の観点から過度に危害を与えたり、無差別に被害をもたらしたりする可能性 |

| 各国の立場 | 賛成派:将来の戦闘における優位性を主張 反対派:倫理的問題、誤作動による被害拡大を懸念 |

| 規制をめぐる議論 | 賛成派:法的拘束力のある規制を求める 反対派:技術革新の阻害を懸念 |

| 現状と課題 | 国際的な合意形成にはほど遠い。自律型兵器の定義、人間の制御範囲など、基本的な事項で意見の一致を見ていない。規制の実効性確保も課題。 |

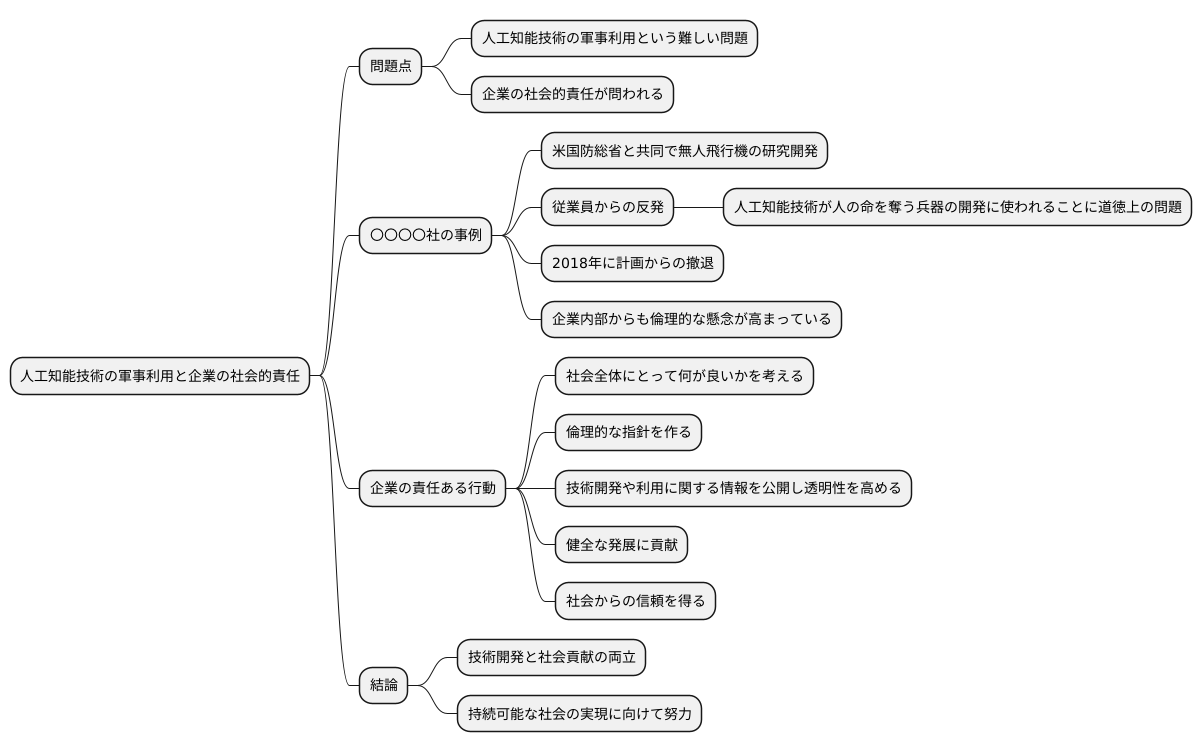

企業の社会的責任

近頃、話題となっている人工知能技術。その技術革新は目覚ましく、様々な分野で活用が広がっています。しかし、その裏側では人工知能技術の軍事利用という難しい問題も存在します。そして、この問題に関連して、企業の社会的責任が問われています。

例えば、情報通信の巨大企業である〇〇〇〇社は、米国国防総省と共同で、人工知能技術を用いた無人飛行機の研究開発を進めていました。しかし、この計画に対し、自社の従業員から強い反発が起こりました。従業員たちは、人工知能技術が人の命を奪う兵器の開発に使われることに、道徳上の問題を感じたのです。そして、この反対運動を受け、〇〇〇〇社は2018年に計画からの撤退を決定しました。

この出来事は、人工知能技術の軍事利用に対する倫理的な懸念が、企業内部からも高まっていることを示す象徴的な出来事となりました。人工知能技術を持つ企業は、自社の技術が軍事目的に利用された場合の影響について、道徳的な観点からしっかりと考える必要があります。そして、責任ある行動をとることが求められます。

具体的にはどのような行動が求められるのでしょうか。まず、社会全体にとって何が良いかを深く考える必要があります。そして、倫理的な指針を作り、技術開発や利用に関する情報を公開することで、透明性を高めることが大切です。このような責任ある行動によって、企業は人工知能技術の健全な発展に貢献できるだけでなく、社会からの信頼も得ることができるでしょう。人工知能技術は大きな可能性を秘めていますが、その利用には責任が伴います。企業は、技術開発と社会貢献の両立を目指し、持続可能な社会の実現に向けて努力していく必要があります。

市民社会の役割

人工知能と安全保障、特に軍事技術に関する議論は、専門家だけの問題ではありません。社会全体、とりわけ市民一人ひとりの考えや行動が、未来を大きく左右する重要な要素となります。この点において、市民社会は特別な役割を担っています。

まず、市民団体や研究機関といった組織は、人工知能を使った兵器の危険性や倫理的な問題点について、広く一般の人々に分かりやすく伝える啓発活動に力を入れています。こうした活動を通して、人工知能と軍事技術の関わりについて、社会全体の関心を高め、国際的な議論を活発化させる役割を担っています。市民の声が高まることで、各国政府や国際機関は政策決定において、民意を無視できなくなります。これは、人工知能技術を平和的に利用するための大きな力となります。

さらに、市民社会は専門的な知識や情報を提供することで、政策を作る担当者や企業に対して、より良い提案を行うことができます。人工知能技術は複雑で難解な部分が多いため、専門家ではない人が理解するのは容易ではありません。市民社会が橋渡し役となることで、技術の専門家と一般の人々との間で、円滑な意思疎通が可能になります。

市民社会は、様々な立場の人々との対話を促す場を作ることも重要です。人工知能技術の倫理的な管理体制を築くためには、開発者、利用者、研究者、そして一般市民など、あらゆる関係者が納得できるルール作りが必要です。市民社会は、それぞれの立場の人々が意見を交換し、合意形成を目指すための話し合いの場を提供することで、より良い社会の実現に向けて貢献しています。

つまり、市民社会は、監視役、助言役、そして調整役という三つの重要な役割を果たすことで、人工知能技術が平和的に、そして人々の幸福のために活用される未来を目指していると言えるでしょう。

| 役割 | 活動内容 | 目的/効果 |

|---|---|---|

| 監視役 | 市民団体や研究機関による啓発活動、AI兵器の危険性や倫理的問題の周知 | 社会全体の関心向上、国際的な議論の活発化、政府や国際機関への政策提言 |

| 助言役 | 専門知識や情報の提供 | 政策担当者や企業への提案、技術専門家と一般市民との円滑な意思疎通 |

| 調整役 | 様々な立場の人々との対話の場の提供 | AI技術の倫理的な管理体制構築のための合意形成、より良い社会の実現 |

将来の課題と展望

人工知能技術は、これからの安全保障と軍事のあり方を大きく変える力を持っており、その進歩は留まることを知りません。人工知能を使った新しい武器や、今までにない戦術が生み出される可能性があり、国際社会全体でこの変化にどう対応していくかが問われています。

人工知能を搭載した兵器の開発や使用に関する国際的なルール作りは急務です。ルールがないまま各国が勝手に開発を進めてしまうと、新たな軍拡競争につながる恐れがあります。各国が協力して、歯止めをかけられる枠組みを作る必要があります。同時に、人工知能技術を平和のために役立てる研究開発も重要です。人の命を守るため、より良い社会を作るために、人工知能の力を活かす方法を探っていく必要があります。

人工知能技術の発展は、私たちに倫理的な問題も突きつけています。例えば、人工知能を搭載した兵器が人の判断なしに攻撃を行うようなことがあってはなりません。倫理的な側面をしっかりと考え、国際社会全体で話し合い、人工知能技術を平和と安全のために役立てていくことが、未来の平和と安全にとって非常に大切です。

人工知能は使い方によっては大きな危険もはらんでいるため、国際的な協調と慎重な検討が必要です。未来の世代に平和な世界を引き継いでいくためにも、今、私たちが責任を持って行動していく必要があります。未来を見据え、知恵を出し合い、協力してこの難題に立ち向かわなければなりません。

| 課題 | 内容 | 対策 |

|---|---|---|

| 軍事利用 | AI兵器、新戦術の出現 | 国際ルール策定、軍拡競争の防止 |

| 平和利用 | 人命保護、より良い社会 | 平和のための研究開発 |

| 倫理問題 | AIの自律的攻撃 | 倫理的な側面の検討、国際的議論 |

| 国際協調 | AIの危険性への対処 | 協調と慎重な検討 |