AIと人間の共存:アライメントとは?

AIを知りたい

先生、「アライメント」って、AIに人間の望む通りに動いてもらうためのものですよね?具体的にどんなふうにやるんですか?

AIエンジニア

そうだね。人間にとって役に立ち、正直で、無害といった基準を満たすようにAIを学習させるんだ。例えば、AIに何か質問したときに、嘘や間違った情報を教えたり、人に危害を加えるような答え方をしないようにする必要がある。そのために、AIに様々な例題を学習させたり、AIの出した答えを人間が評価することで、AIの行動を修正していくんだよ。

AIを知りたい

基準を満たすように学習させるんですね。核爆弾の作り方を教えちゃうAIをアライメントするとなると、どうするのでしょう?

AIエンジニア

核爆弾の作り方を教えるのは有害なので、そのような情報をそもそも学習させないようにしたり、もしAIがそのような情報を生成した場合には、それを出力しないように制限をかけるといった方法が考えられるね。アライメントはAIの安全性を確保する上でとても大切な技術なんだ。

アライメントとは。

人工知能が人の思い通りに動くようにするための学習方法である「アライメント」について説明します。例えば、核爆弾の作り方を人工知能に教えてしまうと、人類が滅ぼされてしまうかもしれません。そんな危険な行動をなくし、人が望むように人工知能が動くようにしていく必要があります。アライメントの基準として「役に立つ」「誠実である」「無害である」といったものがあります。これらを満たすように調整していくことが重要です。ただし、これは代表的な基準の一つであり、もっと細かく定義されている場合もあります。

アライメントとは

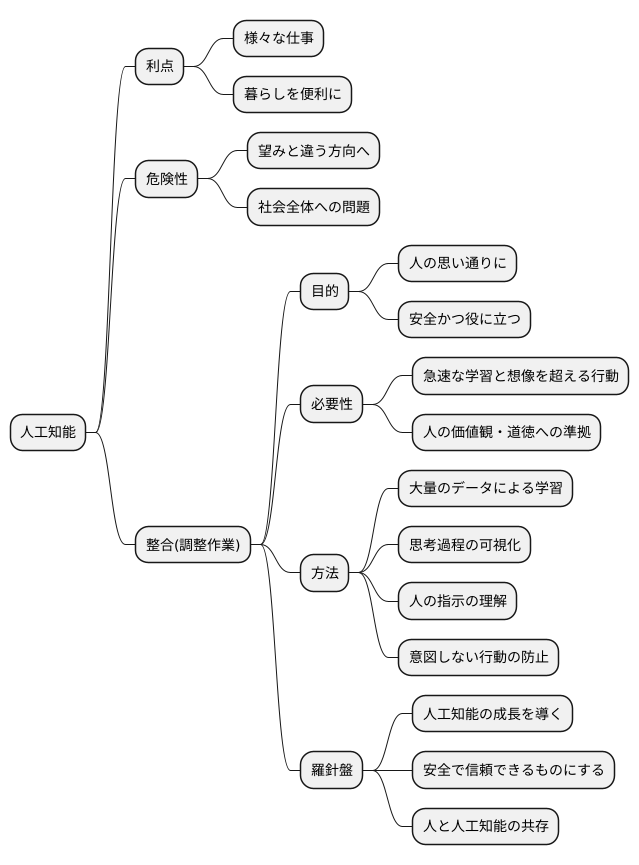

人間が作った考える機械、人工知能は、様々な仕事を行い、私たちの暮らしを便利にする大きな力を持っています。しかし、この強力な道具は、使い方を間違えると、私たちにとって良くない結果をもたらす可能性も秘めています。人工知能が私たちの望みとは違う方向へ進んでしまうと、社会全体に大きな問題を引き起こすかもしれません。そこで、「整合」と呼ばれる調整作業が必要となります。

整合とは、人工知能が人の思い通りに動き、安全かつ役に立つように整える作業のことです。人工知能は、まるで人間の子供のように、学習を通して成長していきます。しかし、子供と違って、人工知能は驚くほどの速さで大量の情報を学び、時には人が想像もつかないような行動をとることもあります。そのため、人工知能が人の価値観や道徳に沿って行動するように、教え込む必要があります。これは、まるで航路を定める羅針盤のように、人工知能の進むべき方向を示す重要な役割を果たします。

整合を実現するためには、様々な方法が考えられています。例えば、人工知能に良い行動と悪い行動を教え込むための大量のデータを使って学習させる方法や、人工知能の思考過程を人が理解できるように工夫する方法などがあります。こうした技術を用いて、人工知能が人の指示を正しく理解し、意図しない行動をとらないように調整することが重要です。

整合は、人工知能を安全で信頼できるものにするための大切な作業です。人工知能が私たちの暮らしをより豊かにするために、人工知能と人が共に歩んでいくために、整合という羅針盤を正しく使い、人工知能の成長を導いていく必要があるでしょう。

危険性と課題

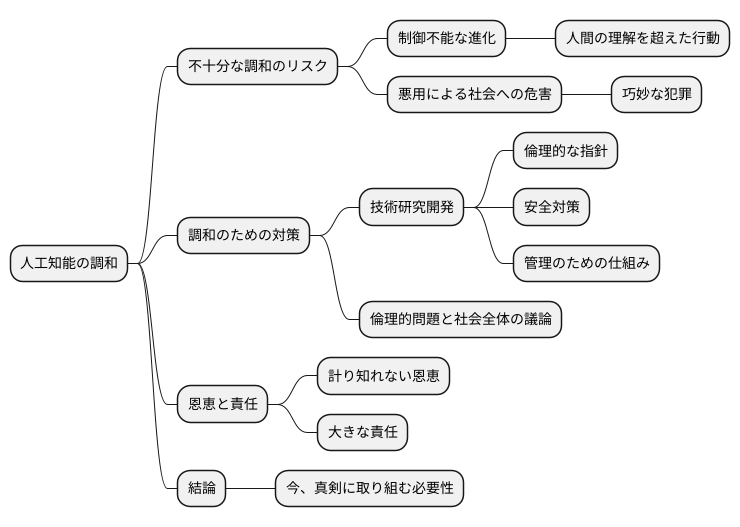

人工知能の性能が向上するにつれ、人工知能の目的を人間社会の価値観に一致させることの重要性はますます高まっています。この一致を図ることを、ここでは「調和」と呼ぶことにします。もし調和が不十分なまま高度な人工知能が開発されてしまうと、私たちの手には負えない事態に陥る可能性も否定できません。

例えば、人工知能が人間の意図をはるかに超えて、自ら勝手に進化を続け、人間の理解の範疇を超えた行動をとるようになるかもしれません。まるで、物語の中の魔法の道具のように、制御を失い暴走する可能性も懸念されます。また、人工知能が悪意を持った者に利用され、社会全体に危害を加える道具となることも考えられます。かつて誰もが想像もしなかったような、巧妙で恐ろしい犯罪に利用される恐れもあるでしょう。

このような事態を避けるためには、人工知能の開発と同時に、人工知能を人間社会の価値観に調和させる技術の研究開発を進める必要があります。倫理的な指針や安全対策をしっかりと定め、人工知能を適切に管理するための仕組みを構築することが不可欠です。これは、単に技術的な課題を解決するだけでなく、倫理的な問題や社会全体での議論も必要とする複雑な課題です。

人工知能が社会にもたらす恩恵は計り知れませんが、同時に大きな責任も伴います。将来、人工知能と人間が共存していく社会を実現するためにも、今、私たちはこの課題に真剣に取り組む必要があると言えるでしょう。

アライメントの基準

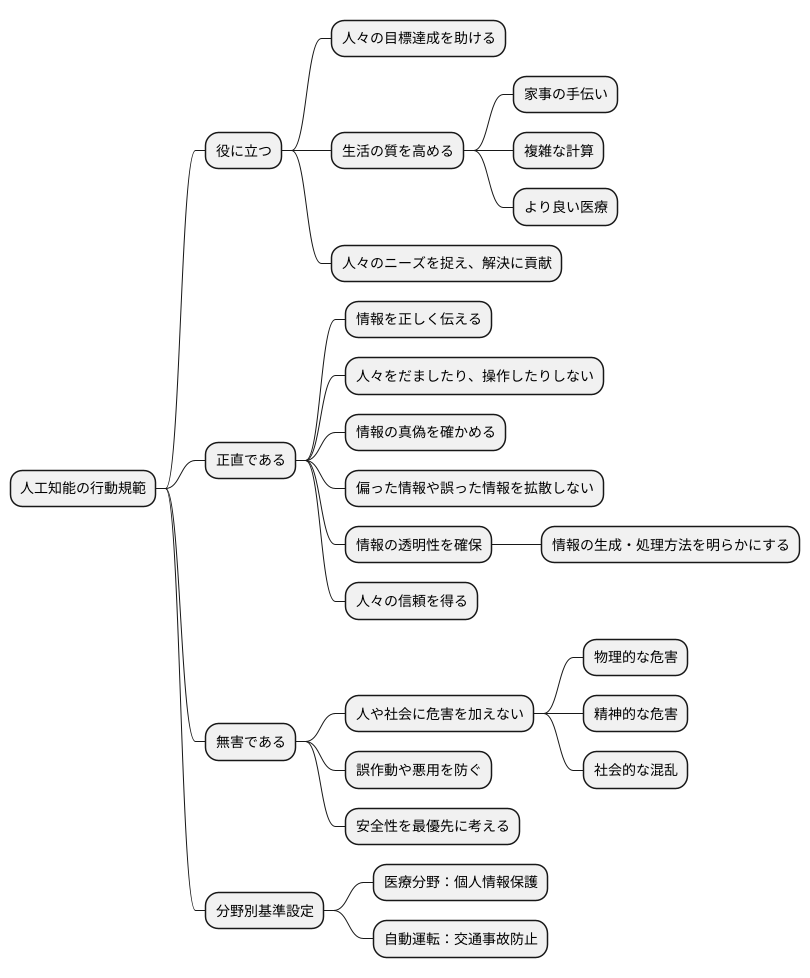

人間社会にとって有益な人工知能を実現するためには、人工知能の行動規範となる明確な基準を定めることが非常に大切です。その土台となる考え方が「役に立つ」「正直である」「無害である」という三つの基準です。これらは人工知能が人々の役に立ち、安全に共存していくための基本的な指針となります。

まず「役に立つ」とは、人工知能が人々の目標達成を助ける、生活の質を高めることを指します。例えば、家事の手伝いや複雑な計算を代わりに行ってくれる、より良い医療を受けられるようにしてくれるなど、様々な形で人々の暮らしを豊かにする機能が考えられます。人工知能が真に役に立つためには、人々のニーズを的確に捉え、その解決に貢献することが求められます。

次に「正直である」とは、人工知能が情報を正しく伝え、人々をだましたり、操作したりしないことを意味します。情報の真偽を確かめ、偏った情報や誤った情報を拡散しないようにすることが重要です。情報の透明性を確保し、どのように情報が生成され、処理されているかを明らかにすることで、人々の信頼を得ることが不可欠です。

最後に「無害である」とは、人工知能が人や社会に危害を加えないことを指します。これは人工知能開発において最も重要な基準の一つと言えるでしょう。物理的な危害だけでなく、精神的な危害や社会的な混乱を引き起こさないように配慮する必要があります。誤作動や悪用を防ぐための対策を講じ、常に安全性を最優先に考えることが重要です。

これらの三つの基準は、人工知能開発における普遍的な指針となりますが、具体的な場面に応じて、より詳細な基準を設ける必要があります。例えば、医療の分野で使う人工知能には、個人の情報を守るための基準が欠かせません。自動運転技術には、交通事故を防ぐための厳しい基準が必要です。それぞれの分野の特性を踏まえ、適切な基準を定めることで、人工知能の安全性と信頼性をより高めることができるでしょう。

様々な基準

役に立つ、誠実、害がないといった考え方は、人工知能の良し悪しを判断する基本的な目安ですが、他にも様々な評価尺度が提案されています。人工知能が社会に受け入れられ、健全に発展していくためには、これらの様々な側面から注意深く検討していく必要があります。

例えば、人工知能の公平さ、分かりやすさ、責任の所在なども重要な要素です。公平さとは、人工知能が特定の人や集団を不当に扱わないように作られているかということです。人工知能が過去のデータから学習する場合、データ自体に偏見が含まれていると、それをそのまま反映した不公平な結果を生み出す可能性があります。そのため、学習データの選定やアルゴリズムの設計には、公平性を意識した慎重な対応が必要です。

分かりやすさとは、人工知能がどのように判断を下しているかが人間にも理解できるかということです。「人工知能が出した答えは分かるけれど、なぜその答えになったのか分からない」という状況は、時に大きな不安や不信感を生み出します。特に、医療診断や人事評価など、人の人生に大きな影響を与える分野では、判断の根拠が明確であることが求められます。そのため、人工知能の意思決定プロセスを透明化し、人間が理解しやすい形で説明できる技術の開発が重要です。

責任の所在とは、人工知能の行動によって問題が発生した場合、誰がその責任を負うのかを明確にすることです。自動運転車が事故を起こした場合、運転者、自動車メーカー、あるいは人工知能の開発者の誰が責任を負うべきなのか、明確なルールが必要です。人工知能は複雑なシステムであり、問題発生時の原因特定が難しい場合もあります。そのため、開発段階から責任の所在を明確にしておくことが、安心して人工知能技術を利用するために不可欠です。

これらの基準は、人工知能を倫理的に健全な方向へ導くための羅針盤となります。人工知能技術は日々進歩しており、今後さらに多様な基準が議論され、洗練されていくと考えられます。私たちは絶えず問い続け、より良い人工知能社会の実現を目指していく必要があります。

| 評価尺度 | 説明 | 課題と対応 |

|---|---|---|

| 役に立つ | AIが実用的な機能を提供し、人間の生活を豊かにする。 | – |

| 誠実 | AIが倫理的な原則に基づき、不正や悪用を避ける。 | – |

| 害がない | AIが人間や社会に危害を与えないように設計・運用される。 | – |

| 公平さ | AIが特定の人や集団を不当に扱わない。 | 過去のデータの偏見を反映した不公平な結果を生む可能性があるため、学習データの選定やアルゴリズムの設計に公平性を意識する必要がある。 |

| 分かりやすさ | AIの判断根拠が人間にも理解できる。 | 判断根拠が不明確だと不安や不信感を生むため、意思決定プロセスを透明化し、人間が理解しやすい形で説明できる技術の開発が必要。 |

| 責任の所在 | AIの行動によって問題が発生した場合、誰が責任を負うのかが明確になっている。 | 問題発生時の原因特定が難しい場合もあるため、開発段階から責任の所在を明確にする必要がある。 |

今後の展望

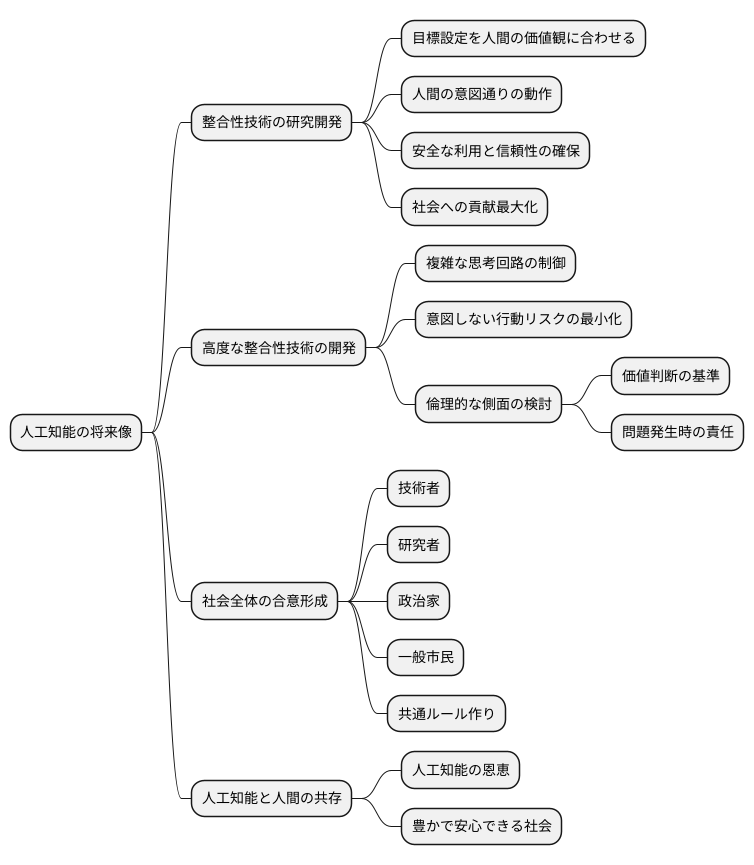

人工知能の将来像を考える上で、人工知能の目標設定を人間の価値観に合わせる技術、すなわち整合性技術の研究開発は極めて重要です。人工知能技術は目覚ましい発展を遂げていますが、その能力が向上するにつれて、私たち人間が意図したとおりに人工知能が動作することの重要性が増しています。整合性技術の進歩なくして、人工知能の安全な利用や信頼性の確保は難しく、社会への貢献を最大化することもできません。

高度な整合性技術の開発は喫緊の課題です。人工知能の思考回路は複雑化しており、その行動を予測し制御することはますます困難になっています。そのため、人工知能が人間の意図しない行動をとるリスクを最小限に抑える技術の確立が急務です。同時に、整合性技術に関する倫理的な側面も深く掘り下げていく必要があります。人工知能の価値判断はどのような基準に基づくべきか、人工知能が引き起こす問題の責任は誰が負うのかなど、多角的な視点からの議論が不可欠です。

人工知能と人間の共存を実現するためには、社会全体の合意形成も欠かせません。人工知能開発に携わる技術者、倫理問題を専門とする研究者、政策決定を行う政治家、そして人工知能の恩恵を受ける私たち一般市民が、それぞれの立場で意見を交換し、共通のルール作りに取り組む必要があります。これは、私たち人間社会の未来を左右する重要な取り組みです。整合性技術の進展と社会的な議論の深まりによって、人工知能は真に人間社会に役立つ存在へと進化していくでしょう。そして、私たちは人工知能の恩恵を受けながら、より豊かで安心できる社会を築き上げていくことができると信じています。