自己注意機構:データの関係性を紐解く

AIを知りたい

先生、「自分自身への注目」って、一体どういう意味ですか?なんだか、自己陶酔みたいでよくわからないです。

AIエンジニア

なるほど。「自分自身への注目」は、文章の中の単語同士の関係性を理解するための仕組みだよ。例えば、「私は猫が好きです。それはとても可愛いです。」という文章があったとしよう。ここで「それ」は何を指しているかわかるかな?

AIを知りたい

「それ」は「猫」のことですよね。

AIエンジニア

正解!「自分自身への注目」は、文章中のそれぞれの単語が、他のどの単語と強く関連しているかを計算することで、「それ」と「猫」の関係性を見つけ出すことができるんだ。つまり、文章全体を理解するために、単語同士の関係性を自分で調べて注目する、というイメージだね。

Self-Attentionとは。

自分自身に注目する仕組み、自己注意機構について説明します。これは、特にトランスフォーマーと呼ばれる技術でよく使われています。 この仕組みでは、注目する対象(クエリ)と、注目する範囲(メモリー)が同じ言葉でできています。

自己注意機構とは

自己注意機構は、情報の塊の中の個々の要素が互いにどのように関わっているかを理解するための巧妙な仕組みです。これは、特に言葉を扱う分野で目覚しい成果を上げており、外国語を私たちの言葉に置き換えたり、長い文章を短くまとめたりする作業などで、その効果が証明されています。

この仕組みは、情報の各部分が他の部分とどのように繋がっているかを計算し、その繋がり具合の強さに応じて、それぞれの部分に重みを付けます。例えば、「青い空」という言葉があった場合、「青い」と「空」は互いに強く関連しています。自己注意機構はこの関連性を数値化し、それぞれの言葉に重みを付けることで、「青い」と「空」が一緒に使われることで生まれる意味を理解します。このように、情報全体の様子を踏まえた上で、それぞれの部分の大切さを適切に見極めることが可能になります。

文章を考えてみましょう。文章の中の個々の言葉の意味は、周りの言葉との関係によって変わることがあります。「明るい」という言葉は、それが「性格」について説明しているのか、「部屋」について説明しているのかによって、受け取る意味合いが変わってきます。自己注意機構は、このような言葉の意味が周りの言葉によって変化する様子を捉え、より正確な理解を可能にします。

従来の方法では、情報の各部分を順番に処理していくため、遠く離れた部分同士の関係を捉えるのが難しかったのです。例えば、長い文章の最初の方に出てきた言葉と、最後の方に出てきた言葉の関係性を理解するのは、従来の方法では困難でした。しかし、自己注意機構は情報全体を一度に見渡すことができるため、部分同士の距離に関係なく、複雑な関係性を捉えることができます。これは、特に長い文章を扱う際に大きな強みとなります。まるで、全体像を把握した上で、それぞれの部分の役割を理解するようなものです。そのため、自己注意機構は、情報の内容をより深く理解する上で、非常に役立つ仕組みと言えるでしょう。

| 機能 | 説明 | 例 | 従来との比較 |

|---|---|---|---|

| 情報の関連性把握 | 情報の塊の中の個々の要素が互いにどのように関わっているかを理解する。それぞれの部分に重みを付ける。 | 「青い空」の「青い」と「空」の関連性を数値化し、重みを付ける。 | 従来の方法では、遠く離れた部分同士の関係を捉えるのが難しかった。 |

| 文脈理解 | 言葉の意味が周りの言葉によって変化する様子を捉え、より正確な理解を可能にする。 | 「明るい」という言葉が「性格」と「部屋」で意味合いが変わる。 | – |

| 長距離依存関係の把握 | 情報全体を一度に見渡すことができるため、部分同士の距離に関係なく、複雑な関係性を捉えることができる。 | 長い文章の最初と最後の言葉の関係性を理解できる。 | 従来の方法では、長い文章の最初の方に出てきた言葉と、最後の方に出てきた言葉の関係性を理解するのは困難だった。 |

変換器における役割

変換器は、近年の言葉に関する情報処理分野で目覚ましい成果をあげている深層学習の模型です。この変換器の心臓部と言えるのが自己注意機構です。変換器が登場する以前は、再帰型ニューラルネットワークが主流でした。これは、言葉の列を一つずつ順番に処理していく方式で、まるで鎖のように繋がれた情報を一つずつ確認していくようなものです。そのため、処理に時間がかかり、また、離れた場所にある言葉同士の関係性を捉えるのが難しいという欠点がありました。

しかし、自己注意機構を用いた変換器は、言葉の列全体を一度に見渡すことができます。例えるなら、鎖ではなく網のように、言葉同士の関係性を全て同時に把握するのです。このため、従来の方式に比べて処理速度が格段に向上し、遠く離れた言葉同士の関係性も捉えることができるようになりました。これは、文章全体の意味を理解する上で非常に重要な点です。

変換器は、大きく分けて符号化器と復号化器という二つの部分から成り立っています。符号化器は、入力された言葉の列を分析し、全体の意味を抽出して表現します。この時、自己注意機構は、それぞれの言葉が他の言葉とどのように関係しているのかを分析する役割を担います。次に、復号化器は、符号化器が抽出した意味表現をもとに、翻訳や文章生成など、目的とする出力を作成します。復号化器でも自己注意機構が重要な役割を果たし、出力される言葉同士の関係性を考慮することで、より自然で正確な文章を作り出すことができます。このように、自己注意機構は変換器の両方の部分で中心的な働きをし、変換器の高い性能を支える重要な機構と言えるでしょう。

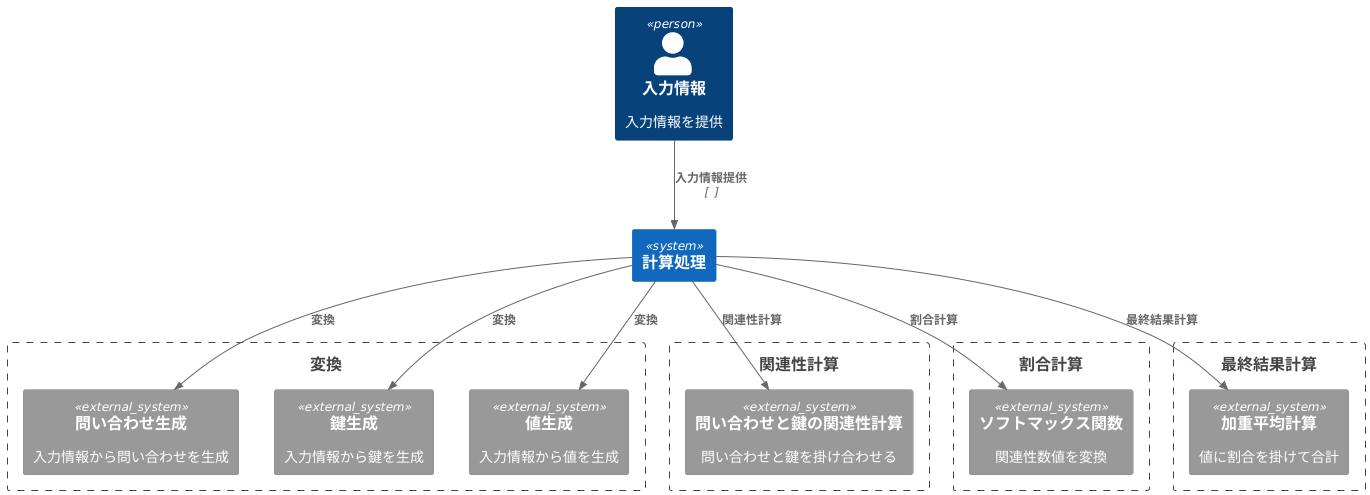

計算方法

計算方法は、問い合わせ、鍵、値と呼ばれる三つの要素を基に考えられています。これらは、入力された情報から計算によって作り出されます。具体的には、変換と呼ばれる処理を通して、入力情報からこれらの三つの要素が生成されます。

まず、それぞれの要素が持つ問い合わせと、他の要素が持つ鍵の関連性を調べます。この関連性の度合いは、二つの要素を掛け合わせることで数値化されます。この数値が高いほど、二つの要素の関連性が強いことを表します。

次に、計算された関連性の数値を、特別な計算方法(ソフトマックス関数)を用いて変換します。この変換によって、それぞれの数値は、全体の中でどの程度の割合を占めるかを示す数値に変換されます。言い換えれば、各要素が他の要素にどの程度注目すべきかを示す割合が計算されるのです。

最後に、各要素が持つ値に、先ほど計算した割合を掛け合わせ、それらを全て足し合わせます。こうして得られた数値が、最終的な計算結果となります。この結果は、各要素が他の要素との関係性を考慮した上で、どのように表現されるべきかを示しています。

注目すべき点として、この一連の計算は、行列という数の集まりを用いた計算方法で効率的に行うことができます。そのため、この計算方法は、膨大な量のデータに対しても適用できるという利点があります。

長所と短所

自己注意機構は、データ分析において革新的な手法であり、多くの利点をもたらしました。最大の特徴は、データのあらゆる要素間の関係性を捉える能力です。従来の手法では、データの要素間の距離が離れるほど、関係性を把握することが困難でした。例えば、文章において、遠く離れた単語同士の関係性を理解することは、従来の技術では容易ではありませんでした。しかし、自己注意機構は、この問題を解決し、離れた要素間の関係性も効果的に捉えることができます。これにより、文章の全体的な意味理解や、画像内の複雑な関係性の把握など、より高度な分析が可能となりました。また、自己注意機構は並列処理に適しているため、計算速度が速いことも大きなメリットです。従来の手法では、逐次的に処理を行う必要があったため、データ量が増えると計算時間が大幅に増加していました。しかし、自己注意機構では、複数の要素を同時に処理することができるため、計算時間を大幅に短縮できます。これにより、大規模なデータセットの分析も現実的な時間で行えるようになり、深層学習の適用範囲を大きく広げました。

一方で、自己注意機構には克服すべき課題も存在します。大きな課題の一つは計算量の多さです。データのサイズが大きくなると、計算量が急激に増加し、膨大な計算資源が必要となります。この計算コストの増大は、利用可能な計算資源の制約により、分析の規模を制限する要因となる可能性があります。また、自己注意機構は、データ全体の関係性を重視する傾向があり、局所的な情報への注意が不足する場合があります。例えば、画像認識において、細かな部分の特徴よりも、画像全体の雰囲気に影響されやすい可能性があります。そのため、画像内の微細な欠陥の検出など、局所的な情報が重要なタスクにおいては、パフォーマンスが低下する可能性も懸念されます。さらに、自己注意機構はモデルの解釈が難しいという側面もあります。なぜ特定の結果が得られたのか、その根拠を理解することが困難な場合があり、分析結果の信頼性評価を難しくしています。これらの長所と短所を踏まえ、タスクの特性や利用可能な計算資源に応じて、自己注意機構を適切に利用することが重要です。

| 項目 | 内容 |

|---|---|

| 長所 |

|

| 短所 |

|

| 効果 |

|

| 課題 |

|

今後の展望

自己注意機構は、今まさに研究開発の最前線にあり、様々な改良が提案されています。研究者たちは、膨大な計算量という課題に取り組むと同時に、文脈全体の把握に加えて、より細かい局所的な情報の取り込みを両立させる方法を模索しています。こうした努力によって、自己注意機構の性能はさらに向上していくと期待されます。

その応用範囲は、自然言語処理にとどまりません。画像認識の分野では、画像内の様々な要素の関係性を捉えることで、より精度の高い認識が可能になると期待されています。また、音声認識においても、音声データの時間的な依存関係を捉えることで、認識精度の向上が期待されています。このように、自己注意機構は様々な分野で注目を集めており、今後の発展が大いに期待されています。

自己注意機構は、深層学習において既に重要な役割を担っていますが、今後さらに多くの分野で活用されると考えられます。情報検索においては、検索キーワードと文書内容との関連性をより深く理解することで、検索精度が向上するでしょう。機械翻訳においては、異なる言語間の微妙なニュアンスを捉えることで、より自然で正確な翻訳が可能になると期待されます。このように、自己注意機構は人工知能技術の発展を加速させ、私たちの生活をより便利で豊かなものにする可能性を秘めています。

今後の研究開発によって、自己注意機構の秘めた可能性がさらに引き出され、様々な分野で革新的な成果が生まれることが期待されます。そして、これらの成果は私たちの社会に大きな変化をもたらす可能性を秘めていると言えるでしょう。

| 分野 | 期待される効果 |

|---|---|

| 自然言語処理 | 文脈全体の把握と局所的な情報の取り込みの両立による性能向上 |

| 画像認識 | 画像内要素の関係性把握による認識精度の向上 |

| 音声認識 | 音声データの時間的依存関係把握による認識精度の向上 |

| 情報検索 | 検索キーワードと文書内容の関連性理解による検索精度の向上 |

| 機械翻訳 | 異なる言語間のニュアンス把握による自然で正確な翻訳 |