ResNet:残差学習で画像認識を革新

AIを知りたい

先生、「ResNet」って、何ですか?なんか、すごい複雑な仕組みみたいで、よくわからないです。

AIエンジニア

そうだね、ResNetは少し複雑だけど、かみ砕いて説明するね。ResNetは、たくさんの層が積み重なったモデルで、層と層の間を飛び越える「近道」があるんだ。この近道をSkip connectionというんだよ。

AIを知りたい

近道…ですか? なんで、そんな近道が必要なんですか?

AIエンジニア

良い質問だね!層を深く積み重ねると、学習がうまくいかなくなることがあるんだ。そこで、近道を作ることで、深い層の情報が浅い層に伝わりやすくなり、学習をうまく進めることができるんだよ。ResNetは画像認識などで高い精度を出せるんだ。

ResNetとは。

人工知能でよく使われる「ResNet(レズネット)」という言葉について説明します。ResNetは、画像認識などで使われるモデルで、たくさんの層が積み重なった構造をしています。それぞれの層では、畳み込みと呼ばれる処理が行われます。ResNetの特徴は、「残差ブロック」と「スキップ接続」という仕組みです。残差ブロックは、畳み込み層に加えて、近道を作るような構造になっています。スキップ接続はこの近道のことで、入力された情報を層を飛び越えて出力側に渡すことができます。これにより、深い層を積み重ねても情報がうまく伝わり、結果として認識精度が向上しました。

残差学習の登場

近年の機械学習、とりわけ画像の認識において、モデルの層を深く積み重ねることで認識の正確さが向上することが分かってきました。層を深くするほど、モデルはより複雑な特徴を捉えることができ、結果として性能が向上するのです。しかし、この単純に層を増やすというやり方には、落とし穴がありました。あまりにも層を深くしてしまうと、学習の過程で勾配が消失したり、逆に爆発したりするという問題が発生し、学習がうまく進まなくなってしまうのです。

このような問題を解決するために、画期的な学習方法である残差学習が登場しました。残差学習は、層の出力をそのまま次の層に渡すのではなく、入力と出力の差分、つまり残差を学習させるという斬新なアイデアに基づいています。残差を学習することで、勾配消失や勾配爆発といった問題を効果的に抑制できることが分かりました。この残差学習を基盤としたモデルがResNet(Residual Network残差ネットワーク)です。ResNetの登場は画像認識の世界に大きな革命をもたらしました。ResNet以前は、層を深くしすぎると性能が低下してしまうという問題がありましたが、ResNetによって非常に深いネットワークでも安定して学習できるようになり、画像認識の正確さは飛躍的に向上しました。これは画像認識のみならず、機械学習全体にとって極めて重要な進歩であり、様々な分野への応用が期待されています。例えば、自動運転技術や医療画像診断など、高度な画像認識技術が求められる分野において、ResNetはなくてはならない存在となっています。

| 課題 | 従来手法の問題点 | 解決策 | ResNet(残差ネットワーク) | 効果 | 応用分野 |

|---|---|---|---|---|---|

| 画像認識の精度向上 | 層を深くすると勾配消失・勾配爆発が発生し、学習がうまくいかない | 残差学習(入力と出力の差分を学習) | 残差学習を基盤としたモデル | 非常に深いネットワークでも安定した学習が可能になり、画像認識の精度が飛躍的に向上 | 自動運転、医療画像診断など |

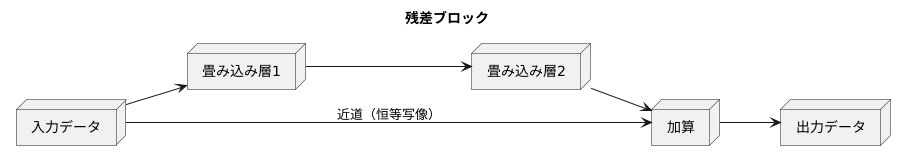

残差ブロックの仕組み

画像認識の分野で画期的な成果を上げた残差ネットワーク(ResNet)は、残差ブロックと呼ばれる特別な構造のおかげで、深い層を持つネットワークを効率的に学習できます。この残差ブロックの仕組みを詳しく見ていきましょう。

残差ブロックの核心は、入力データの一部をそのまま出力側に送るという点にあります。通常の畳み込みニューラルネットワークでは、入力データは幾つもの畳み込み層を順番に通過し、それぞれの層で特徴が抽出されます。しかし、層が深くなるにつれ、学習に必要な情報が薄れてしまったり、変化が小さすぎて学習が進まなくなったりする問題が発生することがあります。これを勾配消失問題と言います。

残差ブロックでは、畳み込み層による変換に加えて、入力データをそのまま出力側に送る経路(恒等写像)を用意します。この経路を近道と考えることができます。入力データは、畳み込み層を通過する経路と、近道を通る経路の両方を通り、最終的に合流して出力となります。畳み込み層では、入力データと出力データの差分、つまり残差を学習します。

近道があることで、学習すべき残差は小さくなり、勾配消失問題の影響を受けにくくなります。深い層のネットワークでも、安定した学習が可能になるのです。また、近道を通るデータは一切変更を加えられないため、層が深くなっても重要な情報が失われずに伝わるという利点もあります。この残差ブロックを積み重ねることで、ResNetは非常に深いネットワークを構築し、高い認識精度を実現しています。まるで高層ビルに非常階段が設置されているように、残差ブロックは深いネットワークにとって重要な役割を果たしていると言えるでしょう。

層を深くする効果

深層学習では、幾重にも積み重ねられた層が、まるで人間の脳のように複雑な情報を処理します。しかし、以前は層を深くすればするほど、学習の際に問題が発生していました。これは、誤差逆伝播法という学習方法に起因します。誤差逆伝播法は、出力層の誤差を、前の層へと次々に伝えていくことで、各層の重みを調整していく手法です。ところが、層が深くなると、この誤差が伝わる過程で徐々に小さくなってしまい、入力層付近の層にはほとんど誤差が届かなくなってしまうのです。これが勾配消失問題と呼ばれる現象で、深い層を持つモデルの学習を阻む大きな壁となっていました。

しかし、残差ネットワーク、略してResNetの登場によって、この状況は大きく変わりました。ResNetは、残差ブロックと呼ばれる特別な構造を導入することで、勾配消失問題を効果的に抑えることに成功しました。残差ブロックは、層への入力値をそのまま出力値に加えるショートカット接続と呼ばれる経路を持っています。この構造により、誤差がショートカット接続を通じて伝わるため、層が深くなっても勾配が消失しにくくなるのです。

ResNet以前は、層を深くすることでモデルの表現力は向上するものの、勾配消失問題によって学習がうまくいかず、かえって性能が低下してしまう場合もありました。ResNetの登場は、まさに深層学習における革新でした。層を深くしても学習が安定し、画像認識をはじめとする様々なタスクで飛躍的な精度の向上が実現しました。これにより、以前はモデルの性能向上の障害だった層の深さが、性能向上のための強力な武器へと変わったのです。ResNetは、深層学習の可能性を大きく広げ、今日のAI技術の発展に大きく貢献しました。

画像認識における成果

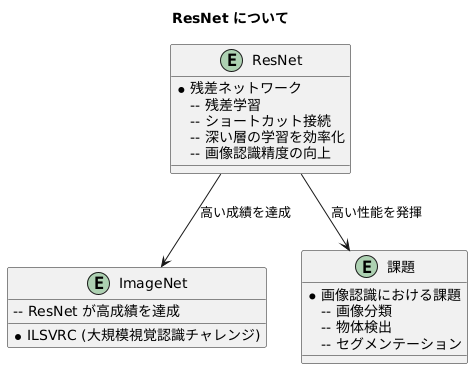

画像を認識する技術は近年、目覚ましい発展を遂げてきました。中でも、残差ネットワーク(ResNet)は、画像認識の世界に大きな変革をもたらした重要な技術です。ResNetは、画像認識の精度を競う大会である「ImageNet 大規模視覚認識チャレンジ」(ILSVRC)において、他の手法を圧倒する高い成績を収め、その実力を証明しました。この大会は、画像認識技術の進歩を測る上で重要な役割を果たしており、ResNetの勝利は、画像認識技術における大きな前進を示すものでした。

ResNetが登場する以前は、画像認識の精度は、モデルを複雑にすることで向上していました。しかし、ある程度の複雑さを超えると、精度の向上が停滞する現象が起きていました。ResNetは、この問題を解決するために、「残差学習」と呼ばれる新しい学習方法を導入しました。残差学習とは、モデルに「ショートカット接続」を追加することで、深い層の学習を効率化する方法です。これにより、ResNetは非常に深い層を持つモデルを学習することが可能になり、結果として画像認識の精度が劇的に向上しました。

ResNetの応用範囲は広く、画像の分類だけでなく、画像中の物体を検出する物体検出や、画像を領域ごとに分割するセグメンテーションといった、様々な画像認識の課題にも利用されています。これらのタスクにおいてもResNetは高い性能を発揮しており、画像認識技術の発展に大きく貢献しています。今日では、ResNetは画像認識の分野においてなくてはならない技術となり、様々な場面で活用されています。ResNetは、まさに画像認識技術の標準的な手法として、広く利用されているのです。

今後の展望

残差ネットワーク、略してレズネットの登場は、深層学習の世界、とりわけ画像認識の分野に大きな変革をもたらしました。画像に含まれる物体を識別したり、画像を分類するといった技術は、レズネットによって飛躍的に向上しました。これまで、層を深く積み重ねた学習モデルは、学習がうまく進まないという問題を抱えていました。深い層を通るうちに情報が失われてしまい、精度が向上しないのです。しかし、レズネットは残差学習という革新的な手法を導入することで、この問題を解決しました。

残差学習とは、層の出力を次の層にそのまま伝えるのではなく、入力値との差分、つまり変化量だけを学習させる方法です。これにより、深い層になっても情報が失われにくくなり、学習が安定します。結果として、従来よりもはるかに深い層を持つネットワークを構築することが可能になり、画像認識の精度も格段に向上しました。

レズネットの登場以降、この残差学習という考え方は様々な学習モデルに応用され、深層学習の発展に大きく貢献しています。音声認識や自然言語処理といった分野でも、レズネットの影響を受けたモデルが開発され、高い性能を達成しています。また、レズネット自身の改良も続けられています。層の構成や学習方法を工夫することで、より高性能なモデルが次々と開発されています。

今後、レズネットを土台とした、さらに高度な画像認識技術が生まれることが期待されています。医療の分野では、レントゲン写真やCT画像から病気を早期発見する技術の向上に役立つでしょう。自動運転の分野では、周囲の状況を正確に認識し、安全な運転を支援する技術の進歩に貢献するでしょう。また、ロボット制御の分野では、ロボットが周囲の環境を理解し、適切な動作を行うための技術の高度化に役立つでしょう。このように、レズネットの応用範囲はますます広がり、私たちの生活をより豊かに、より便利にする技術の進歩に欠かせない存在となるでしょう。レズネットの登場は、まさに画像認識技術の進化における大きな転換点と言えるでしょう。

まとめ

{残差ネットワーク(ResNet)は、画像認識の分野に革命をもたらした画期的な深層学習モデルです。それ以前の深層学習モデルでは、層を深く重ねるほど学習が難しくなり、精度が向上しないという問題がありました。これは、勾配消失問題と呼ばれる現象で、深い層ほど学習に必要な情報が薄れてしまうことが原因でした。ResNetはこの問題を解決するために、残差学習という新しい手法を導入しました。

残差学習の核心は、残差ブロックと呼ばれる構造にあります。残差ブロックでは、入力データをそのまま出力にショートカット接続することで、層を深くしても学習に必要な情報が失われにくくなります。これは、まるで近道を作るように、学習の信号を深い層まで伝える役割を果たします。

この残差学習と残差ブロックの導入により、ResNetは非常に深い層を持つネットワークを安定して学習させることができるようになりました。結果として、画像認識の精度が従来のモデルに比べて飛躍的に向上し、画像分類のコンペティションなどで驚異的な成果を上げました。

ResNetの登場は、深層学習モデルの設計に大きな影響を与えました。多くの研究者がResNetのアーキテクチャを参考にしたり、残差学習の考え方を応用したりすることで、様々な分野で高性能なモデルが開発されています。例えば、物体検出やセグメンテーションといったタスクでも、ResNetをベースにしたモデルが広く活用されています。

ResNetの成功は、深層学習の可能性を大きく広げました。今後、ResNetを基盤とした技術がさらに発展し、様々な分野で革新的な応用が生まれることが期待されます。より高度な画像認識技術や、他の分野への応用など、ResNetの将来には大きな可能性が秘められています。