AI悪用と対策の現状

AIを知りたい

先生、「悪用へのセキュリティ対策」って、具体的にどんなことをするんですか?フェイクニュースとか、偽物の動画とかって、作られた後だと見分けるの難しそうじゃないですか?

AIエンジニア

そうだね、確かに難しい。でも、偽物を見破るための技術も研究されているんだよ。「マイクロソフト社の動画認証システム」や「フェイクニュース発見システム」みたいなものだね。これらを使えば、ある程度は見分けられるようになる。

AIを知りたい

へえー!すごいですね!じゃあ、そういう技術を使えば、もう安心ってことですか?

AIエンジニア

いや、そうとも言い切れないんだ。偽物を作る側も、より巧妙な方法を開発してくる。だから、見破る技術も常に進化させていかないといけない。いわば、いたちごっこの状態なんだよ。だから、常に最新の情報を知っておくことが大切なんだ。

悪用へのセキュリティ対策とは。

人工知能にまつわる言葉で「悪用を防ぐための対策」というものがあります。役に立つ人工知能の技術は、文章を作るものであれば、偽のニュースを作ったり、絵を描くものであれば、本物そっくりの偽の動画や画像を作ったりする悪いことに使われるかもしれません。こうした技術は、論文などで広く公開されていることが多く、悪用されるのを前もって防ぐのはほとんど不可能です。ですから、悪用された後どう対応するかが大切になります。マイクロソフト社の「Microsoft Video Authenticator」やSummarizeBotの「Fake News Detection」のように、偽物を見抜く技術の研究が進められており、こうした技術を使うのが効果的です。人工知能の悪用とその対策は、まるでいたちごっこのようで、常に最新の情報を手に入れるように気をつけましょう。

人工知能の悪用事例

近年、技術の進歩によって人工知能はめざましい発展を遂げ、暮らしの様々な場面で役立てられています。買い物をする時、道を調べる時、娯楽を楽しむ時など、私たちの生活は人工知能の恩恵なくしては考えられないほどになっています。しかし、その便利な技術の裏側には、使い方を誤れば大きな危険につながるという側面も持ち合わせています。人工知能が悪用された場合、どのような問題が起こるのか、具体的な例を挙げて考えてみましょう。

まず、言葉に関する人工知能が悪用されると、真実ではない情報が作られて広まる危険性があります。まるで人間が書いたかのような自然な文章で、嘘のニュース記事や誤った情報を大量に作り出し、インターネット上に拡散することが可能です。このような偽の情報は人々の判断を狂わせ、社会全体の混乱を招く恐れがあります。選挙や政治的な意思決定にも悪影響を及ぼし、民主主義の土台を揺るがす可能性も否定できません。

次に、画像や動画を作る人工知能が悪用されると、人の顔や声を偽物とすり替えた映像が作られる危険性があります。実在の人物が実際には行っていない言動を、まるで本人が行っているかのように捏造した動画を作成し、インターネット上に公開することで、その人の評判を傷つけたり、社会的な信用を失墜させたりする事が可能です。また、このような偽の映像は詐欺行為にも利用される可能性があり、金銭的な被害だけでなく、精神的な苦痛を与える深刻な犯罪につながる恐れがあります。

このように、人工知能は使い方次第で大きな害悪をもたらす可能性があります。人工知能の負の側面を理解し、悪用を防ぐための対策を早急に講じる必要があると言えるでしょう。

| 悪用されるAIの種類 | 具体的な悪用の例 | 起こりうる問題 |

|---|---|---|

| 言葉に関するAI | 嘘のニュース記事や誤った情報の作成・拡散 | 人々の判断の混乱、社会全体の混乱、選挙や政治への悪影響、民主主義の土台を揺るがす |

| 画像や動画を作るAI | 人の顔や声を偽物とすり替えた映像の作成・公開 | 評判の毀損、社会的な信用の失墜、詐欺行為、金銭的・精神的な被害 |

公開モデルと悪用防止の難しさ

人工知能の技術革新は目覚ましく、様々な計算模型が研究論文やインターネットを通じて公開されています。誰でもこれらの模型にアクセスできるということは、技術の進歩を促す上で大きな利点と言えるでしょう。公開された模型を基に、多くの技術者が新たな発想を得て、更なる改良や新たな応用方法を生み出すことが期待されます。しかしながら、この開かれた環境は同時に、模型の悪用という危険性を孕んでいることも事実です。

一度公開された模型を悪用しようとする者を事前に見つけ出し、その行動を止めることは非常に難しいと言えるでしょう。誰がどのような目的で模型を利用するのかを事前に全て把握することは不可能です。また、悪意を持った者が模型を改変し、不正な用途に転用することも考えられます。悪用を企てる者は、匿名性を保ちながら行動する可能性が高く、その正体や目的を特定することは容易ではありません。そのため、悪用を未に行われる前に完全に防ぐことは現実的に不可能に近いと考えられます。

現状においては、悪用が行われた後、いかに迅速に対応できるかが重要となります。悪用された模型の影響範囲を最小限に抑え、被害を速やかに回復するための対策を講じる必要があります。具体的には、悪用された模型の検知システムの開発や、悪用された場合の影響を軽減するための技術的な対策などが挙げられます。また、悪用に関する情報を共有し、関係者間で協力体制を築くことも重要です。更に、倫理的な観点から模型の利用について議論を深め、社会全体で適切な利用方法を模索していく必要があるでしょう。技術の発展と安全性の確保の両立は容易ではありませんが、継続的な努力が求められます。

| 項目 | 説明 |

|---|---|

| 人工知能模型の公開 | 技術進歩を促進、新たな発想や応用を期待 |

| 模型公開の課題 | 悪用の危険性、事前検知の困難性、匿名性の問題 |

| 悪用への対策 | 迅速な対応、影響範囲の最小化、被害回復、検知システム開発、技術的対策、情報共有、協力体制構築、倫理的な議論 |

悪用対策技術の現状

人工知能は様々な分野で革新をもたらしていますが、同時に悪用される危険性もはらんでいます。こうした悪用を防ぐために、様々な対策技術が開発されています。

動画の改ざんを検知する技術は、悪用対策の重要な一つです。例えば、マイクロソフト社が開発した「マイクロソフト動画認証システム」は、動画に含まれるわずかな変化を捉え、改ざんの有無を判別します。動画に人工知能を使って人の顔や声を合成する技術、いわゆる「深層偽造」による偽動画の拡散は大きな社会問題になりつつあります。この技術を使えば、まるで本人が話しているかのような偽動画を作成することができ、悪意ある情報操作に利用される恐れがあります。「マイクロソフト動画認証システム」のような技術は、このような偽動画を見破り、情報の信頼性を守る上で大きな役割を果たします。

また、誤った情報の拡散を防ぐ技術も開発が進んでいます。「サマライズボット偽情報検知」は、文章の特徴を分析することで、偽情報が含まれる可能性を評価する技術です。インターネット上には多くの情報が溢れており、その中には意図的に操作された情報も含まれています。このような偽情報を見分けることは、一般の人々にとって容易ではありません。「サマライズボット偽情報検知」のような技術は、情報の真偽を判断する手助けとなり、人々が正しい情報に基づいて判断を下せるよう支援します。

これらの技術は、人工知能の悪用に対抗する重要な手段となります。しかし、悪用する側も常に新しい方法を開発しているため、対策技術も絶え間ない進化が必要です。人工知能技術の発展と悪用への対策は、今後も私たちが向き合い続けなければならない課題と言えるでしょう。

| 対策技術 | 説明 | 対象となる悪用 |

|---|---|---|

| マイクロソフト動画認証システム | 動画に含まれるわずかな変化を捉え、改ざんの有無を判別する。 | 深層偽造 (ディープフェイク) による偽動画の拡散 |

| サマライズボット偽情報検知 | 文章の特徴を分析することで、偽情報が含まれる可能性を評価する。 | インターネット上での誤った情報の拡散 |

いたちごっこの現状と継続学習の重要性

人工知能の悪用と、それに対抗するための対策は、まるでいたちごっこのようです。悪意のある者が、あの手この手で人工知能を不正に利用しようと新しい方法を考え出す一方で、それを防ごうとする側は、その新しい方法に対応するための対策を講じます。しかし、すぐにまた別の新しい悪用方法が生み出されるため、いたちごっこは終わりません。

悪用する側は、常に最新の技術や知識を駆使し、既存の対策をすり抜けようと試みます。そのため、対策をする側も常に最新の情報を把握し、技術を磨き続ける必要があります。この継続的な学習こそが、人工知能の悪用との戦いを有利に進めるための重要な鍵となります。

人工知能の悪用は、様々な形をとります。例えば、偽の情報を作成して拡散したり、個人情報を不正に入手したり、他人のふりをしてだましたりといったことが考えられます。これらの悪用を防ぐためには、最新の研究成果やセキュリティに関する情報を常に確認し、どのような脅威が新しく現れているのかを把握することが大切です。

継続学習には、様々な方法があります。学会や研究会に参加して最新の研究成果を学ぶ、専門家による講演会やセミナーを受講する、関連書籍や論文を読む、オンライン学習プラットフォームを利用するなど、自分に合った方法で継続的に学習することが重要です。また、セキュリティに関するニュースや情報を常にチェックし、最新の脅威や対策技術について学ぶことも重要です。人工知能技術は常に進化しており、それに伴い、悪用の手法も高度化しています。そのため、我々も常に学習し続け、進化する脅威に備える必要があります。人工知能を安全に利用するためには、いたちごっこに負けないように、継続的な学習を心がけましょう。

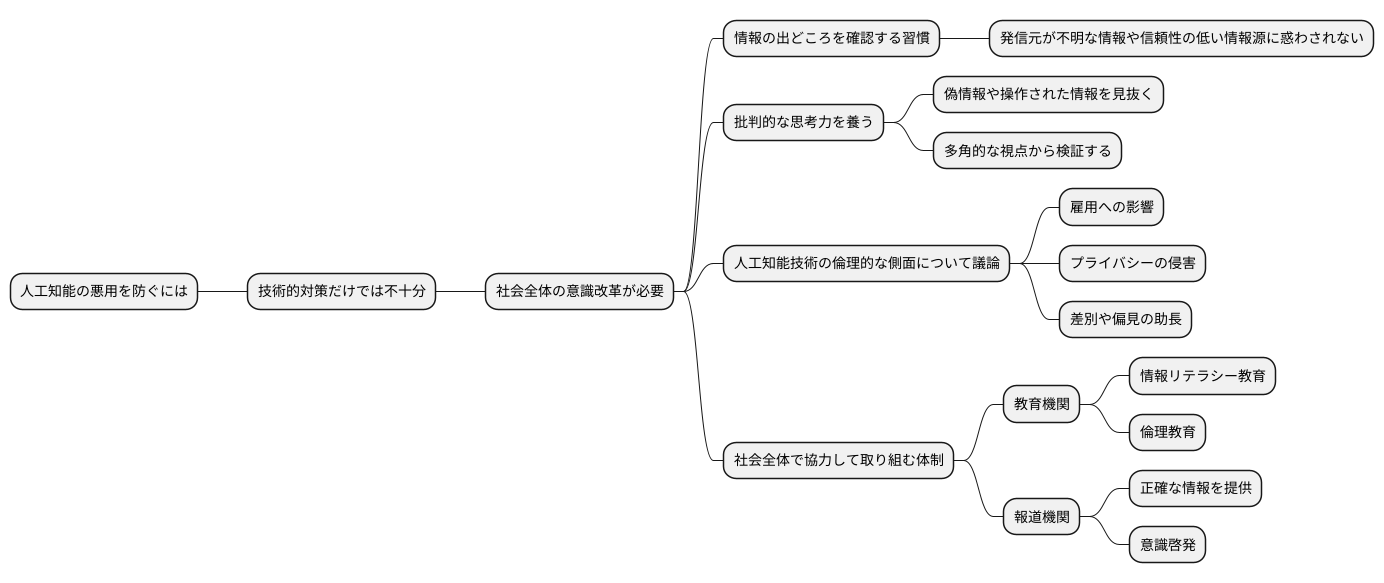

社会全体の意識改革

人工知能(じんこうちのう)の悪用を防ぐには、技術的な対策だけでは足りません。社会全体の意識改革も必要不可欠です。技術の進歩と普及は目覚ましいものがありますが、その使い方を誤れば、大きな害悪をもたらす可能性も秘めているからです。そのため、一人ひとりが人工知能のリスクと適切な使い方について理解を深める必要があります。

まず情報の出どころを確認する習慣を身につけることが重要です。インターネット上には真偽不明な情報が溢れています。発信元が不明な情報や、信頼性の低い情報源からの情報に惑わされないように、情報の出どころを注意深く確認する癖をつけるべきです。

不確かな情報に惑わされない批判的な思考力を養うことも大切です。人工知能によって作られた偽の情報や、巧妙に操作された情報を見抜くためには、情報の内容を鵜呑みにせず、多角的な視点から検証する能力が必要です。何が事実で何がそうでないのか、自分の頭で考え判断する力を養うことが重要です。

人工知能技術の倫理的な側面についても、社会全体で議論を深める必要があります。人工知能は私たちの生活に様々な恩恵をもたらしますが、同時に、倫理的な問題も引き起こします。例えば、雇用への影響やプライバシーの侵害、差別や偏見の助長など、解決すべき課題は山積みです。これらの問題について、様々な立場の人々が議論を重ね、より良い社会を築くためにどう人工知能を活用していくべきかを考えていく必要があるでしょう。

教育機関や報道機関など、社会全体で協力して取り組む体制を作ることも重要です。学校教育では、子供たちに情報リテラシー教育や倫理教育を充実させる必要があります。報道機関は、人工知能に関する正確な情報を提供し、社会全体の意識啓発に努めるべきです。人工知能技術を正しく理解し、責任を持って利用することで、悪用による被害を最小限に抑え、より良い未来を築くことができるはずです。

法整備の必要性

近頃、技術革新の速度は目覚ましく、特に人工知能の分野における進歩はめざましいものがあります。しかし、その進歩に法整備が追いついていないことが大きな問題となっています。技術の進歩は私たちの生活を豊かにする可能性を秘めている一方で、悪用される危険性も孕んでいるからです。人工知能が悪用された場合、個人情報の漏洩や偽情報の拡散など、深刻な被害が発生する恐れがあります。このような事態を防ぐためには、早急に法整備を進める必要があります。

まず、人工知能の悪用に対する明確な法的規制を設けることが重要です。どのような行為が違法とみなされるのかを明確に定義し、罰則規定を設けることで、悪用を抑止する効果が期待できます。例えば、人工知能を用いて他人の個人情報を不正に取得したり、偽情報を生成して拡散したりする行為を違法行為として明確に規定する必要があります。また、人工知能開発者に対する責任についても明確化し、開発段階から悪用防止のための対策を講じるように促す必要があります。

さらに、被害者救済のための枠組みを構築することも重要です。人工知能が悪用された場合、被害者は迅速かつ適切な救済を受けることができるようにする必要があります。具体的には、被害者が損害賠償請求を行うための手続きを簡素化したり、国による救済制度を設けたりするなどの対策が考えられます。

そして、国際的な協力も欠かせません。人工知能の悪用は国境を越えて行われる可能性があるため、国際的な法整備の枠組みを構築し、各国が連携して対策を進める必要があります。国際的な協力体制を築くことで、悪用を未然に防ぎ、被害が発生した場合でも迅速かつ効果的な対応が可能となります。人工知能の健全な発展のためにも、法整備の遅れを取り戻し、安全な利用環境を整備することが急務です。

| 課題 | 対策 |

|---|---|

| 人工知能の悪用 |

|

| 被害者救済 |

|

| 国際協力 |

|