深層学習

深層学習 FPN:高精度な物体検出を実現する技術

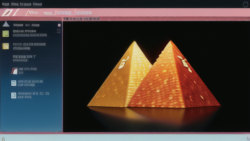

物を探す画像認識技術では、画像に写る物体の大きさが様々であることが課題となります。遠くにあるものは小さく、近くにあるものは大きく写るため、これらを同じものだと認識するには、大きさの違いを考慮する必要があります。この課題を解決するのが特徴ピラミッドと呼ばれる技術です。

特徴ピラミッドは、画像を異なる縮尺で複数枚用意することで、様々な大きさの物体の特徴を捉えます。例えば、元の画像を縮小した画像、さらに縮小した画像などを用意することで、ピラミッドのような階層構造を作ります。それぞれの縮尺の画像から特徴を抽出することで、大小様々な物体を認識できるようになります。小さな物体は縮小画像から、大きな物体は元の画像から、それぞれ適切な大きさで特徴を捉えることができるのです。

従来の物体認識システムでは、この特徴ピラミッドが重要な役割を果たしていました。ピラミッド構造によって、一枚の画像から様々な大きさの特徴を抽出できるため、様々な大きさの物体を検出することが可能になります。例えば、遠くの小さな人と近くの大きな人をどちらも「人」と認識するために、この技術は不可欠でした。

しかし、特徴ピラミッドは計算量が多いという欠点も持っています。複数の縮尺の画像を処理する必要があるため、処理時間やメモリ使用量が増加してしまうのです。そのため、より効率的な物体認識技術の開発が進められていますが、特徴ピラミッドの基本的な概念は、様々な画像認識技術の基礎となっています。大きさの変化に対応できるという利点は、画像認識において非常に重要であり、今後の技術発展にも影響を与え続けるでしょう。