生成AI利用における自主対策の重要性

AIを知りたい

先生、「自主対策」ってよく聞くんですけど、具体的にどういうことですか?

AIエンジニア

そうだね。例えば、最近話題の文章や画像を作るAIを使う場面を想像してみよう。便利な一方で、間違った情報が広まったり、個人の秘密が漏れたりする危険性もあるよね。そうした危険を減らすために、使う人や作る人がそれぞれ自分で気を付けることを「自主対策」と言うんだよ。

AIを知りたい

なるほど。使う人と作る人でそれぞれ違うことをするんですか?

AIエンジニア

その通り!使う人は、入力する情報に注意したり、出てきた結果が正しいか確認したりする。作る人は、AIの学習データの質を高めたり、AIの仕組みを分かりやすく説明したりする。そうしたことが自主対策になるんだ。

自主対策とは。

人工知能にまつわる言葉である「自主的な対策」について説明します。自主的な対策とは、一般的に、組織や個人が自分の判断で、問題や課題に対処するために行う取り組みや方法のことです。文章や画像などを作り出す人工知能を使う場面では、情報の漏洩や間違った情報の拡散といった危険性があります。そのため、人工知能を使うことによる危険性を、使う側も作る側も、自主的に減らす、つまり自主的な対策をある程度行う必要が出てきます。例えば、使う側は入力する情報に注意する、作る側はデータの質や、どのように結果が出力されるのかが分かりやすいかといった点に注意するといった自主的な対策がそれぞれ必要です。

生成AIに伴う危険性

近頃、文章を綴ったり、絵を描いたり、曲を作ったりと、様々な分野で新しい技術が注目を集めています。それは生成AIと呼ばれるものです。この技術は、私達の生活を大きく変える可能性を秘めていますが、同時に幾つかの危険性も孕んでいます。

まず、個人情報や企業の機密情報が漏れてしまう危険性があります。生成AIに何かを作らせるには、元となるデータを入力する必要があります。その際、うっかり重要な情報を入力してしまうと、それが意図せず外部に漏れてしまうかもしれません。これは、個人だけでなく、企業にとっても大きな損害になりかねません。

次に、生成AIが間違った情報を作り出してしまう危険性があります。生成AIはまだ発展途上の技術であり、常に正しい情報を出力できるとは限りません。事実とは異なる情報を生成してしまう可能性があり、それを信じてしまう人がいると、混乱を招いたり、誤った判断に繋がる恐れがあります。

さらに、著作権に関わる問題も発生する可能性があります。生成AIは、既存の作品を学習して新しい作品を作り出します。その際、元の作品の著作権を侵害してしまう可能性があるのです。

これらの危険性は、生成AIの利用が広まるにつれて、ますます深刻になることが予想されます。大きな損害が発生する前に、対策を講じる必要があります。利用者は、入力する情報に注意し、生成された情報が正しいかどうかを確認する必要があります。開発者は、生成AIが間違った情報や著作権を侵害する作品を作り出さないように、技術的な改良を進める必要があります。生成AIを安全に利用するためには、利用者と開発者の双方による努力が不可欠です。

| メリット | デメリット | 対策 |

|---|---|---|

| 文章作成、絵画、作曲など様々な分野で活用できる | 個人情報や企業の機密情報が漏洩する危険性 | 入力情報に注意 |

| 間違った情報を生成する危険性 | 生成された情報の真偽確認 | |

| 著作権侵害の可能性 | 技術的な改良 |

利用者の自主対策

近頃話題の文章や絵を作る技術を使う人にとって、気を付けるべき点がいくつかあります。まず、入力する情報に注意が必要です。個人の大切な情報や、会社の秘密など、漏れてしまうと困ることは入力しないようにしましょう。うっかり入力してしまわないよう、日頃から注意深く扱うことが大切です。

次に、この技術で作られた文章や絵を、全て正しいと信じてはいけません。作られたものはあくまでも参考程度と考え、本当に正しいのかどうか、自分自身で確認することが重要です。便利な道具ではありますが、最終的に判断するのは人間です。自分自身の目で見て、耳で聞いて、確かめる習慣をつけましょう。

最後に、この技術で作られた文章や絵を、広くみんなに見せる時にも注意が必要です。作ったものによっては、誰かの権利を侵害してしまう可能性があります。例えば、文章や絵の作者の権利や、写真に写っている人の権利など、様々な権利が存在します。誰かの作ったものを勝手に使ったり、誰かの顔を勝手に公開したりすることは、法律で禁じられています。作ったものを公開する前に、権利を侵害していないか、しっかりと確認しましょう。

これらの点に気を付けることで、この技術を安全に使うことができます。便利な道具だからこそ、使い方を間違えると大きな問題につながる可能性もあります。安全に、そして正しく使うことで、より良いものとなるでしょう。

| 注意点 | 詳細 |

|---|---|

| 入力情報 | 個人情報や会社の秘密など、漏れてしまうと困る情報は入力しない。 |

| 情報の信頼性 | 生成された文章や絵を全て正しいと信じてはいけない。あくまでも参考程度とし、自分自身で確認する。 |

| 公開時の注意点 | 他者の権利を侵害していないか確認する(例:作者の権利、写真に写っている人の権利)。無断使用や公開は法律で禁じられている。 |

開発者の自主対策

人工知能を作る人は、良いものを作るために様々な工夫をしなければなりません。その一つが、学習に使う情報の質と、作ったものの分かりやすさに気を配ることです。

まず、学習に使う情報が偏っていると、人工知能も偏った考えを持つようになってしまいます。例えば、ある特定の地域の情報ばかりで学習させると、他の地域のことを知らない、あるいは誤解しているような人工知能になってしまいます。これはまるで、限られた知識だけで世界を判断するようなものです。ですから、色々な種類の情報をバランス良く使って学習させることがとても大切です。多様な情報に触れさせることで、より公平で正確な判断ができる人工知能を作ることができます。

次に、作ったものがどのように考えているのかを分かりやすくすることも重要です。これは、まるで人の思考過程が見えるようにするようなものです。人工知能の判断の理由が分かれば、間違った考えや偏見を持っているかどうかを確かめることができます。もし問題があれば、修正することも容易になります。これは、人工知能の間違いを未然に防ぎ、より信頼できるものにするために欠かせない対策です。

さらに、作った人工知能が正しく動くかどうかの試験も大切です。色々な問題を出してみて、きちんと答えられるか、間違った答えを出さないかなどを確認します。これは、製品を市場に出す前に欠陥がないかを確認する品質検査のようなものです。十分な試験を行うことで、安心して使える人工知能を提供することができます。

これらの対策をしっかり行うことで、信頼できて安全な人工知能を作ることができるようになります。人工知能を作る人たちは、常に責任感を持ってこれらの対策に取り組む必要があります。そうすることで、より多くの人が安心して人工知能を利用できる社会を実現できるでしょう。

| 工夫 | 内容 | 例え | メリット |

|---|---|---|---|

| 学習データの質への配慮 | 多様な情報で学習させる | 限られた知識で世界を判断するようなもの | 公平で正確な判断ができるAI |

| 分かりやすさへの配慮 | AIの思考過程を分かりやすくする | 人の思考過程が見えるようにする | 間違いや偏見の確認、修正が容易になる |

| 試験の実施 | 様々な問題でAIの動作確認 | 製品の品質検査 | 安心して使えるAIの提供 |

自主対策の限界

自ら進んで行う対策は確かに大切です。責任ある行動を促し、問題発生を未然に防ぐ効果も期待できます。しかし、万能な解決策とは言い難いのも事実です。

第一に、技術革新の速度に追いつけない可能性があります。人工知能技術は日進月歩で進化しており、昨日まで有効だった対策が今日には通用しなくなることも考えられます。悪意ある利用を防ぐための対策も、常に最新の状態に保つ必要がありますが、自主的な取り組みだけでは限界があります。

第二に、自主対策は強制力に欠けるため、全ての人が遵守するとは限りません。倫理観や責任感の低い開発者や利用者が、自主的なガイドラインを無視して行動する可能性も否定できません。特に、競争の激しい状況下では、倫理よりも利益を優先する誘惑に駆られることもあるでしょう。

第三に、新しい技術に伴うリスクは予測困難なことが多く、自主対策だけで全てのリスクに対応することは不可能です。想定外の事態が発生した場合、自主的な取り組みだけでは迅速かつ適切な対応が難しい場面も出てくるでしょう。

だからこそ、自主対策だけでなく、法による規制や社会全体での倫理的な議論も必要不可欠です。法規制は、最低限守るべきルールを定め、違反者には罰則を科すことで、健全な発展を促すことができます。また、倫理的な議論を通して、社会全体の共通認識を形成し、技術利用の適切な方向性を導き出すことができます。

自主対策、法規制、倫理的な議論。これらが三位一体となって機能することで、初めて人工知能技術は社会にとって真に有益なものとなるでしょう。人工知能技術は大きな可能性を秘めている一方、使い方を誤れば大きな害悪をもたらす可能性も秘めています。適切な管理のもとで、その恩恵を最大限に享受できる社会を目指していく必要があります。

| 自主対策の限界 | 詳細 |

|---|---|

| 技術革新への対応 | 人工知能技術の急速な進化に自主対策が追いつかない可能性がある。 |

| 強制力の欠如 | ガイドラインの遵守は任意であるため、倫理観や責任感の低い者が無視する可能性がある。 |

| 予測困難なリスクへの対応 | 想定外の事態が発生した場合、自主的な取り組みだけでは迅速かつ適切な対応が難しい。 |

結論: 自主対策に加えて、法規制と倫理的な議論も必要不可欠である。

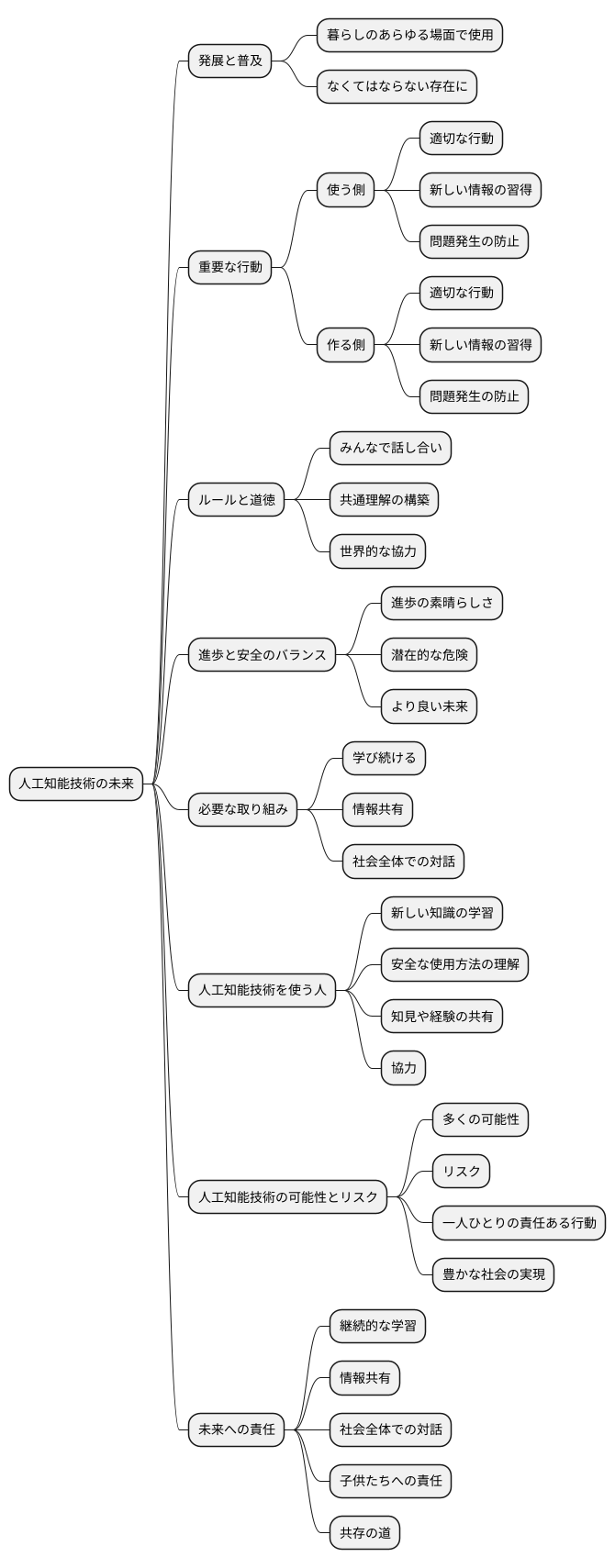

今後の展望

これからの人工知能技術は、ますます発展し、私たちの暮らしのあらゆる場面で使われるようになるでしょう。まるで空気のように、なくてはならないものになるかもしれません。そのため、人工知能技術を使う側も作る側も、自ら考えて適切な行動をとることがこれまで以上に大切になります。常に新しい情報を取り入れ、問題が起きないように気を配る必要があります。

人工知能技術を使う上で、どのようなルールや道徳的な考え方を持つべきか、みんなで話し合い、共通の理解を作っていくことも重要です。これは、国や地域だけでなく、世界中の人々が協力して取り組むべき課題です。人工知能技術の進歩は素晴らしいものですが、同時に危険も潜んでいます。進歩と安全のバランスをうまくとりながら、より良い未来を作っていく必要があります。

そのためには、学び続けること、情報を共有すること、そして社会全体で話し合うことが欠かせません。人工知能技術を使う人たちは、常に新しい知識を学び、安全に使うための方法を理解する必要があります。また、人工知能技術を使うことで得られた知見や経験を共有し、互いに協力することで、より安全で効果的な使い方を見つけることができます。

人工知能技術は、私たちに多くの可能性を与えてくれますが、同時にリスクも伴います。私たち一人ひとりが、その可能性とリスクを正しく理解し、責任ある行動をとる必要があります。人工知能技術を正しく使うことで、より豊かな社会を実現できるはずです。そのためにも、継続的な学習と情報共有、そして社会全体での対話を続け、より良い未来を築いていく努力が欠かせません。未来を担う子供たちのためにも、責任ある行動を心がけ、人工知能技術と共存していく道を模索していく必要があるでしょう。