AI規制:技術革新と倫理の調和

AIを知りたい

先生、「規制化」って難しくてよくわからないです。もっと簡単に説明してもらえますか?

AIエンジニア

そうだね、難しいよね。「規制化」というのは、AIに「して良いこと、悪いこと」のルールを決めることだよ。例えば、人の情報を勝手に使ったり、嘘を広めたりするAIはダメだよね?そういうことを防ぐためのルール作りなんだ。

AIを知りたい

なるほど。AIにもルールが必要なんですね。どんなルールがあるんですか?

AIエンジニア

例えば、AIが作ったものだとわかるように表示するルールや、個人情報を使う時に許可を得るルールなどがあるよ。他にも、AIが差別的なことをしないようにするルール作りも進められているんだ。

規制化とは。

人工知能にまつわる言葉である「規制」について説明します。この「規制」とは、人工知能の技術やその使い方に対して、法律や倫理に基づいたルールや制限を設けることを意味します。人工知能がどのように動いているのかが分かりにくいことや、個人の情報の保護、みんなにとって公平であるか、安全であるか、倫理的に問題がないかといった心配事が増えているため、技術の進歩と利用の広がりに合わせて、人工知能への規制が必要になってきました。特に、最近では文章や画像などを作り出す人工知能が目立つようになってきており、それを使うことで起こる社会的な問題や倫理的な問題に対処するために、さまざまな法律や倫理に基づいた取り組みが行われています。

規制の必要性

人工知能は、近頃めざましい進歩を遂げ、暮らしに様々な良い影響を与えています。例えば、機械が自分で車を動かす技術や、病気を診断する手助け、お客さまへの対応の改善など、活用の範囲は広く、社会全体の効率を高め、暮らし向きをよくするのに大きく役立っています。

しかし、それと同時に、人工知能を使うことで起こる様々な心配事も増えています。例えば、人工知能の誤った判断によって人の命に関わる事故が起きるかもしれないという不安があります。また、個人の秘密の情報が不正に使われたり、人工知能が人々を差別したり、偏った判断をするといった問題も、解決しなければならない課題として山積みになっています。

人工知能が社会に広く使われるようになるにつれ、こうした危険をきちんと管理し、倫理的な問題にきちんと対応するためのルール作りが必要になっています。人工知能は膨大な量の情報を学習して賢くなりますが、その学習データに偏りがあれば、偏った判断をする可能性があります。例えば、特定の人種や性別に対して不公平な情報が含まれていると、人工知能も差別的な判断を下す可能性があります。

また、人工知能がどのように判断を下したのかが分かりにくいという問題もあります。複雑な計算を経て答えを出すため、なぜその結論に至ったのかを人間が理解するのは難しい場合が多く、もし誤った判断がされた場合、原因を特定して修正することが困難になります。

さらに、人工知能の進化によって、人間の仕事が奪われるという懸念もあります。単純作業だけでなく、高度な知識や技能が必要な仕事も人工知能に取って代わられる可能性があり、雇用への影響は無視できません。

これらの問題に対処するために、人工知能の開発や利用に関する明確なルールを定め、適切な監視を行う仕組みが必要です。また、人工知能に関する倫理的な教育を推進し、社会全体の理解を深めることも重要です。人工知能の恩恵を最大限に享受しつつ、潜在的なリスクを最小限に抑えるためには、社会全体で議論を深め、適切な規制の枠組みを構築していく必要があるでしょう。

| メリット | デメリット | 課題と対策 |

|---|---|---|

|

|

|

透明性の確保

人工知能技術の利用が広まるにつれ、その判断の過程が不透明であることが問題となっています。人が理解しにくい複雑な計算に基づいて結論を出すため、まるで中身の見えない黒い箱のようです。このため、人工知能がどのような理由で特定の結果を出したのかを人が理解することは難しく、信頼性を築く上で大きな障害となっています。

例えば、人工知能を使った融資審査を考えてみましょう。もし人工知能が融資を拒否した場合、その理由が分からなければ、利用者は納得できません。理由が分からなければ、改善点も分からず、ただ不公平感を抱くだけでしょう。また、採用活動で人工知能を活用する場合にも、同じ問題が生じます。もし採用担当者が人工知能の判断根拠を理解できなければ、本当に適正な評価が行われているのか疑問を抱き、最終的に人工知能の判断を信頼できなくなるでしょう。

このような問題を防ぐため、人工知能の判断過程を明らかにする仕組み作りが重要です。人工知能がどのような情報に基づいて、どのような計算を行い、最終的にどのような結論に至ったのかを、人が理解できる形で示す必要があります。これは、人工知能を使う側にとってだけでなく、人工知能を作る側にとっても重要なことです。開発者自身も、人工知能の判断過程を理解することで、予期せぬ誤作動や偏った判断を防ぎ、より信頼性の高い人工知能を開発できるようになります。

透明性を高めることは、人工知能の信頼性を高めるだけでなく、社会全体の利益にもつながります。人工知能の利用者が安心して利用できるようになり、様々な分野での活用が促進されるからです。そのため、人工知能の透明性確保に向けた取り組みは、今後ますます重要になるでしょう。

| 問題点 | 具体例 | 解決策 | メリット |

|---|---|---|---|

| AIの判断過程の不透明性 | 融資審査での拒否理由不明、採用活動での評価根拠不明 | AIの判断過程を明らかにする仕組み作り | AIの信頼性向上、利用者の安心感向上、様々な分野での活用促進 |

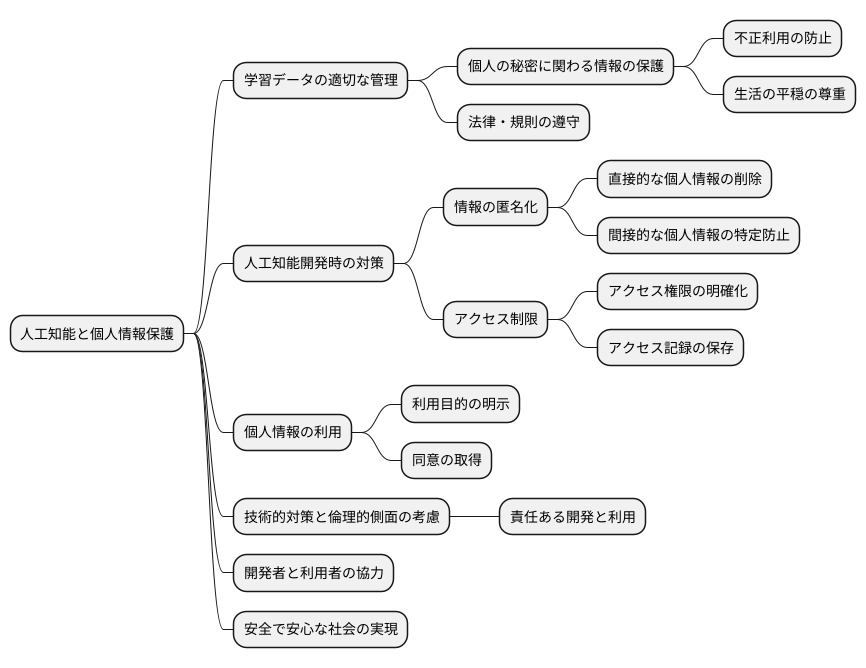

個人情報保護

人工知能は、膨大な量の情報を学習することで、その能力を高めていきます。学習に使われる情報の中には、個人の秘密に関わる情報が含まれている場合もあり、これらの情報の不正な利用や、個人の生活を乱す危険性が心配されています。そのため、人工知能を作る時や使う時には、個人の秘密に関わる情報を適切に管理し、保護することが必要不可欠です。個人の秘密を守るための法律や規則に従うことは当然のことです。さらに、人工知能の仕組みを作る段階から、個人の生活を守ることを考えて、様々な対策を立てなければなりません。

例えば、個人の秘密に関わる情報を特定できないような形に変えたり、情報にアクセスできる人を制限したりすることが考えられます。具体的には、名前や住所などの直接的な個人情報を消すだけでなく、複数の情報を組み合わせることで個人が特定できるような場合も考慮する必要があります。また、誰がどのような目的で個人情報にアクセスできるのかを明確に定め、アクセス記録を残すことで、不正利用を防ぐことができます。さらに、人工知能の学習データとして個人情報を利用する場合は、利用目的を明示し、同意を得ることが重要です。利用者の生活の平穏を尊重し、個人の秘密に関わる情報を適切に管理することで、人工知能の技術に対する信頼を高めることに繋がります。

人工知能は様々な分野で活用が期待されていますが、その発展には、個人情報の保護が不可欠です。技術的な対策だけでなく、倫理的な側面も考慮した上で、責任ある開発と利用を進めていく必要があります。そのためには、開発者だけでなく、利用者も個人情報保護の重要性を理解し、協力していくことが大切です。 人工知能と個人情報保護のバランスを取りながら、安全で安心な社会を実現していくことが、私たちの未来にとって重要な課題です。

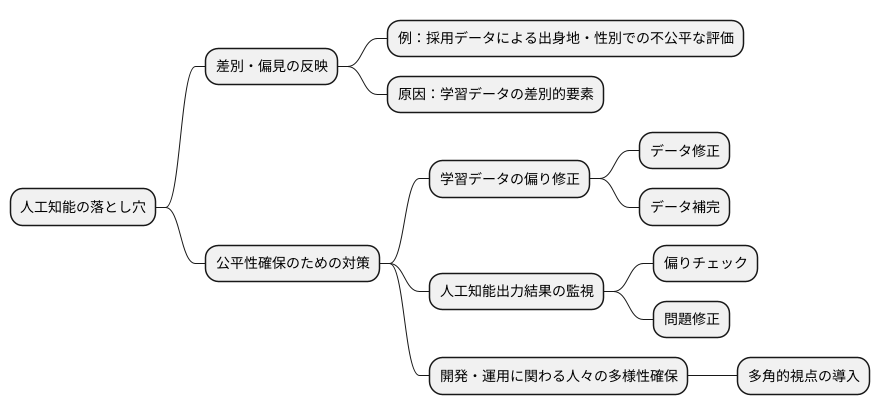

公平性の担保

人工知能(じんこうちのう)は、わたしたちの生活を便利にする一方で、思わぬ落とし穴も持っています。それは、学習に使うデータに潜む偏見や差別を、そのまま反映してしまう可能性があるということです。例えば、過去の採用データから学習した人工知能が、特定の出身地や性別を持つ人に対して不利な評価を下してしまうかもしれません。これは、過去のデータに、意図的あるいは無意識的に差別的な要素が含まれていた場合に起こりえます。

このような人工知能による差別や偏見を防ぎ、公平性を確実にするためには、様々な対策が必要です。まず、学習データの偏りを修正することが重要です。過去のデータに偏りがある場合は、それを修正したり、不足しているデータを補うことで、より公平な学習を促すことができます。また、人工知能が出力した結果を監視する仕組みも必要です。人工知能の判断に偏りがないか、常にチェックし、問題があれば修正していく必要があります。さらに、人工知能の開発や運用に関わる人々の多様性を確保することも大切です。様々な背景を持つ人々が関わることで、多角的な視点を取り入れ、偏りのない人工知能を開発することができます。

人工知能の公平性を確保することは、わたしたちの社会全体の公正さを維持するために不可欠です。誰もが属性に関わらず平等に扱われる社会を実現するためには、人工知能システムが公正に機能することが求められます。そのためにも、人工知能の開発者、利用者、そして社会全体で、人工知能の公平性について考え、対策を講じていく必要があると言えるでしょう。

安全性の確保

人の命に直接関わる分野、例えば自動で車を動かす技術や病気を診断する手伝いをする技術といったものにおいて、人工知能の安全性は最も大切なことです。もし人工知能が間違って動いたり、予想外の行動をとったりすると、大きな事故につながる恐れがあります。例えば、自動運転中の車が誤作動を起こして衝突事故を起こしたり、医療診断支援システムが誤診をして適切な治療が遅れたりするといった深刻な事態も想定されます。

このような事態を防ぐためには、人工知能システムの安全性を確実にするための厳しいルール作りが必要です。具体的には、人工知能を開発する段階で、様々な状況を想定した十分な試験や効果の検証を行う必要があります。想定されるあらゆる条件下で、人工知能が正しく動作することを確認し、潜在的なリスクを洗い出す必要があります。また、誤作動や予期せぬ挙動が発生した場合の対応策も事前に準備しておくことが重要です。

さらに、人工知能システムを実際に使い始めてからも、継続的にシステムの状態を監視し、問題が発生していないかを確認することが重要です。人工知能は学習を続けることで性能が変化していくため、運用開始後も常にシステムの安全性を確認し続ける必要があります。そして、もし問題が見つかった場合は、速やかにシステムを修正したり、運用を一時停止したりするといった適切な措置をとる必要があります。

このように、開発段階での入念な試験や検証、運用開始後の継続的な監視など、安全性を確実にするための対策を徹底することで、人工知能技術を誰もが安心して使える環境を作っていくことが重要です。人工知能技術は私たちの生活を豊かにする可能性を秘めていますが、その恩恵を安全に享受するためには、安全性確保へのたゆまぬ努力が欠かせません。

| フェーズ | 対策 | 目的 |

|---|---|---|

| 開発段階 | 様々な状況を想定した十分な試験と効果の検証 潜在的なリスクの洗い出し 誤作動や予期せぬ挙動発生時の対応策準備 |

人工知能システムの安全性を確実にする |

| 運用開始後 | 継続的なシステム状態の監視 問題発生時の迅速な対応(システム修正、運用一時停止など) |

常にシステムの安全性を確認し続ける |

倫理的な配慮

人工知能技術の発展は目覚ましいものですが、それと同時に様々な倫理的な問題も浮かび上がらせています。便利な道具である反面、使い方を誤れば社会に大きな混乱をもたらす可能性も秘めているため、慎重な利用が求められます。

まず、雇用への影響について考えてみましょう。人工知能は様々な作業を自動化できるため、人間の仕事が奪われるという懸念があります。工場での単純作業だけでなく、事務作業や高度な専門職の一部も代替可能になるかもしれません。人工知能によって仕事を失った人々への支援策や、新たな働き方を模索するための教育制度の整備など、早急な対策が必要です。

次に、人工知能を搭載した兵器、いわゆる自律型兵器の開発についても議論が必要です。人間が関与せずに攻撃を行う兵器は、誤作動や予測不能な事態を引き起こす危険性があります。また、誰が責任を負うのかという問題も明確になっていません。国際的なルール作りを通して、兵器利用の歯止めをかける必要があります。

さらに、人工知能による判断の偏りも懸念材料です。人工知能は学習データに基づいて判断を行うため、データに偏りがあれば、その偏見を反映した結果を出力してしまいます。例えば、採用活動において、過去のデータに基づいて特定の属性の人物を不利に扱う可能性も考えられます。公正な判断を行うためには、学習データの偏りをなくすための工夫や、人工知能が出力した結果を人間がチェックする仕組みが必要です。

人工知能技術をより良い方向に活用していくためには、社会全体で倫理的な指針を定め、開発者や利用者がその指針に沿って行動することが不可欠です。継続的な議論と、社会全体の理解を深める努力が求められています。

| 倫理的問題 | 懸念事項 | 対策 |

|---|---|---|

| 雇用への影響 | 人工知能による仕事の自動化、人間の失業 | 失業者への支援策、新たな働き方のための教育制度の整備 |

| 自律型兵器の開発 | 誤作動や予測不能な事態、責任の所在の不明確さ | 国際的なルール作りによる兵器利用の規制 |

| 人工知能による判断の偏り | 学習データの偏りによる不公正な判断 | 学習データの偏りの解消、人間のチェックによる是正 |