AIと公平性、説明責任、透明性

AIを知りたい

先生、『FAT』って言葉、AIの授業で出てきたんですけど、どういう意味ですか?

AIエンジニア

いい質問だね。『FAT』はAIを正しく使う上でとても大切な考え方だよ。公平性、説明責任、透明性という三つの言葉の頭文字をとったものなんだ。つまり、AIはみんなにとって公平に使えるように設計し、作った人や運用する人は、AIの動きについてきちんと説明する責任を持つ。そして、AIがどのように動くのか、みんながわかるように透明性を保つ必要がある、ということを『FAT』は示しているんだよ。

AIを知りたい

なるほど。三つとも大切なんですね。でも、なぜ大切なんですか?

AIエンジニア

もし、AIが公平でなかったら、特定の人たちに不利な結果をもたらすかもしれないよね。また、AIの動きがわからなかったり、説明責任がなかったら、何か問題が起こった時に原因を突き止めるのが難しくなる。だから、AIを信頼して使うためには、この三つの要素が不可欠なんだよ。

FATとは。

人工知能を使うにあたっては、『公平性』『説明責任』『透明性』の三つが重要だと言われています。この三つをまとめて『FAT』と呼ぶこともあります。公平性とは、人工知能が全ての人に対して偏りなく、平等に扱われるようにすることです。説明責任とは、人工知能の判断や行動について、なぜそうしたのかを明確に説明できるようにすることです。透明性とは、人工知能の仕組みや働きが誰にでも分かりやすく公開されている状態を指します。人工知能を正しく運用するためには、この三つ全てを守ることが欠かせません。

はじめに

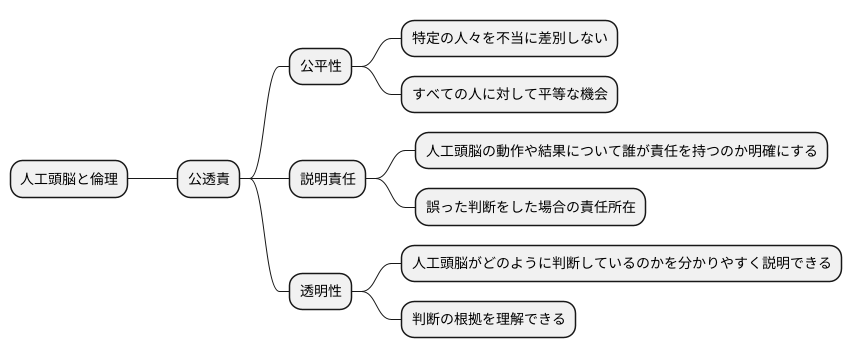

近ごろ、人工頭脳は、暮らしの様々な場面で見かけるようになりました。買い物をする時、道を調べる時、音楽を聴く時など、気が付かないうちに人工頭脳の恩恵を受けていることも少なくありません。とても便利な反面、人工頭脳を使う際には、倫理的な側面も考えなくてはなりません。人工頭脳の仕組みが不公平だったり、誰の責任で動いているのか分からなかったり、どのように判断しているのかが分からなかったりすると、社会に悪い影響を与えることがあるからです。

そこで、本稿では、人工頭脳システムにおける「公平性」「説明責任」「透明性」の大切さについて説明します。これらをまとめて「公透責」と呼ぶことにしましょう。

まず「公平性」とは、人工頭脳が特定の人々を不当に差別しないことです。例えば、採用活動で使う人工頭脳が、ある特定の属性の人を不利に扱うようなことがあってはなりません。すべての人に対して、平等な機会が与えられるように設計する必要があります。

次に「説明責任」とは、人工頭脳の動作や結果について、誰が責任を持つのかを明確にすることです。人工頭脳が誤った判断をした場合、誰に責任を問えば良いのか、どのように改善していくのかをあらかじめ決めておくことが重要です。

最後に「透明性」とは、人工頭脳がどのように判断しているのかを分かりやすく説明できることです。人工頭脳の中身は複雑で分かりにくいものですが、利用者にとって、その判断の根拠を理解できることはとても大切です。なぜその結果になったのかが分からなければ、人工頭脳を安心して使うことはできません。

これら「公透責」の三つの原則を理解し、人工頭脳システムを作る時や使う時に活かすことで、より良い社会を作っていきましょう。人工頭脳は便利な道具ですが、使い方を誤ると危険な道具にもなり得ます。倫理的な側面を常に意識し、責任ある行動を心がけることが重要です。

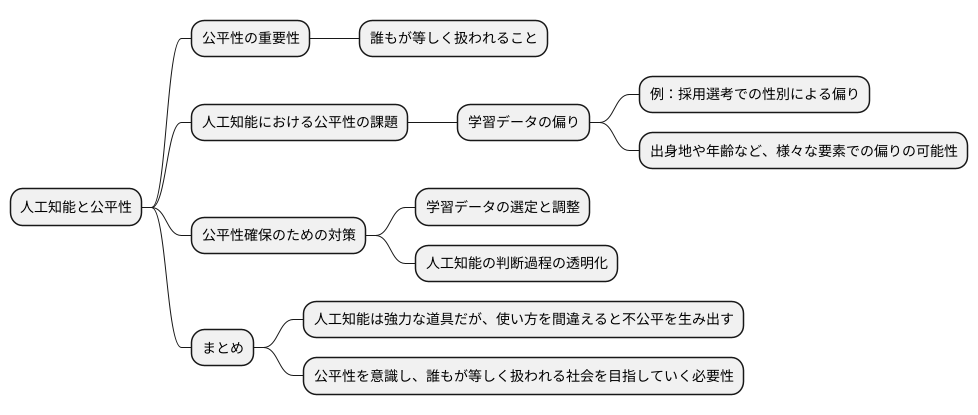

公平性とは

誰もが等しく扱われること、それが公平性です。人工知能の分野でも、この公平性は大変重要です。人工知能は、大量の情報を元に学習し、様々な判断や予測を行います。もし、学習に使われる情報に偏りがあると、人工知能も偏った判断をしてしまうかもしれません。

例えば、会社の採用選考に人工知能を使う場面を考えてみましょう。過去の採用データに男性が多く含まれていると、人工知能は男性を採用しやすいと学習してしまうかもしれません。これは、女性にとって不公平な結果を生み出す可能性があります。性別だけでなく、出身地や年齢など、様々な要素で偏った判断が生まれる可能性があります。

このような偏りを防ぐためには、人工知能の開発段階から公平性に配慮することが重要です。学習に使う情報を注意深く選び、偏りがないように調整する必要があります。また、人工知能の判断過程を透明化し、なぜそのような判断をしたのかを人が理解できるようにすることも大切です。

人工知能は、私たちの社会をより良くするための強力な道具です。しかし、使い方を間違えると、不公平を生み出す原因にもなりかねません。だからこそ、人工知能を開発し、利用する際には、常に公平性を意識し、誰もが等しく扱われる社会を目指していく必要があります。人工知能の公平性を確保することは、これからの社会における公正さを守る上で欠かせない取り組みです。

説明責任とは

説明責任とは、人工知能の仕組みや判断について、分かりやすく説明できる状態のことを指します。まるで人のように複雑な思考を行う人工知能ですが、その思考過程が分からなければ、なぜそのような結果になったのか理解することができません。これは、まるで中身の見えない黒い箱のようなものです。

人工知能がどのように答えを導き出したのか、その理由を説明できることは、人々の信頼を得る上でとても大切です。例えば、病気の診断を人工知能に任せる場面を考えてみましょう。もし人工知能が「あなたは病気です」とだけ告げ、その理由を説明してくれなければ、患者は不安になり、その診断結果を受け入れることは難しいでしょう。人工知能の判断を信頼し、安心して利用するためには、その判断の根拠を知る必要があるのです。

また、問題が起きた時、その原因を突き止め、責任の所在を明らかにするためにも、説明責任は欠かせません。もし自動運転車が事故を起こした場合、なぜ事故が起きたのか、誰が責任を負うのかを明らかにする必要があります。人工知能がどのように判断し、どのような行動をとったのかを説明できなければ、原因究明は難航し、再発防止策を講じることもできません。

このように、説明できない人工知能、いわゆるブラックボックス型の人工知能は、社会的な信頼を得ることが難しく、運用上の危険も高まります。そのため、説明可能な人工知能、つまり人工知能の思考過程を分かりやすく説明できる仕組みの開発が、人工知能を広く普及させる上で重要な課題となっています。人工知能が社会に受け入れられ、より良いものとなるためには、その判断過程の透明性を高め、人々が安心して利用できる環境を整備していくことが不可欠です。

| 説明責任の必要性 | 説明責任がない場合の問題点 | 具体例 |

|---|---|---|

| 人々の信頼を得る | 思考過程が分からなければ、結果を理解できない。信頼性が低下する。 | 病気の診断で、結果のみを提示されても患者は不安になり、診断を受け入れにくい。 |

| 問題発生時の原因究明と責任所在の明確化 | 原因究明が難航し、再発防止策を講じることができない。 | 自動運転車の事故で、AIの判断過程が分からなければ、責任所在の明確化が困難。 |

| 社会的な信頼の獲得と運用上の危険回避 | ブラックボックス型のAIは、社会的な信頼を得ることが難しく、運用上の危険も高まる。 | – |

透明性とは

「透明性」とは、人工知能の仕組みや情報の源、計算方法などが明らかにされている状態のことです。 ちょうど、澄んだ水を通して底まで見渡せるように、人工知能の働きが分かりやすく示されている様を指します。

人工知能の透明性を高めることで、使う人はその仕組みを理解し、安心して利用できるようになります。 例えば、自動運転車がどのように周囲の状況を判断し、どのような経路で走行するのかが分かれば、より安心して乗車できます。また、融資の審査で人工知能が使われている場合、どのような情報に基づいて判断が下されたのかが分かれば、利用者は納得感を得られます。

さらに、透明性を確保することで、専門家による検査や評価がしやすくなります。 人工知能の仕組みが公開されていれば、専門家は問題点や改善点を的確に見つけることができます。これは、人工知能の安全性を高め、より信頼できるものにするためにも重要です。もし、人工知能が誤った判断をした場合、その原因を特定し、再発を防ぐための対策を立てることができます。

透明性の高い人工知能は、社会全体の理解と協力を得ながら発展していく上で欠かせません。 人工知能は、私たちの生活を豊かにする可能性を秘めていますが、同時に、使い方によっては思わぬ問題を引き起こす可能性もあります。そのため、人工知能の開発や利用にあたっては、社会全体の理解と協力が不可欠です。透明性を高めることで、人工知能に対する不安や懸念を払拭し、社会全体の合意形成を図ることができます。

人工知能の内部構造や情報の処理方法などを公開することは、技術的に難しい面もありますが、人工知能の健全な発展には必要不可欠な取り組みです。 今後、人工知能が社会に浸透していく中で、透明性を確保するための技術開発やルール作りがますます重要になっていくでしょう。

| 透明性とは | 人工知能の仕組みや情報の源、計算方法などが明らかにされている状態 |

|---|---|

| 透明性のメリット(利用者) |

|

| 透明性のメリット(専門家) |

|

| 透明性のメリット(社会) |

|

| 今後の課題 | 透明性を確保するための技術開発やルール作り |

FATの相互関係

公平性、説明責任、透明性。これらは、人工知能が社会に受け入れられ、信頼されるために欠かせない三つの柱です。まるで三つ組のように、これらは互いに深く結びつき、影響し合っています。この三つの関係性を紐解いてみましょう。

まず、透明性について考えてみます。透明性とは、人工知能の仕組みや判断の根拠が、利用者にとって分かりやすい形で示されている状態です。例えるなら、料理のレシピが公開されているようなものです。材料や作り方の手順が分かれば、どのような料理が出来上がるのか予測できますし、もし問題があれば原因を特定しやすくなります。人工知能も同様に、その仕組みが明らかであれば、なぜそのような結果になったのかを理解し、評価することができます。これは、公平性と説明責任を支える重要な土台となります。

次に、公平性について見てみましょう。公平性とは、人工知能が特定の個人や集団を不当に差別しないことです。人工知能が人々の生活に深く関わっていく中で、その判断が公平であることは非常に重要です。例えば、ローン審査や採用選考などで人工知能が使われる場合、特定の属性を持つ人々が不利に扱われることがあってはなりません。透明性の高い人工知能であれば、その判断過程を検証し、偏りがないかを確認することができます。公平性を確保するためには、透明性が不可欠なのです。

最後に、説明責任についてです。説明責任とは、人工知能の開発者や運用者が、そのシステムの動作や結果について責任を持つことです。もし人工知能が誤った判断をし、誰かに損害を与えた場合、誰がどのように責任を取るのかが明確でなければなりません。透明性があれば、問題の原因を特定し、責任の所在を明らかにすることができます。また、責任を明確にすることで、開発者や運用者はより慎重にシステムを設計・運用するようになり、結果として公平性の向上にも繋がります。

このように、公平性、説明責任、透明性は、互いに補完し合い、強化し合う関係にあります。この三つのバランスを保つことが、信頼できる人工知能を実現するための鍵となるでしょう。

これからのAI開発に向けて

近頃、人工知能の技術は目覚ましい進歩を遂げており、私たちの暮らしの中に急速に浸透しつつあります。今後、人工知能は社会のあらゆる場面で活躍し、私たちの生活をより豊かに、より便利にしてくれると期待されています。しかし、その一方で、人工知能技術の利用には潜在的な危険性も潜んでいることを忘れてはなりません。人工知能を正しく活用し、その恩恵を最大限に受けるためには、公正さ、説明責任、透明性という三つの重要な原則、すなわち「公明正大であること」「責任能力を持つこと」「明瞭であること」の頭文字をとった三原則を遵守することが不可欠です。

第一に、人工知能は全ての人にとって公平であるべきです。人工知能が特定の人々を差別したり、不利益を与えたりすることがあってはなりません。開発者は、あらゆる人々が平等に人工知能の恩恵を受けられるように、偏見のない公正な人工知能を開発する必要があります。第二に、人工知能の判断過程は説明可能であるべきです。人工知能がどのように結論に至ったのかを理解することで、私たちは人工知能をより信頼し、安心して利用することができます。透明性の高い人工知能は、利用者からの信頼を得るだけでなく、問題発生時の原因究明にも役立ちます。第三に、人工知能の仕組みは透明性が高く、誰にでも理解できるものでなければなりません。複雑で分かりにくい人工知能は、誤解や不信感を招き、社会全体の不安を高める可能性があります。

人工知能は道具であり、使い方次第で社会に大きな利益をもたらす反面、使い方を誤れば大きな損害をもたらす可能性もあります。開発者だけでなく、利用者、そして社会全体が人工知能技術の健全な発展のために、これらの原則の重要性を理解し、責任ある行動をとる必要があります。私たちは今、人工知能とどのように共存していくべきか、真剣に考えるべき時期に来ていると言えるでしょう。

| 原則 | 説明 | 目的/効果 |

|---|---|---|

| 公正さ | 人工知能は全ての人にとって公平であるべき。特定の人々を差別したり、不利益を与えたりしてはならない。 | あらゆる人々が平等に人工知能の恩恵を受けられるようにする。 |

| 説明責任 | 人工知能の判断過程は説明可能であるべき。どのように結論に至ったのかを理解できるようにする。 | 人工知能への信頼と安心を高める。問題発生時の原因究明に役立つ。 |

| 透明性 | 人工知能の仕組みは透明性が高く、誰にでも理解できるものであるべき。 | 誤解や不信感を避け、社会全体の不安を抑える。 |