生成系AIが生み出す新たなリスク

AIを知りたい

先生、「新たなリスク」って、画像や動画が上手に作れるようになったこと以外にも何かあるんですか?

AIエンジニア

いい質問だね。確かに画像や動画の偽造は大きなリスクだけど、それだけじゃないんだ。例えば、AIが作ったものの責任の所在が曖昧なことも問題なんだよ。

AIを知りたい

責任の所在が曖昧って、どういうことですか?

AIエンジニア

例えば、AIが誰かの著作権に抵触する作品を作ってしまった場合、誰が悪いことになるのか、はっきりしないということだよ。作ったAIが悪いのか、AIを作った人なのか、AIを使った人なのか、判断が難しいんだね。他にも、AIが不適切な内容のものを生成した場合なども、同じような問題が発生するんだよ。

新たなリスクとは。

人工知能に関する『新しい危険性』について説明します。人工知能、特に文章や画像などを作り出す人工知能の進化は、色々な分野で役に立ちますが、同時に悪い影響や危険性も持っています。

例えば、今や人工知能で作った画像は、本物の写真と見分けがつかないほど精巧になっています。動画も、同じようにとても自然に作れるようになってきています。このような技術を使うと、嘘の情報を盛り込んだ画像や動画を簡単に作れてしまいます。そして、それを使って、偽の情報が広く世の中に広まる危険性があります。

また、人工知能が作ったものの責任の所在が不明確であることも問題です。著作権に違反するものや、過激な内容、倫理的に良くないものを作って、売ったり広めたりすることもできてしまいます。こうした問題に対して、はっきりと規制できる法律を整備する必要があります。

偽の情報による混乱

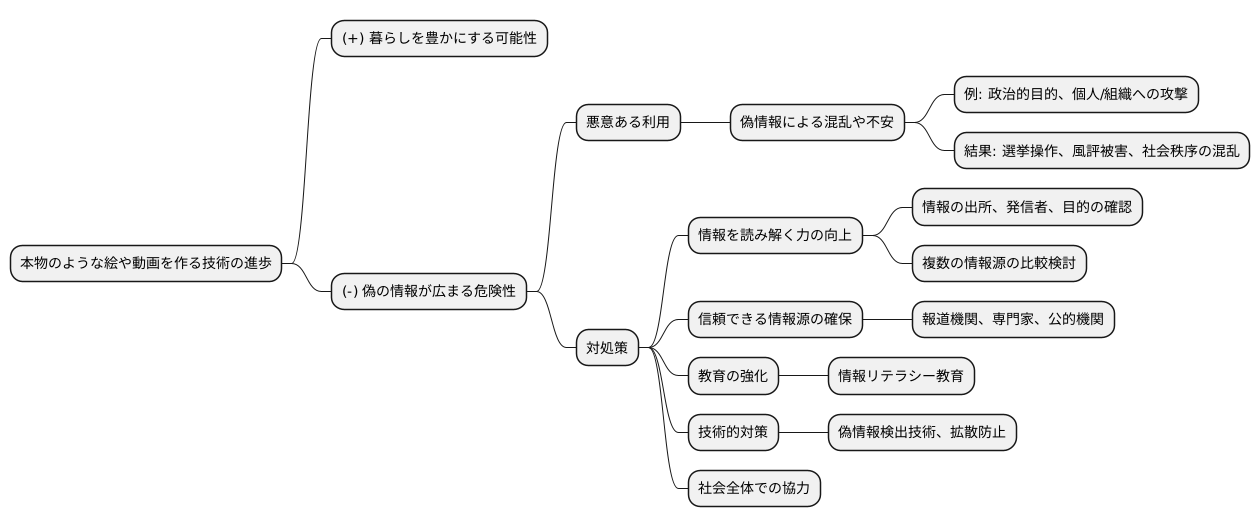

近ごろ、絵や動画をまるで本物のように作り出す技術が急速に進歩しています。この技術は、私たちの暮らしを豊かにするたくさんの可能性を秘めている一方で、偽物の情報が広まる危険性も高めています。

悪意を持った人がこの技術を misuse して、事実とは異なる絵や動画を作り、それを広めることで、社会全体に混乱や不安を引き起こすかもしれません。例えば、政治的な目的のために、あるいは特定の人や組織を傷つけるために、偽の情報が作り出され、広められる可能性があります。このような偽の情報は、選挙の結果を左右したり、人々の評判を傷つけたり、社会の秩序を乱す可能性があります。

このような偽の情報を見破るためには、私たち一人ひとりが情報を読み解く力を身に付けることが大切です。情報の出所はどこなのか、誰が何のためにその情報を発信しているのか、といった点を注意深く確認する必要があります。また、複数の情報源を比較検討し、情報の信憑性を確かめることも重要です。

信頼できる情報源を見つけることも大切です。信頼できる報道機関や専門家の意見を参考にしたり、公的機関が提供する情報をチェックするなどして、正確な情報を得るように心がける必要があります。

さらに、学校や地域社会で、情報を読み解く力を育てるための取り組みをもっと積極的に進める必要があります。子供たちだけでなく、大人も含めて、情報の真偽を見極める力を養うための教育が不可欠です。また、技術的な対策も重要です。偽の情報を見つける技術を開発したり、偽の情報が拡散するのを防ぐ仕組みを作るなど、様々な対策が必要です。

偽の情報による混乱を防ぎ、正しい情報に基づいて判断し、行動するためには、社会全体で協力して取り組む必要があります。私たち一人ひとりが意識を高め、適切な行動をとることで、偽の情報に惑わされることなく、より良い社会を築くことができるでしょう。

責任の所在のあいまいさ

近頃話題となっている文章や画像などを作り出す人工知能。その活用範囲は広がる一方ですが、作り出されたものに関して、誰が責任を負うのかという問題が未解決のまま残っています。人工知能が作った文章や画像に問題があった場合、誰に責任を問えば良いのでしょうか。

例えば、人工知能が作った文章が、既に発表されている他者の著作物と酷似していたとします。この場合、著作権の侵害にあたる可能性がありますが、誰に責任があるのかは容易に判断できません。人工知能を作った人、それを使った人、はたまた人工知能自身に責任があると言えるのでしょうか。現状では、人工知能は道具であり、それを使う人に責任があると考える人が多いですが、人工知能がますます高度になり、自ら考えて行動するようになるにつれて、この考え方も変わっていくかもしれません。

また、人工知能が作り出した情報に誤りがあった場合も同様です。例えば、健康に関する情報を人工知能が提供し、その情報が間違っていたために利用者が健康被害を被ったとしたら、誰がその責任を負うべきでしょうか。人工知能の提供者でしょうか、それとも利用者自身でしょうか。

人工知能が作り出したものに対する責任の所在を明らかにすることは、人工知能技術が健全に発展していく上で非常に重要です。責任の所在があいまいなままでは、人工知能の利用に不安がつきまとい、技術の進歩も阻害されてしまうでしょう。そのため、人工知能に関する新しい法律や倫理的な指針を整備することが急務となっています。人工知能技術の発展と安全な利用のために、責任の所在に関する明確なルール作りが求められています。

| 問題点 | 責任の所在 | 具体例 |

|---|---|---|

| 著作権侵害 | 不明瞭(AI作成者、使用者、AI自身?) | AI生成文章が既存著作物と酷似 |

| 情報誤りによる損害 | 不明瞭(AI提供者、利用者?) | AI提供の誤った健康情報による健康被害 |

有害なコンテンツの拡散

近頃話題となっている文章や画像などを作り出す人工知能は、便利な反面、倫理的に問題のある情報や過激な思想を含む情報、違法な情報を作成できてしまうという危険性も持っています。具体例として、憎悪を煽る発言や差別的な表現、暴力や犯罪を肯定するような内容、わいせつな画像など、社会にとって有害な情報が簡単に作られ、広まってしまう恐れがあります。これらの情報は、人の尊厳を傷つけ、社会の秩序を乱すだけでなく、犯罪に繋がる可能性も否定できません。

また、人工知能が悪用され、テロや犯罪を助長する目的で利用される懸念もあります。例えば、偽の情報で人を騙したり、特定の人物を誹謗中傷するような情報操作、あるいは犯罪計画の立案などに利用される可能性も考えられます。人工知能は使い方によっては非常に危険な道具となり得るのです。人工知能技術の進歩は素晴らしいものですが、同時に、その使い方には大きな責任が伴います。私たちはこの技術を正しく使い、社会に悪い影響を与えるような使い方は避けなければなりません。

そのためには、人工知能技術に関する倫理的な教育や啓発活動が重要です。人工知能技術の仕組みや特性、倫理的な問題点、適切な使い方などを学ぶ機会を設け、技術の利用者一人ひとりが責任感を持つ必要があります。また、人工知能技術の開発者も、倫理的な側面を考慮した開発を行うことが求められます。人工知能技術を安全に利用していくためには、技術の進歩と倫理的な教育の両輪が不可欠と言えるでしょう。さらに、法的な規制や監視体制の整備も重要です。有害な情報の拡散を防ぎ、悪用を阻止するための対策を講じる必要があります。人工知能技術は、正しく使えば社会をより良くする力となります。私たちは皆で協力し、この技術を責任感を持って利用していく必要があるでしょう。

| 項目 | 内容 |

|---|---|

| 人工知能の危険性 | 倫理的に問題のある情報、過激な思想を含む情報、違法な情報を作成できてしまう。

人の尊厳を傷つけ、社会の秩序を乱すだけでなく、犯罪に繋がる可能性もある。

|

| 対策 |

|

法整備の必要性

近頃、急速に進化を遂げている生成系人工知能(AI)技術は、私達の生活に様々な恩恵をもたらす可能性を秘めています。しかし、同時に新たな問題も浮き彫りになってきています。生成系AIが作り出す文章や画像、音声などの著作物の権利は誰に帰属するのか、AIが不適切な情報を生成した場合の責任はどこにあるのか、AIが悪用されて有害な情報が拡散された場合はどう対処するのかなど、解決すべき課題は山積しています。

現状では、これらの問題に対処するための明確な法の枠組みが整備されていません。例えば、AIが既存の著作物を学習し、それと酷似したものを生成した場合、現在の著作権法では権利侵害にあたるのかどうか判断が難しい場合があります。また、AIが差別的な表現や暴力的な内容を含む文章や画像を生成した場合、誰が責任を負うのか、どのように規制するのか明確な基準がありません。

このような状況下で、AI技術が急速に発展していくと、様々な問題が深刻化し、社会に混乱を招く恐れがあります。AI技術の健全な発展と社会の安全を守るためには、AI技術の進歩に合わせた法整備が急務です。具体的には、AIが生成した著作物の権利の帰属、AIによる不適切な情報生成の際の責任の所在、有害な情報の拡散に対する規制などについて、明確なルールを定める必要があります。

関係各機関は、それぞれの立場や意見にとらわれず、協力して具体的な法整備に向けた議論を早急に進める必要があります。また、法整備を進める際には、技術の進歩の速度にも配慮し、柔軟に対応できるような仕組みを構築することも重要です。AI技術の利点を最大限に活かしつつ、潜在的なリスクを適切に管理することで、より良い社会の実現を目指していくべきです。

| 項目 | 内容 |

|---|---|

| 生成系AIの利点 | 生活に様々な恩恵をもたらす可能性 |

| 生成系AIの課題 |

|

| 現状の課題 |

|

| AI技術の健全な発展のために必要なこと |

|

| 関係各機関への期待 |

|

| 将来への展望 | AI技術の利点を最大限に活かし、潜在的なリスクを適切に管理することで、より良い社会の実現を目指す |

倫理的な課題への取り組み

人工知能を生み出し、活用していく上で、倫理的な問題に向き合うことは欠かせません。人工知能という技術は、私たちの暮らしをより良くする力を持っていますが、使い方を誤ると社会に悪い影響を与えることもあり得ます。だからこそ、開発に携わる人たちは、人工知能が倫理的に見て問題のない方法で使われるように、責任感を持った開発と活用を進める必要があるのです。

例えば、人工知能が出した結果に偏りがないか、個人の情報を勝手に扱っていないか、悪用される恐れはないか、といった点を注意深く考える必要があります。また、人工知能を使う側も、倫理的に問題のない範囲で使う責任があります。人工知能を使って、事実ではない情報を広めたり、他の人を傷つけるようなことは決して許されるべきではありません。

人工知能の倫理的な側面について、社会全体で深く話し合い、倫理的な指針を作る必要があります。倫理的な指針とは、人工知能を開発し、活用する際の道しるべとなるものです。具体的には、個人情報の保護、偏見や差別の排除、透明性の確保、説明責任の明確化などが含まれます。

人工知能を正しく使い、社会の発展に役立てるためには、倫理的な課題に真剣に取り組むことが大切です。そのためには、開発者だけでなく、利用者、教育機関、政府など、様々な立場の人々が協力し、共に考えていく必要があります。人工知能に関する教育を充実させ、倫理的な意識を高めることも重要です。また、人工知能技術の進歩は非常に速いため、常に最新の情報を共有し、変化に対応していく努力も必要です。倫理的な問題をないがしろにすれば、人工知能は社会にとって脅威となる可能性も秘めています。だからこそ、私たちは継続的に対話を重ね、より良い未来を築くために、人工知能と倫理の調和を目指していく必要があるのです。

| 項目 | 説明 |

|---|---|

| 倫理的な問題への責任 | 人工知能の開発者と利用者は、倫理的に問題のない方法で開発と活用を進める責任がある。 |

| 開発時の注意点 | 結果の偏り、個人情報の不正利用、悪用の可能性などを考慮する必要がある。 |

| 利用時の注意点 | 虚偽情報の拡散や他者への誹謗中傷など、倫理的に問題のある利用は許されない。 |

| 倫理的な指針の必要性 | 社会全体で倫理的な指針を作成し、人工知能の開発と活用の道しるべとする必要がある。 |

| 倫理的な指針の内容 | 個人情報保護、偏見や差別の排除、透明性の確保、説明責任の明確化などが含まれる。 |

| 多様な立場の人々の協力 | 開発者、利用者、教育機関、政府など、様々な立場の人々が協力し、倫理的な課題に取り組む必要がある。 |

| 教育の重要性 | 人工知能に関する教育を充実させ、倫理的な意識を高めることが重要。 |

| 継続的な対話と情報共有 | 技術の進歩に対応するため、常に最新の情報を共有し、継続的に対話を重ねる必要がある。 |