説明可能なAIとは?

AIを知りたい

先生、「説明できるAI」ってよく聞くんですけど、普通のAIとは何が違うんですか?

AIエンジニア

良い質問だね。普通のAIは、まるでブラックボックスのように、なぜその答えを出したのかが分かりにくいことが多いんだ。例えば、AIが「この写真は猫です」と答えても、なぜ猫だと判断したのか理由は示してくれない。でも、「説明できるAI」は、その判断の根拠を示してくれるんだよ。「耳の形」「ひげの有無」「目の形」といった特徴から猫だと判断した、といった具合にね。

AIを知りたい

なるほど!じゃあ、判断の理由が分かると何が便利なんですか?

AIエンジニア

そうだね。例えば、医療の診断でAIを使う場合を考えてみよう。普通のAIだと「この人は病気です」とだけ言われても、患者さんもお医者さんも納得できないよね。「説明できるAI」なら、どの検査結果のどの部分が病気の判断に繋がったのかが分かるので、診断の信頼性が高まり、治療方針も立てやすくなるんだよ。つまり、AIの判断を人間が理解し、信頼できるようになることが大きなメリットだね。

説明可能AIとは。

人工知能にまつわる言葉で「説明できる人工知能」というものがあります。(英語ではExplainable Artificial Intelligenceと言い、略してXAIと書きます。これは説明できる人工知能という意味です。)これは、人工知能がどのように考えて答えを出したのか、その手順や理由を人が理解できるようにした仕組み、あるいはそうした仕組みを作るための研究のことを指します。

説明可能なAIの登場背景

近ごろ、人工知能(AI)は目覚ましい進歩を遂げ、様々な場面で役立てられています。画像を見分けたり、言葉を理解したり、車を自動で運転したりと、AIは複雑な作業を高い正確さで行うことができます。しかし、これまでのAIには「中身の見えない箱」のような側面がありました。これは、AIがどのように考えて結論を出したのかが人に分かりにくいという問題です。つまり、AIの判断の理由や根拠がはっきりしないため、AIの信頼性や責任の所在があいまいになっていました。例えば、医療診断やお金の取引といった、人の命や財産に関わる重要な決定において、AIの判断の理由が分からないままでは、その結果をそのまま信用することは難しいでしょう。

具体的に考えてみましょう。もし、AIが融資の可否を判断する場合、その理由が分からなければ、融資を断られた人は納得できません。また、自動運転車が事故を起こした場合、AIがなぜその行動をとったのかが分からなければ、責任の所在を明らかにすることが困難です。このように、AIの判断が人の生活に大きな影響を与える場合、その判断の過程を理解することは非常に重要です。

そこで、AIの思考過程を人に分かりやすく示す「説明可能なAI(エックスエーアイ)」の必要性が高まってきました。これは、AIがどのような情報に基づいて、どのような手順で結論に至ったのかを、人が理解できる形で示す技術です。説明可能なAIは、AIの信頼性を高めるだけでなく、AIの誤りを発見したり、AIの性能を向上させたりするためにも役立ちます。また、AIを利用する人々が安心してAIを活用できる環境を作る上でも、説明可能なAIは重要な役割を果たすと考えられています。

| AIの現状 | 課題 | 解決策 | 説明可能なAIのメリット |

|---|---|---|---|

様々な分野で活躍

|

判断過程が不明瞭

|

説明可能なAI (XAI) の開発

|

|

| 例:融資判断、自動運転 | 例:融資却下の理由不明、事故原因の特定困難 |

説明可能なAIとは

人が理解しやすい人工知能、それが説明可能な人工知能(説明できる人工知能)です。この技術は、まるで魔法の箱のような、これまでの分かりにくい人工知能の仕組みを解き明かす鍵となります。人工知能がどのように考え、答えを導き出したのか、その思考の過程を人が理解できるように示してくれるのです。

従来の人工知能は、まるでブラックボックスのように、入力と出力の関係が複雑で、その内部の workings が全く見えませんでした。そのため、どんなに優れた結果を出したとしても、なぜそのような結果になったのかを人が理解することは困難でした。このブラックボックス型の workings は、人工知能への不信感や不安を生む原因ともなっていました。

説明できる人工知能は、この問題を解決するために開発されました。人工知能がどのように情報を処理し、どの情報が判断に大きく影響したのかを、分かりやすく示すことで、人がその workings を理解できるようにします。例えば、画像認識の人工知能であれば、どの部分を見て「猫」と判断したのかを、画像中の猫の輪郭を強調するなどして示すことができます。

説明できる人工知能の利用は様々な利点をもたらします。まず、人工知能の信頼性が高まります。思考の過程が分かれば、その判断の正しさや妥当性を評価することができるからです。また、誤作動や偏った判断を発見しやすくなります。さらに、人工知能がどのように学習しているのかを理解することで、より効率的な学習方法の開発にも繋がります。説明できる人工知能は、今後の社会における人工知能の活用を大きく進展させる重要な技術と言えるでしょう。

| 項目 | 説明 |

|---|---|

| 説明可能なAIの定義 | 人が理解しやすい人工知能。AIの思考過程を解き明かす。 |

| 従来のAIの問題点 | ブラックボックス型で入力と出力の関係が複雑。AIがどのように答えを導き出したのか不明。不信感や不安の原因。 |

| 説明可能なAIの仕組み | AIの思考過程、判断に影響を与えた情報を分かりやすく提示。例:画像認識AIで猫を認識した部分を強調表示。 |

| 説明可能なAIの利点 | AIの信頼性向上、誤作動や偏った判断の発見、効率的な学習方法の開発。 |

| 説明可能なAIの将来性 | 社会におけるAI活用の進展に大きく貢献する重要な技術。 |

説明可能なAIの手法

人工知能がどのように結論に至ったのかを理解することは、人工知能への信頼を高め、実社会への応用を広げる上で非常に重要です。そのため、説明可能な人工知能、つまり、その判断の根拠を人間が理解できる人工知能の開発が盛んに行われています。説明可能な人工知能を実現するための手法は様々です。

まず、もともと解釈しやすいモデルを使うという方法があります。例えば、決定木は、まるで樹形図のように判断の過程を可視化できるため、なぜその結論に至ったのかを容易に理解できます。また、ルールベース学習は、人間が理解しやすい「もし~ならば~」というルールに基づいて予測を行うため、その判断根拠が明確です。

次に、複雑なモデルの振る舞いを分析する手法があります。感度分析は、入力データのどの部分が予測結果に大きく影響を与えているかを分析する手法です。例えば、ある画像認識人工知能が「猫」と判断した際に、耳の部分が判断に大きく影響していたと分かれば、その人工知能が猫の耳の特徴を捉えていることが分かります。局所的な説明手法は、入力データを少しずつ変化させたときに、予測結果がどのように変化するかを分析します。これにより、特定の入力データに対する人工知能の判断根拠を局所的に理解することができます。

これらの手法は、それぞれ得意とする分野や不得意とする分野、扱うことのできるデータの種類が異なります。例えば、決定木は比較的小さなデータセットに適していますが、大規模なデータセットには不向きです。また、感度分析は、どの入力変数が重要かを特定できますが、具体的な判断の過程までは示せません。そのため、人工知能のタスクやデータの特性に合わせて、適切な手法を選択することが重要です。近年では、深層学習などの複雑で高度なモデルに対しても、説明可能性を高めるための研究が活発に進められています。これらの研究の進展により、今後ますます、人間にとって分かりやすく、信頼できる人工知能が実現していくと考えられます。

| 手法の分類 | 手法 | 説明 | 長所 | 短所 |

|---|---|---|---|---|

| 解釈しやすいモデル | 決定木 | 樹形図のように判断過程を可視化 | 判断根拠を容易に理解できる | 大規模なデータセットには不向き |

| ルールベース学習 | 人間が理解しやすいルールに基づいて予測 | 判断根拠が明確 | – | |

| 複雑なモデルの振る舞いを分析 | 感度分析 | 入力データのどの部分が予測結果に影響するかを分析 | どの入力変数が重要かを特定できる | 具体的な判断過程までは示せない |

| 局所的な説明手法 | 入力データを少しずつ変化させたときの予測結果の変化を分析 | 特定の入力データに対する判断根拠を局所的に理解できる | – |

説明可能なAIの応用

説明可能な人工知能は、様々な分野で応用が期待されています。これまで、人工知能はまるで魔法の箱のように扱われてきました。入力に対して出力が得られるものの、その過程は謎に包まれていました。しかし、説明可能な人工知能は、その謎を解き明かし、判断の根拠を人間が理解できる形で示してくれます。

医療の分野では、人工知能による診断結果の根拠を説明することで、医師の診断を支援したり、患者さんの理解と納得を得るために役立ちます。例えば、画像診断で人工知能が病変を発見した場合、その根拠となる画像の特徴を医師に示すことで、診断の精度を高めることができます。また、患者さんにも分かりやすく説明することで、治療方針への理解と納得を深めることができます。

金融の分野では、融資の審査や不正を検知する場面などで、人工知能の判断の根拠を明らかにすることで、透明性と公平性を保つことができます。例えば、融資の審査で人工知能が却下と判断した場合、その理由を顧客に分かりやすく示すことで、納得感を高めることができます。また、不正検知においても、人工知能が不正と判断した根拠を示すことで、誤検知を防ぎ、公正な判断を下すことができます。

自動運転の技術では、人工知能がどのように状況を判断し、どのような行動を選んだのかを説明することで、安全性と信頼性を高めることができます。例えば、自動運転車が急ブレーキをかけた場合、その理由を乗客に説明することで、不安を軽減することができます。また、事故が発生した場合にも、原因究明に役立ちます。

その他にも、製造の分野や教育の分野など、様々な分野で説明可能な人工知能の活用が進んでいます。製造の分野では、製品の品質検査などで、人工知能が不良品と判断した根拠を明らかにすることで、不良品発生の原因を特定し、改善につなげることができます。教育の分野では、生徒一人ひとりの学習状況に合わせて、人工知能が最適な学習方法を提案し、その根拠を説明することで、学習効果を高めることができます。このように、説明可能な人工知能は、様々な分野で私たちの生活をより豊かに、より安全なものにしてくれる可能性を秘めています。

| 分野 | 説明可能なAIの活用 | メリット |

|---|---|---|

| 医療 | 診断結果の根拠説明 (例:画像診断での病変発見根拠提示) | 医師の診断支援、患者の理解と納得、診断精度向上 |

| 金融 | 融資審査・不正検知の根拠提示 (例:融資却下の理由説明) | 透明性と公平性の確保、顧客の納得感向上、誤検知防止 |

| 自動運転 | 状況判断と行動選択の根拠説明 (例:急ブレーキの理由説明) | 安全性と信頼性向上、乗客の不安軽減、事故原因究明 |

| 製造 | 製品品質検査の根拠提示 (例:不良品判定の理由説明) | 不良品発生原因の特定と改善 |

| 教育 | 最適な学習方法の提案と根拠説明 | 学習効果の向上 |

説明可能なAIの課題と将来展望

説明できる人工知能はまだ研究開発の途上にある技術であり、いくつかの難題が山積しています。今後の発展のためには、これらの課題を一つ一つ解決していく必要があります。

まず、説明の正確さと分かりやすさの両立が課題です。人工知能の判断根拠を人間が理解できる言葉で説明する必要がありますが、専門用語を使わずに、かつ正確さを損なわずに説明することは容易ではありません。曖昧な表現は誤解を招き、信頼性を損なう恐れがあるため、説明の方法は慎重に検討する必要があります。

次に、計算にかかる資源の問題です。説明できる人工知能は、通常の処理に加えて、判断の根拠を説明するための処理を行うため、多くの計算資源を必要とします。膨大な量の情報を扱う場合、計算に時間がかかりすぎたり、必要な装置が高価になったりする可能性があります。このため、計算資源の効率化が重要な課題となっています。

さらに、個人の情報の保護も忘れてはなりません。人工知能が扱う情報の中には、個人の秘密が含まれる場合もあります。説明の際に、個人の秘密が漏洩しないように、情報の安全管理を徹底する必要があります。

しかし、説明できる人工知能の研究開発は、現在急速に進歩を遂げています。研究者たちの努力により、これらの課題は少しずつ克服されつつあり、近い将来、様々な分野で説明できる人工知能が活用されることが期待されます。人工知能が社会に広く受け入れられるためには、人工知能の判断過程の透明性を高め、信頼性を向上させることが不可欠です。説明できる人工知能は、人間と人工知能が互いに理解し合い、協力して問題解決に取り組む社会を実現するための、重要な技術となるでしょう。今後の研究開発の進展により、より高度で実用的な技術が確立され、様々な分野でその恩恵がもたらされることが期待されます。

| 課題 | 詳細 |

|---|---|

| 説明の正確さと分かりやすさの両立 | 専門用語を使わずに、かつ正確さを損なわずに説明することは容易ではない。曖昧な表現は誤解を招き、信頼性を損なう恐れがある。 |

| 計算にかかる資源の問題 | 通常の処理に加えて、判断の根拠を説明するための処理を行うため、多くの計算資源を必要とする。計算に時間がかかりすぎたり、必要な装置が高価になったりする可能性がある。 |

| 個人の情報の保護 | 人工知能が扱う情報の中には、個人の秘密が含まれる場合もある。説明の際に、個人の秘密が漏洩しないように、情報の安全管理を徹底する必要がある。 |

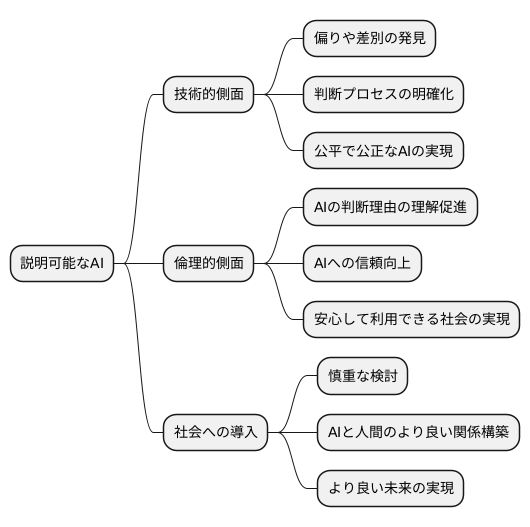

説明可能なAIの倫理的側面

人工知能が物事をどのように判断しているのかを明らかにする技術、いわゆる説明可能な人工知能は、技術的な進歩と同じくらい倫理的な側面も大切です。この技術は、人工知能が持つかもしれない偏りや差別を見つけるために役立ちます。人工知能がどのように判断したのかが分かれば、その判断に偏りや差別が含まれていないかをチェックし、必要に応じて修正することができます。これは、人工知能を公平で公正なものにするために欠かせない要素です。

また、人工知能の判断理由が理解しやすくなれば、人々は人工知能の働きをより深く理解し、納得して利用できるようになります。これは、人工知能に対する信頼を高める上で非常に重要です。なぜなら、人々は自分が理解できないものに対しては不安や不信感を抱きがちだからです。説明可能な人工知能は、このような不安を取り除き、人工知能を安心して利用できる社会を実現する上で大きな役割を果たします。

人工知能を倫理的に正しく利用するためには、説明可能な人工知能の技術開発を進めると同時に、社会への導入方法も慎重に検討する必要があります。人工知能が私たちの生活の中でますます重要な役割を担うようになるにつれて、その利用に関する倫理的な問題への対処はますます重要になってきます。説明可能な人工知能は、人工知能の公平性、透明性、そして責任を確保するための重要な道具となります。そして、人工知能と人間がより良い関係を築き、共に発展していくための鍵となるでしょう。人工知能と人間が互いに理解し合い、協力し合うことで、より良い未来を築くことができると考えられます。