価値関数:強化学習における価値の尺度

AIを知りたい

先生、「価値関数」って、エージェントが迷路のゴールに近いほど値が大きくなるんですよね?ということは、スタート地点は値が一番小さいんですか?

AIエンジニア

いい質問ですね。必ずしもそうとは限りません。スタート地点の価値は、そこからゴールにたどり着くまでの道のりの見込みで決まります。もしスタート地点からゴールまでの道筋が明確で、簡単に行けそうなら、価値は比較的高くなります。

AIを知りたい

なるほど。じゃあ、スタート地点からゴールがすごく遠くて、難しい迷路だったら、スタート地点の価値は低くなるんですか?

AIエンジニア

その通りです。ゴールへの道のりが長くて困難であれば、スタート地点の価値は低くなります。逆に、スタート地点のすぐ近くにゴールがある場合は、スタート地点の価値は高くなります。

価値関数とは。

人工知能の分野でよく使われる「価値関数」について説明します。価値関数は、強化学習という学習方法で使われるもので、簡単に言うと、ある状況や行動がどれくらい良いかを数値で表すものです。例えば、迷路を解く人工知能を考えてみましょう。ゴールに近い場所にいることは良いことなので、価値は高くなります。逆に、行き止まりにいることは良くないので、価値は低くなります。また、行き止まりに進んでしまうような行動も良くないため、価値は低くなります。人工知能は学習を通して、どのような状況や行動が良いかを数値で表すこの価値関数を学んでいきます。この価値関数をうまく学ぶことが、強化学習ではとても大切です。

価値関数の定義

強化学習とは、機械がまるで人間のように試行錯誤を繰り返しながら、与えられた課題をうまくこなせるように学習していく方法のことです。この学習を進める上で、とても大切な役割を担うのが価値関数と呼ばれるものです。価値関数は、ある状況や行動がどれほど良いかを数値で表す役割を果たします。

例えば、迷路を抜けるロボットを想像してみてください。このロボットにとって、ゴールに近い場所は価値が高く、逆に行き止まりに近い場所は価値が低いと判断できます。価値関数は、ロボットが将来得られる報酬、つまりゴールに辿り着いたときに得られる喜びを予測するのに役立ちます。そして、この予測に基づいて、より良い行動、つまりゴールへの近道をロボットは選択できるのです。

価値関数を考える上で、状態価値関数と行動価値関数という二つの種類があります。状態価値関数は、ある状況における価値を表すものです。迷路の例で言えば、あるマスにロボットがいる時の価値を数値化します。一方、行動価値関数は、ある状況で特定の行動をとった時の価値を表すものです。例えば、ロボットがあるマスで右に進む行動をとった時の価値、あるいは左に進む行動をとった時の価値などを数値化します。

価値関数をいかに正確に見積もるかは、強化学習の成否を左右する重要な要素です。価値関数の見積もり精度が高ければ、ロボットはより効率的に迷路を抜けられるようになります。逆に、見積もりが不正確であれば、遠回りしたり、行き止まりに迷い込んだりする可能性が高くなります。そのため、強化学習の研究では、いかに価値関数を正確に学習させるかという点が常に重要な課題となっています。

状態価値関数

状態価値関数とは、ある特定の状態に自分がいることが、どのくらい良いのかを示す指標です。未来に得られると予測される報酬の平均値によって、その状態の価値が決まります。例えば、迷路でゴールに近い場所にいる状態を考えてみましょう。このような状態は高い価値を持ちます。なぜなら、ゴール地点にすぐ辿り着き、報酬を獲得できる可能性が高いからです。反対に、行き止まりに立ち往生している状態を考えてみましょう。このような状態の価値は低くなります。ゴールに到達するためには、いくつもの曲がり角を回り、多くの歩数を費やす必要があるからです。つまり、報酬を得るまでに長い時間がかかってしまうのです。

この状態価値関数は、どのように計算されるのでしょうか? 未来に得られる報酬を予測するためには、方策が必要です。方策とは、それぞれの場所でどのような行動をとるかを決めた手順のことです。例えば、迷路の分岐点で、常に右に曲がるという方策を立てたとします。この方策に従って迷路を進んでいくと、最終的にゴールに辿り着くかもしれませんし、袋小路に迷い込んでしまうかもしれません。それぞれの道筋で得られる報酬を計算し、その平均値をとることで、ある状態の価値が算出されます。

状態価値関数の役割は、どの状態を目指すべきかを判断する材料を提供することです。価値の高い状態は、より多くの報酬を得られる可能性が高い状態です。ですから、エージェントは、価値の高い状態を目指して行動を選択するべきです。迷路の例でいえば、状態価値関数は、ゴールへの近道を見つけ出すための地図のような役割を果たします。価値の高い場所を辿っていくことで、効率的にゴールに到達できるのです。状態価値関数は、強化学習において重要な概念であり、様々な場面で活用されています。

| 概念 | 説明 | 例 |

|---|---|---|

| 状態価値関数 | 特定の状態の良さを示す指標。未来に得られる報酬の平均値で決まる。 | 迷路でゴールに近い場所:高い価値、行き止まり:低い価値 |

| 方策 | 各場所でどのような行動をとるかを決めた手順。 | 迷路の分岐点で常に右に曲がる |

| 状態価値関数の計算方法 | 方策に従って得られる報酬を計算し、その平均値をとる。 | 右に曲がる方策でゴールに辿り着く場合と袋小路に迷い込む場合の報酬の平均 |

| 状態価値関数の役割 | どの状態を目指すべきかを判断する材料を提供。 | 迷路でゴールへの近道を見つけるための地図 |

行動価値関数

行動価値関数は、ある状況における特定の行動の良し悪しを数値で表すものです。簡単に言うと、その状況でその行動をとった場合、将来どれだけの良い結果が期待できるかを示す指標と言えるでしょう。これは、現在の状況と行動から始まって、将来得られる報酬の期待値によって計算されます。

例えば、迷路を抜ける場面を想像してみましょう。迷路のゴールに近い場所にいる時、ゴールへ進む行動は高い行動価値を持ちます。なぜなら、ゴールに到達し、報酬を得られる可能性が高いからです。逆に、壁に向かって進む行動は低い行動価値です。壁にぶつかり、先に進めず、報酬を得られない可能性が高いからです。このように、行動価値関数は状況に応じて変化します。同じ行動でも、状況が変わればその価値も変わるのです。

行動価値関数は、私たちが何かの行動を選択する際に役立つと言えるでしょう。迷路の例で言えば、エージェント(迷路を解く人やロボット)は、それぞれの行動の価値を比較し、最も高い価値を持つ行動を選択します。つまり、行動価値関数は、より良い結果を得るための行動指針となるのです。

似た言葉に状態価値関数がありますが、両者は異なる概念です。状態価値関数は、ある状況自体がどれほど良いかを表すのに対し、行動価値関数は、ある状況で特定の行動をとることがどれほど良いかを表します。つまり、状態価値関数は状況の価値に着目し、行動価値関数は状況と行動の組み合わせの価値に着目するのです。

行動価値関数は、強化学習において重要な役割を果たすもので、様々な場面で応用されています。例えば、ロボットの制御やゲームプレイ、囲碁や将棋などの戦略設計など、様々な分野で活用され、より良い行動戦略を導き出すために利用されています。

| 項目 | 説明 | 例(迷路) |

|---|---|---|

| 行動価値関数 | ある状況における特定の行動の良し悪しを数値で表す。将来どれだけの良い結果が期待できるかを示す指標。 | ゴールに近い場所でゴールへ進む行動は高い行動価値を持つ。壁に向かって進む行動は低い行動価値を持つ。 |

| 計算方法 | 現在の状況と行動から始まって、将来得られる報酬の期待値によって計算される。 | ゴールに到達すると報酬が得られると仮定した場合、ゴールに近い場所でのゴールに向かう行動は高い期待値を持つ。 |

| 状況依存性 | 状況に応じて変化する。同じ行動でも、状況が変わればその価値も変わる。 | ゴールから遠い場所では、ゴールへ進む行動は必ずしも高い行動価値を持つとは限らない。 |

| 行動選択への応用 | それぞれの行動の価値を比較し、最も高い価値を持つ行動を選択する際の指針となる。 | エージェントは、各地点で可能な行動の行動価値を比較し、最も高い行動価値を持つ行動を選択する。 |

| 状態価値関数との違い | 状態価値関数は状況自体がどれほど良いかを表すのに対し、行動価値関数は状況と行動の組み合わせがどれほど良いかを表す。 | 状態価値関数は、迷路のある地点にいること自体の価値を表す。 |

| 応用分野 | 強化学習において重要な役割を果たし、ロボットの制御、ゲームプレイ、戦略設計など様々な分野で活用される。 | 迷路を解くAI、ロボットの行動制御、ゲームAIなど。 |

価値関数の学習

強化学習とは、試行錯誤を通じて行動の良し悪しを学び、より良い結果を得るための行動戦略を身につける学習方法です。この学習の中核を担うのが「価値関数」です。価値関数は、ある状態に置かれた時、あるいはある行動を取った時に、将来どれだけの報酬を得られるかを予測する関数です。言い換えれば、それぞれの状態や行動の価値を数値化したものと言えるでしょう。

強化学習の最終目標は、この価値関数を「最適な状態」にすることです。最適な価値関数は、それぞれの状態や行動に対して、実際に得られる最大の期待報酬を示します。例えば、迷路を解く場面を想像してみてください。最適な価値関数は、迷路の各地点からゴールへ到達するまでに得られる報酬を正しく予測します。ゴールに近い地点ほど価値が高く、袋小路のような地点は価値が低くなるでしょう。

では、どのように最適な価値関数を学習するのでしょうか?エージェント(学習を行う主体)は、環境(迷路)の中で様々な行動(移動)を試します。そして、その結果として得られた報酬(ゴール到達)や罰(袋小路に迷い込む)を経験として蓄積します。この経験を基に、価値関数を少しずつ修正していくのです。価値関数の更新には、時間差分学習やモンテカルロ法といった手法が用いられます。時間差分学習は、直前の行動で得られた報酬をもとに、価値関数を段階的に更新していく方法です。一方、モンテカルロ法は、一連の行動を終えた後に得られた最終的な報酬を用いて、価値関数をまとめて更新します。

このように、エージェントは試行錯誤を繰り返しながら価値関数を真の価値に近づけていきます。学習が進むにつれて、エージェントの行動はより洗練され、最終的には最適な行動戦略を習得するのです。

価値関数の応用

価値関数は、様々な分野で活用され、未来への展望を切り開く重要な技術です。

遊戯の分野では、例えば、将棋や囲碁のような盤上遊戯において、価値関数は効果を発揮します。熟練した人のように、盤面の状態から勝利に繋がる手を見出すために、価値関数は盤面の良し悪しを評価する役割を担います。駒の配置や戦況に応じて、どの手が有利かを判断し、勝利への道筋を照らし出します。

機械の制御においても、価値関数は重要な役割を担います。複雑な動作を必要とする機械、例えば、工場で働く多関節ロボットや、災害現場で活躍する探査ロボットなどにおいて、価値関数は最適な動作の順序を学習するために用いられます。周囲の状況や自身の状態を把握し、目的を達成するための効率的な一連の動作を導き出します。これにより、機械は複雑な作業を正確かつスムーズに行うことが可能になります。

資源の管理においても、価値関数の応用は期待されています。限られた資源を最大限に活用するためには、状況に応じた最適な配分戦略が不可欠です。価値関数は、現在の資源の状態や将来の需要予測などを考慮し、資源を効率的に配分するための指針となります。例えば、エネルギー資源の管理や水の配分など、様々な場面で価値関数は資源の有効活用に貢献します。

このように、価値関数は様々な分野で応用され、複雑な問題を解決するための強力な道具となります。今後、価値関数の研究がさらに進展することで、より高度な人工知能の実現や、様々な社会問題の解決に繋がるものと期待されています。人工知能がより賢く、より人間に寄り添う存在となるために、価値関数の更なる発展は不可欠と言えるでしょう。

| 分野 | 活用例 | 価値関数の役割 |

|---|---|---|

| 遊戯 | 将棋、囲碁 | 盤面の良し悪しを評価し、有利な手を選択 |

| 機械制御 | 多関節ロボット、探査ロボット | 最適な動作の順序を学習 |

| 資源管理 | エネルギー資源、水 | 資源の効率的な配分 |

価値関数の将来

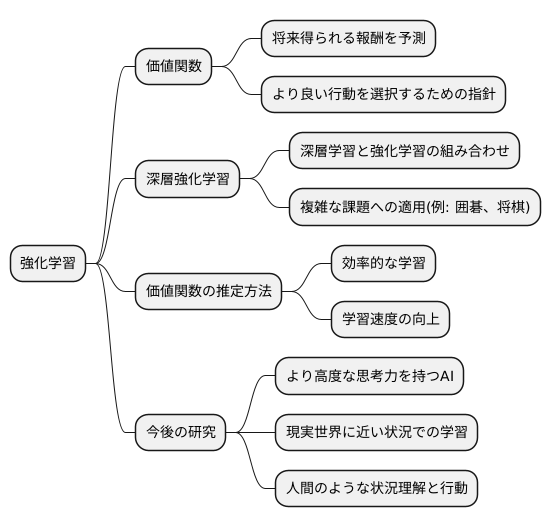

強化学習という分野は、まるで生き物が経験から学ぶように、機械に学習させる方法です。この学習の中心となるのが価値関数で、将来得られるであろう報酬を予測する役割を担っています。価値関数は、まるで道案内のように、機械がより良い行動を選択するための指針となるのです。

近年、この強化学習の分野は目覚ましい発展を遂げており、価値関数も進化し続けています。特に、人間の脳の仕組みを模倣した深層学習と組み合わせることで、深層強化学習と呼ばれる新しい分野が生まれました。これにより、従来の方法では難しかった複雑な課題にも取り組めるようになりました。例えば、囲碁や将棋といった複雑なゲームで人間を上回る強さを示す人工知能も、深層強化学習と価値関数の進化によって実現したのです。

価値関数の推定方法もまた、日夜改良が重ねられています。より効率的に学習を進めるための、様々な工夫が凝らされた計算手順が開発されているのです。これにより、限られた時間の中でより多くのことを学べるようになり、人工知能の学習速度は飛躍的に向上しました。

今後の研究では、より高度な思考力を持つ人工知能を作ることや、現実世界に近い状況で学習させることが重要になります。まるで人間のように、様々な状況を理解し、適切な行動をとれる人工知能の実現が期待されています。価値関数は強化学習の根幹をなす重要な概念であり、その更なる発展は人工知能の進化に大きく貢献するでしょう。より高度な価値関数の開発によって、複雑な課題を解決できる人工知能が実現し、私たちの生活はより豊かで便利なものになると期待されます。