AIの予期せぬ挙動と対応

AIを知りたい

先生、「予期しない振る舞いへの対処」って、結局何をすればいいんですか?アマゾンの例だと、差別するつもりはなかったのに、AIが勝手に差別しちゃったんですよね?

AIエンジニア

そうだね。アマゾンの例では、学習データに男性が多かったことで、AIが「男性が良い」と学習してしまったんだ。開発者は意図していなかったけれど、予期しない振る舞いをしてしまった。だから、まず予期しない振る舞いを防ぐ対策が必要になるね。

AIを知りたい

対策ですか?具体的にはどんなことをするんですか?

AIエンジニア

学習データの偏りを減らすことが大切だね。色んな人のデータを入れることで、偏りをなくせる。そして、AIの動きをしっかり確認することも重要だ。問題があればすぐに修正できるようにね。それでも予期しない振る舞いが起きた時は、アマゾンのように謝罪と修正を速やかに行うことが大切だよ。

予期しない振る舞いへの対処とは。

人工知能に関する言葉で「思いもよらない行動への対応」というものがあります。人工知能が学習する際に、学習データの偏りによって、人工知能が予想外の行動をとってしまうことがあります。この学習データの偏りを「アルゴリズムの偏り」といいます。偏った学習データを使うと、偏った人工知能ができてしまいます。

過去にアマゾン社で、男性の履歴書がほとんどを占める学習データを使って採用のための人工知能を学習させたところ、女性であるというだけで評価を下げてしまうことがありました。アマゾン社の開発チームには「男性を女性よりも優先して採用しよう」という考えは全くありませんでしたが、結果として差別的な採用人工知能ができてしまいました。その後、アマゾン社は謝罪し、すぐにこの採用人工知能の使用をやめました。

このような問題が起きてしまった場合は、意図しない動作であったことを利用者に伝え、誠実に謝罪することが大切です。

思いがけない動作の要因

近年の技術革新により、人工知能は目覚ましい発展を遂げ、私たちの生活に深く浸透しつつあります。膨大な量の情報を学習し、そこから規則性を見出すことで、複雑な作業もこなせるようになりました。しかし、この学習という過程には落とし穴が潜んでいます。人工知能の学習に用いる情報に偏りがある場合、私たちが望まない、予期しない行動を示すことがあるのです。これは、計算手順の偏りと呼ばれ、人工知能開発における重要な課題の一つとなっています。

例えば、過去の採用活動の記録に男性が多く含まれているとします。このデータを基に学習した人工知能は、男性を採用する傾向を強める可能性があります。これは、人工知能が過去のデータの偏りをそのまま反映した結果です。開発者が意図的に男性を優遇するよう指示したわけではないにも関わらず、このような事態が発生することがあります。人工知能は、与えられた情報を統計的に処理し、最も確率の高い結果を導き出そうとするため、学習データに偏りがあれば、その偏りを反映した結果を出力してしまうのです。

このような計算手順の偏りは、人工知能による判断を歪め、公平性や倫理的な問題を引き起こす可能性があります。例えば、採用活動において、女性や少数派の人々が不当に不利な扱いを受けるといった事態が生じる恐れがあります。また、犯罪予測システムにおいて、特定の地域や人種に対する偏見が反映され、不当な捜査や逮捕につながる可能性も懸念されています。

人工知能の活用が拡大するにつれて、この計算手順の偏りの問題はますます重要性を増しています。偏りのない、公平な人工知能を実現するためには、学習データの偏りを認識し、適切な対策を講じる必要があります。多様なデータを用いて学習を行う、偏りを修正する技術を開発するなど、様々な取り組みが求められています。人工知能が真に社会に貢献するためには、技術的な側面だけでなく、倫理的な側面にも配慮した開発が不可欠です。

| 問題点 | 原因 | 具体例 | 影響 | 対策 |

|---|---|---|---|---|

| AIの計算手順の偏り | 学習データに偏りがある | 過去の採用データに男性が多く含まれる場合、AIが男性を採用する傾向を強める | 公平性・倫理的な問題(例:採用における差別、犯罪予測の偏見) | 多様なデータを用いた学習、偏りを修正する技術の開発 |

過去の事例と教訓

技術の進歩によって、人の知恵を模倣した人工知能が様々な場面で使われるようになってきました。しかし、その活用には注意が必要であり、過去に起きた出来事から学ぶべき点が多くあります。有名な例として、大きな通販事業を展開するアマゾン社が採用活動に人工知能を導入しようとした時のことを挙げることができます。

アマゾン社は、より効率的な採用活動を行うため、応募者の履歴書を人工知能で評価する仕組みを作りました。この人工知能は、過去の採用データを使って学習し、優秀な人材の特徴を把握するように設計されていました。ところが、過去の採用データには男性の履歴書が非常に多く含まれていたため、人工知能は男性を優遇する傾向を持つようになってしまいました。その結果、女性からの応募は能力とは関係なく、低い評価を受けてしまうという問題が発生しました。

アマゾン社に女性を差別する意図はありませんでしたが、学習に使ったデータに偏りがあったことで、人工知能が予期せぬ動作をするようになってしまったのです。この出来事は、人工知能の開発において、学習データの偏りをなくすことがどれほど重要かを示す重要な教訓となりました。偏りのあるデータで学習させた人工知能は、現実世界で公平な判断ができず、差別や不平等を生み出す可能性があることを改めて認識させられました。

また、この事例は人工知能の判断が常に正しいとは限らないという事実を浮き彫りにしました。どんなに高度な人工知能でも、その判断は学習データに大きく左右されます。そのため、人工知能を導入する際には、常にその働きを監視し、評価することが不可欠です。人工知能が出した結果を鵜呑みにするのではなく、人の目で確認し、必要に応じて修正を加える体制を整えることが重要です。そうすることで、人工知能をより安全かつ効果的に活用できるようになるでしょう。

| 企業 | 目的 | 方法 | 問題点 | 教訓 |

|---|---|---|---|---|

| アマゾン | 効率的な採用活動 | 履歴書をAIで評価 | 過去のデータの偏りにより、AIが男性を優遇 | 学習データの偏りをなくすことが重要。AIの判断は常に正しいとは限らない。AIの働きを監視・評価し、人の目で確認する必要がある。 |

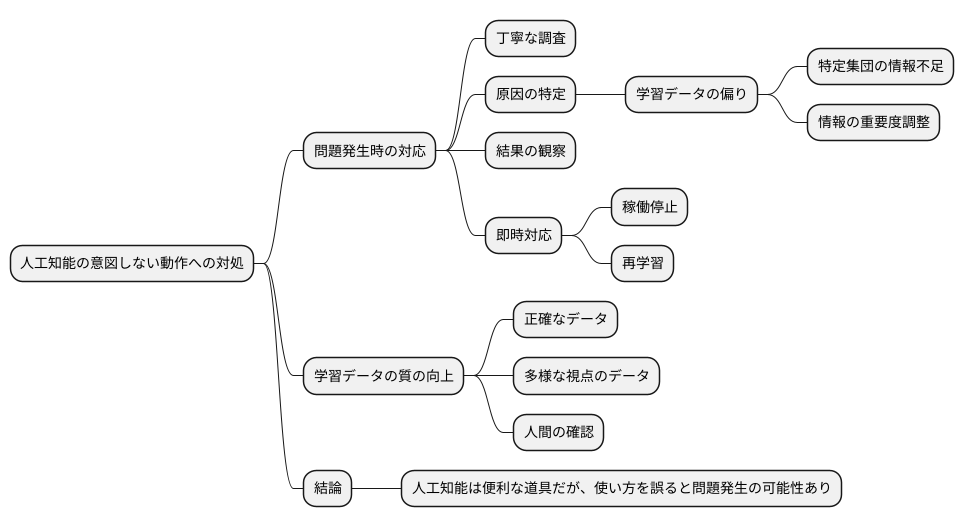

問題への対処法

人工知能が人間の意図しない動作をした場合、まずは何が起きているのかを丁寧に調べる必要があります。その原因は様々ですが、学習に使われた情報の偏りが原因であることが少なくありません。偏りのある情報で学習すると、人工知能も偏った考え方をするようになってしまいます。

例えば、ある特定の集団に関する情報が少ない状態で人工知能を学習させると、その集団を正しく評価できない可能性があります。このような場合、情報が不足している集団の情報を追加で集め、学習データに加えることで、偏りを少なくすることができます。また、それぞれの情報の重要度を調整することで、偏りの影響を抑えることも可能です。

人工知能が正しく動作しているかを確認するために、人工知能が出した結果を常に注意深く観察することも大切です。もし問題が発生した場合には、すぐに対応しなければなりません。問題の内容によっては、一時的に人工知能の稼働を停止し、改めて学習をやり直す必要があるかもしれません。

人工知能の学習には、質の高いデータが不可欠です。データの質を高めるためには、データの正確さを確認するだけでなく、多様な視点を取り入れることも重要になります。多様なデータを使って学習することで、人工知能はより公平で正確な判断ができるようになります。また、人工知能が出した結果が本当に正しいのか、常に人間が注意深く確認し続けることが重要です。人工知能は便利な道具ですが、使い方を誤ると予期せぬ問題を引き起こす可能性があることを忘れてはいけません。

利用者への説明

人工知能が時折、想定外の動きを見せることがあります。このような事態が発生した場合、利用者の皆様に分かりやすくご説明することが私たちの責務だと考えています。まず、問題が起きたことを認め、何が原因でそのような動きになったのかを丁寧に説明いたします。そして、その問題にどう対応していくのか、具体策を明確にお伝えします。このような予期せぬ動きは、決して意図的なものではなく、私たちも驚いていることをご理解いただきたいと考えています。このような事態を二度と起こさないために、再発防止策を徹底してまいります。具体的には、プログラムの修正や新たな確認作業の導入などを検討し、より安全な人工知能の開発に努めてまいります。

問題を隠したり、責任逃れをするようなことは決していたしません。そのような態度は、より多くの批判を招き、私たちの信頼を失墜させることにつながると考えています。誠実を旨として対応することで、失われた信頼を取り戻せるよう真摯に取り組んでまいります。人工知能はまだ発展途上の技術であり、予期せぬ問題が発生する可能性があることをご理解いただきたく存じます。私たちは常に改善を続け、より安全で信頼できる人工知能を提供できるよう尽力してまいりますので、今後とも変わらぬご支援を賜りますようお願い申し上げます。皆様からのご意見やご指摘は、私たちにとって大変貴重なものです。ご不明な点やご心配なことがございましたら、ご遠慮なくお問い合わせください。私たちは常に皆様の声に耳を傾け、より良いサービスを提供できるよう努めてまいります。

| 発生事象 | 人工知能が想定外の動きを見せる |

|---|---|

| 対応方針 |

|

| 姿勢 |

|

今後の開発に向けて

人工知能技術は日進月歩で進化を続けており、その発展は私たちの生活に大きな変化をもたらしています。それと同時に、人工知能が予期しない動作をする可能性を完全に排除することは、現状では難しいと言わざるを得ません。しかし、過去の失敗や成功事例を深く分析し、そこから得られた知見を活かして適切な対策を施すことで、リスクを最小限に抑え、安全性を高めることは可能です。

人工知能開発においては、多様な背景を持つ技術者、倫理学者、社会学者など、様々な分野の専門家が集まり、それぞれの視点を持ち寄り議論を深めることが重要です。このような多角的な視点を取り入れた開発体制を構築することで、偏りのない、よりバランスの取れた人工知能を開発することができます。同時に、倫理的な指針を遵守し、社会規範に適合した人工知能の開発を心がける必要があります。倫理的な側面を軽視すると、思わぬ問題を引き起こす可能性があるため、開発の初期段階から倫理的な配慮を怠らないことが大切です。

人工知能がどのように判断を下しているのか、その過程を分かりやすく示すことも重要です。利用者が人工知能の思考プロセスを理解することで、人工知能に対する信頼感が高まり、安心して利用できるようになります。人工知能の判断過程を透明化することで、問題が発生した場合にも原因究明が容易になり、迅速な対応が可能となります。

人工知能技術は発展途上にあり、今後も継続的な研究開発が必要です。同時に、人工知能技術と社会との関わりについて、広く議論を深め、社会全体の理解と合意形成を図っていくことが不可欠です。技術者だけでなく、一般の人々も巻き込んだ対話を重ねることで、人工知能技術をより良い方向へ導き、より良い未来を築いていくことができると信じています。

| 項目 | 内容 |

|---|---|

| 人工知能の発展 | 日進月歩で進化し、生活に大きな変化をもたらす一方、予期しない動作の可能性も存在する。 |

| 安全性の確保 | 過去の事例分析と適切な対策により、リスク最小化と安全性の向上を図る。 |

| 開発体制 | 多様な専門家(技術者、倫理学者、社会学者など)による多角的な視点を取り入れ、偏りのないバランスの取れた開発を目指す。 |

| 倫理的配慮 | 倫理的な指針遵守、社会規範への適合。初期段階からの倫理的配慮は不可欠。 |

| 透明性の確保 | 人工知能の判断過程を分かりやすく示すことで、利用者の信頼感向上、問題発生時の原因究明を容易にする。 |

| 今後の展望 | 継続的な研究開発、社会全体の理解と合意形成。多様な立場の人々との対話でより良い未来を目指す。 |

信頼の構築

人と人との間柄と同じように、人工知能との間にも信頼関係を築くことが大切です。信頼は一方的なものではなく、双方向のやり取りから生まれます。人工知能が私たちの生活に溶け込み、様々な場面で活躍するためには、人工知能への信頼が不可欠です。

人工知能の信頼性を高めるためには、まず、その仕組みを分かりやすく示すことが重要です。複雑な計算式や難解な専門用語ではなく、誰もが理解できる言葉で、人工知能がどのような仕組みで動いているのか、どのような判断基準で結果を出しているのかを説明する必要があります。さらに、人工知能が持つ可能性と限界、そして潜在的な危険性についても包み隠さず伝えるべきです。

公平性も信頼構築には欠かせません。人工知能は、特定の人々を優遇したり、差別したりするようなことがあってはなりません。あらゆる人々にとって公平で、偏りのない結果を出せるように、開発段階から注意深く設計する必要があります。そのためには、様々な背景を持つ人々が開発に携わり、多角的な視点を取り入れることが重要です。

人工知能が誤った判断をした場合、誰に責任があるのかを明確にすることも大切です。問題が起きた際に責任の所在があいまいだと、人工知能への不信感が高まり、社会への導入が難しくなります。開発者、運用者、利用者、それぞれの責任範囲を明確にすることで、問題発生時の迅速な対応が可能となり、信頼関係を維持することができます。

人工知能は、私たち人間が作り出した道具です。道具は使い方次第で、社会に大きな利益をもたらすこともあれば、大きな害悪をもたらすこともあります。人工知能を正しく使い、その恩恵を最大限に受けるためには、私たち一人一人 が人工知能との信頼関係を築き、責任ある利用を心がける必要があるでしょう。

| 要素 | 説明 |

|---|---|

| 双方向性 | 信頼は一方的なものではなく、人とAIの双方向のやり取りから生まれる。 |

| 分かりやすさ | AIの仕組みを分かりやすく示し、判断基準を誰もが理解できる言葉で説明する必要がある。 |

| 透明性 | AIの可能性、限界、潜在的な危険性について包み隠さず伝える。 |

| 公平性 | 特定の人々を優遇・差別しない、公平で偏りのない結果を出せるように設計する。多様な人々が開発に携わり、多角的な視点を取り入れる。 |

| 責任の明確化 | AIが誤った判断をした場合の責任の所在を明確にする(開発者、運用者、利用者)。 |

| 責任ある利用 | AIは道具であり、使い方次第で利益にも害悪にもなる。一人一人がAIとの信頼関係を築き、責任ある利用を心がける。 |