AIを狙う見えない脅威:敵対的攻撃

AIを知りたい

先生、「敵対的な攻撃」ってどういうことですか?よくわからないです。

AIエンジニア

そうだね、少し難しい言葉だね。「敵対的な攻撃」とは、人工知能をだまして、間違った判断をさせるような悪意のある行為のことだよ。例えば、画像認識の人工知能に、少しだけ手を加えたパンダの画像を見せると、人工知能はそれを猿だと誤認識してしまう、といった具合だね。

AIを知りたい

なるほど。でも、少し手を加えるだけで、どうしてそんなことが起こるんですか?

AIエンジニア

人間には気づかないような、とても小さな変化を画像に加えることで、人工知能の判断を狂わせてしまうんだ。これは、人工知能がどのように物事を判断しているのか、その仕組みを悪用したものと言えるね。例えば、自動運転の車に、標識を誤認識させて事故を起こさせようとすることも、敵対的な攻撃の一つだよ。

敵対的な攻撃とは。

人工知能にまつわる言葉である「わざと邪魔する攻撃」について説明します。この攻撃は、人工知能の仕組みをうまく使えなくするために、わざと間違った認識をさせるように仕向けられます。たとえば、人に似せた偽物を作ったり、システムの弱いところをついて不正に侵入したりすることで、人工知能の働きを邪魔するのです。

人工知能への新たな攻撃手法

近ごろ、機械による知恵、いわゆる人工知能の技術がめざましく進み、私たちの暮らしは便利で豊かなものへと変わってきています。自動で動く車や病気の診断、人の顔を識別する技術など、様々な場面で人工知能が活躍しています。しかし、それと同時に、新たな危険も姿を現し始めています。それが「敵対的な攻撃」と呼ばれるものです。

この敵対的な攻撃とは、人工知能が持つ、ものごとを見分ける力をわざと混乱させることで、間違った動きをさせる悪意のある攻撃方法です。まるで人が目の錯覚を起こすように、人工知能は巧妙に作られた罠にはまり、本来とは違う判断をしてしまうのです。例えば、自動運転車の場合を考えてみましょう。道路標識に特殊なシールを貼ることで、人工知能が標識を誤認識し、制限速度を無視したり、停止すべき場所で止まらなかったりする危険性があります。また、人の顔を識別するシステムに敵対的な攻撃を加えると、別人を本人として認識させたり、逆に本人を認識できないようにしたりすることも可能です。

この攻撃は、人工知能を使った仕組の信頼性と安全性を脅かす重大な問題として、広く認識されています。もし自動運転車が誤作動を起こせば、大きな事故につながる可能性がありますし、セキュリティーシステムが突破されれば、個人情報が盗まれる危険性も出てきます。そのため、敵対的な攻撃への対策は急務となっています。人工知能を開発する技術者たちは、様々な方法でこの問題に取り組んでおり、より安全で信頼性の高い人工知能の実現を目指して研究を進めています。例えば、人工知能に多くの種類の攻撃パターンを学習させることで、攻撃への耐性を高める方法や、人工知能の判断根拠を明確化することで、誤作動の原因を特定しやすくする方法などが研究されています。人工知能の技術は日々進化していますが、安全性を確保するための努力もまた、同時に続けなければならないのです。

| 項目 | 説明 | 例 |

|---|---|---|

| 人工知能の進歩 | 私たちの生活は便利で豊かになってきている。自動運転、病気の診断、顔認識など様々な場面でAIが活躍。 | |

| 敵対的な攻撃 | AIの認識能力を混乱させ、間違った動作をさせる悪意のある攻撃。 | |

| 攻撃の仕組み | 人の目の錯覚のように、巧妙に作られた罠でAIを誤認識させる。 | 道路標識に特殊なシールを貼ることで、自動運転車が標識を誤認識する。 |

| 攻撃の例(自動運転車) | 制限速度の無視、停止すべき場所で止まらないなど。 | |

| 攻撃の例(顔認識システム) | 別人を本人として認識、または本人を認識できない。 | |

| 攻撃の影響 | AIを使ったシステムの信頼性と安全性を脅かす。事故や個人情報漏洩の危険性。 | |

| 対策 | AIに多くの攻撃パターンを学習させ耐性を高める、AIの判断根拠を明確化し誤作動の原因を特定しやすくする。 |

見えないノイズでAIを欺く

人工知能は、私たちの暮らしを便利にする様々な技術に利用されています。しかし、その能力の裏には、驚くべき弱点も潜んでいます。人工知能を欺く「敵対的攻撃」という手法をご存じでしょうか。まるで魔法のようなこの攻撃は、私たち人間には全く気が付かない程度の、ごくわずかな変更を加えるだけで、人工知能の判断を狂わせてしまうのです。

例えば、画像認識の人工知能を考えてみましょう。美味しそうな菓子パンの写真を認識させているとします。この写真に、特殊なノイズをほんの少しだけ加えます。人間が見ても、写真の変化には全く気が付きません。しかし、このわずかなノイズによって、人工知能は菓子パンを猿の一種だと誤認識してしまうかもしれません。まるで、人工知能の目にだけ見える、見えない仕掛けがあるかのようです。

この「敵対的攻撃」は、画像認識だけでなく、様々な人工知能技術に影響を及ぼす可能性があります。自動運転技術を例に考えてみましょう。自動運転車は、カメラで周囲の状況を認識し、道路標識に従って安全に走行します。もし、道路標識に特殊なシールが貼られていたとしたらどうでしょうか。人間にはただの汚れに見えるシールでも、自動運転車にとっては大きな落とし穴となるかもしれません。標識の意味を誤認識し、思わぬ事故につながる恐れもあるのです。

このように、敵対的攻撃は、人工知能の安全性を脅かす深刻な問題です。人工知能技術の発展に伴い、この攻撃への対策も急務となっています。まるでいたずら好きの魔法使いの悪戯のように、私たちの目には見えないノイズが、人工知能の未来に影を落としているのです。

| 対象 | 攻撃手法 | 結果 |

|---|---|---|

| 画像認識AI | 菓子パンの画像に特殊なノイズを追加 | 菓子パンを猿と誤認識 |

| 自動運転AI | 道路標識に特殊なシールを貼る | 標識を誤認識し、事故の可能性 |

様々な攻撃手法とその脅威

人工知能を狙った攻撃は、多種多様であり、それぞれの手法で人工知能の弱点を探り当てて攻撃します。代表的な攻撃として「回避型攻撃」と「毒性型攻撃」が挙げられます。

「回避型攻撃」は、人工知能の監視システムをくぐり抜けることを目的とした攻撃です。この攻撃では、データに微かなノイズを加えることで、人工知能の判断を狂わせます。具体例として、迷惑メールの選別システムをすり抜ける、あるいは不正な活動を隠蔽するために使われます。まるで忍者が敵に見つからないように姿を隠すかのように、人工知能の目を欺く巧妙な手法と言えるでしょう。

一方、「毒性型攻撃」は、人工知能が学習するデータそのろに不正なデータを入力する攻撃です。この攻撃は、人工知能の学習過程を妨害し、学習の精度を低下させることを狙います。不正なデータが混入した状態で学習を進めた人工知能は、本来とは異なる判断基準を学習してしまい、誤った判断をする可能性が高まります。まるで健康な体に毒物を少しずつ与え、徐々に体を蝕んでいくような攻撃と言えるでしょう。

これらの攻撃手法は日々高度化しており、人工知能を利用したシステムの安全性は常に脅かされています。そのため、セキュリティ対策も常に最新の状態に保つ必要があります。人工知能の進化と共に、攻撃手法も進化していくため、絶え間ない努力と工夫が求められます。まるでいたちごっこですが、安全性を確保するためには、常に警戒を怠らず、最新の防御策を講じ続けることが不可欠です。

| 攻撃の種類 | 目的 | 手法 | 具体例 |

|---|---|---|---|

| 回避型攻撃 | 人工知能の監視システムをくぐり抜ける | データに微かなノイズを加えることで、人工知能の判断を狂わせる | 迷惑メールの選別システムをすり抜ける、不正な活動を隠蔽する |

| 毒性型攻撃 | 人工知能の学習過程を妨害し、学習の精度を低下させる | 人工知能が学習するデータそのものに不正なデータを入力する | 本来とは異なる判断基準を学習し、誤った判断をする |

攻撃の目的と影響範囲

人工知能を狙った攻撃、いわゆる敵対的攻撃は、様々な目的で行われます。攻撃者の狙いは実に多岐に渡り、システムの機能を停止させることや、秘密情報の不正取得、さらにはシステムそのものの制御を奪取することなどが挙げられます。これらの攻撃は、私達の生活に様々な形で影響を及ぼす可能性を秘めています。

攻撃の影響範囲は、攻撃対象となる人工知能システムの種類や規模によって大きく異なります。例えば、顔認証システムが攻撃対象となった場合を考えてみましょう。この場合、個人の大切な情報が漏洩する危険性や、他人のふりをして不正にシステムに侵入される可能性があります。また、自動運転システムが攻撃された場合はどうでしょうか。システムの誤作動により交通事故が発生したり、道路が混雑し渋滞を引き起こすといった事態も想定されます。

さらに、医療診断支援システムへの攻撃は、誤診につながり人命に関わる重大な結果を招く恐れがあります。金融取引システムへの攻撃は、経済的な損失を生み出すだけでなく、社会全体に混乱を招く可能性も否定できません。

このように敵対的攻撃は、標的となるシステムによって様々な影響を及ぼし、私たちの生活に深刻な被害をもたらす可能性があります。そのため、人工知能システムの安全性を確保するための対策が急務となっています。システムの開発段階からセキュリティ対策を組み込むことはもちろん、常に最新の攻撃手法に対応できるようシステムを更新していく必要があります。また、利用者一人ひとりがセキュリティ意識を高め、不審な点に気付いたらすぐに報告するといった協力体制も重要です。

| 攻撃対象 | 影響 |

|---|---|

| 顔認証システム | 個人情報漏洩、不正侵入 |

| 自動運転システム | 交通事故、道路混雑・渋滞 |

| 医療診断支援システム | 誤診、人命に関わる重大な結果 |

| 金融取引システム | 経済的損失、社会全体の混乱 |

防御策の模索と今後の展望

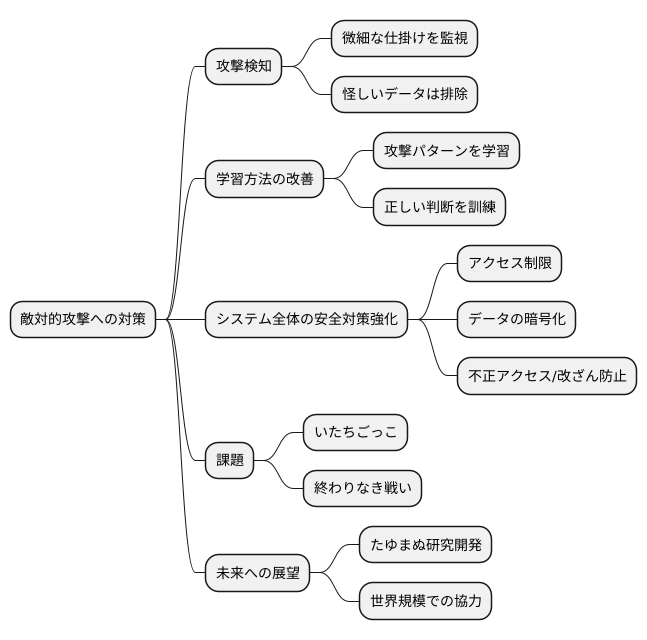

近頃話題となっている人工知能を狙った攻撃、いわゆる敵対的な攻撃への対策について、様々な角度からの取り組みが盛んに行われています。この敵対的な攻撃とは、人工知能の学習過程に、人間には認識できないような、ごく僅かな変更を加えたデータを入力することで、人工知能の判断を誤らせる攻撃です。まるで、人間の目には見えないほどの小さな仕掛けによって、人工知能の思考を混乱させるようなものです。こうした攻撃から人工知能を守るため、様々な防御策の研究が進められています。

まず、敵対的な攻撃を検知する仕組みの開発が挙げられます。これは、人工知能に入力されるデータに、そのような微細な仕掛けが施されていないか、常に監視するようなものです。まるで、人工知能の門番のように、怪しいデータは排除することで、攻撃を防ぎます。

次に、人工知能そのものの学習方法を改善することで、これらの攻撃に対して頑丈にする試みも進んでいます。これは、様々な攻撃パターンをあらかじめ学習させることで、多少の仕掛けがあっても正しい判断ができるように訓練するようなものです。まるで、様々な攻撃を経験した熟練者のように、人工知能を育てていくのです。

さらに、人工知能システム全体の安全対策を強化することも重要です。これは、人工知能そのものだけでなく、それを取り巻くシステム全体のセキュリティを高めることで、攻撃のリスクを減らす試みです。具体的には、アクセスを制限したり、データを暗号化したりすることで、不正なアクセスやデータの改ざんを防ぎます。まるで、人工知能を守る城を築き、堅牢な防御体制を構築するようなものです。

しかし、敵対的な攻撃と防御策の開発競争は、まるでいたちごっこのようです。攻撃側は常に新しい攻撃手法を開発し、防御側はそれに対応する新たな防御策を考え出す必要があります。この終わりなき戦いは、人工知能技術の発展と安全性を確保していく上で、避けては通れない道です。

人工知能技術を安全に、そして安心して利用できる未来を実現するためには、たゆまぬ研究開発と、世界規模での協力が欠かせません。様々な分野の専門家や研究機関が連携し、知恵を出し合うことで、より強固な防御システムを構築していく必要があるでしょう。

より安全なAI社会の実現に向けて

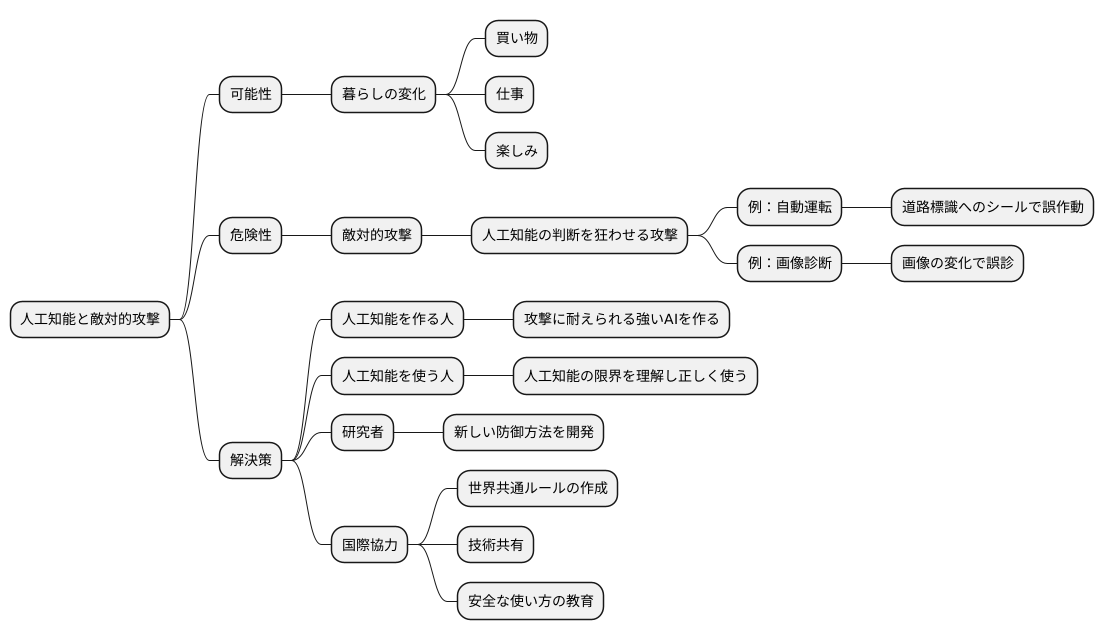

人工知能は、私たちの暮らしを大きく変える力を持っています。買い物や仕事の仕方、楽しみ方など、様々な変化がすでに起こり始めています。しかし、その素晴らしい可能性と同時に、新たな危険も生まれています。まるで魔法の呪文のように、人工知能の判断を狂わせる攻撃のことです。これは「敵対的攻撃」と呼ばれ、人工知能の安全性を脅かす大きな問題となっています。

例えば、自動運転の車を考えてみましょう。道路標識にシールを貼るだけで、人工知能が標識を読み間違え、事故につながる危険性があります。また、病院で使われる画像診断の人工知能も、わずかな画像の変化で誤診する可能性があります。このように、敵対的攻撃は私たちの安全を直接脅かす可能性があるのです。

この問題を解決するためには、人工知能を作る人、使う人、そして研究する人、皆で協力して対策を考えなければなりません。人工知能を作る人は、攻撃に耐えられる強い人工知能を作る必要があります。使う人は、人工知能の限界を理解し、正しく使うことが大切です。そして、研究者は新しい防御方法を開発し続けなければなりません。

さらに、国と国が協力してルールを作ることも重要です。人工知能は世界中で使われているため、世界共通のルールが必要です。敵対的攻撃から身を守るための技術を共有したり、安全な人工知能の使い方を教え合うことで、より安全な社会を作ることができます。人工知能は、正しく使えば私たちの未来を明るくする力を持っています。皆で協力して、安全で信頼できる人工知能社会を実現しましょう。