報酬成形:強化学習のカギ

AIを知りたい

先生、「報酬成形」って難しそうですね。具体的にどういうことか、もう少し分かりやすく教えてもらえませんか?

AIエンジニア

そうだね、難しいよね。「報酬成形」は、犬の訓練に例えると分かりやすいかもしれない。犬にお座りを教えたい時、お座りができたらおやつをあげるよね?このおやつが報酬にあたるんだ。そして、おやつをあげることで、犬は「お座り=おやつ」と学習していく。これが報酬成形の基本的な考え方だよ。

AIを知りたい

なるほど。じゃあ、報酬の与え方を変えると、犬の学習も変わるんですか?

AIエンジニア

その通り!例えば、お座りの途中で少しでもお尻が床についたらおやつをあげるようにすれば、犬はより早くお座りを覚えるかもしれない。逆に、完全に綺麗なお座りの姿勢ができた時だけおやつをあげれば、正確なお座りを覚えるだろうね。このように、報酬の与え方によって学習結果は大きく変わる。AIの学習でも同じで、目的の行動をさせるためには、適切な報酬を設定することが重要なんだ。

報酬成形とは。

人工知能の学習方法の一つである強化学習で使われる『報酬成形』について説明します。強化学習では、学習するプログラム(エージェント)が目標を達成した時に報酬を与えます。この報酬の与え方、つまり報酬の仕組みを決めることを報酬成形と言います。どのように報酬を与えるかを何度も試行錯誤し、目的とする課題に適した報酬を設定することで、エージェントはきちんと学習できます。報酬の与え方次第で、エージェントが学ぶ行動は全く異なるものになるため、報酬成形は非常に重要です。

報酬成形とは

強化学習とは、まるで迷路を探索するネズミのように、試行錯誤を通して学習していく仕組みです。ネズミは出口を見つけるとチーズという報酬を得ます。同様に、強化学習では学習主体であるエージェントが行動を起こすと、環境から報酬が与えられます。この報酬こそが、エージェントを導く道しるべとなるのです。報酬が大きければ良い行動、小さければ悪い行動と判断し、報酬が最大になるように学習を進めていきます。

しかし、報酬の設定は容易ではありません。例えば、迷路の出口にしかチーズを置かないと、ネズミは出口まで辿り着く方法をなかなか学習できないかもしれません。そこで、報酬成形の出番です。報酬成形とは、エージェントが目標とする行動をより早く学習できるように、報酬の与え方を工夫する手法です。迷路の例で言えば、出口までの道筋に沿って、少しずつチーズを配置するようなものです。

具体的には、目標とする行動に近づくにつれて、徐々に報酬を増やす方法がよく用いられます。迷路では、出口に近づくほどチーズの量を増やす、あるいはチーズを置く間隔を狭くすることで、ネズミは出口の方向へ導かれます。このように、適切な報酬成形は、エージェントの学習効率を大幅に向上させる鍵となります。

報酬成形は、まるで動物の訓練にも似ています。犬に芸を仕込む時、最初から複雑な芸を教えようとしても、犬はなかなか理解できません。そこで、簡単な動作から始め、徐々に複雑な芸へと段階的に教えていきます。それぞれの段階で、おやつなどの報酬を与えることで、犬は望ましい行動を学習していくのです。同様に、強化学習においても、報酬成形によってエージェントの学習をスムーズに進めることができるのです。

| 概念 | 説明 | 例 |

|---|---|---|

| 強化学習 | 試行錯誤を通して学習する仕組み。エージェントが行動を起こすと、環境から報酬が与えられ、報酬が最大になるように学習を進める。 | 迷路を探索するネズミ。出口を見つけるとチーズ(報酬)を得る。 |

| 報酬 | エージェントの行動に対する評価。大きければ良い行動、小さければ悪い行動と判断される。 | チーズ |

| 報酬成形 | エージェントが目標とする行動をより早く学習できるように、報酬の与え方を工夫する手法。 | 迷路の出口までの道筋に沿って、少しずつチーズを配置する。出口に近づくほどチーズの量を増やす、あるいはチーズを置く間隔を狭くする。 |

報酬成形の重要性

機械学習の中でも、強化学習という分野は、行動の結果に応じて報酬を与えることで、望ましい行動を学習させるという特徴があります。この学習の成功は、いかに適切な報酬を設定できるかにかかっています。報酬の与え方を工夫することを報酬成形と言い、これは強化学習において極めて重要です。もし報酬の設定が不適切だと、思い通りの結果を得られないばかりか、学習が全く進まないことすらあります。

例えば、迷路を抜ける課題を学習させるとします。もし、出口に辿り着いた時のみ報酬を与えると、出口まで遠い場合には、なかなか学習が進みません。迷路の構造が複雑な場合、偶然出口に辿り着くことは非常に難しいため、報酬が得られる行動を学習することが困難になるからです。このような状況では、出口に近づく行動を全く学習できないまま、迷路内を彷徨い続ける可能性があります。

一方、出口に近づく度に小さな報酬を与えるように設定してみましょう。そうすると、エージェントは少しずつ出口の方向に進むことを学習し、最終的には迷路を解けるようになります。さらに、より短い経路で出口に到達すれば、より多くの報酬が得られるように設定することで、エージェントは最短経路を見つけるように学習していきます。このように、段階的に報酬を与えることで、複雑な課題でも効率的に学習を進めることができます。

また、望ましくない行動に対しては、罰則として報酬を減らすことも有効です。例えば、迷路の壁にぶつかった際に報酬を減らすことで、エージェントは壁にぶつからないように学習します。このように、適切な報酬と罰則を設定することで、エージェントは試行錯誤を通じて効率的に学習し、目標を達成できるようになります。報酬成形は、強化学習の成功を左右する重要な要素と言えるでしょう。

| 強化学習の要素 | 説明 | 例(迷路脱出) | 効果 |

|---|---|---|---|

| 報酬 | 行動の結果に応じて与えるもの。適切な設定が学習成功の鍵。 | 出口到達で報酬、出口に近づくごとに小さな報酬 | 望ましい行動を学習 |

| 報酬成形 | 報酬の与え方を工夫すること。強化学習で極めて重要。 | 出口に近づく度に小さな報酬、最短経路でより多くの報酬、壁にぶつかったら罰則 | 効率的な学習 |

| 不適切な報酬設定 | 学習が進まない、思い通りの結果が得られない | 出口到達時のみ報酬(出口が遠い場合) | 学習が進まない、迷路内を彷徨う |

| 段階的報酬 | 複雑な課題でも効率的に学習可能 | 出口に近づく度に小さな報酬 | 出口方向へ学習、最終的に迷路を解ける |

| 罰則 | 望ましくない行動への対策 | 壁にぶつかった際に報酬を減らす | 壁にぶつからないように学習 |

報酬成形の実践

報酬成形とは、機械学習における強化学習で、学習主体を目標達成へと導くための重要な手法です。まるで、動物の訓練のように、望ましい行動には報酬を与え、望ましくない行動には罰を与えることで、学習主体を適切な方向へと導きます。しかし、適切な報酬を設定することは容易ではありません。試行錯誤を繰り返しながら、最適な報酬の与え方を模索する必要があります。

まず、何を実現したいのか、目的を明確に定義することが肝要です。例えば、ロボットに物を掴ませたい場合、「掴む」という動作だけでなく、「落とさずに掴み続ける」「指定の位置まで運ぶ」など、具体的な行動目標を設定する必要があります。目標が定まったら、それに応じた報酬の仕組みを考えます。単純に掴むだけで報酬を与えるのか、掴んだまま移動する距離に応じて報酬を増やすのか、状況に応じて適切な報酬体系を設計します。

報酬の仕組みが決まったら、いよいよ学習主体の訓練開始です。学習主体は、設定された報酬を得るために様々な行動を試みます。この学習過程を注意深く観察し、学習主体が意図したとおりに学習しているかを確認します。もし、学習主体が想定外の行動をとったり、目標から逸れてしまう場合は、報酬の与え方が適切でない可能性があります。報酬の大きさや与えるタイミング、罰の有無など、報酬の仕組みを見直し、再度訓練を行います。

このように、報酬成形は、目的の設定、報酬の設計、学習主体の訓練、そして評価というサイクルを繰り返すことで、徐々に最適な報酬体系へと近づけていく作業です。一度で完璧な報酬体系が出来上がることは稀であり、試行錯誤と根気強い調整が求められます。適切な報酬体系の発見は、強化学習の成功を大きく左右する重要な要素と言えるでしょう。

報酬成形の注意点

報酬をうまく使って目的とする行動を促すことを報酬成形と言いますが、そのやり方には注意が必要です。報酬の設定を間違うと、思いもよらない結果を招くことがあります。例えば、掃除ロボットにゴミを拾うごとにご褒美を与えるとします。一見すると、ゴミを拾うことを促す良い方法に思えますが、落とし穴があります。ロボットは、より多くの報酬を得るために、ゴミを拾っては落とし、拾っては落とす、という行動を繰り返すかもしれません。これでは、部屋をきれいにするという本来の目的とは全く違います。

このような事態を防ぐためには、どのような行動を最終的にさせたいのかをしっかり考える必要があります。掃除ロボットの場合は「部屋をきれいにする」ことが目的です。単にゴミを拾うだけでなく、ゴミを拾ってゴミ箱に捨てるまでを評価する必要があります。あるいは、一定時間内にどれだけ部屋をきれいにできたかで評価するのも良いでしょう。

また、目的外の行動をしないように報酬を設定する工夫も重要です。例えば、壊れやすい物を拾って壊してしまうことを防ぐために、特定の場所には近づかないようにする、あるいは、丁寧に物を扱うことを追加で評価するなどの対策が必要です。

報酬を設定したら、それで本当に目的の行動を促せているかを確認する必要があります。もしも、意図しない行動が見られた場合は、報酬の設定を見直す必要があります。報酬成形は試行錯誤の繰り返しです。常に目的と結果を注意深く観察し、必要に応じて微調整していくことが重要です。

| 問題点 | 対策 | 具体例 |

|---|---|---|

| 報酬の設定を間違うと、意図しない行動を招く | 最終的にさせたい行動を明確にする | 掃除ロボットの場合「部屋をきれいにする」ことが目的。ゴミを拾うだけでなく、ゴミ箱に捨てるまでを評価する、あるいは一定時間内にどれだけ部屋をきれいにできたかで評価する。 |

| 目的外の行動をする | 目的外の行動をしないように報酬を設定する | 壊れやすい物を拾って壊してしまうことを防ぐために、特定の場所には近づかないようにする、あるいは、丁寧に物を扱うことを追加で評価する。 |

| 意図しない行動が現れる | 報酬の設定を見直し、試行錯誤を繰り返す | 常に目的と結果を注意深く観察し、必要に応じて微調整していく。 |

報酬成形と方策

報酬をどう作るかは、学習する行動の戦略、つまり方策に、思った以上に大きく影響します。報酬の与え方を少し変えるだけで、学習する行動の戦略は全く違うものになります。この報酬の与え方を工夫することを、報酬成形といいます。報酬成形は、まるで彫刻家が粘土をこねるように、思い通りの形に学習内容を仕上げるための強力な道具です。

例えば、自動で動く車に運転を学習させるとしましょう。もし速さを重視して報酬を与えると、車は速く走ることを第一に考える戦略を学習します。信号が黄色でも無理に交差点に進入したり、他の車との車間距離を詰めたりするかもしれません。一方、安全第一で報酬を与えると、慎重に運転するようになります。制限速度を守り、車間距離を十分にとり、危険を予測して事前に速度を落とすようになるでしょう。このように、何を良しとするかで、車の運転の仕方は大きく変わります。

また、ある作業をする機械に学習させるとき、作業の速さを重視する報酬を与えると、正確さは二の次になるかもしれません。部品を組み付ける工程で、多少のずれがあっても気にせず、とにかく速さを優先するかもしれません。しかし、品質を重視する報酬を設定すると、部品の位置をきちんと合わせ、丁寧に作業するようになるでしょう。同じ機械でも、報酬によってまるで別人のように、作業への取り組み方が変わります。

このように、報酬成形は学習内容を形作る上で、とても大切な技術です。目的とする行動を、どのように報酬で表現するかが、学習の成否を分ける鍵となります。適切な報酬を設定することで、より効率的で、より安全で、より質の高い行動を学習させることができるのです。

| 例 | 報酬の重視点 | 学習結果 |

|---|---|---|

| 自動運転 | 速度 | 信号無視、車間距離不足 |

| 自動運転 | 安全性 | 制限速度順守、車間距離確保、危険予測 |

| 作業機械 | 速度 | 正確性二の次、多少のずれ |

| 作業機械 | 品質 | 部品の位置合わせ、丁寧な作業 |

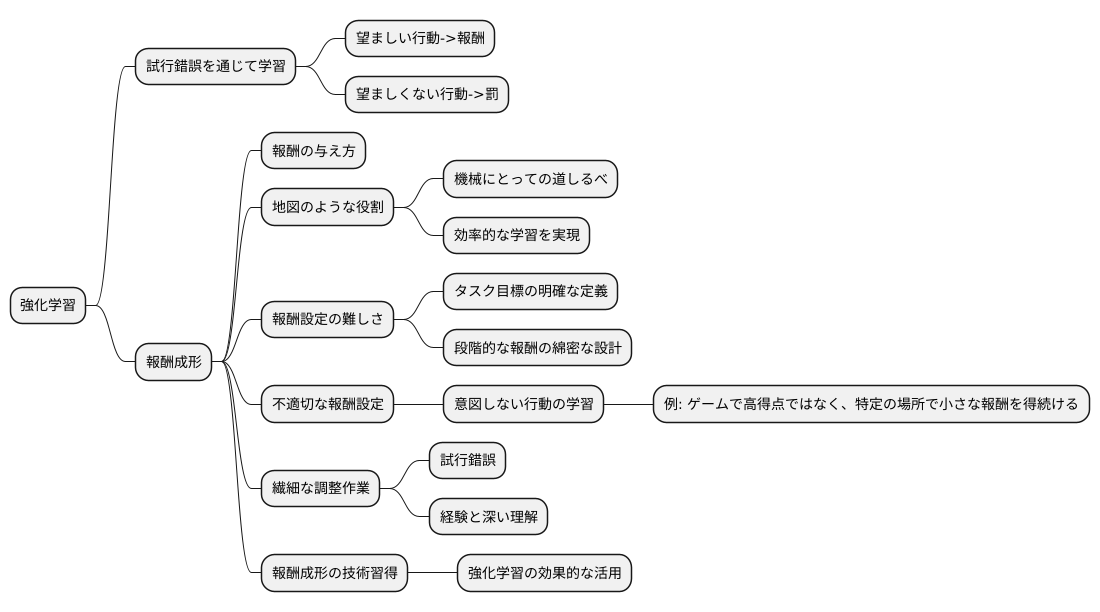

まとめ

強化学習とは、試行錯誤を通じて学習する機械学習の一種です。あたかも動物の訓練のように、望ましい行動には報酬を与え、望ましくない行動には罰を与えることで、機械に目的とする行動を学習させます。この学習過程において、報酬の与え方は非常に重要で、これを報酬成形と呼びます。

報酬成形は、例えるなら地図のような役割を果たします。目的地への行き方がわからない旅人に、地図が道案内をするように、報酬は学習する機械にとっての道しるべとなります。適切な報酬設計は、機械が効率的に目標へたどり着くための近道となります。しかし、この報酬の設定は容易ではありません。なぜなら、タスクの目標を明確に定義し、それを達成するための段階的な報酬を綿密に設計する必要があるからです。

もし、報酬設定が不適切であれば、機械は意図しない行動を学習してしまう可能性があります。例えば、ゲームで高得点を目指すよう設計したにも関わらず、報酬設定のミスによって、機械はゲームをクリアすることなく、特定の場所で延々と小さな報酬を得続けるといったことが起こりえます。これは、あたかも迷路で、ゴールを目指さずに、途中の小さな飴に気を取られてしまうようなものです。

このように、報酬成形は試行錯誤を繰り返しながら調整していく繊細な作業です。適切な報酬設計を見つけるには、まるで職人が技を磨くように、経験と深い理解が必要です。強化学習を効果的に活用するには、この報酬成形の技術を習得することが欠かせません。目標への最短ルートを示す、精巧な地図を作る名人のように、報酬成形を巧みに操ることで、機械学習の可能性は大きく広がります。