決定木の剪定:過学習を防ぐ賢い方法

AIを知りたい

先生、「剪定」って聞きましたけど、どういう意味ですか?木を切るみたいなことですか?

AIエンジニア

そうだね、木を切るイメージに近いよ。AIの分野、特に決定木と呼ばれる予測モデルを作る時によく使う手法なんだ。決定木は枝分かれを繰り返して色々な条件でデータを分けていくんだけど、枝分かれが多すぎると、複雑になりすぎて新しいデータに対してうまく予測できないことがあるんだ。

AIを知りたい

複雑になりすぎると良くないんですね。剪定はその枝を切ることで、複雑さを調整しているということですか?

AIエンジニア

その通り!重要じゃない枝を切ることで、木全体の大きさを小さくして、新しいデータでもうまく予測できるようにするんだ。これを剪定と言うんだよ。

剪定とは。

人工知能の分野で使われる『剪定』という言葉について説明します。剪定とは、決定木と呼ばれる木の形をしたデータ構造において、木の深さを制限する方法のことです。具体的には、精度にあまり影響を与えない枝や節を刈り取ることで、新しいデータに対しても正しく予測できる能力(汎化性能)を高めることができるということが知られています。

剪定とは

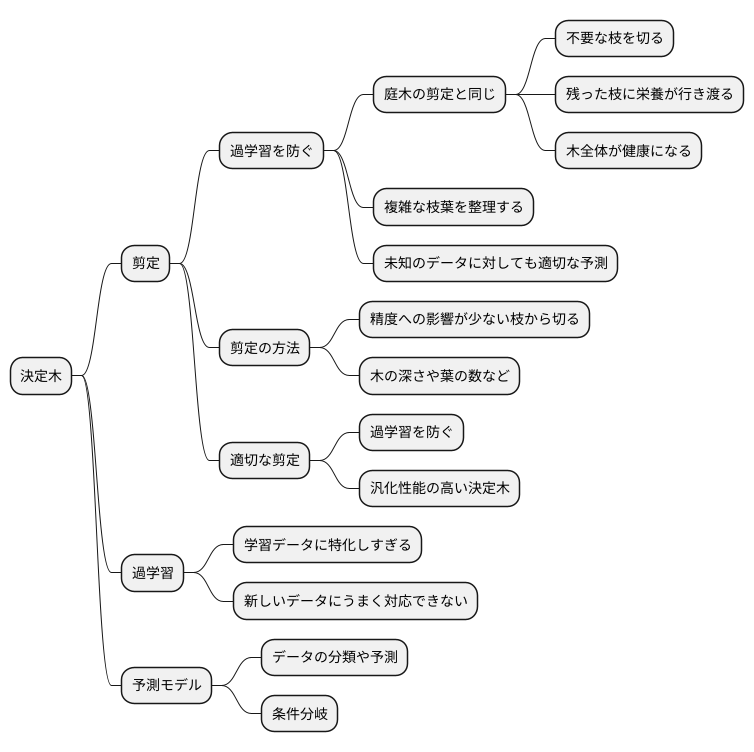

庭木の手入れと同じように、伸びすぎた枝を切ることで木全体の生育を良くしたり、美しい形を保ったりするように、決定木と呼ばれる予測モデルにも剪定という作業があります。決定木は、様々な条件分岐を組み合わせて、データの分類や予測を行うモデルです。まるで木の枝が分かれるように、条件によってデータが振り分けられていきます。多くの枝葉を持つ複雑な決定木は、学習に使ったデータに対しては非常に高い精度で予測できますが、新しい未知のデータに対してはうまく予測できないことがあります。これは、まるで特定の生徒だけに合わせた特別な授業は、その生徒には効果的でも、他の生徒には通用しないのと同じです。このような状態を過学習と呼びます。

剪定は、この過学習を防ぐための大切な手法です。具体的には、決定木の一部を刈り取ることで、モデルを単純化します。複雑になりすぎた枝葉を整理することで、未知のデータに対しても、より適切な予測ができるようになります。庭木の剪定で不要な枝を切ることで、残った枝に栄養が行き渡り、木全体が健康になるのと同じように、決定木の剪定でも、重要な部分を残しつつ不要な部分を削ぎ落とすことで、モデル全体の性能が向上するのです。

剪定には様々な方法があり、どの枝を切るべきかを判断する基準も様々です。例えば、ある枝を切ったときに、予測精度がどれだけ変化するかを計算し、精度への影響が少ない枝から優先的に切る方法があります。他にも、木の深さや葉の数など、複雑さを示す指標を基に剪定する方法もあります。どの方法が最適かは、扱うデータや目的によって異なります。適切な剪定を行うことで、過学習を防ぎ、より汎化性能の高い、つまり様々なデータに対応できる、頑健な決定木を構築することができるのです。

剪定の種類

木の枝を切り落とす作業、すなわち剪定には、大きく分けて二つのやり方があります。一つはあらかじめ木がどこまで大きくなるかを決めてしまう「事前剪定」です。これは、木がまだ苗木のうちから、最終的にどのくらいの高さにするか、枝をどれくらい広げるかを決めてしまうようなものです。木の深さや葉の数をあらかじめ制限することで、木が大きくなりすぎないようにします。この方法は、木が大きくなる前に手を打つので手間がかかりません。しかし、木が本来どれくらい大きくなるかを見極めるのは難しく、制限を厳しくしすぎると、木が十分に育たない可能性もあります。丁度良い大きさをあらかじめ決めるのは、経験と知識が必要です。

もう一つのやり方は、木を一度完全に育ててから、不要な枝を切る「事後剪定」です。木が十分に成長した後で、不要な枝や、伸びすぎた枝を切り落とすことで、木全体のバランスを整えたり、風通しを良くしたりします。この方法は、木が最終的にどのくらいの大きさになるかを見てから剪定できるので、事前剪定よりも良い結果が得られることが多いです。しかし、木を一度完全に育てる必要があるため、事前剪定に比べて手間と時間がかかります。事後剪定にも色々なやり方があり、例えば、木の全体像を見てバランスの悪い枝を切る方法や、枯れた枝や病気の枝を重点的に切る方法などがあります。どの枝を切るかの判断基準には様々なものがあり、木の種類や剪定の目的によって適切な方法を選ぶ必要があります。例えば、実をたくさんつけさせたい場合は、実のならない枝を切るといった具合です。剪定は木の生育にとって重要なので、事前剪定と事後剪定の長所と短所を理解し、状況に応じて適切な方法を選ぶことが大切です。

| 剪定方法 | 説明 | メリット | デメリット |

|---|---|---|---|

| 事前剪定 | 苗木のうちから最終的な木の大きさ(高さ、枝の広がり)を決めて剪定する。 | 手間がかからない。 | 木の本来の大きさを予測するのが難しく、制限を厳しくしすぎると木が十分に育たない可能性がある。適切な大きさを決めるには経験と知識が必要。 |

| 事後剪定 | 木を一度完全に育ててから、不要な枝や伸びすぎた枝を切る。 | 木の最終的な大きさを見てから剪定できるので、事前剪定より良い結果が得られやすい。 | 木を一度完全に育てる必要があるため、事前剪定に比べて手間と時間がかかる。 |

剪定の基準

木の枝を切り落とす作業である剪定は、機械学習の分野でも重要な技術です。機械学習では、データから規則性やパターンを見つけ出すために、複雑なモデルを作ることがあります。しかし、複雑すぎるモデルは、学習データに過剰に適応しすぎてしまい、新しいデータに対してうまく予測できないという問題が生じることがあります。これを過学習と呼びます。剪定は、この過学習を防ぐために、モデルを簡略化する手法です。

剪定を行う際には、どの枝を切るか、つまり、モデルのどの部分を削除するかを判断するための基準が必要です。一つの基準は、検証データに対する精度です。モデルの学習には使われなかった検証データを使ってモデルの性能を測り、剪定によってその精度が向上する場合は、剪定が有効だったと判断できます。精度が向上するということは、モデルが学習データだけに特化せず、より一般的なデータにも対応できるようになったことを示しています。

また、情報量基準などの統計的な指標を用いる方法もあります。赤池情報量規準(AIC)やベイズ情報量規準(BIC)といった指標は、モデルの複雑さと精度のバランスを評価します。複雑なモデルは表現力が高い一方で、過学習のリスクも高まります。これらの指標は、精度と複雑さのバランスを考慮し、最適な剪定位置を決定するのに役立ちます。

さらに、枝を切ること、つまりモデルを簡略化することで、どれだけの計算量を削減できるかという観点も重要です。特に、大量のデータや複雑なモデルを扱う場合は、計算に時間がかかります。剪定によってモデルが簡略化されれば、計算時間の短縮につながり、より効率的に処理を行うことができます。これは、大規模なデータを取り扱う場合に大きな利点となります。

| 剪定の目的 | 基準 | 指標 | 利点 |

|---|---|---|---|

| 過学習を防ぎ、モデルを簡略化 | 検証データに対する精度向上 | 赤池情報量規準(AIC)、ベイズ情報量規準(BIC) | 計算量の削減、処理の効率化 |

剪定の実施方法

木の切り方は、どの道具を使うか、どのやり方で行うかで大きく変わります。多くの庭木の手入れに役立つ道具には、様々な種類があります。それぞれに得意な切り方があるので、よく理解して使うことが大切です。例えば、ノコギリは太い枝を切るのに向いており、剪定ばさみは細い枝を切るのに適しています。また、高枝切りばさみは高い所の枝を切るのに便利です。

木を切るやり方も様々です。まず、不要な枝を根本から切る「切り戻し」という方法があります。これは、木の形を整えたり、風通しを良くしたりするのに効果的です。次に、枝の一部を切り取る「間抜き」という方法があります。これは、込み入った枝を整理し、日当たりを良くするのに役立ちます。さらに、徒長枝と呼ばれる、必要以上に伸びた枝を切ることも重要です。徒長枝は木の養分を無駄に消費するため、早めに切ることで、他の枝に栄養が行き渡りやすくなります。

木の切り方には、木の成長を調整するための技術も含まれます。例えば、木の高さを抑えたい場合は、先端の枝を切ることで成長を抑制できます。また、特定の方向に枝を伸ばしたい場合は、その方向に伸びている芽を残し、他の芽を摘み取ることで、思い通りの形に育てることができます。木の切り方を学ぶ際には、これらの技術を習得することが重要です。

適切な切り方をすることで、木は健康に育ち、美しい姿を保つことができます。反対に、間違った切り方をすると、木を傷つけたり、病気の原因になることもあります。そのため、木の切り方を学ぶ際には、正しい知識を身につけることが大切です。また、木の状態をよく観察し、適切な時期に剪定を行うことも重要です。剪定の時期は、木の種類や地域によって異なるため、事前に調べておく必要があります。

木の切り方は、一見簡単そうに見えても、奥が深い技術です。正しい知識と技術を習得することで、木を美しく健康に保つことができます。そのため、積極的に学び、実践していくことが大切です。

| 項目 | 説明 |

|---|---|

| 道具 | ノコギリ(太い枝)、剪定ばさみ(細い枝)、高枝切りばさみ(高い所の枝) |

| 切り戻し | 不要な枝を根本から切る。木の形を整え、風通しを良くする。 |

| 間抜き | 枝の一部を切り取る。込み入った枝を整理し、日当たりを良くする。 |

| 徒長枝の除去 | 必要以上に伸びた枝を切る。他の枝に栄養が行き渡りやすくなる。 |

| 高さ調整 | 先端の枝を切ることで成長を抑制する。 |

| 方向調整 | 特定の方向の芽を残し、他の芽を摘み取る。 |

| 剪定時期 | 木の種類や地域によって異なる。事前に調べておく必要がある。 |

剪定の効果と注意点

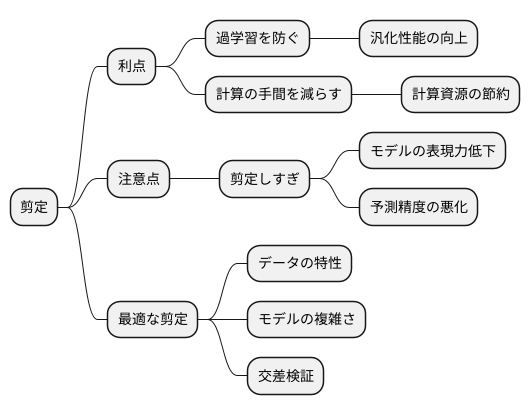

木の枝を切り落とすように、機械学習モデルにある枝葉のような不要な部分を切り落とす作業を剪定といいます。この剪定を行うことで、様々な良い効果が得られます。

まず、剪定は過学習を防ぎます。過学習とは、訓練データに過度に適合しすぎてしまい、新しいデータに対してうまく対応できなくなる状態のことです。剪定によってモデルを簡略化することで、この過学習を防ぎ、未知のデータに対しても高い予測精度を維持することができます。これは汎化性能の向上と呼ばれ、モデルの重要な目標の一つです。

また、剪定は計算の手間を減らす効果もあります。モデルが複雑であればあるほど、計算に時間がかかります。剪定によってモデルを小さくすることで、計算にかかる時間を短縮し、計算資源を節約することができます。これは、特にデータ量が膨大な場合に大きな効果を発揮します。

しかし、剪定には注意点もあります。剪定しすぎると、必要な情報まで切り落としてしまい、モデルの表現力が低下してしまう可能性があります。これは、予測精度の悪化につながるため、注意が必要です。例えるなら、木の枝を剪定しすぎて、花が咲かなくなってしまうようなものです。

最適な剪定の具合は、扱うデータの特性やモデルの複雑さによって異なります。そのため、どの程度剪定を行うのが最適なのかを、様々な方法を試して見つける必要があります。例えば、交差検証と呼ばれる手法を用いることで、データの一部を使ってモデルを訓練し、残りのデータで性能を評価することを繰り返すことで、最適な剪定の程度を探ることができます。

このように、剪定は機械学習モデルの性能向上に欠かせない技術ですが、適切な剪定を行うためには、データやモデルへの理解、そして慎重な調整が必要です。

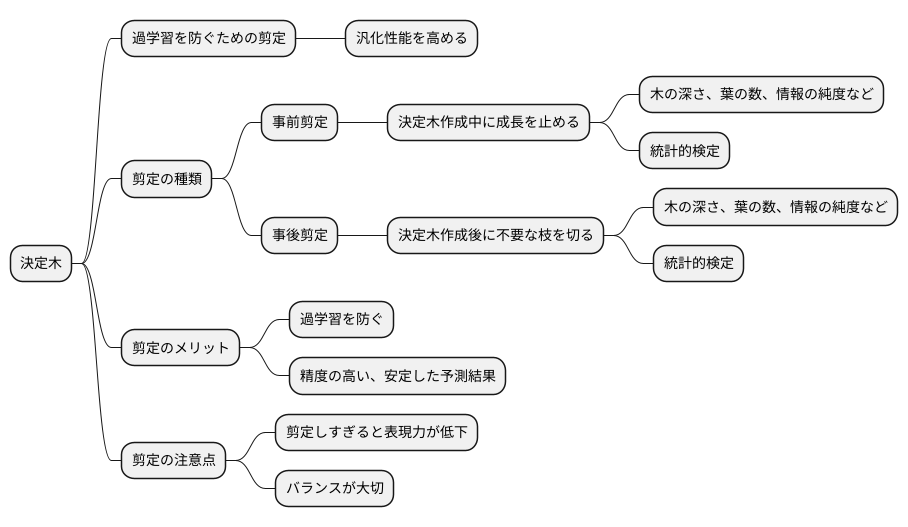

まとめ

決定木は、データを元に判断の分岐を繰り返すことで予測を行う、わかりやすい手法です。しかし、学習データにあまりにも適合しすぎると、未知のデータに対しての予測精度が落ちてしまうことがあります。これを過学習といいます。この過学習を防ぎ、様々なデータにも対応できる力、つまり汎化性能を高めるために、剪定という手法が用いられます。

剪定には、大きく分けて二つの種類があります。一つは事前剪定です。これは、決定木を作成する過程で、ある条件を満たすと木の成長を途中で止める方法です。もう一つは事後剪定です。こちらは、まず完全に決定木を成長させた後、不要な枝を切り落とすことで、木を小さくする方法です。

事前剪定と事後剪定、それぞれに様々な基準や方法があります。例えば、木の深さや葉の数、枝分かれの際の情報の純度など、様々な指標を用いて剪定を行います。また、統計的な検定を用いて、枝を落とすかどうかの判断を行う方法もあります。どの方法が最適かは、扱うデータの性質や予測したい内容によって異なります。そのため、データに合わせて適切な剪定方法を選ぶことが重要です。

剪定を行うことで、過学習を防ぎ、より精度の高い、安定した予測結果を得られるようになります。しかし、剪定しすぎると、決定木の表現力が低下し、必要な情報まで切り落としてしまう可能性があります。つまり、過学習を防ぎつつ、モデルの表現力を維持するバランスが大切です。

剪定は、決定木の性能を最大限に引き出すための重要な技術です。剪定の様々な技術を理解し、データに合わせて適切に剪定を行うことで、より効果的な機械学習モデルを構築することができます。そして、精度の高い予測を通して、様々な課題の解決に役立てることができます。