モデル蒸留:技術の伝承

AIを知りたい

先生、AIの『蒸留』と『派生モデル』の違いがよくわからないのですが、教えていただけますか?

AIエンジニア

いい質問ですね。『蒸留』は、例えるなら、先生(既存モデル)の作った解答を見ながら、生徒(新たなモデル)が同じように問題を解けるように練習するようなものです。先生と同じように解けるようになることが目的なので、生徒は先生と似たような考え方をするようになります。

AIを知りたい

なるほど。では、『派生モデル』はどういうものですか?

AIエンジニア

『派生モデル』は、先生(既存モデル)の思考回路(構造)はそのままに、違う教科書(データ)で勉強させるようなものです。先生と同じ考え方を持ったまま、新しい知識を学ぶことになります。つまり、『蒸留』は先生の解答を真似るのに対し、『派生モデル』は先生の思考回路を受け継いで別の学習をする、という違いがあります。

蒸留とは。

人工知能の分野でよく使われる『蒸留』という言葉について説明します。『蒸留』とは、すでにある模型の入力と出力の組み合わせをもとに、新しい模型を学習させることです。そうすることで、元の模型と似た働きをする新しい模型を作ることができます。また、元の模型の仕組みがわかっている場合は、別のデータを使って学習し直したものを、派生模型と呼びます。

蒸留とは

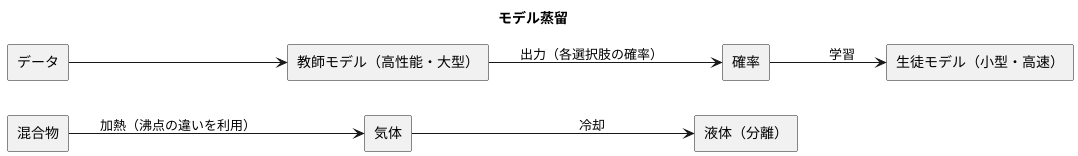

蒸留とは、もともとは化学の分野で使われてきた言葉で、物質を熱して気体にし、それを再び冷やして液体に戻すことで、目的の成分を取り出す技術のことを指します。複数の液体が混ざっているときに、それぞれの液体は沸騰する温度が違います。この温度差を利用して、低い温度で沸騰する成分から順番に気体として分離し、それを冷やすことで再び液体として集めることで、各成分を分けて取り出すことができます。

この蒸留の考え方を、近年の技術である機械学習にも応用することができます。これをモデル蒸留と呼びます。モデル蒸留では、高性能で複雑なモデル(教師モデル)から、小型で扱いやすいモデル(生徒モデル)へと、知識を受け継がせることを目指します。教師モデルは、大量のデータと多くの計算を使って学習させるため、高い性能を示しますが、その分、計算に時間がかかったり、多くの資源が必要となったりします。そこで、教師モデルの予測結果を生徒モデルの学習に利用することで、教師モデルの高い性能はそのままに、計算の手間を減らすことが可能になります。

これは、熟練した職人から弟子へと技術を伝える過程と似ています。熟練した職人は長年の経験と知識を積み重ねていますが、弟子は師匠の仕事ぶりや教えを学ぶことで、効率的に技術を習得できます。同じように、モデル蒸留では、教師モデルの出力という形で知識を取り出し、生徒モデルに効率よく学習させることで、高性能なモデルを作ることができます。このように、異なる分野で培われた技術や考え方を応用することで、新たな技術が生まれています。

蒸留の仕組み

蒸留とは、物質を一度気体にしてから再び液体に戻す操作で、沸点の違いを利用して混合物を分離する技術です。この原理は、お酒作りにも使われています。お酒作りでは、発酵によってできたもろみを加熱することで、アルコールだけが気化しやすいため、先に蒸発します。その後、蒸気を冷やすことで再び液体に戻し、アルコール度数の高いお酒が得られます。

この蒸留の考え方は、人工知能の学習方法の一つであるモデル蒸留にも応用されています。モデル蒸留では、高性能な大きなモデル(教師モデル)の知識を、小型で高速なモデル(生徒モデル)に伝達することで、生徒モデルの性能向上を目指します。

具体的には、教師モデルにデータを入力し、得られた出力値を生徒モデルの学習に利用します。通常の学習では、正解は「はい」か「いいえ」のようなはっきりとした値です。一方、モデル蒸留では、教師モデルが出力する各選択肢の確率を生徒モデルに教えます。例えば、画像に猫が写っているかを判断するモデルの場合、通常の学習では「猫である」か「猫でない」かを教えます。しかし、モデル蒸留では、教師モデルが「猫である確率90%、猫でない確率10%」と出力した場合、この確率の値を生徒モデルに伝えます。

このように、確率というより詳細な情報を伝えることで、生徒モデルは教師モデルの判断の根拠をより深く理解し、より正確な予測ができるようになります。さらに、学習データに含まれる間違いの影響も受けにくくなるため、様々な状況に対応できる柔軟なモデルを作ることができます。これは、教師が生徒により多くの知識や考え方を伝えることで、生徒の理解を深めることに似ています。

派生モデル

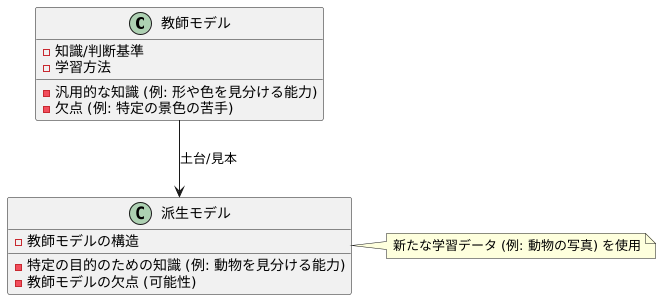

派生モデルは、既存のモデル、つまり教師モデルを土台として、新たなモデルを作る手法です。言えると、優れた職人さんが作った見本を参考に、自分なりの作品を作るようなものです。この見本が教師モデルで、新しく作る作品が派生モデルです。

派生モデルを作る際は、教師モデルの構造はそのまま活用します。これは、見本の設計図をそのまま使うようなものです。設計図を新しく作る手間が省けるので、ゼロからモデルを作るよりも早く、効率的に作業を進めることができます。そして、この設計図に基づいた作品を、異なる材料を使って作っていきます。この材料が、派生モデルを作るための新たな学習データです。

例えば、風景写真を見分ける名人、つまり教師モデルがいるとします。この名人の持つ知識や判断基準を活かしながら、今度は動物を見分ける専門家、つまり派生モデルを育てたいとします。この場合、風景写真の認識能力を高めるために使われた名人の学習方法はそのままに、動物の写真を使って改めて学習させます。すると、動物を見分ける能力に特化した派生モデルが完成します。

派生モデルの利点は、教師モデルが既に持っている汎用的な知識を活かせることです。風景写真の認識で培われた、形や色を見分ける能力は、動物の認識にも役立ちます。そのため、少ない動物の写真だけでも、効率的に学習を進めることができます。

ただし、注意すべき点もあります。教師モデルの設計図をそのまま使うということは、教師モデルが持っている欠点も受け継いでしまう可能性があるということです。風景写真の名人が、特定の景色を苦手としていた場合、動物を見分ける際にも、似た特徴を持つ動物を苦手とするかもしれません。このように、教師モデルの性質が派生モデルに影響を与えることを理解しておく必要があります。

まとめると、派生モデルは、教師モデルの優れた点を活かしつつ、特定の目的に特化したモデルを効率的に作るための、有力な手法と言えるでしょう。

応用事例

様々な分野で活用されているモデル蒸留について、具体的な事例を交えて説明します。

まず、計算資源が限られる携帯端末での活用事例です。高性能な認識機能を小型の機器で実現するには、多くの計算処理を必要とする高性能なモデルは搭載できません。そこで、高性能な計算機で学習させた複雑で大規模なモデルを教師モデルとし、携帯端末でも動作可能な簡素で小規模なモデルを生徒モデルとして学習させます。教師モデルは、大量のデータと十分な計算資源を使って学習させることで高い性能を実現しています。この教師モデルの出力結果を模倣するように生徒モデルを学習させることで、限られた計算資源でも高精度な認識機能を実現できるのです。

次に、個人情報の保護が必要な場合の活用事例です。学習データには、個人のプライバシーに関わる重要な情報が含まれている場合があり、これらのデータを外部に持ち出すことはできません。このような状況では、データを持つ組織が教師モデルを学習させ、その出力結果だけを外部の組織と共有します。外部の組織は、共有された出力結果を使って生徒モデルを学習させます。この方法により、学習データそのものを共有することなく、高性能なモデルの知識だけを共有できるため、データのプライバシーを守りながら、高性能なモデルを開発できます。

最後に、複数のモデルを組み合わせる学習方法である集団学習での活用事例です。集団学習は、複数のモデルの予測結果を統合することで、より高い精度を実現できます。しかし、複数のモデルを同時に運用するには、多くの計算資源が必要となります。そこで、複数のモデルを教師モデルとして、一つの統合されたモデルを生徒モデルとして学習させます。これにより、集団学習と同等の性能を維持しながら、計算資源の消費を抑えることができます。このようにモデル蒸留は、様々な場面で活用され、人工知能技術の発展に貢献しています。

| 活用場面 | 教師モデル | 生徒モデル | メリット |

|---|---|---|---|

| 携帯端末への搭載 | 複雑で大規模な高性能モデル | 簡素で小規模なモデル | 限られた計算資源でも高精度な認識機能を実現 |

| 個人情報の保護 | データを持つ組織で学習させた高性能モデル | データを持たない組織で学習させるモデル | 学習データそのものを共有することなく、高性能なモデルの知識だけを共有 |

| 集団学習の効率化 | 複数のモデル | 一つの統合されたモデル | 集団学習と同等の性能を維持しながら、計算資源の消費を抑える |

今後の展望

知識を大きなものから小さなものへ受け渡す、まるで師匠が弟子に教えるような技術。それがモデル蒸留です。この技術は、これからの人工知能の進化に欠かせないものとなるでしょう。特に、近年の深層学習モデルは巨大化の一途をたどっており、高性能な計算機が必要不可欠となっています。しかし、誰もがそのような計算機を利用できるわけではありません。そこで、モデル蒸留によって大きなモデルの知識を小さなモデルに移し替えることで、少ない計算資源でも高性能な人工知能を実現できるようになります。

現在、様々な研究者たちが、より効果的な蒸留方法を開発しようとしのぎを削っています。例えば、大きなモデルのどの部分を重点的に小さなモデルに教えるか、どのように教えれば効率よく学習できるかなど、様々な工夫が凝らされています。また、画像認識や音声認識など、様々な種類の人工知能モデルへの応用も研究されています。将来的には、まるで人間のように様々な能力を持つ人工知能が、この技術によって身近なものになるかもしれません。

さらに、量子計算機との組み合わせも期待されています。量子計算機は、従来の計算機では不可能だった計算を可能にする革新的な技術です。この技術とモデル蒸留を組み合わせることで、より巨大なモデルの知識を小さなモデルへ受け渡すことが可能になり、人工知能の性能が飛躍的に向上すると考えられています。

また、人工知能の説明性を高める上でも、モデル蒸留は重要な役割を果たすと期待されています。近年の深層学習モデルは非常に複雑で、その判断の根拠を理解することが困難です。しかし、モデル蒸留によって複雑なモデルの知識を単純なモデルに移し替えることで、判断の根拠を理解しやすくなり、人工知能の信頼性向上に繋がると期待されています。このように、モデル蒸留は人工知能の発展に大きく貢献する技術として、様々な分野で活用されていくでしょう。

| 項目 | 内容 |

|---|---|

| モデル蒸留とは | 大きなモデルの知識を小さなモデルに転移する技術。師匠が弟子に教えるようなイメージ。 |

| 目的/効果 | 少ない計算資源での高性能AI実現、様々なAIモデルへの応用、AIの性能向上、AIの説明性向上 |

| 現状 | 様々な研究者による効果的な蒸留方法の研究開発、画像認識や音声認識への応用研究 |

| 課題/研究方向 | 大きなモデルのどの部分を重点的に教えるか、どのように教えれば効率よく学習できるか |

| 将来展望 | 人間のように様々な能力を持つAIの実現、量子計算機との組み合わせによる性能飛躍、AIの信頼性向上 |