LIME:AIの解釈を助ける技術

AIを知りたい

先生、「LIME」ってなんですか?なんだか難しそうでよくわからないです。

AIエンジニア

そうだね、少し難しいけど、簡単に言うと、AIがなぜその答えを出したのかを分かりやすく説明してくれる道具のようなものだよ。AIの中身は複雑でブラックボックス化されているけど、LIMEを使えば、その理由を私たち人間にも理解できるようにしてくれるんだ。

AIを知りたい

なるほど。たとえば、AIが「この写真は猫です」と判断したとき、LIMEを使えば、どうして猫だと判断したのかが分かるってことですか?

AIエンジニア

その通り!AIが注目した部分、例えば耳の形やヒゲといった特徴を分かりやすく示してくれることで、なぜ猫と判断したのかを説明してくれるんだよ。

LIMEとは。

人工知能にまつわる言葉、『ライム』について説明します。ライムとは、説明可能人工知能と呼ばれる、中身が複雑で分かりにくい機械学習の仕組みを、人が見てすぐに分かるようにする技術の一つです。ライムは、ある予測結果が出たときに、その予測結果になるまでの過程を、予測結果の周辺に絞って単純な分類器を作って模倣することで、分かりやすくしています。

説明可能なAIとは

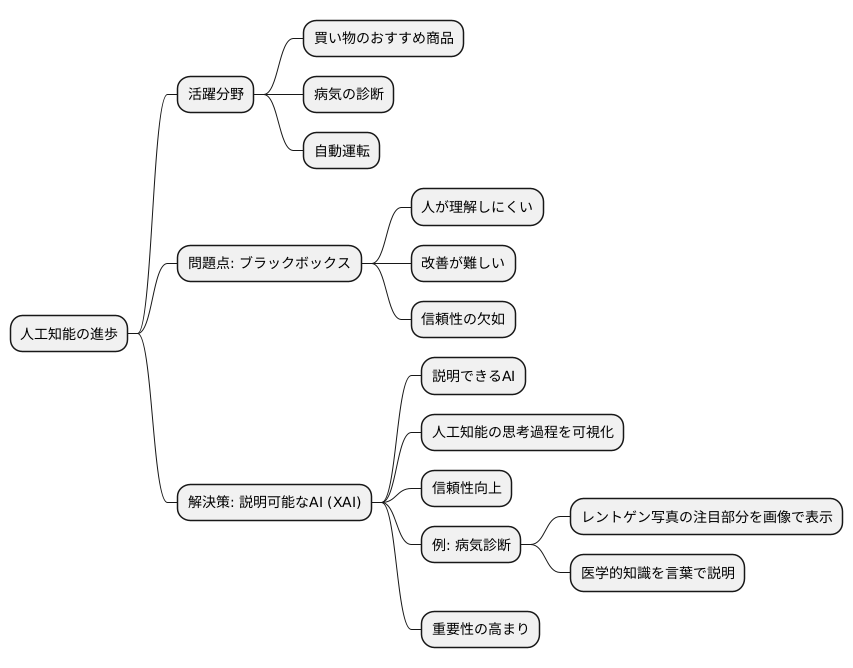

近ごろ、人工知能はめざましい進歩を遂げ、様々な場所で役立てられています。買い物でのおすすめ商品、病気の診断、自動運転など、生活の多くの場面で人工知能が活躍しています。しかし、特に複雑な仕組みを持つ人工知能は、どのように答えを出したのかを人が理解するのが難しいという問題を抱えています。まるで中身の見えない黒い箱のようなので、「ブラックボックス」と呼ばれています。

例えば、ある人工知能が患者のレントゲン写真から病気を診断したとします。しかし、人工知能が写真のどの部分を見て、どのような根拠でその病気を診断したのかが分からなければ、医師は診断結果を完全に信頼することはできません。また、もし誤診があった場合、原因を特定し改善することも難しくなります。

このような問題を解決するために、人工知能の判断の過程を人が理解できるようにする技術が研究されています。これを「説明可能な人工知能」、もしくは「説明できる人工知能」と呼びます。英語ではExplainable AIと書き、XAIと略されることもあります。

説明可能な人工知能は、人工知能がどのように考え、どのような理由で答えを出したのかを分かりやすく示すことで、ブラックボックス問題を解決します。例えば、先ほどの病気の診断であれば、人工知能がレントゲン写真のどの部分に注目したのかを画像で示したり、診断の根拠となった医学的な知識を言葉で説明したりすることで、医師が診断結果を理解しやすくなります。

説明可能な人工知能は、人工知能の信頼性を高め、安心して使えるようにするために欠かせない技術です。今後、人工知能がさらに社会に浸透していく中で、説明可能な人工知能の重要性はますます高まっていくでしょう。

LIMEの概要

「説明可能な人工知能」(XAI)を実現するための一つの方法として、「ライム」(LIMELocal Interpretable Model-agnostic Explanations)というものがあります。これは、複雑で分かりにくいモデルの予測結果を、局所的に簡単なモデルで近似することで、人が理解しやすい説明を作り出す手法です。

全体を理解しようとするのではなく、個々の予測結果に注目し、その予測に影響を与えた要因を特定します。たとえば、画像認識で人工知能が「猫」と予測した場合、ライムは画像のどの部分が「猫」の特徴だと判断されたのかを明らかにすることができます。

ライムは、複雑なモデルの種類に関係なく利用できるという利点があります。どんなモデルでも、入力データの一部を変化させて、予測結果への影響を調べます。この変化に基づいて、局所的な単純なモデル(例えば線形モデル)を学習します。

この単純なモデルは、元の複雑なモデルの挙動を局所的に近似しているため、その係数を見ることで、どの特徴量が予測にどの程度影響を与えているかを理解できます。例えば、画像認識の場合、単純なモデルの係数が大きい部分は、元のモデルが「猫」と判断する際に重視した部分であると解釈できます。

このように、ライムはブラックボックス化した人工知能の内部 workings を知ることなく、その予測の根拠を理解する助けとなります。つまり、「なぜこの予測結果になったのか」という問いに対して、具体的な説明を提供することができるのです。これは、人工知能の信頼性を高め、より効果的に活用するために非常に重要です。

| 手法 | 目的 | 仕組み | 利点 | 効果 |

|---|---|---|---|---|

| LIME (Local Interpretable Model-agnostic Explanations) | 複雑なAIモデルの予測結果を説明可能にする | 個々の予測結果に注目し、予測に影響を与えた要因を特定 入力データの一部を変化させ、予測結果への影響を調べ、局所的な単純なモデル(例:線形モデル)を学習 単純なモデルの係数から、どの特徴量が予測にどの程度影響を与えているかを理解 |

モデルの種類に依存しない (model-agnostic) | AIの予測根拠を理解 AIの信頼性向上 AIのより効果的な活用 |

LIMEの仕組み

LIME(ライム)とは、複雑な機械学習モデルがどのように予測を行っているのかを、人間が理解しやすい形で説明する技術です。

モデルの種類に関わらず使えるため、様々な場面で活用できます。

LIMEは、注目したデータの周辺に似たようなデータをたくさん作り出し、元のモデルでこれらのデータの予測を行います。

たくさんのデータと予測結果をもとに、単純で分かりやすいモデル(例えば、一次関数のようなモデル)を作ります。

この単純なモデルは、元の複雑なモデルの動きを、注目したデータの周辺だけで模倣したものです。

例えるなら、広い地図全体を細部まで再現する代わりに、ある特定の場所だけを詳しく描いた簡易地図のようなものです。

全体を完璧に再現する必要はなく、注目した場所の周辺だけを正しく表現できれば十分です。

このようにして作られた単純なモデルを分析することで、元のモデルがどのような基準で予測を行ったのかを把握できます。

具体的には、どの情報が予測結果に大きく影響したのか、どの情報が重要でどの情報が重要でないのかを特定できます。

例えば、ある人物の融資審査を機械学習モデルで行ったとします。

LIMEを使うことで、その人物の年収や勤続年数、過去の借入履歴といった様々な情報のうち、融資の可否を判断する際に、どの情報が重要視されたのかを具体的に示すことができます。

これは、モデルの判断根拠を明らかにすることで、予測結果の信頼性を高めることに繋がります。

このように、LIMEはブラックボックスになりがちな機械学習モデルの解釈を支援し、AIの活用をより透明性の高いものにする上で重要な役割を担っています。

LIMEの利点

説明可能人工知能(XAI)の手法の一つであるLIMEは、様々な長所を持つことから、幅広い分野で活用されています。その中でも特に注目すべき点は、モデルを選ばない汎用性の高さです。近年のAI技術の中心である深層学習モデルだけでなく、決定木やサポートベクターマシンなど、様々な種類のモデルに適用できるため、状況に応じて最適なモデルを選択できます。また、LIMEはモデル全体ではなく、特定の予測結果に焦点を当てた局所的な説明を提供します。複雑なモデルは、全体像を把握することが難しい場合も少なくありません。しかし、LIMEを用いることで、一つ一つの予測結果について、入力データのどの部分がどのように影響を与えているのかを詳細に理解することができます。これは、モデルの挙動を深く理解し、信頼性を高める上で非常に重要です。さらに、LIMEは解釈しやすい線形モデルを用いて説明を行います。線形モデルは、入力と出力の関係が単純な比例関係で表されるため、非常に分かりやすいモデルです。LIMEは、複雑なモデルの挙動を局所的に線形モデルで近似することで、誰にでも理解しやすい説明を生成します。専門的な知識を持たない人でも、予測結果の根拠を理解し、納得することができます。これらの利点が、LIMEをXAI分野で重要な手法として位置づけていると言えるでしょう。

| 長所 | 説明 |

|---|---|

| モデルを選ばない汎用性 | 深層学習モデル、決定木、サポートベクターマシンなど、様々なモデルに適用可能 |

| 局所的な説明を提供 | 特定の予測結果に焦点を当て、入力データの影響を詳細に分析 |

| 解釈しやすい線形モデルを用いた説明 | 複雑なモデルの挙動を線形モデルで近似し、分かりやすい説明を生成 |

LIMEの活用事例

説明可能人工知能(じんこうちのう)の手法の一つであるLIMEは、様々な分野で応用されています。この技術は、複雑な人工知能の判断根拠を分かりやすく示すことで、人工知能の活用範囲を広げ、人々の理解と信頼を得る助けとなっています。

医療分野では、病気の診断支援において、LIMEは医師にとって心強い味方となります。例えば、人工知能がある病気を診断した際に、LIMEを用いることで、どの検査データが診断に大きく影響したのかを特定できます。これにより、医師は人工知能の診断根拠を理解し、自身の知識と経験に基づいて診断の妥当性を判断することができます。また、患者にも診断結果を分かりやすく説明することができ、納得感の向上に繋がります。

金融分野でも、LIMEは融資審査などにおいて重要な役割を果たしています。人工知能が融資を却下した場合、その理由を説明することは、顧客との信頼関係を維持するために不可欠です。LIMEは、人工知能が融資の可否を判断する際に、どの要素を重視したのかを明らかにします。例えば、収入や過去の借入状況、信用情報など、どの情報が判断に影響を与えたのかを具体的に示すことで、顧客は却下の理由を理解しやすくなり、納得感を得やすくなります。

このように、LIMEは、人工知能がどのように判断したのかを分かりやすく示すことで、人工知能の透明性を高め、信頼性を向上させています。特に、人の判断が重要な役割を果たす医療や金融といった分野において、LIMEは人工知能の活用を促進し、社会全体の利益に貢献することが期待されています。将来的には、更なる技術開発により、より多くの分野でLIMEが活用され、人工知能と人間がより良く協調していく社会の実現に貢献していくと考えられます。

| 分野 | LIMEの役割 | 効果 |

|---|---|---|

| 医療 | 病気の診断支援において、どの検査データが診断に大きく影響したのかを特定 | 医師の診断根拠の理解、患者への説明性の向上 |

| 金融 | 融資審査において、どの要素(収入、借入状況、信用情報など)が判断に影響を与えたのかを明らかに | 顧客への説明性の向上、納得感の向上 |

LIMEの課題

LIME(ライム)は、機械学習モデルの予測結果を説明するための有力な手法です。複雑なモデルの判断根拠を特定の事例について分かりやすく示してくれるので、AIの判断を人間が理解する助けとなります。しかし、万能ではなく、いくつかの克服すべき課題も抱えています。

まず、LIMEは局所的な説明に焦点を当てています。ある特定のデータに対して、モデルがなぜそのように予測したのかを説明することに長けていますが、モデル全体の働きや、全体的な判断の傾向を把握することは苦手です。例えるなら、木を見て森を見ずといったところで、個々の判断の理由は分かっても、モデル全体の特徴や癖を理解することはできません。

次に、LIMEは近似的な説明を行います。複雑なモデルの動きをそのまま説明するのではなく、単純なモデルで近似して説明するため、どうしても元のモデルの挙動を完全に再現することはできません。これは、複雑な地形を簡単な模型で表現しようとするようなもので、細かな起伏や特徴までは再現できないのと似ています。そのため、近似の精度が説明の信頼性に大きく影響します。近似の度合いによっては、誤解を招く可能性もあるため注意が必要です。

さらに、LIMEによる説明の質は、使用するデータの性質や、近似モデルの設定に左右されます。近似モデルが複雑すぎると、説明が分かりにくくなり、逆に単純すぎると、重要な情報が欠落する可能性があります。データの性質も重要で、データの分布や特徴によっては、LIMEがうまく機能しない場合もあります。

これらの課題を解決するために、LIMEの改良や、新たな説明手法の開発が盛んに行われています。より正確で、分かりやすく、モデル全体の挙動を把握できる手法の登場が期待されます。LIMEは発展途上の技術であり、今後の進歩に注目していく必要があります。

| 課題 | 内容 | 例え |

|---|---|---|

| 局所的な説明 | 特定データに対する予測理由は説明できるが、モデル全体の働きや傾向は把握できない。 | 木を見て森を見ず |

| 近似的な説明 | 複雑なモデルを単純なモデルで近似して説明するため、元のモデルの挙動を完全に再現できない。 | 複雑な地形を簡単な模型で表現 |

| データと設定への依存 | 説明の質はデータの性質や近似モデルの設定に左右される。近似モデルが複雑すぎると説明が分かりにくく、単純すぎると情報が欠落する。 | – |