LIME:機械学習の解釈

AIを知りたい

先生、「LIME」ってなんですか?難しそうでよくわからないです。

AIエンジニア

LIMEは、複雑なAIの判断を分かりやすく説明してくれる技術だよ。AIがなぜそう考えたのかを、私たち人間にも理解できるようにしてくれるんだ。

AIを知りたい

なるほど。でも、どうやって説明してくれるんですか?

AIエンジニア

AIの判断のもとになったデータを単純化して、その判断に近い簡単な例を作って見せてくれるんだよ。そうすることで、AIの思考過程を推測しやすくなるんだ。

LIMEとは。

人工知能に関わる言葉である『ライム』について説明します。ライムとは、説明可能な人工知能と呼ばれる、中身がブラックボックス化して分かりにくい機械学習モデルを、人が見てすぐに分かるようにする技術の一つです。ライムを使うと、ある予測結果が出た際に、その予測結果になるべく近い、単純な分類器を作り出すことで、なぜそのような予測結果になったのかを分かりやすく示すことができます。

説明可能なAIとは

近ごろ、機械学習、中でも深層学習といった技術がめざましい進歩を遂げ、様々な場面で使われるようになってきました。医療診断や自動運転など、私たちの生活に密着した分野でも活躍しています。しかし、これらの技術は複雑な仕組みで動いているため、なぜそのような結果になったのか、その理由を人間が理解するのは難しいという問題があります。これは、まるで中身の見えない黒い箱のようなので、「ブラックボックス問題」と呼ばれています。

このブラックボックス問題を解決するために注目されているのが、「説明可能な人工知能」、略して「説明可能なAI」です。英語ではExplainable AIと書き、XAIと呼ばれることもあります。説明可能なAIとは、人工知能の判断の理由を人間が理解できるようにする技術のことです。たとえば、ある画像を見て人工知能が「猫」と判断した場合、なぜ猫だと思ったのか、耳の形やひげの様子など、根拠を分かりやすく示してくれるのです。

説明可能なAIは、人工知能の信頼性を高める上で重要な役割を果たします。なぜその判断に至ったのかが分かれば、安心して利用することができます。また、人工知能が間違った判断をした場合でも、その原因を特定しやすくなります。これは、人工知能の改善に役立ち、より正確な判断ができるように学習させることができます。さらに、説明可能なAIは、私たち人間に新たな発見をもたらしてくれる可能性も秘めています。人工知能が注目した点や、判断の根拠を分析することで、私たちが気づかなかった新たな視点や知識を得ることができるかもしれません。

LIME(ライム)は、このような説明可能なAIを実現する技術の一つです。LIMEを使うことで、複雑な人工知能の判断プロセスを分かりやすく解釈し、そのブラックボックス問題を解決する糸口となります。

LIMEの概要

「説明可能な人工知能」(説明可能なAI)とは、AIの判断根拠を人が理解できるように説明する技術のことです。近年のAI技術、特に深層学習(ディープラーニング)の急速な発展に伴い、AIは様々な分野で複雑なタスクを高い精度でこなせるようになりました。しかし、その判断過程は複雑で、人間には理解しにくい「ブラックボックス」となっている場合が多くあります。そこで、AIの判断根拠を人間が理解できるように説明する「説明可能なAI」技術が重要視されるようになってきました。「LIME」(ライム局所的に解釈可能なモデルに依存しない説明)は、このような説明可能なAIを実現するための手法の一つです。

LIMEは、特定の予測結果に焦点を当て、その予測がどのような要因に基づいているのかを局所的に説明します。例えば、ある画像が「猫」と分類されたとします。このとき、LIMEは、その画像のどの部分が「猫」の特徴として捉えられたのかを、人間にも分かりやすい形で示してくれます。具体的には、元の入力データに少し変更を加えたデータを多数作成し、それらをAIモデルで予測します。そして、予測結果と入力データの変化の関係を分析することで、どの部分が予測に大きく影響を与えているのかを特定します。

LIMEの大きな特徴は、モデルの種類に依存しないという点です。つまり、深層学習だけでなく、決定木やサポートベクターマシンなど、様々な種類のAIモデルに対して適用可能です。これは、LIMEがモデルの内部構造を解析するのではなく、入力データと出力結果の関係性に基づいて説明を行うためです。そのため、ブラックボックス化しやすい複雑なモデルの解釈にも有効です。LIMEを用いることで、AIの予測根拠を理解し、AIの信頼性を高め、より効果的にAIを活用することが可能になります。

| 項目 | 内容 |

|---|---|

| 説明可能なAI | AIの判断根拠を人が理解できるように説明する技術 |

| 背景 | 深層学習の発展に伴い、AIの判断過程がブラックボックス化している問題 |

| LIME (Lime局所的に解釈可能なモデルに依存しない説明) | 説明可能なAIを実現する手法の一つ。特定の予測結果の根拠を局所的に説明 |

| LIMEの動作原理 | 入力データに少し変更を加えたデータを多数作成し、AIモデルで予測。予測結果と入力データの変化の関係を分析し、予測への影響が大きい部分を特定 |

| LIMEの特徴 | モデルの種類に依存しない(深層学習、決定木、サポートベクターマシンなど様々なモデルに適用可能) |

| LIMEの利点 | AIの予測根拠を理解し、信頼性を高め、効果的なAI活用を促進 |

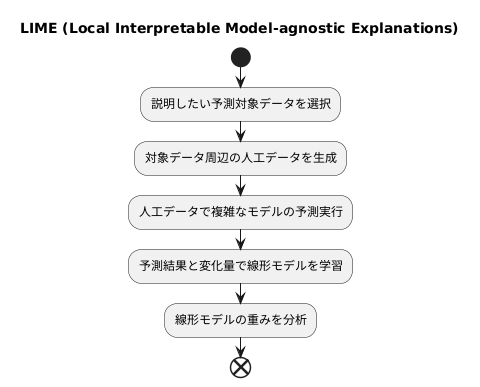

LIMEの仕組み

複雑で分かりにくい予測モデルの仕組みを解き明かす技術の一つに、LIME(ライムLocal Interpretable Model-agnostic Explanationsの略)という手法があります。LIMEは、複雑なモデルの全体像を捉えるのではなく、特定の予測結果に焦点を当て、その予測がどのように導き出されたのかを局所的に説明することを目指します。

具体的には、まず説明したい予測の対象となるデータを選びます。例えば、ある人の信用度を予測するモデルで、なぜこの人の信用度が低いと予測されたのかを知りたいとします。この人のデータを中心として、様々な特徴量の値を少しずつ変化させた人工的なデータを複数生成します。例えば、年齢を少し高くしたり、年収を少し低くしたりといった具合です。

次に、これらの新しく作ったデータに対して、元の複雑なモデルで予測を行います。そして、それぞれのデータに対する予測結果と、元々のデータからの変化量を用いて、単純で分かりやすい線形モデルを学習します。線形モデルとは、各特徴量の値に重みをつけて足し合わせることで予測を行うモデルです。

この線形モデルは、元の複雑なモデルの局所的な挙動を模倣しています。つまり、元のモデルが複雑な計算で信用度を予測していた部分を、線形モデルで近似的に表現しているのです。

線形モデルの重みを調べることで、どの特徴量が予測結果にどの程度影響を与えているかを把握できます。例えば、年齢の重みが大きければ、年齢がこの人の信用度予測に大きく影響していることが分かります。年収の重みが小さければ、年収はあまり影響していないと言えるでしょう。このように、複雑なモデルの代わりに、理解しやすい線形モデルを用いることで、特定の予測に対する説明を分かりやすく提供できるのです。

LIMEの利点

LIME(ライム)は、複雑な予測模型の仕組みを分かりやすく説明するための手法です。LIMEを使うことで、なぜある特定の予測結果が出力されたのかを、具体的な根拠と共に理解することができます。この手法には、様々な利点があります。

まず、LIMEは、使用する予測模型の種類を選びません。近年注目を集めている深層学習模型はもちろんのこと、従来から広く利用されている決定木や、サポートベクターマシンといった様々な種類の模型にも適用できます。つまり、LIMEは特定の模型に特化した手法ではなく、汎用的に使える手法であると言えます。一つの説明手法を様々な模型に適用できるため、異なる種類の模型を扱う際に、その都度新たな手法を学ぶ必要がありません。

次に、LIMEは、局所的な視点で説明を行います。複雑な予測模型は、全体像を把握することが難しい場合があります。LIMEは模型全体を説明するのではなく、個々の予測結果に焦点を当てて説明します。例えば、ある顧客が商品を購入するかどうかを予測する模型の場合、LIMEは、なぜその顧客が購入すると予測されたのか、あるいは購入しないと予測されたのかを、その顧客の属性情報に基づいて説明します。全体像を理解する必要がないため、専門家ではない人にも理解しやすい説明を提供できます。

最後に、LIMEは視覚的に分かりやすい説明を提供します。数値や数式だけで説明するのではなく、グラフや図などを用いて視覚的に表現します。例えば、顧客の購入予測であれば、どの属性情報が購入予測に大きく影響したのかを、グラフで分かりやすく示すことができます。これにより、専門的な知識を持たない人でも、予測結果の根拠を直感的に理解することができます。

このように、LIMEは模型の種類を選ばない汎用性、局所的な説明による分かりやすさ、視覚的な表現による直感的な理解という点で、優れた説明手法と言えます。これらの利点により、予測結果に対する信頼性を高め、より効果的な意思決定を支援することが期待されます。

| 利点 | 説明 |

|---|---|

| 模型を選ばない | 深層学習、決定木、サポートベクターマシンなど、様々な種類の模型に適用可能。 |

| 局所的な説明 | 模型全体ではなく、個々の予測結果に焦点を当てて説明。特定の顧客の属性情報に基づいて、なぜ購入すると予測されたのか/購入しないと予測されたのかを説明。 |

| 視覚的な説明 | グラフや図などを用いて視覚的に表現。どの属性情報が購入予測に大きく影響したのかをグラフで分かりやすく表示。 |

LIMEの応用

「説明可能な人工知能」(Explainable AI、略してXAI)と呼ばれる技術の一種であるLIMEは、様々な分野で活用されています。機械学習モデルがどのように結論に至ったのかを解き明かすことで、その判断の根拠を分かりやすく示すことができます。

医療の現場では、LIMEは診断の支援に役立ちます。例えば、画像診断で病気を特定する際に、AIが画像のどの部分に着目して判断したのかを明らかにすることで、医師の診断をより確かなものにします。従来、AIによる診断結果はブラックボックス化されており、医師はその根拠を理解することが困難でした。しかし、LIMEを用いることで、AIの判断根拠が可視化され、医師はAIの診断結果をより深く理解し、最終的な診断に役立てることができます。これにより、誤診のリスクを減らし、より適切な治療方針を決定することに繋がります。

金融業界においても、LIMEは融資審査の透明性を高めるために活用されています。融資の可否を判断する際、AIは様々な要素を考慮しますが、その判断過程は複雑で分かりにくい場合があります。LIMEを利用することで、どの情報が審査結果に大きく影響したのかを具体的に示すことができます。例えば、過去の取引履歴や信用情報などが、融資の可否にどのように影響を与えたのかを顧客に説明することで、審査結果への理解と納得感を高めることができます。

また、販売促進の分野でもLIMEは効果を発揮します。顧客の購買行動を予測するAIモデルの解釈にLIMEを用いることで、どのような特徴を持つ顧客がどのような商品に興味を持つのかを分析することができます。例えば、年齢や居住地、過去の購入履歴といった情報が、顧客の購買行動にどのように影響しているのかを理解することで、より効果的な販売促進戦略を立てることができます。特定の顧客層に合わせた広告配信や、商品の推奨を行うことで、販売機会の増加に繋げることが期待できます。

| 分野 | LIMEの活用方法 | 効果 |

|---|---|---|

| 医療 | 画像診断におけるAIの判断根拠の可視化 | 医師の診断支援、誤診リスクの軽減、適切な治療方針の決定 |

| 金融 | 融資審査におけるAIの判断根拠の提示 | 審査の透明性向上、顧客の理解と納得感の向上 |

| 販売促進 | 顧客の購買行動予測AIの解釈 | 効果的な販売促進戦略の立案、販売機会の増加 |

LIMEの限界

「LIME」は、複雑な機械学習モデルの予測結果を説明するための有力な手法ですが、いくつかの限界があります。この手法は、モデル全体を解き明かすのではなく、特定の予測結果周辺の挙動に焦点を当てた局所的な説明を提供することに特化しています。そのため、モデルの全体像を把握するには不向きです。

また、LIMEは、複雑なモデルを解釈しやすい単純なモデルで近似することで説明を行います。しかし、この単純なモデルの選び方や、データに与える変化のさせ方によって、解釈結果が大きく変わってしまう可能性があります。つまり、同じ予測結果に対しても、設定次第で異なる説明が得られる可能性があり、解釈結果をそのまま受け入れるのではなく、慎重に検討する必要があります。

さらに、扱うデータの次元数、つまりデータの特徴量の数が多くなると、LIMEの計算コストが急激に増加します。これは、高次元空間で適切な近似を行うのが困難になるためです。膨大な計算資源が必要となる場合もあり、現実的な時間内で処理を行うためには、工夫が必要となることがあります。例えば、重要な特徴量を選択して次元数を減らすといった前処理が有効な場合があります。

このように、LIMEは強力な手法である一方で、いくつかの制約も存在します。これらの限界を正しく理解し、目的に応じて適切に利用することが重要です。LIMEの解釈結果を盲信するのではなく、他の手法と組み合わせて多角的に分析することで、より信頼性の高い解釈が可能になります。

| 項目 | 内容 |

|---|---|

| 説明の範囲 | 局所的。特定の予測結果周辺の挙動に焦点を当てた説明を提供。モデル全体の挙動は把握できない。 |

| 近似モデルの影響 | 単純なモデルで近似するため、モデルの選び方やデータの変化のさせ方によって解釈結果が変わる可能性がある。 |

| 計算コスト | データの次元数が増加すると計算コストが急激に増加する。高次元空間での近似は困難。 |

| 注意点 | 解釈結果をそのまま受け入れるのではなく、他の手法と組み合わせて多角的に分析する必要がある。 |