ラッソ回帰:スパースなモデルを実現

AIを知りたい

先生、「ラッソ回帰」ってよく聞くんですけど、普通の回帰分析と何が違うんですか?

AIエンジニア

良い質問だね。ラッソ回帰は、たくさんの説明変数の中から本当に必要なものだけを選び出すのに役立つ回帰分析なんだ。不要な説明変数の影響を少なくすることで、予測の精度を上げることができるんだよ。

AIを知りたい

へえ、どうやって選び出すんですか?

AIエンジニア

説明変数の重要度が低いと判断されたものは、その影響がゼロになるように調整されるんだ。不要なものを排除することで、よりすっきりとしたモデルを作ることができるんだよ。

ラッソ回帰とは。

人工知能で使われる言葉に「ラッソ回帰」というものがあります。ラッソ回帰とは、たくさんの要素が影響しあっている関係を分析する「重回帰分析」という手法に、「L1正則化」という方法を使ったものです。L1正則化とは、分析の目的となる関数に、分析に使う要素の重みの絶対値の合計(マンハッタン距離)を足すことで、重みを調整する方法です。この方法を使うと、他のデータから大きく外れた一部のデータの影響をなくすことができるため、データのまばらさを調整することができます。しかし、この方法は微分できないため、計算で直接答えを求めることができないという欠点もあります。

ラッソ回帰とは

ラッソ回帰は、統計学や機械学習の分野で予測モデルを作る際に使われる有力な方法です。特に、たくさんの変数が関係する状況で力を発揮します。この方法は、重回帰分析という手法に「L1正則化」と呼ばれる特別な工夫を加えることで、モデルを単純化し、過剰な学習を防ぎ、分かりやすい結果を得ることを目指します。

普通の重回帰分析では、全ての変数に何かしらの重みをつけて予測を行います。しかし、変数が多すぎると、モデルがデータの細かいノイズまで学習してしまい、まだ知らないデータに対する予測の正確さが落ちてしまうことがあります。例えるなら、複雑な計算式を覚えるのに一生懸命になりすぎて、基本的な問題が解けなくなってしまうようなものです。

ラッソ回帰はこの問題を解決するために、必要のない変数の重みをゼロに近づけます。つまり、モデルから実質的にその変数をなくしてしまうのです。これは、たくさんの材料の中から、本当に必要なものだけを選んで料理を作るようなものです。シンプルながらも美味しい料理、つまり効果的なモデルを作ることができるのです。この不要な変数を排除する特性は「疎性」と呼ばれ、ラッソ回帰の大きな長所の一つです。

ラッソ回帰を使うことで、モデルが複雑になりすぎるのを防ぎ、予測の正確さを高めることができます。また、どの変数が重要なのかが分かりやすくなるため、分析結果の解釈もしやすくなります。そのため、様々な分野で活用されています。

| 項目 | 説明 |

|---|---|

| 手法 | ラッソ回帰 (L1正則化を用いた重回帰分析) |

| 目的 | 予測モデルの構築 (特に多変数の場合に有効) |

| 効果 | モデルの単純化、過剰学習の防止、分かりやすい結果の獲得 |

| 課題(重回帰分析) | 変数が多すぎる場合、ノイズまで学習し、未知データへの予測精度が低下 |

| ラッソ回帰の解決策 | 不要な変数の重みをゼロに近づける (疎性) |

| メリット | 予測精度の向上、重要な変数の特定、解釈の容易化 |

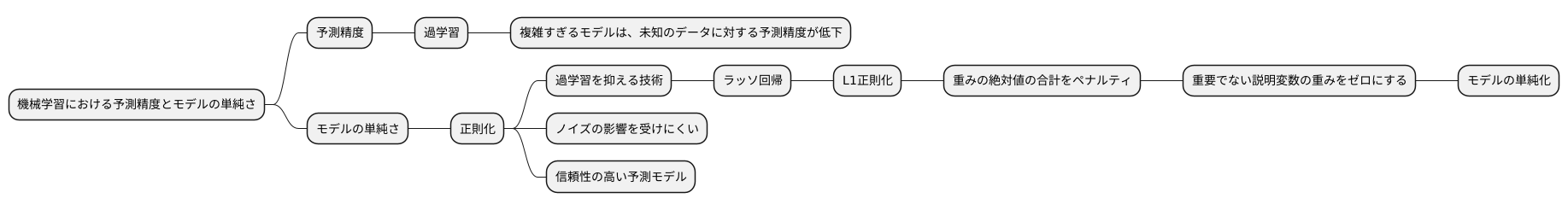

正則化の役割

予測の正確さとモデルの単純さは、機械学習において重要な二つの要素です。複雑すぎるモデルは、学習に使ったデータの細かい特徴にまで過剰に適合してしまい、未知のデータに対する予測精度が下がることがあります。これを過学習と呼びます。この過学習を防ぎ、予測能力を高める手法の一つに、正則化があります。正則化とは、モデルの複雑さにペナルティを科すことで、過学習を抑える技術です。ラッソ回帰では、L1正則化という方法を用います。

ラッソ回帰の仕組みを見ていきましょう。ラッソ回帰は、基本的には重回帰分析とよく似ています。重回帰分析では、目的変数(予測したい値)と説明変数(予測に使う変数)の関係を、直線または超平面で表現します。この直線や超平面を決めるのが、各説明変数に対応する重みです。ラッソ回帰では、この重みを調整することで、予測精度を高めます。しかし、単に予測精度だけを追求すると、過学習が起こりやすくなります。そこで、ラッソ回帰では重みの絶対値の合計をペナルティとして加えます。これがL1正則化です。

このペナルティがどのように働くか考えてみましょう。重みの絶対値が大きいほど、ペナルティも大きくなります。そのため、ラッソ回帰は、重みをなるべく小さくしようとします。結果として、重要でない説明変数の重みはゼロになり、モデルから排除されます。つまり、本当に必要な変数だけが残るため、モデルは単純になります。

ラッソ回帰は、このL1正則化を用いることで、過学習を抑えつつ、重要な変数を自動的に選択する効果があります。これは、データの中にノイズ(誤差や無関係な情報)が多く含まれる場合に特に有効です。ノイズの影響を受けにくく、本質的な関係を捉えた、より信頼性の高い予測モデルを作ることができるのです。このように、正則化は、モデルの精度と安定性を高めるために重要な役割を果たします。

スパース性の利点

まばらなデータ、つまり多くの部分がゼロであるデータの特性を活用する考え方を「まばら性」と呼びます。このまばら性は、ラッソ回帰といった特定の手法でモデルを構築する際に大きな利点をもたらします。

まず、まばら性によってモデルが簡素化されます。多くの変数の重みがゼロになることで、モデルに関わる変数の数が減り、理解しやすくなります。通常の回帰分析では、全ての変数がモデルに含まれるため、変数間の関係が複雑になりがちです。しかし、まばら性を持つモデルでは、本当に重要な変数だけが残り、それらの変数と結果の関係に集中して分析することができます。どの変数が結果に大きく影響し、どの変数が影響しないかが明確になるため、分析結果を基にした意思決定の質が向上します。

次に、計算にかかる手間や時間が削減されます。重みがゼロになった変数は、以降の計算から省くことができます。そのため、計算の負担が軽くなり、処理速度が向上します。これは、特に変数の数が非常に多い高次元データの処理において、大きな効果を発揮します。膨大な量のデータを扱う場合、計算時間の短縮は分析全体の効率を大きく左右します。

さらに、まばら性によってモデルの過学習が抑えられます。過学習とは、学習データに過度に適合しすぎてしまい、未知のデータに対する予測精度が低下する現象です。まばら性を持つモデルは、不要な変数を排除することで、学習データの細かなノイズにまで適合することを防ぎます。結果として、学習データだけでなく、未知のデータに対しても高い予測精度を維持できる、より信頼性の高い予測モデルを構築することができます。

このように、まばら性を活用したラッソ回帰などは、解釈の容易さ、計算コストの削減、そして過学習の抑制といった多くの利点をもたらし、データ分析において強力な手法となります。

| まばら性の利点 | 詳細 |

|---|---|

| モデルの簡素化 |

|

| 計算コストの削減 |

|

| 過学習の抑制 |

|

微分可能性と計算方法

微分というのは、ある関数の変化の割合を表す重要な概念です。滑らかな曲線で表される関数は、どの点でも微分できます。つまり、どの点でも接線を引くことができ、その傾きによって変化の割合を測ることができます。しかし、全ての関数が滑らかな曲線で表されるわけではありません。例えば、尖った点を持つ関数や、ある点で値が急に飛ぶような関数などは、その点で微分することができません。

ラッソ回帰と呼ばれる手法は、統計学や機械学習の分野でよく用いられる強力な道具です。この手法は、データから有用な情報を抽出したり、将来の予測を行う際に役立ちます。ラッソ回帰では、「L1正則化」と呼ばれる特殊な処理が用いられます。この処理は、モデルの複雑さを抑え、過剰適合と呼ばれる問題を防ぐ効果があります。しかし、このL1正則化には、微分できない点が存在するという問題があります。

L1正則化には絶対値が含まれています。絶対値を含む関数は、ゼロにおいて尖った点を持つため、この点で微分できません。そのため、通常の微分を用いる手法では、ラッソ回帰の最適な解を見つけることができません。しかし、この問題を解決するために、様々な計算方法が開発されています。例えば、座標降下法は、複数ある変数を一つずつ順番に最適化していく方法です。また、近接勾配法は、微分できない点の近傍で、微分可能な関数で近似することで最適化を行う方法です。

これらの手法を用いることで、微分できない点が存在しても、ラッソ回帰を効果的に利用することができます。これらの手法は、繰り返し計算を行うことで最適な解に近づいていきます。このように、微分できないという問題は、ラッソ回帰の利用を妨げるものではありません。様々な工夫によって、ラッソ回帰はデータ分析において、なくてはならない手法となっています。

| 手法 | 説明 | 利点 | 欠点 |

|---|---|---|---|

| ラッソ回帰 | 統計学や機械学習で用いられる。L1正則化を用いて過剰適合を防ぐ。 | モデルの複雑さを抑え、過剰適合を防ぐ。 | L1正則化に微分できない点が存在する。 |

| 座標降下法 | 複数ある変数を一つずつ順番に最適化していく方法。 | 微分できない点があっても最適化が可能。 | 変数の数が多い場合、計算に時間がかかる。 |

| 近接勾配法 | 微分できない点の近傍で、微分可能な関数で近似することで最適化を行う方法。 | 微分できない点があっても最適化が可能。 | 近似の精度によっては、最適解にたどり着かない可能性がある。 |

他の手法との比較

多くの予測手法の中で、過学習を抑えつつ精度の高い予測を実現する手法が求められています。その有力な候補として、ラッソ回帰とリッジ回帰という二つの手法が挙げられます。どちらも正則化という考え方に基づき、モデルの複雑さを調整することで過学習を防ぎます。

ラッソ回帰はL1正則化を用いる手法です。これは、モデルのパラメータの絶対値の和をペナルティとして加えることを意味します。このペナルティにより、重要度の低い変数の重みはゼロになり、結果としてモデルが単純化されます。つまり、ラッソ回帰は変数選択の機能も兼ね備えていると言えるでしょう。不要な変数を排除することで、モデルの解釈性を高める効果も期待できます。

一方、リッジ回帰はL2正則化を用います。これは、モデルのパラメータの二乗の和をペナルティとして加えることを意味します。リッジ回帰も過学習を防ぐ効果がありますが、ラッソ回帰とは異なり、変数の重みを完全にゼロにするわけではありません。つまり、全ての変数がモデルに残ることになります。

ラッソ回帰は、説明変数の数が多く、その中に本当に必要な変数が少ない場合に特に有効です。例えば、遺伝子発現データや画像データの解析などが挙げられます。このような高次元データでは、多くの変数がノイズとして働き、モデルの精度を低下させる可能性があります。ラッソ回帰を用いることで、ノイズとなる変数を排除し、真に重要な変数のみを用いた精度の高い予測モデルを構築できます。

データの特性や解析の目的に合わせて適切な手法を選択することが重要です。変数選択と予測の両方を同時に行いたい場合はラッソ回帰が、全ての変数を考慮に入れて予測精度を上げたい場合はリッジ回帰が適していると言えるでしょう。それぞれの正則化手法の特徴を理解し、データに合わせて使い分けることで、より効果的な分析が可能となります。

| 手法 | 正則化 | ペナルティ | 変数選択 | 特徴 | 適用例 |

|---|---|---|---|---|---|

| ラッソ回帰 | L1正則化 | パラメータの絶対値の和 | ○ | 重要度の低い変数の重みをゼロにする モデルの解釈性向上 |

遺伝子発現データ、画像データなど 説明変数の数が多い場合 |

| リッジ回帰 | L2正則化 | パラメータの二乗の和 | × | 変数の重みを完全にゼロにはしない 全ての変数を考慮 |

全ての変数を考慮に入れて予測精度を上げたい場合 |

実用例

ラッソ回帰は、様々な分野で活用されている強力な統計手法です。その応用範囲は広く、例えば金融、医療、販売促進など、多岐にわたります。

金融の世界では、ラッソ回帰は資産の組み合わせを最適化したり、リスクを管理するために使われています。多数の投資対象の中から、リスクを抑えつつ利益を最大化する組み合わせを見つける際に、ラッソ回帰は有効な手段となります。また、市場の変動を予測し、将来のリスクを事前に見積もるためにも役立ちます。

医療分野では、病気の診断や治療効果の予測にラッソ回帰が貢献しています。患者の様々な検査データや症状から、病気を特定したり、治療の効果を予測することで、より適切な医療を提供することが可能になります。例えば、ある病気にかかるリスクが高い人を特定し、早期の治療や予防につなげることができます。

販売促進の分野では、顧客の購買行動を分析したり、将来の売上を予測するためにラッソ回帰が利用されています。顧客の属性や過去の購買履歴から、どのような商品が売れそうかを予測し、効果的な販売戦略を立てることができます。また、顧客一人ひとりに合わせたお勧め商品を提示することで、顧客満足度を高めることも可能です。

これらの応用例は、ラッソ回帰が持つ二つの大きな特徴を示しています。一つは、重要な要素を選び出す力です。もう一つは、精度の高い予測を行う力です。近年、扱うデータの規模がますます大きくなってきており、このような状況下では、ラッソ回帰のような手法の重要性がさらに高まっています。ラッソ回帰は、複雑なデータの中から本質を見抜き、未来を予測するための不可欠な道具と言えるでしょう。

| 分野 | ラッソ回帰の活用例 |

|---|---|

| 金融 | 資産の組み合わせ最適化、リスク管理、市場変動予測 |

| 医療 | 病気の診断、治療効果予測、リスクの高い人の特定 |

| 販売促進 | 顧客の購買行動分析、売上予測、効果的な販売戦略立案、顧客への商品推奨 |