L0正則化:モデルの複雑さを制御する

AIを知りたい

先生、「L0正則化」って、パラメータをなるべくゼロにすることで過学習を防ぐ方法ですよね?でも、何か計算が大変だって聞いたんですけど、どうしてですか?

AIエンジニア

そうだね、ゼロにするパラメータを選ぶことで過学習を防ぐんだ。計算が大変なのは、パラメータをゼロにするかどうかの組み合わせを全部試さないといけないからだよ。例えば、パラメータが3つある場合、それぞれゼロにするかしないかで2×2×2=8通りの計算が必要になる。パラメータが増えると、組み合わせが爆発的に増えて計算量が膨大になってしまうんだ。

AIを知りたい

なるほど。じゃあ、パラメータが多いと、全部の組み合わせを試すのは現実的じゃないってことですね。他に何か簡単に計算する方法はないんですか?

AIエンジニア

その通り。だから、L0正則化と似たような効果がありつつ、計算しやすいL1正則化やL2正則化がよく使われるんだ。これらの方法は、パラメータを完全にゼロにするのではなく、ゼロに近づけることで、L0正則化と似た効果を得られるんだよ。

L0正則化とは。

人工知能分野で使われる言葉に「L0正則化」というものがあります。これは、学習モデルが、すでに知っているデータだけに最適化されすぎて、新しいデータに対応できなくなることを防ぐための工夫の一つです。通常、正則化では、モデルの誤差と正則化項と呼ばれる値の合計を最小にするように調整します。L0正則化の特徴は、この正則化項が、モデルのパラメータのうち、値が0でないものの個数で表されることです。つまり、0でないパラメータが多いほど、正則化項の値が大きくなり、モデルの誤差に大きなペナルティが加算されます。ただし、この方法では、パラメータの値が0になるものをあらかじめ知っておく必要があり、さらに、パラメータを少しだけ変えたときの正則化項の変化を計算することができません。そのため、最適なパラメータを見つけるための計算量が非常に大きくなってしまうという欠点があります。

正則化とは

機械学習では、学習に使ったデータにぴったり合いすぎて、新しいデータへの予測がうまくいかないことがあります。ちょうど、試験の過去問だけを丸暗記して、似たような問題しか解けないような状態です。これを過学習と呼びます。この過学習を防ぐための大切な技術が、正則化です。

正則化とは、モデルの複雑さを抑えることで、未知のデータに対しても適切に予測できるようにする技術です。例えるなら、複雑な計算式を使うよりも、単純な計算式の方が新しい問題にも応用しやすいのと同じです。

具体的には、損失関数という指標に正則化項を付け加えます。損失関数とは、モデルの予測と実際の値とのずれ具合を表すものです。このずれが小さいほど、モデルの精度は高いと言えます。この損失関数を小さくすることで、モデルの精度を上げていくわけです。

正則化項は、モデルの複雑さを表す指標で、モデルのパラメータの大きさに関係します。パラメータとは、モデルの性質を決める様々な数値のことです。これらの数値が大きすぎると、モデルは複雑になりすぎてしまいます。

正則化項を損失関数に加えることで、モデルは損失関数を小さくすることと同時に、パラメータの値も小さくしようとします。例えるなら、問題を解くための計算式をなるべく簡単なものにするように促すようなものです。結果として、モデルは複雑になりすぎず、過学習を防ぎ、新しいデータに対しても高い予測精度を保つことができるようになります。まるで、基本的な考え方を理解することで、様々な応用問題にも対応できるようになるのと同じです。

このように、正則化は機械学習において、モデルの汎化性能を高めるための重要な役割を果たしています。

L0正則化の仕組み

L0正則化とは、機械学習モデルをより簡素化し、性能を高めるための手法です。具体的には、モデルを構成する無数の数値、いわゆる「係数」の中で、ゼロでないものの数を減らすことで実現します。このゼロでない係数の数が、モデルの複雑さを示す指標となり、これを「正則化項」と呼びます。正則化項を小さく、すなわちゼロでない係数を少なくすればするほど、モデルは単純になります。

L0正則化の目的は、モデルの「まばらさ」を向上させることにあります。「まばらさ」とは、係数の大部分がゼロである状態を指します。係数の多くがゼロになることで、モデルがどの情報に重点を置いているかが明確になり、理解しやすくなります。例えば、たくさんの品物の価格を予測するモデルを考えてみましょう。L0正則化を適用することで、価格に影響を与える少数の重要な要素、例えば材料費や人件費のみが選択され、それ以外の要素の係数はゼロになります。このように、L0正則化は、本当に必要な情報だけを選び取る役割を果たします。

この特性は、画像認識の分野でも役立ちます。例えば、画像の中から猫を見つけるモデルを学習させる場合、L0正則化によって猫の特徴を表す少数の要素、例えば耳や目の形、ひげなどに係数が集中し、それ以外の背景などは無視されるようになります。つまり、画像のどの部分が猫の認識に重要なのかを特定できるのです。

さらに、L0正則化は「特徴選択」にも利用されます。特徴選択とは、膨大なデータの中から、予測に役立つ重要な特徴だけを選び出す手法です。L0正則化を適用することで、不要な特徴に対応する係数がゼロになり、必要な特徴だけが残ります。これにより、モデルの計算量が減り、処理速度が向上するだけでなく、予測の精度も高まります。つまり、L0正則化は、モデルをより軽く、より賢くするための強力な道具と言えるでしょう。

| 項目 | 説明 | 例 |

|---|---|---|

| L0正則化 | 機械学習モデルを簡素化し、性能を高める手法。ゼロでない係数の数を減らすことでモデルの複雑さを低減。 | – |

| 正則化項 | ゼロでない係数の数。モデルの複雑さを示す指標。 | – |

| まばらさ | 係数の大部分がゼロである状態。モデルがどの情報に重点を置いているかを明確化。 | – |

| 価格予測モデル | L0正則化適用例。材料費や人件費など、価格に影響を与える少数の重要な要素のみが選択され、それ以外の要素の係数はゼロになる。 | 品物の価格予測において、材料費、人件費等の係数は大きく、その他はゼロ。 |

| 画像認識 | L0正則化適用例。猫の認識において、耳、目、ひげ等の係数は大きく、背景等はゼロ。 | 猫の画像認識において、耳、目、ひげ等の係数は大きく、背景等はゼロ。 |

| 特徴選択 | 膨大なデータの中から、予測に役立つ重要な特徴だけを選び出す手法。L0正則化を適用することで、不要な特徴に対応する係数がゼロになる。 | – |

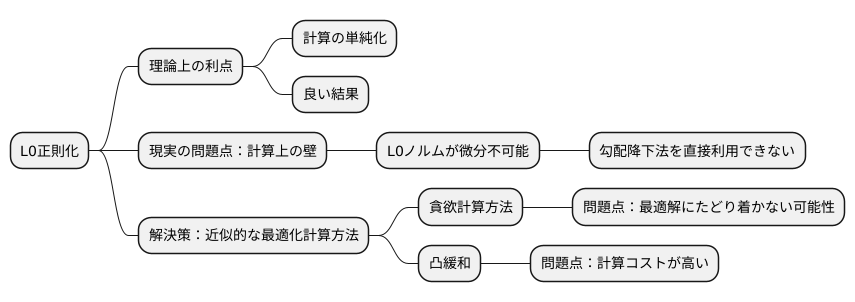

計算上の課題

計算の世界では、理想と現実はしばしば一致しません。例えば、ある計算方法は理論上は大変優れているものの、実際に使おうとすると様々な問題に直面することがあります。L0正則化と呼ばれる計算方法も、まさにそのような例の一つです。

L0正則化は、計算を単純化し、より良い結果を得るための強力な手法です。しかし、この手法には大きな計算上の壁があります。それは、L0正則化で使われるL0ノルムというものが、微分不可能であるという点です。

微分というのは、ある瞬間の変化量を表すもので、多くの計算方法で重要な役割を果たします。例えば、勾配降下法と呼ばれる手法は、この微分を利用して、目的とする値を最小化する最適な解を見つけ出します。この勾配降下法は、いわば山の斜面を下るように、少しずつ最適な値へと近づいていく方法です。しかし、L0ノルムは、値が0付近で微分不可能、つまり斜面が急に切り立つ崖のようになっているため、この勾配降下法を直接使うことができません。

そのため、L0正則化を使うためには、別の工夫が必要になります。具体的には、近似的な最適化計算方法を用いることになります。例えば、貪欲計算方法や凸緩和といった手法が知られています。貪欲計算方法は、その時点での最良の選択を繰り返す方法で、必ずしも最終的に最適な解にたどり着くとは限りません。凸緩和は、複雑な問題を単純な問題に変換することで解を見つけやすくする手法ですが、計算に多くの時間と資源を必要とします。

このように、L0正則化は理論上は優れた手法ですが、実際に使うためには、計算上の課題を克服するための近似的な手法を用いる必要があります。そして、これらの近似的計算方法は、必ずしも最適な解を保証するものではなく、計算にも多くのコストがかかるという限界を抱えています。

代替手法

まばらなデータを用いた効果的な計算を行うためには、不要な情報を削ぎ落とすことが重要です。この不要な情報を取り除くための手法の一つに、L0正則化というものがあります。これは、モデルに含まれるパラメータの数を減らすことで、データの持つ本質的な特徴を捉えようとするものです。しかし、L0正則化は計算の複雑さが高く、最適な解を見つけるのが難しいという課題があります。

そこで、L0正則化の代わりに、より計算しやすい手法がいくつか提案されています。その代表的なものが、L1正則化とL2正則化です。L1正則化は、パラメータの絶対値の合計を小さくすることで、いくつかのパラメータをゼロにします。これは、まるで不要な情報を切り捨てるかのように、モデルを単純化し、重要な情報だけを残す効果があります。また、L1正則化は微分可能であるため、勾配降下法などの一般的な最適化手法を用いて効率的に計算することができます。

一方、L2正則化は、パラメータの二乗の合計を小さくすることで、全てのパラメータをゼロに近づけます。これは、各パラメータの影響を小さくすることで、モデルの複雑さを抑える効果があります。L2正則化も微分可能であり、最適化が容易です。L1正則化のように特定のパラメータを完全にゼロにするわけではありませんが、パラメータの値を全体的に小さくすることで、モデルの過学習を防ぎ、より安定した予測結果を得ることができます。

L1正則化とL2正則化は、どちらもL0正則化に比べて計算コストが低く、最適な解を見つけやすいという利点があります。そのため、データの特性や計算資源に合わせて、これらの手法を使い分けることが、効果的なデータ分析を行う上で重要です。どの手法を選ぶかは、解析の目的やデータの性質によって異なります。例えば、本当に重要な情報だけを選び出したい場合はL1正則化が適しています。一方、全ての情報をバランス良く考慮したい場合はL2正則化が適しています。それぞれの特性を理解し、適切な手法を選択することで、より精度の高い分析が可能になります。

| 正則化手法 | 目的 | 効果 | 計算コスト | 最適化手法 |

|---|---|---|---|---|

| L0正則化 | パラメータ数を削減 | データの本質的特徴を捉える | 高い | 難しい |

| L1正則化 | パラメータの絶対値の合計を最小化 | 不要なパラメータをゼロにする モデルの単純化 |

低い | 勾配降下法等 |

| L2正則化 | パラメータの二乗の合計を最小化 | 全てのパラメータをゼロに近づける モデルの複雑さを抑制 過学習を防ぐ |

低い | 勾配降下法等 |

適用事例

様々な分野で活用されているL0正則化は、データに含まれる情報のうち、本当に必要な情報だけを選び出すことで、モデルの性能を高める技術です。具体的には、画像処理、信号処理、自然言語処理といった分野で応用されています。

まず、画像処理の分野では、画像に含まれる不要な情報を減らすノイズ除去や、データ量を小さくする画像圧縮などにL0正則化が利用されます。写真に写り込んだゴミやノイズは、本来の画像情報には不要な情報です。L0正則化を用いることで、これらのノイズを効果的に除去し、より鮮明な画像を得ることができます。また、画像を構成する情報の中で、重要度の低い情報を削除することで、データ量を圧縮し、保存や転送を効率化できます。

次に、信号処理の分野では、信号を少ない情報で表現するスパース表現にL0正則化が役立ちます。音声や電波などの信号は、多くの情報を含んでいますが、その中には冗長な情報も含まれています。L0正則化を用いることで、本当に必要な情報だけを選び出し、信号を簡潔に表現することが可能になります。これは、通信に必要なデータ量を減らすなど、様々な応用につながります。

最後に、自然言語処理の分野では、文章の分類や機械翻訳といったタスクにL0正則化が利用されます。例えば、文章を特定のカテゴリに分類する際、文章に含まれる全ての単語が分類に役立つわけではありません。L0正則化を用いることで、分類に重要な単語だけを選び出し、モデルの精度を高めることができます。同様に、機械翻訳においても、文の意味を決定づける重要な単語を特定することで、より正確な翻訳結果を得ることが可能になります。このように、L0正則化は、様々な分野でデータの持つ真の価値を引き出す強力な手法として活用されています。

| 分野 | 応用例 | 効果 |

|---|---|---|

| 画像処理 | ノイズ除去、画像圧縮 | 鮮明な画像、データ量の削減 |

| 信号処理 | スパース表現 | データ量の削減、通信効率向上 |

| 自然言語処理 | 文章分類、機械翻訳 | モデル精度向上、翻訳精度向上 |

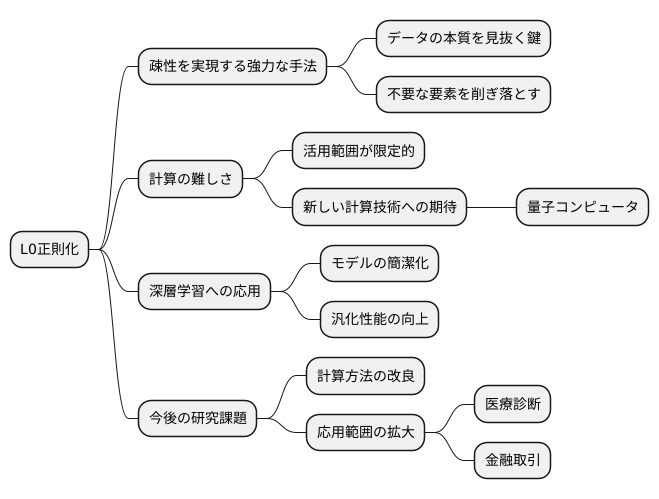

今後の展望

無駄を省いた簡潔な表現を好む性質、すなわち「疎性」は、近年の情報化社会において、膨大なデータの中から本質を見抜く鍵として大変重要です。この疎性を効果的に作り出す手法の一つに、L0正則化があります。L0正則化は、データの表現において、本当に必要な要素だけを選び出し、不要な要素を削ぎ落とす強力な方法です。しかし、その効果の高さの一方で、計算の難しさが大きな壁となっています。

この計算上の難しさから、L0正則化は、まだ限られた範囲でしか活用されていません。しかし、その潜在能力の高さから、様々な分野での応用が期待されています。特に、人間の脳を模倣した複雑な仕組みを持つ深層学習の分野では、L0正則化は大きな期待を集めています。深層学習は、時に複雑になりすぎて、なぜそのような結果が出たのかを理解することが困難になります。L0正則化を用いることで、モデルを簡潔化し、その中身を理解しやすくすることが期待されます。また、学習データだけでなく、未知のデータに対しても高い精度で予測できる能力、すなわち汎化性能の向上も期待できます。

今後の研究では、L0正則化をより使いやすくするための計算方法の改良が重要な課題となります。現在、様々な計算方法が提案されていますが、どれも計算時間がかかってしまうという問題を抱えています。そこで、全く新しい計算技術に注目が集まっています。例えば、量子コンピュータは、従来のコンピュータでは不可能だった計算を高速で行うことができると期待されており、L0正則化の計算を劇的に速くできる可能性を秘めています。

また、L0正則化の応用範囲を広げることも、今後の重要な研究テーマです。医療診断の分野では、病気の兆候を早期に発見するための正確な予測モデルの構築に役立つ可能性があります。金融取引の分野では、市場の動きを正確に予測し、リスクを最小限に抑えるための投資戦略の立案に役立つ可能性があります。このように、L0正則化は、様々な分野で未来を予測し、より良い判断を行うための強力な道具となる可能性を秘めています。今後、L0正則化は更なる発展を遂げ、社会に大きく貢献していくことでしょう。