AIの解釈:ブラックボックスを開く鍵

AIを知りたい

先生、「モデルの解釈」ってなんですか?難しそうでよくわからないです。

AIエンジニア

そうだね、少し難しい概念だね。簡単に言うと、AIがなぜそのような答えを出したのか、その理由を説明できるようにすることだよ。例えば、AIが画像を見て「これは猫です」と答えた時、なぜ猫だと判断したのか、その根拠を明らかにするのが「モデルの解釈」なんだ。

AIを知りたい

なるほど。AIが判断した理由がわかるようにするってことですね。でも、どうしてそんなことをする必要があるんですか?

AIエンジニア

いい質問だね。例えば、医療の分野でAIが「この患者さんは病気です」と診断したとする。でも、AIがなぜそう判断したのかわからなければ、お医者さんはその診断結果を信用して治療に踏み切れないよね?だから、AIの判断根拠を明らかにすることは、AIを様々な分野で安全に活用するためにとても重要なんだよ。

モデルの解釈とは。

人工知能にまつわる言葉で「どのように考えて答えを出したのかを説明する」という意味の「モデルの解釈」について説明します。人工知能、特に深層学習と呼ばれる技術は、様々な分野で応用できる便利な道具ですが、どのように答えを導き出したのかが分かりにくいという欠点があります。例えるなら、中身の見えない黒い箱のようなものです。特に医療の分野などでは、なぜそのような判断をしたのかを説明できない限り、実際に現場で使ってもらうことは難しいです。そこで、人工知能がどのように考えて答えを出したのかを、Grad-CAMのような技術を使って分かりやすく示す研究が行われています。この研究分野は「説明できる人工知能」と呼ばれています。

解釈の必要性

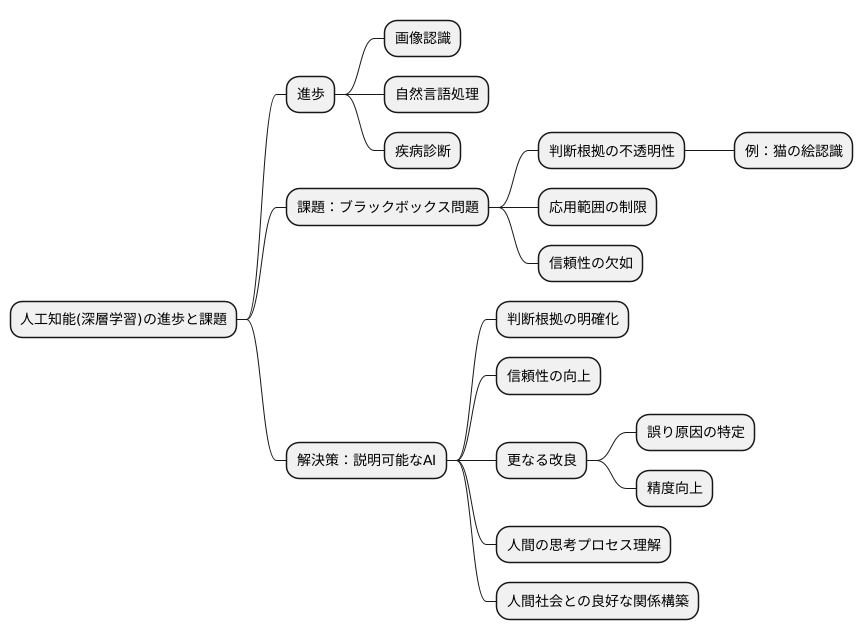

近頃、人工知能、中でも深く学ぶ技術は目覚しい進歩を遂げ、様々な場所で活用されています。例えば、絵を見て何かを判断する、人の言葉を理解する、病気を見つけるといった具合です。こうした技術は、私たちの暮らしにもどんどん入り込んで来ています。しかし、その高い精度の裏には、大きな問題が隠されています。それは、深く学ぶ仕組みの中身が複雑すぎて、なぜそのような予測や判断をしたのか、人が理解しにくいという点です。例えるなら、ある機械が絵を見て「猫」と判断したとして、なぜ「猫」だと思ったのか、その理由をはっきり示すことが難しい、といった具合です。この分かりにくさは「ブラックボックス」と呼ばれ、深く学ぶ技術の応用範囲を狭めています。

特に、病気の診断や自動で車を運転するといった、人の命に関わる分野では、人工知能がなぜそう判断したのかを明らかにすることがとても大切です。間違った判断は、取り返しのつかない結果に繋がりかねません。だからこそ、人工知能の判断の過程を分かりやすく示し、信頼性を高める必要があります。人工知能の判断の理由を説明する技術は、このブラックボックス問題を解決するための重要な鍵となります。深く学ぶ仕組みは多くの層が複雑に絡み合っており、その中でどのような情報処理が行われているのかを理解するのは容易ではありません。しかし、判断の根拠を理解することは、人工知能の信頼性を高めるだけでなく、更なる改良にも繋がります。例えば、誤った判断の原因を特定することで、より精度の高い人工知能を開発することが可能となります。また、人工知能がどのように物事を判断しているのかを理解することは、私たち自身の思考プロセスを理解するヒントにもなるかもしれません。人工知能の解釈技術は、人工知能と人間社会がより良い関係を築くためにも、今後ますます重要になっていくでしょう。

解釈の方法

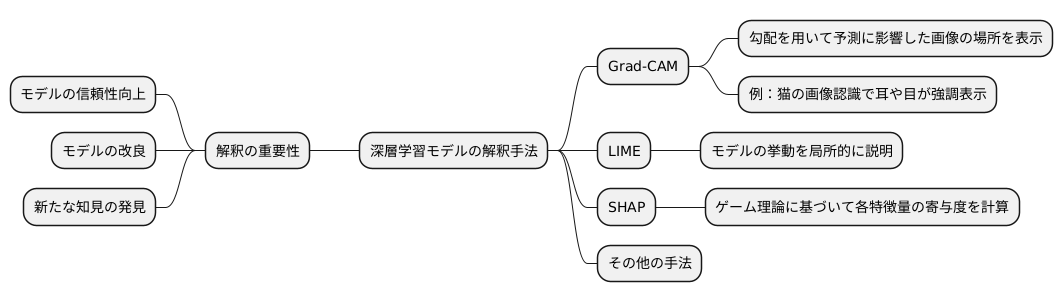

近年の技術革新により、深層学習モデルは目覚ましい成果を上げてきました。しかし、その複雑な構造ゆえに、どのように予測を行っているのかを理解することは難しいという課題も抱えています。この、モデルの予測根拠を明らかにする作業を「解釈」と呼び、様々な手法が開発されています。

数ある解釈手法の中でも、Grad-CAMは代表的な手法の一つです。Grad-CAMは、「勾配」と呼ばれる情報を用いて、予測に大きく影響した画像の場所を分かりやすく表示する手法です。具体的には、まずモデルの出力結果に対する、入力画像の各場所ごとの影響度を勾配として計算します。次に、その勾配の情報を画像の各場所に反映させることで、どの部分が予測に強く影響したかを視覚的に表現します。例えば、猫の画像認識の場合、Grad-CAMを用いると、猫の耳や目といった特徴的な部分が強調表示されます。これは、モデルがそれらの部分を見て猫と判断したことを示唆しています。

Grad-CAM以外にも、様々な解釈手法が存在します。例えば、LIMEは、モデルの挙動を局所的に説明するという考えに基づいた手法です。また、SHAPは、ゲーム理論に基づいて各特徴量の寄与度を計算する手法です。これらの手法は、それぞれ異なるアプローチでモデルの内部構造を解き明かそうとしています。これらの手法を目的に合わせて適切に使い分ける、あるいは組み合わせることで、より多角的で深いモデルの解釈が可能になります。そして、モデルの解釈は、モデルの信頼性向上や改良、更には新たな知見の発見につながるため、今後の深層学習の発展において非常に重要な役割を担うと考えられています。

説明可能なAI

近年、人工知能の分野で「説明可能な人工知能」、つまり「説明できる人工知能」という考え方が注目を集めています。この「説明できる人工知能」とは、人工知能がどのように考えて答えを出したのか、その理由を人間が理解できるように説明できるようにする研究分野です。

特に、深層学習という複雑な仕組みを持つ人工知能は、まるで中身の見えない箱のように扱われてきました。その判断の過程がわかりにくいため、どんなに優れた答えを出しても、本当に信頼できるのかどうか不安が残るという問題がありました。「説明できる人工知能」は、この問題を解決し、人工知能の信頼性を高める上で、とても重要な役割を担っています。

「説明できる人工知能」を作るには、大きく分けて二つの方法があります。一つは、既に存在する複雑な人工知能に対して、その考え方を分析し、判断の根拠を明らかにする手法です。これは、例えるなら、優秀な職人が作った複雑な機械を分解して、その仕組みを理解しようとするようなものです。もう一つは、最初から分かりやすい仕組みを持つ人工知能を新たに設計する方法です。これは、最初から設計図を公開し、誰でも仕組みを理解できるように機械を作るようなものです。

前者は、既存の技術を活用できるという利点がありますが、解釈に限界がある場合もあります。後者は、根本的な解決策となりますが、性能の向上と分かりやすさの両立が難しいという課題があります。どちらの方法も重要であり、「説明できる人工知能」の更なる発展には、両方の研究を進めていく必要があります。

「説明できる人工知能」の研究が進めば、人工知能はより人間にとって理解しやすく、信頼できるものへと進化していくと考えられています。これにより、医療診断や自動運転など、様々な分野で人工知能の活用がより一層広がることが期待されています。そして、人間と人工知能がより良い関係を築き、共に発展していく未来へと繋がっていくでしょう。

| 説明できるAIとは | AIの思考過程と判断根拠を人間が理解できるようにする研究分野 |

|---|---|

| 必要性 | 深層学習等の複雑なAIの判断過程はブラックボックス化しており、信頼性の担保が課題 |

| 実現方法 |

|

| 各方法のメリット・デメリット |

|

| 今後の展望 |

|

応用分野

人工知能の判断理由を説明する技術、モデルの解釈は、様々な分野で活用が広がっており、人々の生活に深く関わってきています。特に、人の命に関わる医療診断や、大きな金額が動く金融取引といった、高い信頼性が求められる分野では、その重要性が日に日に増しています。

医療診断の分野では、人工知能が病気を診断する際、医師がその根拠を理解することは極めて重要です。人工知能による診断結果が信頼できるものかどうか、そしてどのような治療方針を立てるべきかを判断するためには、人工知能の判断の理由を理解することが欠かせません。例えば、画像診断で人工知能が特定の病変を指摘した場合、医師はその根拠となる画像の特徴を理解することで、診断の確からしさを判断し、適切な治療方針を決定することができます。人工知能が示す診断結果だけを見るのではなく、その裏付けとなる情報を得ることで、医師はより確信を持って治療にあたることが可能になります。

また、金融取引の分野においても、人工知能が投資判断を行う際、その根拠を理解することはリスク管理の観点から重要です。人工知能がなぜ特定の銘柄に投資すべきと判断したのか、その理由を理解することで、投資判断の妥当性を評価し、リスクを適切に管理することができます。もし、人工知能の判断根拠が市場の短期的な変動に基づくものであった場合、長期的な投資戦略には適さない可能性があります。このように、人工知能の判断根拠を理解することは、投資におけるリスクを最小限に抑え、より効果的な投資判断を行うために必要不可欠です。

このように、モデルの解釈技術は、人工知能の活用範囲を広げ、社会に貢献するための重要な技術となっています。人工知能がブラックボックスではなく、その判断過程が透明化されることで、人々は安心して人工知能を活用できるようになり、様々な分野での進歩が加速していくでしょう。

| 分野 | 重要性 | 人工知能の判断根拠の理解による利点 |

|---|---|---|

| 医療診断 | 人の命に関わるため、高い信頼性が求められる |

|

| 金融取引 | 大きな金額が動くため、リスク管理が重要 |

|

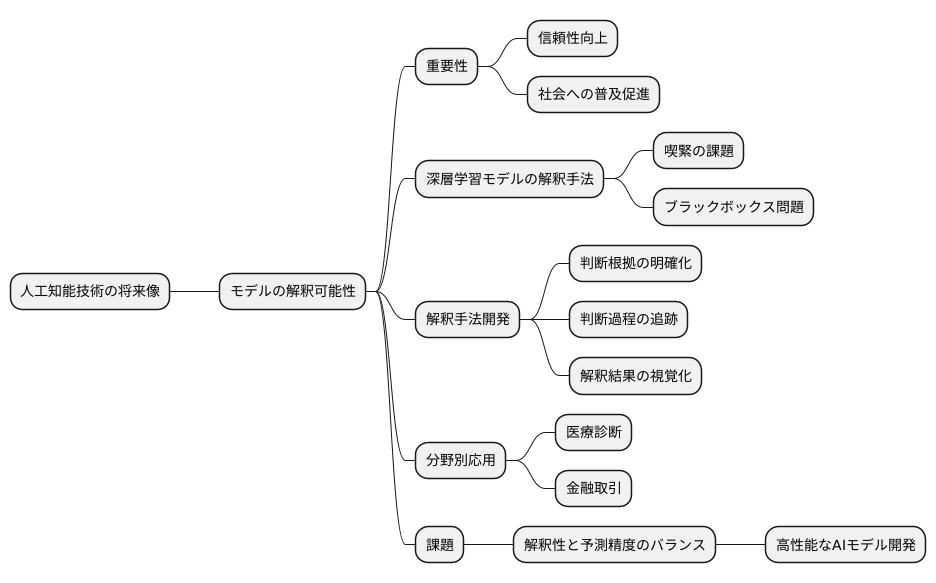

今後の展望

人工知能技術の将来像を考える上で、モデルの解釈可能性は極めて重要な要素となります。人工知能の研究開発は今後ますます活発化すると考えられますが、特に、複雑な構造を持つ深層学習モデルの解釈手法の確立は喫緊の課題です。現在用いられている深層学習モデルは、高度な予測能力を持つ反面、その内部構造が複雑で、なぜそのような予測結果に至ったのかを理解することが困難です。この「ブラックボックス」と称される状態は、人工知能技術への信頼性を損なう一因となっています。

今後、人工知能研究は、より正確な解釈手法の開発に重点が置かれるでしょう。具体的には、モデルが特定の判断を下した根拠を明確に示す技術や、その判断に至るまでの過程を段階的に追跡できる技術などが求められます。また、解釈結果を分かりやすく図示する技術の開発も重要です。複雑な数値データや数式を、誰もが一目で理解できる視覚的な情報に変換することで、人工知能の判断過程をより透明化することができます。

さらに、これらの解釈手法を様々な分野へ応用していくことも重要な課題です。医療診断や金融取引など、人の生活に大きな影響を与える分野では、人工知能の判断根拠を明確にすることが不可欠です。それぞれの分野に特化した解釈手法を開発することで、人工知能の社会実装を加速させることができます。

しかし、解釈性の追求と予測精度の向上は、しばしば相反する目標となります。一般的に、単純で解釈しやすいモデルは予測精度が低く、高精度な予測を行う複雑なモデルは解釈が困難になりがちです。この両者のバランスをどのように取るかが、今後の研究における大きな課題となるでしょう。解釈性と精度を両立させた、より高性能な人工知能モデルの開発が期待されています。

人工知能が人々の生活に深く浸透していくためには、技術への信頼性の確保が不可欠です。モデルの解釈技術の発展は、人工知能の信頼性を高め、社会への普及を促進する上で重要な役割を担っています。人々が安心して人工知能技術を利用できる社会を実現するために、今後ともモデルの解釈性向上に向けた研究開発が続けられるでしょう。