AIの解釈:信頼への架け橋

AIを知りたい

「モデルの解釈」ってよく聞くんですけど、難しそうでよくわからないです。簡単に教えてもらえますか?

AIエンジニア

そうですね。「モデルの解釈」とは、人工知能がどのように考えて答えを出したのか、その理由を人間が理解できるようにすることです。人工知能は複雑な計算をしているので、そのままではどうしてその結果になったのか分かりにくいことが多いんです。

AIを知りたい

なるほど。つまり、人工知能の思考過程を分かりやすく説明することですね。でも、どうしてそれが重要なんですか?

AIエンジニア

良い質問ですね。例えば、お医者さんが病気の診断に人工知能を使う場面を想像してみてください。人工知能が「この人は病気です」とだけ言っても、どうしてそう判断したのか分からなければ、お医者さんも患者さんも不安ですよね。そこで、「モデルの解釈」が重要になるんです。人工知能が「この人のレントゲン写真で、ここの部分が病気の兆候を示しているため、病気だと判断しました」と説明できれば、納得できますよね。特に医療や法律の分野では、判断の理由が大切なので、「モデルの解釈」が欠かせません。

モデルの解釈とは。

人工知能にまつわる言葉で「どのように考えているかを説明できる人工知能」というものがあります。人工知能を実際に役立てるには、人工知能がどのように考えているかを説明できるかどうかが大切です。人工知能は、普段中身が見えない箱のようなもので、なぜそういう答えを出したのかを人にわかるように説明するのが苦手です。たとえば、医療や裁判のような場面で人工知能を使うことを考えると、なぜそのような結論になったのかを説明できないと、みんなに納得してもらえないかもしれません。

解釈の必要性

近頃、人工知能(AI)は目覚しい進歩を遂げ、様々な場面で利用されるようになりました。しかし、AIがどのようにして答えを導き出したのか、その過程を理解することは難しい場合が多くあります。これは、AIが複雑な計算に基づいて判断を下すため、その過程が人間にとって分かりづらいからです。

特に、医療診断や金融取引といった、人々の暮らしに大きな影響を及ぼす分野では、AIの判断の理由を明らかにすることが非常に重要です。例えば、AIが特定の病気を診断した場合、医師はAIがどのような情報に基づいてその診断に至ったのかを知る必要があります。また、AIが融資を拒否した場合、顧客はAIがどのような基準で判断したのかを知る権利があります。もしAIの判断過程がブラックボックスのままでは、利用者はAIの判断を信頼することが難しく、安心して利用することができません。

AIの説明能力を高めるためには、いくつかの方法が考えられます。一つは、AIの判断過程を可視化する手法です。例えば、AIが画像認識を行う際に、どの部分に着目したのかを分かりやすく表示することで、人間がAIの判断根拠を理解しやすくなります。また、AIの判断に影響を与えた要因を分析する手法も有効です。例えば、融資審査において、収入や過去の借入状況など、どの要素がAIの判断に大きく影響したのかを分析することで、AIの判断の透明性を高めることができます。

AIの信頼性を高め、社会に広く受け入れられるようにするためには、AIの解釈性を向上させることが不可欠です。今後、AI技術の更なる発展と共に、AIの説明能力を高めるための研究開発がますます重要になっていくと考えられます。

| AIの課題 | 課題への対応策 | 期待される効果 |

|---|---|---|

| AIの判断過程が不透明(ブラックボックス)であるため、利用者がAIの判断を信頼しにくい。特に、医療診断や金融取引など、人々の暮らしに大きな影響を及ぼす分野では、AIの判断理由を明らかにすることが重要。 |

|

AIの信頼性向上、社会への普及促進 |

解釈手法

人工知能がどのように結論を導き出したのかを理解することは、信頼性確保のために重要です。そのため、様々な方法が開発されています。

まず、決定木を使う方法があります。決定木は、まるで樹形図のように、判断の過程を枝分かれで示してくれます。どの情報が判断に影響を与えたのかを、視覚的に追いかけることが容易です。例えば、ある人が融資を受けるかどうかの判断で、収入や年齢などの情報がどのように使われたのかが、一目で分かります。

また、数値で重要度を示す方法もあります。これは、判断に各情報がどれだけ影響を与えたのかを数値で示すものです。例えば、融資の判断では、収入が最も重要で、年齢はあまり重要ではない、といったことが数値で分かります。

さらに、入力情報を少し変えて、結果がどう変わるかを見る方法もあります。例えば、年齢を1歳変えると、融資の判断は変わるのか、変わらないのか。収入を少し変えるとどうなるのか。このように、入力の変化に対する出力の変化を見ることで、判断の仕組みをより深く理解できます。

これらの方法は、組み合わせて使うことで、より効果を発揮します。例えば、決定木で全体像を把握し、数値で重要度を確認した後、入力の変化による影響を調べることで、人工知能の判断根拠を多角的に理解できます。

最近では、これらの方法を自動で実行する道具も開発されています。そのため、人工知能の判断根拠を、誰でも簡単に調べられるようになってきています。これは、人工知能の信頼性を高め、より広く活用していく上で、大変重要な進歩です。

| 方法 | 説明 | 例 |

|---|---|---|

| 決定木 | 判断過程を樹形図のように表示し、どの情報が判断に影響を与えたかを視覚的に示す。 | 融資判断における収入や年齢の影響を視覚的に把握 |

| 数値による重要度表示 | 各情報が判断にどれだけ影響を与えたかを数値で示す。 | 融資判断において、収入の重要度が高いことを数値で確認 |

| 入力情報の変更による影響確認 | 入力情報を少し変えて結果がどう変わるかを確認する。 | 年齢や収入を少し変えた場合の融資判断への影響を分析 |

活用事例

人工知能の解釈性を高める技術は、様々な現場で活用され始めており、その応用範囲は広がりを見せています。

医療の現場では、人工知能による画像診断が実用化されつつありますが、診断結果だけでなく、その根拠を医師が理解することは、診断の正確さをより高める上で大変重要です。例えば、人工知能が特定の病気を診断した際に、画像のどの部分に着目したのかが分かれば、医師は自身の知識と経験に基づいてその判断の妥当性を評価し、必要に応じて追加の検査を行うことができます。これにより、見落としや誤診のリスクを減らし、より確かな診断へと繋げることができます。

金融業界においては、融資の審査を人工知能が担うケースが増えていますが、審査における透明性を高めるために、人工知能の判断根拠を明確にすることが求められています。例えば、融資を却下した場合、その理由が顧客の属性や過去の取引履歴のみに基づくのではなく、将来的な返済能力を予測するための様々な要因を考慮に入れたものであることを示す必要があります。人工知能の判断根拠が分かれば、顧客は納得感を得やすく、金融機関は説明責任を果たすことができます。

製造業においても、人工知能は製品の品質管理に役立っています。製品の欠陥を自動的に検出するだけでなく、不良品が発生した原因を特定することも可能です。例えば、人工知能が特定の部品の形状に異常があると判断した場合、その根拠となるデータを示すことで、製造工程における問題点を特定し、改善につなげることができます。これにより、不良品発生率の低減、生産効率の向上に繋がります。このように様々な分野で人工知能の解釈性は、その信頼性を高め、より実用的なものとするために重要な役割を担っています。

| 分野 | 人工知能の活用例 | 解釈性のメリット |

|---|---|---|

| 医療 | 画像診断 | 診断根拠の理解による診断精度の向上、見落としや誤診リスクの軽減 |

| 金融 | 融資審査 | 審査の透明性向上、顧客の納得感向上、金融機関の説明責任を果たせる |

| 製造業 | 製品の品質管理 | 不良品発生原因の特定、製造工程の改善、不良品発生率の低減、生産効率の向上 |

倫理的側面

人工知能が持つ説明責任は、倫理的な観点から見て大変重要です。人工知能がどのように結論を導き出したのかを理解することは、人工知能を正しく利用するために欠かせません。

例えば、人工知能が人の肌の色や性別といった特徴に基づいて不公平な判断を下した場合を考えてみましょう。このような差別的な判断がどのように行われたのかを解明できれば、その原因を取り除き、公正な判断が行われるように改善することができます。人工知能の説明責任を果たすことで、差別をなくし、誰もが平等に扱われる社会を実現することに繋がります。

また、自動運転技術においても、人工知能の説明責任は極めて重要です。もしも事故が起こってしまった場合、人工知能がどのような状況判断を行い、どのような行動をとったのかを明らかにすることで、事故の原因を究明し、再発防止策を講じることができます。さらに、事故の責任の所在を明確にする上でも、人工知能の説明責任は不可欠です。

人工知能は、医療診断や金融取引など、私たちの生活に深く関わっています。これらの分野においても、人工知能がどのように判断を下したのかを理解することは、利用者の信頼を得るために必要不可欠です。説明責任を果たすことで、人工知能に対する不安や不信感を払拭し、より安心して利用できる環境を築き上げることができます。

人工知能が社会に浸透するにつれて、その倫理的な側面はますます重要性を増しています。人工知能の説明責任を果たすことは、人工知能を正しく、安全に利用し、より良い社会を築くために欠かせない要素となるでしょう。

| 分野 | 説明責任の重要性 | 具体例 |

|---|---|---|

| 全般 | AIの結論導出過程の理解は、正しい利用に不可欠 | – |

| 倫理 | 差別的な判断の根拠を解明し、公正な判断を実現 | 肌の色や性別による不公平な判断 |

| 自動運転 | 事故原因の究明、再発防止策、責任所在の明確化 | 事故時の状況判断と行動の解明 |

| 医療診断・金融取引 | 利用者の信頼獲得、不安や不信感の払拭 | 判断根拠の理解 |

| 社会全体 | AIの正しい、安全な利用、より良い社会の実現 | – |

今後の展望

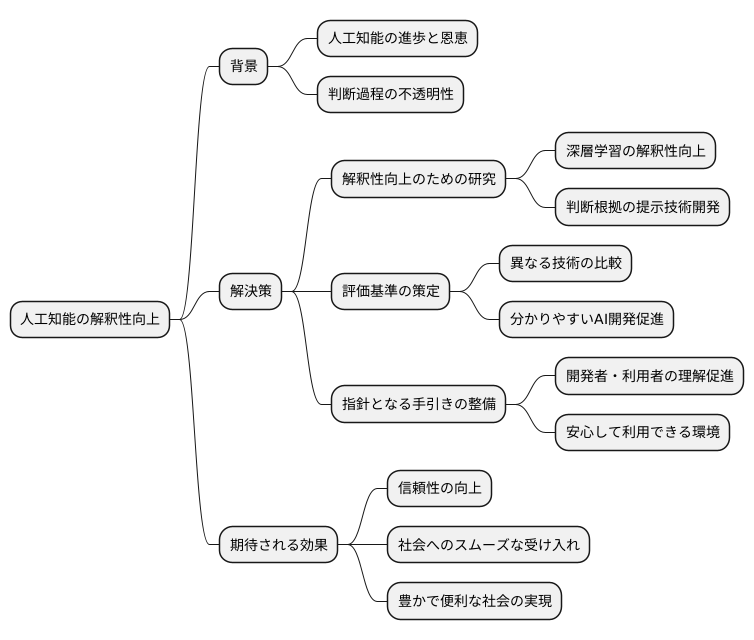

人工知能技術は目覚ましい進歩を遂げており、私たちの生活にも様々な恩恵をもたらしています。それと同時に、人工知能がどのように答えを導き出したのか、その過程が分かりにくいという問題も指摘されています。この問題を解決するために、人工知能の判断の根拠を明らかにする、いわゆる「解釈性」を高める研究が盛んに行われています。

特に、人間の脳の仕組みを模倣した「深層学習」と呼ばれる技術は、高い性能を発揮する一方で、その複雑さゆえに判断過程を理解することが難しいという課題を抱えています。今後の研究では、この深層学習をはじめとする複雑な仕組みを持つ人工知能の解釈性を向上させることが重要な鍵となります。具体的には、人工知能が特定の判断に至った理由を、人間にも理解しやすい形で提示する技術の開発などが期待されます。まるで先生のように、人工知能が自分の思考過程を丁寧に説明してくれるようになるかもしれません。

また、人工知能の解釈性を評価するための基準を設けることも重要です。共通の尺度を用いることで、異なる人工知能技術の解釈性を比較し、より分かりやすい人工知能の開発を促進することができます。さらに、解釈性を評価するための指針となるような手引きを整備することも必要です。これにより、開発者だけでなく、利用者も人工知能の解釈性を理解しやすくなり、安心して利用できるようになります。

こうした研究や取り組みによって、人工知能の信頼性を高め、社会への受け入れをスムーズに進めることが期待されます。人工知能が人々に受け入れられ、広く活用されることで、私たちの社会はより豊かで便利なものになっていくでしょう。そのためにも、人工知能の解釈性を高める研究をさらに推進していくことが重要です。

まとめ

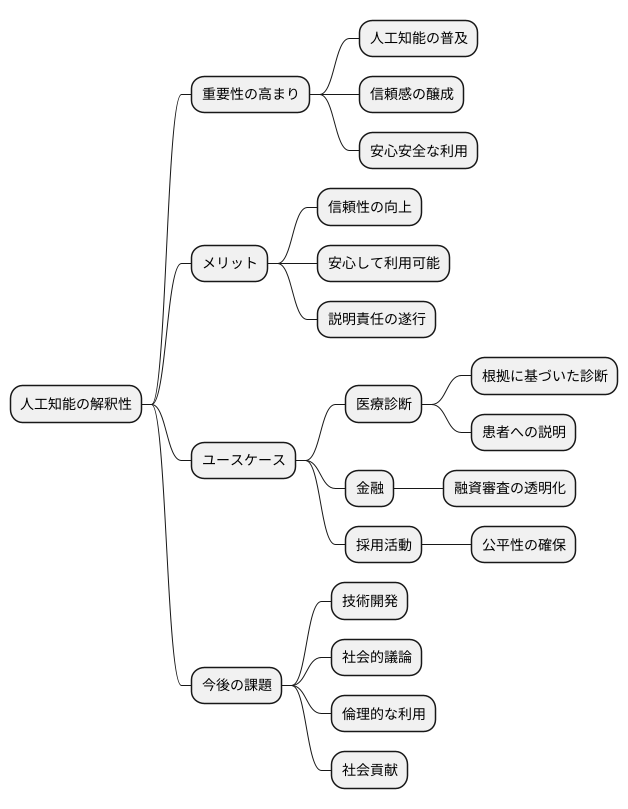

人工知能が私たちの暮らしに深く入り込むにつれて、その判断の根拠を理解できることがますます重要になっています。これを「解釈性」と言い、人工知能を社会に広く役立てる上で欠かせない要素となっています。解釈性を高めることは、人工知能に対する信頼感を育み、人々が安心して利用することに繋がります。 なぜなら、人工知能の判断がどのように行われたのかが分からなければ、その結果を信頼したり、安心して利用したりすることは難しいからです。

例えば、医療の現場で人工知能が診断を支援する場合を考えてみましょう。人工知能が特定の病気を診断したとしても、その根拠が分からなければ、医師は診断結果をそのまま受け入れることはできません。人工知能がどのような情報に基づいて判断したのかが分かれば、医師は人工知能の診断を参考にしながら、より正確な診断を下すことができます。また、患者の立場からも、診断の根拠が明らかであれば、納得して治療を受けることができます。

様々な分野で人工知能の活用事例が増えていますが、解釈性の重要性はますます高まっています。金融の分野では、人工知能が融資の審査を行う際に、なぜ融資が承認されたのか、あるいは拒否されたのかを説明できることが必要です。採用活動においても、人工知能が応募者を評価する際に、どのような基準で評価したのかが透明化されていなければ、公平性を担保することはできません。

人工知能の解釈性は、倫理的な利用と社会貢献を実現するための重要な鍵となります。人工知能が人々の生活に大きな影響を与えるようになるにつれて、その判断過程を理解し、適切に管理することが必要不可欠です。今後、技術開発を進めると同時に、社会的な議論を深めていくことで、人工知能の解釈性を高め、人工知能と人間が共に生きる社会を築いていくことが重要です。人工知能が私たちの生活を豊かにするために、解釈性という課題に真摯に取り組む必要があります。