交差検証:機械学習の精度の鍵

AIを知りたい

「交差検証」って、どういうものですか?

AIエンジニア

簡単に言うと、持っているデータを学習用とテスト用に分けて、学習した結果がどれくらい正しいかを確かめる方法だよ。 全部のデータで学習してしまうと、新しいデータに対してどれくらいうまくいくか分からなくなってしまうからね。

AIを知りたい

なるほど。どうしてデータを分けて検証する必要があるのですか?

AIエンジニア

限られたデータで学習すると、特定のデータにだけ最適化されてしまうことがあるんだ。これを「過学習」と言うんだけど、交差検証を使うことで、過学習を防ぎ、より汎用的なモデルを作ることができるんだよ。

cross validationとは。

人工知能に関わる言葉である「交差検証」について説明します。交差検証とは、統計学で使われる方法で、集めたデータの一部を使って分析し、残りのデータでその分析結果が正しいかを確認するものです。これは、データ分析の方法がどれくらい良いかを評価するために使われます。特に、機械学習や深層学習といった方法の良さを評価する際に、交差検証はよく用いられます。データの数が少ない場合は、交差検証は特に重要です。理由は以下の通りです。

1. 集めたデータ全てを学習に使うと、その学習結果が新しいデータにも使えるかどうかわかりません。

2. 学習と検証に使うデータを分けずに学習させると、学習結果が偏ってしまう可能性があります。

交差検証の手順は以下の通りです。

1. データを分割します。

2. 分割したデータの一部を使って学習を行います。

3. 残りのデータを使って、学習結果がどれくらい良いかを評価します。

4. 学習に使うデータと検証に使うデータを入れ替え、手順2と3を繰り返します。

5. 複数回行った評価結果をまとめて、最終的な分析方法の良し悪しを判断します。

交差検証とは

機械学習では、集めた情報を使って、コンピュータに色々なことを学習させます。学習した結果が、本当に役立つものなのかを確かめる必要があります。そのために使う方法の一つが、交差検証です。

交差検証は、限られた量の情報を有効に使うための工夫です。例えるなら、料理のレシピを少しの材料で試し、改良していくようなものです。材料を全部使って一度だけ料理を作るのではなく、材料を分けて何回か料理を作ります。

具体的には、集めた情報をいくつかのグループに分けます。そして、ある一つのグループを除いた残りのグループを使ってコンピュータに学習させます。残しておいたグループを使って、学習した結果がどれくらい正しいかを調べます。これを、残しておいたグループを変えながら繰り返します。それぞれのグループを順番にテスト用として使い、それ以外のグループを学習用として使うことで、全てのデータが学習とテストに使われます。

この方法の利点は、少ない情報でも学習結果の確かさを調べることができる点です。全ての情報を学習に使い、別のデータでテストできれば理想ですが、十分な情報がない場合、交差検証が役立ちます。

交差検証によって、コンピュータが学習したことが、特定の情報だけに合うのではなく、他の新しい情報にも役立つことが確認できます。つまり、本当に役立つ知識をコンピュータが学習できたかを確認できるのです。

交差検証は、機械学習の様々な場面で使われており、より信頼性の高い学習結果を得るために重要な方法です。

交差検証の必要性

機械学習では、作った予測の仕組みの良し悪しを確かめるために、学習用の情報とテスト用の情報を分けて使います。学習用の情報だけで学習と評価を行うと、予測の仕組みは学習用の情報に過度に適応してしまい、新しい情報に対する予測の正確さが低くなることがあります。これは、いわば勉強しすぎて応用が利かなくなるようなもので、過学習と呼ばれています。

交差検証を使うと、限られた量の情報を有効に使い、過学習を防ぎながら、予測の仕組みがどれだけ広く使えるかを評価できます。交差検証では、持っている情報をいくつかのグループに分け、一つのグループをテスト用、残りを学習用として使います。これをグループの数だけ繰り返すことで、全ての情報が一度はテスト用に使われます。このようにして、限られた情報でも偏りなく予測の仕組みの性能を評価できるのです。

特に情報が少ない場合には、交差検証は予測の仕組みの真の性能を測る上で非常に重要です。例えば、新しい薬の効果を調べる際に被験者が少ない場合、交差検証を使うことで少ない被験者でも信頼性の高い結果を得ることができます。もし、交差検証を行わずに被験者を学習用とテスト用に単純に分けると、たまたま選ばれた被験者の性質によって結果が大きく左右されてしまう可能性があります。

つまり、交差検証は、予測の仕組みが特定の情報だけでなく、広く一般的に使えるかを確かめるための強力な手法と言えるでしょう。これは、機械学習においてより正確で信頼性の高い予測を行うために欠かせないものです。

交差検証の方法

交差検証とは、機械学習モデルの性能をより正確に評価するためによく使われる手法です。この手法は、限られた量の学習データを有効に活用し、モデルの汎化性能、つまり未知のデータに対する予測能力を測るのに役立ちます。

まず、手持ちのデータを複数のグループ(部分集合)に分割します。分割数は、一般的に5個や10個といった値がよく用いられます。それぞれのグループは、ほぼ同じくらいのデータ数になるように分けられます。

次に、これらのグループの中から一つを選び、これをテストデータとして取っておきます。残りのグループをまとめて訓練データとして扱います。この訓練データを使って機械学習モデルの学習を行います。つまり、訓練データの中に潜むパターンや規則をモデルに覚えさせます。

学習が完了したら、取っておいたテストデータを使って、学習したモデルの性能評価を行います。具体的には、テストデータを入力としてモデルに予測させ、その予測結果と実際の値を比較することで、モデルの精度や誤差などを計算します。

ここまでの手順を、それぞれのグループが一度ずつテストデータの役割を果たすように繰り返します。例えば、データを5つのグループに分割した場合、この手順を5回繰り返すことになります。それぞれの繰り返しにおいて、異なる訓練データとテストデータの組み合わせでモデルの学習と評価が行われます。

最後に、各回の評価結果を平均します。これにより、特定のデータの分割方法に偏ることなく、モデルの全体的な性能を測ることができます。この平均値が、交差検証によって得られるモデルの最終的な性能評価となります。このように、交差検証は、限られたデータからでも信頼性の高いモデル評価を行うための、強力な手法と言えるでしょう。

交差検証の種類

機械学習モデルの性能を正しく測ることは、モデル構築の中で非常に大切な仕事です。そこで役立つのが交差検証です。交差検証とは、学習データ全体を複数のグループに分け、各グループを順番にテストデータとして用いることで、モデルの汎化性能を評価する手法です。様々な交差検証の手法がありますが、中でも代表的なものがK分割交差検証です。

K分割交差検証では、まず全ての学習データをK個の等しい大きさのグループに分割します。例えば、Kの値を5とすると、学習データは5つのグループに分けられます。次に、一つのグループをテストデータとし、残りのK-1個のグループを訓練データとしてモデルを学習させます。この時、訓練データで学習したモデルをテストデータで評価し、その性能を記録します。この手順をK回、つまり各グループが一度ずつテストデータとなるように繰り返します。5分割交差検証であれば、この手順を5回繰り返すことになります。そして、K回の評価結果の平均を最終的なモデルの性能とみなします。

Kの値は、交差検証の精度や計算時間に影響を与えます。Kの値が小さい場合、例えばK=2のような極端な例では、訓練データの量が少なくなり、モデルの学習が不十分になる可能性があります。一方、Kの値が大きい場合、例えばKが学習データのサンプル数と等しい場合(Leave-One-Out 交差検証)、計算時間が非常に長くなります。そのため、データ量や計算資源、そしてモデルの複雑さなどを考慮して、適切なKの値を選択することが重要です。一般的には、K=5 または K=10 がよく用いられます。

交差検証の利点

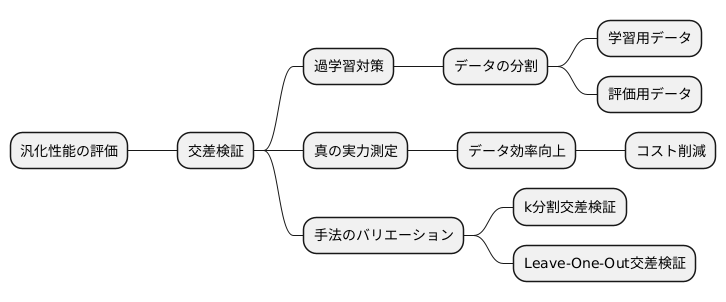

機械学習モデルを作る上で、そのモデルがどれくらいきちんと働くかを確かめることはとても大切です。この「きちんと働くか」を測る尺度の一つが汎化性能で、未知のデータにどれくらいうまく対応できるかを表します。交差検証は、この汎化性能を正しく測るための強力な手法です。

すべてのデータを使って学習し、同じデータで評価すると、一見性能が良いように見えても、実際には学習に使ったデータの特徴に過剰に適応してしまい、新しいデータではうまくいかないことがあります。これは過学習と呼ばれ、モデルの汎化性能を低下させる大きな要因です。交差検証を使うことで、この過学習の影響を小さくすることができます。

交差検証では、持っているデータをいくつかのグループに分け、あるグループを評価用、残りのグループを学習用としてモデルを作ります。これをグループの組み合わせを変えながら繰り返し、それぞれの評価結果を平均します。こうすることで、限られたデータでもすべてのデータを評価に使い、モデルの真の実力を測ることができます。

データを集めるのは費用も手間もかかります。交差検証は少ないデータでも有効に活用できるので、データ収集にかかるコストを抑えることにも繋がります。

さらに、交差検証には様々な方法があります。例えば、データをランダムにグループ分けするk分割交差検証や、1つだけを評価用に残りを学習用とするLeave-One-Out交差検証などです。これらの手法をデータの性質や目的に合わせて使い分けることで、より適切な評価を行うことができます。

交差検証の注意点

交差検証は、機械学習モデルの性能を評価する手法として広く使われています。限られた学習データを有効に活用し、モデルの汎化性能をより正確に見積もるために重要な役割を担っています。しかし、交差検証を行う際にはいくつか注意すべき点があります。その中でも特に重要なのが分割数(K値)の選択とデータの分割方法です。

まず、分割数Kについて考えてみましょう。Kは学習データをいくつのグループに分けるかを表す値です。例えば、K=5の場合、データを5つのグループに分け、1つのグループを検証データ、残りの4つのグループを学習データとしてモデルを学習させます。これを5回繰り返すことで、全てのグループが1回ずつ検証データとして使われます。Kの値が小さい場合、例えばK=2のような極端な例では、学習データが全体の半分しかありません。そのため、モデルの学習が不十分になり、本来の性能を発揮できない可能性があります。これは、モデルが学習データの特徴を十分に捉えきれていない状態と言えるでしょう。一方、Kの値が大きい場合、例えばK=学習データ数とした場合(Leave-One-Out交差検証)、計算コストが大幅に増加します。学習データ数が膨大な場合、膨大な数のモデルを学習させる必要があり、時間と計算資源の消費が莫大になります。そのため、実用上はK=5またはK=10といった値がよく用いられます。これらの値は、計算コストと学習データ量のバランスが良いとされています。

次に、データの分割方法についてです。データの分割方法にも注意を払わないと、偏った評価結果が出てしまう可能性があります。例えば、学習データに特定の特徴を持つデータが偏って存在する場合、単純にランダムに分割すると、ある分割ではその特徴を持つデータが学習データに多く含まれ、別の分割では検証データに多く含まれるといったことが起こりえます。このような分割の偏りは、モデルの性能評価を不正確にする要因となります。そこで、層化抽出法を用いることが有効です。層化抽出法は、データの持つ特定の属性に基づいてデータを層に分け、各層から均等にデータを抽出する方法です。これにより、各分割においてデータの分布が元のデータセットとほぼ同じになり、偏りの影響を軽減することができます。例えば、顧客の購買データを用いてモデルを学習させる場合、年齢層や性別といった属性で層化抽出を行うことで、各分割で年齢層や性別の比率がほぼ均等になり、より信頼性の高い評価結果を得ることができます。

| 項目 | 説明 | 問題点 | 対策 |

|---|---|---|---|

| 分割数(K値) | 学習データをいくつのグループに分けるかを表す値。K=5の場合、データを5つのグループに分け、1つのグループを検証データ、残りの4つのグループを学習データとしてモデルを学習させる。これを5回繰り返す。 | K値が小さい場合(例:K=2):学習データが少なく、モデルの学習が不十分になる。K値が大きい場合(例:K=学習データ数):計算コストが大幅に増加する。 | K=5またはK=10といった値がよく用いられる。 |

| データの分割方法 | 学習データと検証データの分割方法。 | 単純にランダムに分割すると、データの偏りが生じ、モデルの性能評価が不正確になる。 | 層化抽出法を用いる。データの持つ特定の属性に基づいてデータを層に分け、各層から均等にデータを抽出する。 |