データの偏りが招く落とし穴

AIを知りたい

先生、「データセットの偏りによる注意」って、どういう意味ですか?

AIエンジニア

簡単に言うと、機械学習のAIを鍛えるためのデータに偏りがあると、AIも偏った考え方をするようになるということだよ。 例えば、過去に猫の写真ばかりで学習したAIは、犬を見せても猫と判断してしまうかもしれないね。

AIを知りたい

なるほど。猫ばかり見ていたら、犬も猫に見えてしまうということですね。でも、人間がAIを作る時に、偏ったデータを選んでしまうのですか?

AIエンジニア

人間がわざと偏ったデータを選ぶとは限らないんだ。例えば、昔は技術者の仕事をしている人が男性ばかりだったので、技術者の仕事の写真を集めたら男性の写真ばかりになってしまい、AIは「技術者=男性」と学習してしまった、というようなケースもあるんだよ。

データセットの偏りによる注意とは。

人工知能を作る際に使う学習データに偏りがあると、その人工知能にも偏りが生まれる可能性があるという問題についてです。学習データは、本来、色々な特徴を持った人や物を満遍なく含んでいなければなりません。もし特定の特徴を持つデータが多かったり少なかったりすると、人工知能が正しく物事を判断できなくなることがあります。例えば、アマゾンの採用選考で人工知能を使ったところ、男性の方が女性より高く評価されてしまうという問題が起きました。これは、過去の応募者に男性が多かったため、学習データにも男性のデータが多く含まれていたことが原因です。また、マイクロソフトが作った顔認識システムでは、白人よりも有色人種の認識精度が低く、性別の判断を間違えることもありました。これも、学習データに白人の画像が多かったことが原因の一つです。このように、開発者に差別的な意図がなかったとしても、偏ったデータを使って人工知能を作ると、様々な問題につながることがあります。

偏ったデータが学習に与える影響

機械学習は、多くの事例から学び、規則性を見つけることで、未来の予測や判断を行います。まるで、人間が経験から学ぶようにです。しかし、学習に使う事例が現実の世界を正しく表しておらず、特定の特徴に偏っている場合、機械学習もその偏りを学び、偏った結果を出力してしまうことがあります。これは、偏った情報ばかりを耳にする人が、偏った考えを持つようになるのと似ています。

例えば、ある地域で特定の種類の犯罪が多い事例だけを学習させた機械学習を考えてみましょう。この機械学習は、その地域で起こる全ての出来事を、学習した特定の種類の犯罪だと誤って判断するかもしれません。これは、まるで「井の中の蛙、大海を知らず」という諺のように、限られた情報しか知らないために、間違った判断をしてしまうのです。

他にも、ある病気の診断支援を行う機械学習を開発する場合を考えてみます。もし、学習データに男性の患者が多く含まれていて、女性の患者が少ない場合、この機械学習は男性の症状には正確な診断を下せるかもしれません。しかし、女性の患者に対しては、診断の精度が低くなる可能性があります。これは、学習データに含まれる男女比の偏りが、機械学習の判断に影響を与えているためです。

このように、学習データの偏りは、機械学習の正確さや信頼性を低下させるだけでなく、社会的な不公平や差別につながる危険性も持っています。偏りのない、バランスの取れたデータを使うことは、公平で信頼できる機械学習を作るための土台となるのです。そのため、機械学習を開発する際には、データの偏りを注意深く調べ、偏りを減らすための工夫をすることが重要です。これは、より良い社会を作るために、機械学習が正しく機能するようにするための大切な取り組みと言えます。

| 問題点 | 具体例 | 人間への例え | 諺 |

|---|---|---|---|

| 学習データの偏りが、偏った結果を生む | 特定の種類の犯罪が多い地域で学習した機械学習が、全ての出来事をその犯罪と誤認する | 偏った情報ばかりを耳にする人が、偏った考えを持つ | 井の中の蛙、大海を知らず |

| 学習データの偏りが、特定のグループへの精度低下を引き起こす | 男性患者が多いデータで学習した病気診断支援AIが、女性患者への診断精度が低い | – | – |

過去の事例に見るデータ偏りの問題点

情報を取り扱う機械の学習において、学ぶ情報に偏りがあると、様々な問題が起こることが過去の事例から明らかになっています。偏った情報で学習した機械は、現実世界で思わぬ不具合を引き起こすことがあります。

例えば、ある大きな買い物仲介の会社が人材を選ぶために作った情報機械は、過去の応募者の情報から学習した結果、男性を優先的に選ぶようになってしまいました。これは、技術系の仕事に応募してきた人に男性が多かったという、学ぶ情報の偏りが原因でした。この会社は、意図的に男性を選ぼうとしたわけではありませんでしたが、情報機械が過去の情報に基づいて判断した結果、不平等な選考をしてしまったのです。

また、ある会社の顔を見分ける仕組みも、肌の色が白い人の顔の情報が多く、肌の色が違う人の顔はうまく認識できないという問題点が指摘されました。これは、学習に使った顔写真に肌の色が白い人が多かったことが原因です。この顔認証システムは、防犯や安全確認など様々な場面で使われることを想定していましたが、特定の人々を正しく認識できないため、本来の目的を達成することが難しくなってしまいました。犯罪捜査などで使われた場合、誤った判断につながる危険性も懸念されます。

これらの事例は、作る人の意図とは関係なく、学ぶ情報の偏りが差別や不公平につながる可能性を示しています。情報機械を作る際には、どのような情報で学習させるかを注意深く考える必要があります。偏りのない、様々な情報をバランスよく学習させることで、より公平で正確な判断ができる情報機械を作ることができます。情報機械の開発において、情報の偏りをきちんと理解し、適切に対処することは、これからの社会にとって非常に大切なことなのです。

| 事例 | 問題点 | 原因 | 影響 |

|---|---|---|---|

| 人材選考AI | 男性を優先的に選考 | 過去の応募者に男性が多かった | 不平等な選考 |

| 顔認証システム | 肌の色が白い人の顔以外をうまく認識できない | 学習用データに肌の色が白い人の顔写真が多かった | 特定の人々を正しく認識できない、誤った判断につながる危険性 |

データ偏りを減らすための対策

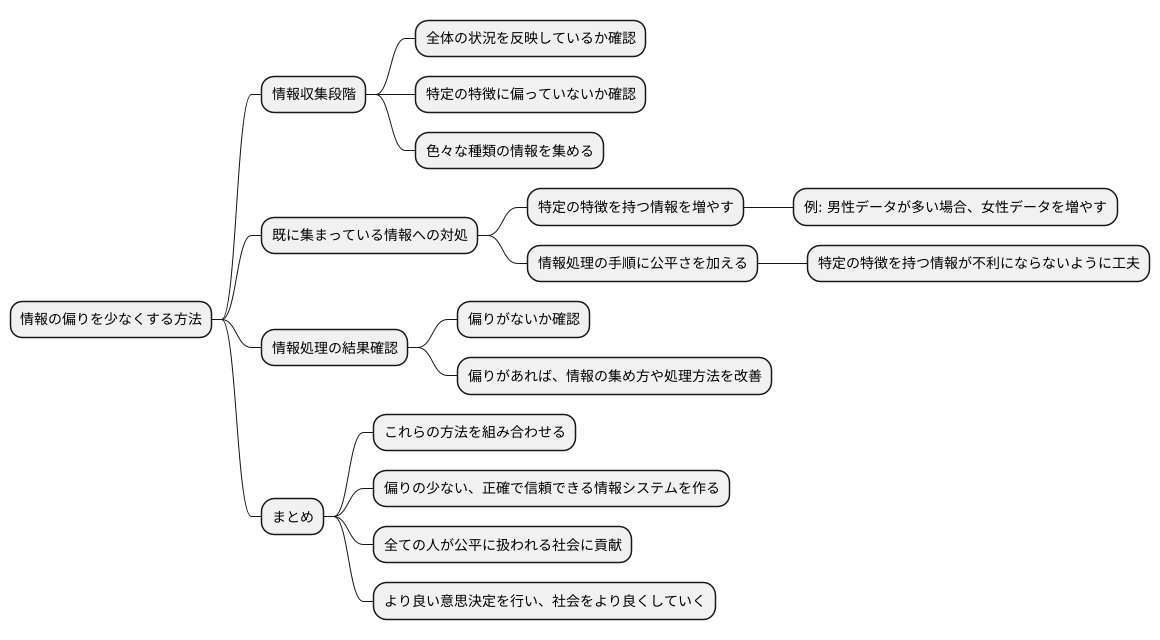

情報の偏りを少なくするためには、色々な方法があります。まず、情報を集める段階から気を付ける必要があります。集める情報が、全体の状況を正しく反映しているか、特定の特徴に偏っていないかを注意深く確認し、色々な種類の情報を集めることが大切です。

既に集まっている情報から偏りをなくす技術も研究されています。特定の特徴を持つ情報を増やすことで、情報のバランスを調整する方法もあります。例えば、男性のデータが多い場合は、女性のデータを意図的に増やすことでバランスを取ることができます。また、情報処理の手順自体に公平さを加える方法も研究されています。これは、情報処理をする際に、特定の特徴を持つ情報が不利にならないように工夫するということです。

さらに、情報処理の結果を常に見て、偏りがないかを確認することも重要です。もし偏りが見つかった場合は、情報の集め方や処理方法を改善する必要があります。

これらの方法を組み合わせることで、偏りの少ない、より正確で信頼できる情報システムを作ることができます。偏りをなくす努力を続けることで、全ての人が公平に扱われる社会に貢献できます。情報の偏りは、時に大きな問題を引き起こす可能性があります。偏りのない情報を集め、正しく処理することで、より良い意思決定を行い、社会をより良くしていくことができるのです。

多様な視点を取り入れる重要性

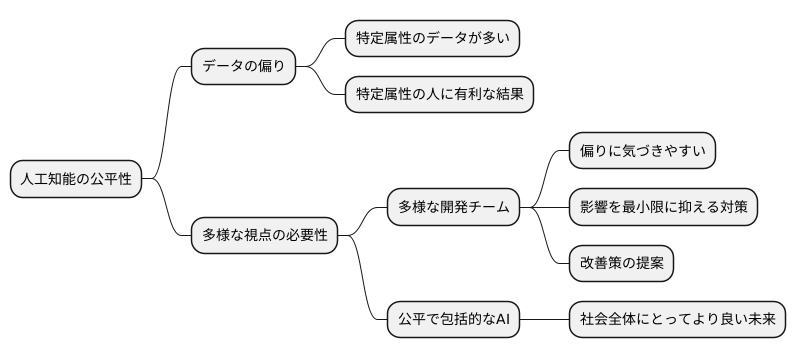

人工知能(じんこうちのう)技術の進化(しんか)は目覚(めざま)しく、私達(わたしたち)の暮らしを様々な場面(ばめん)で支(ささ)えています。しかし、人工知能が真(しん)に社会全体(しゃかいぜんたい)にとって有益(ゆうえき)なものとなるためには、開発段階(かいはつだんかい)から多様(たよう)な視点(してん)を取り入(い)れることが大変重要(たいへんじゅうよう)です。

人工知能の学習(がくしゅう)には大量(たいりょう)のデータが用(もち)いられますが、もしそのデータに偏(かたよ)りがあれば、結果的(けっかてき)に人工知能も偏(かたよ)った判断(はんだん)をするようになってしまいます。例えば、ある特定(とくてい)の属性(ぞくせい)の人に関するデータが多(おお)く、他(ほか)の属性の人のデータが少(すく)ない場合、人工知能はその特定の属性の人に有利(ゆうり)な結果を導(みちび)きやすくなります。

このようなデータの偏りを防ぐためには、開発チーム自体が多様(たよう)な構成員(こうせいいん)であることが必要です。様々な背景(はいけい)や経験(けいけん)を持つ人々が集まることで、データに潜(ひそ)む偏りに気づき、その影響(えいきょう)を最小限(さいしょうげん)に抑(おさ)える対策(たいさく)を立てることができます。ある属性を持つ人がチームにいれば、自分と同じ属性の人々に関するデータに偏りがないか、問題点はないかを敏感(びんかん)に察知(さっち)し、改善策(かいぜんさく)を提案(ていあん)できる可能性(かのうせい)が高まります。

多様な視点を開発プロセスに反映(はんえい)させることで、特定の属性の人々だけでなく、あらゆる人にとって公平(こうへい)で包括的(ほうかつてき)な人工知能システムを構築(こうちく)することが可能になります。これは、社会全体にとってより良い未来(みらい)を築く上で欠(か)かせない要素(ようそ)と言えるでしょう。

公平な社会を実現するためのAI開発

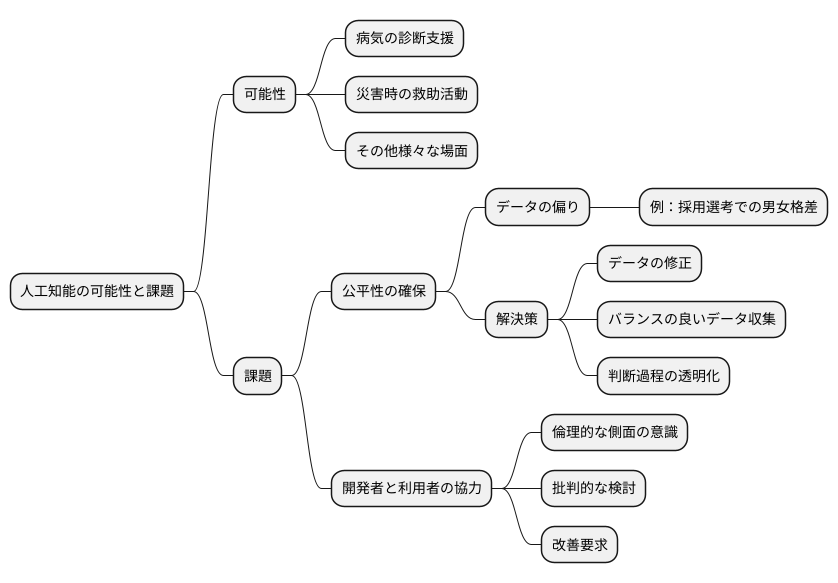

人工知能は、私たちの暮らしを様々な面で支え、より良い社会を実現するための大きな可能性を秘めています。病気の診断支援や、災害時の救助活動など、人工知能はすでに様々な場面で活躍しており、今後ますますその役割は大きくなっていくと考えられます。しかし、人工知能が全ての人にとって公平な結果をもたらすとは限りません。人工知能の学習に用いるデータに偏りがあると、その偏りが人工知能の判断にも反映され、不公平な結果を生み出す可能性があるのです。

例えば、採用選考に人工知能を用いる場合を考えてみましょう。過去の採用データに男性社員が多いという偏りがあった場合、人工知能は男性を採用する方が有利だと学習してしまうかもしれません。これは女性にとって不公平な結果をもたらし、社会における男女格差をさらに広げてしまう可能性があります。

人工知能が真に社会の役に立つためには、このような偏りをなくし、公平性を確保することが不可欠です。そのためには、人工知能の開発者は、学習データの偏りを注意深く確認し、偏りを軽減するための対策を講じる必要があります。具体的には、偏りのあるデータを修正したり、様々な属性の人々からバランスよくデータを収集したりすることが重要です。また、人工知能の判断過程を透明化し、なぜそのような結果になったのかを説明できるようにすることも大切です。

人工知能の公平性を確保することは、開発者だけの責任ではありません。人工知能を利用する私たちも、人工知能が出した結果を鵜呑みにするのではなく、批判的に検討する必要があります。人工知能が不公平な結果を出していると感じた場合は、その原因を調べ、改善を求めることが重要です。人工知能を正しく活用することで、より公平で暮らしやすい社会を築くことができるのです。人工知能の倫理的な側面を常に意識し、開発者と利用者が協力して、より良い未来を目指していくことが大切です。