AMSBound:学習率の調整による最適化

AIを知りたい

先生、『AMSBound』って、何ですか?

AIエンジニア

いい質問だね。『AMSBound』は、機械学習の最適化手法である『AMSGrad』の学習率に、上限と下限を設けたものだよ。 学習率は、機械が学習する際の歩幅のようなものだ。適切な歩幅でないと、なかなか目標にたどり着けない。大きすぎても小さすぎてもいけないんだ。

AIを知りたい

AMSGradの学習率に制限を加える理由は何ですか?

AIエンジニア

AMSGradは、Adamという手法の弱点を克服するために作られたんだけど、学習率が小さすぎると、Adamと同じくらいの精度しか出せないという問題があったんだ。そこで、AMSBoundは学習率に上限と下限を設けることで、この問題を解決しようとしたんだよ。

AMSBoundとは。

人工知能で使われる言葉、「エーエムエスバウンド」について説明します。エーエムエスバウンドは、エーエムエスグラッドという学習方法の、学習の速さの調整範囲に上限と下限を設けるものです。

機械学習では、学習をうまく進めるための色々な方法があります。その中で、アダムという方法は、学習の最初の段階は速いのですが、なかなか最終的な答えにたどり着かないという弱点がありました。この弱点を克服するために考えられたのが、エーエムエスグラッドという方法です。エーエムエスグラッドは、速すぎる学習を抑えることはできましたが、今度は遅すぎる学習が問題となり、結局アダムと同じくらいの精度しか出せませんでした。

ちなみに、アダムにエーエムエスバウンドと同じような制限を加えた方法に、アダバウンドというものがあります。

はじめに

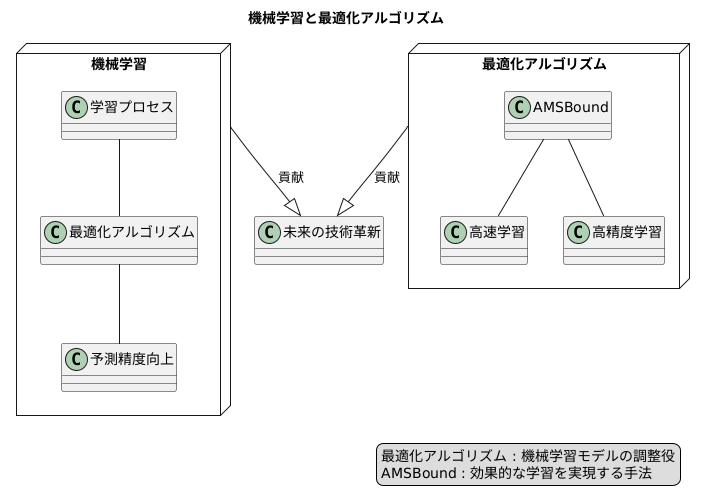

機械学習という技術は、多くの情報から、まるで人間のように法則や繋がりを自ら学び取る力を持っています。そして、近年、様々な分野で目覚しい成果を上げており、私たちの生活にも大きな影響を与え始めています。この機械学習の肝となるのが、学習プロセスにおける最適化アルゴリズムです。最適化アルゴリズムとは、機械学習モデルの調整役と言えるでしょう。モデルの中には様々な部品があり、それぞれの部品がうまく働くように調整することで、予測の正確さを高めることができます。この調整作業を自動的に行うのが、最適化アルゴリズムの役割です。例えるなら、目的地への行き方がわからない旅人に、最適な道案内をしてくれる頼もしいガイドのような存在です。

数ある最適化アルゴリズムの中でも、AMSBoundは効果的な学習を実現するための優れた手法の一つです。AMSBoundは、他のアルゴリズムと比べて、より速く、より正確に学習を進めることができると期待されています。まるで、経験豊富なベテランガイドのように、最短ルートで目的地まで案内してくれるだけでなく、寄り道をして新たな発見をさせてくれることもあります。

機械学習は、まるで人間の脳のように、学習と調整を繰り返すことで成長していきます。そして、その成長を支えているのが最適化アルゴリズムです。AMSBoundのような優れたアルゴリズムが、機械学習の可能性をさらに広げ、未来の技術革新に繋がる重要な役割を担っていくと考えられます。AMSBoundは、今後の機械学習の発展に大きく貢献する可能性を秘めた、注目すべきアルゴリズムと言えるでしょう。

課題と解決策

近年の機械学習では、膨大なデータを扱うことが多いため、いかに効率よく学習を進めるかが重要です。そのために、様々な最適化アルゴリズムが開発されてきました。中でもAdamは、その処理速度の速さから広く使われています。しかしAdamには、学習の最終段階で最適なパラメータ値にたどり着かず、精度が向上しなくなるという弱点がありました。つまり、目標値付近を揺れ動き、なかなか落ち着かないイメージです。

このAdamの弱点を克服するために、AMSGradという手法が提案されました。AMSGradは、過去の勾配情報を考慮することで、学習の進み具合を調整しようとしました。具体的には、学習率と呼ばれるパラメータの値を、過去の勾配情報に基づいて動的に変化させる仕組みを取り入れました。これは、急な坂道を下る際に、速度が出すぎないようにブレーキをかけるようなものです。

ところが、AMSGradはAdamの弱点を克服するどころか、新たな問題を生み出してしまいました。学習率を小さくし過ぎた結果、学習の進みが遅くなり、Adamと同じように精度が頭打ちになってしまったのです。これは、ブレーキをかけすぎて、目的地までなかなかたどり着けない状況に似ています。

そこで登場するのがAMSBoundです。AMSBoundは、AMSGradの良いところを生かしつつ、その弱点を克服するために考案されました。AMSBoundは、AMSGradのように学習率を調整しますが、その値に上限と下限を設けます。これは、ブレーキを適切に調整することで、速度が出すぎることもなく、かつ遅すぎることもなく、スムーズに目的地にたどり着けるようにする工夫です。このように、AMSBoundは学習率を適切な範囲内に保つことで、より安定した学習を実現し、AdamやAMSGradよりも高い精度を達成することを目指しているのです。

| 手法 | 特徴 | 問題点 |

|---|---|---|

| Adam | 高速な学習 | 最終段階で精度向上せず(目標値付近で揺れ動き) |

| AMSGrad | 過去の勾配情報考慮、学習率を動的に変化(ブレーキ機能) | 学習率が小さくなりすぎ、学習速度低下、精度向上せず(ブレーキ過剰) |

| AMSBound | AMSGradの学習率調整機能 + 学習率の上限下限設定(適切なブレーキ制御) | – |

手法の仕組み

この手法は、学習の進み具合を調整する仕組みを改良したものです。

名前は「改良型平均二乗勾配手法」と言い、学習の速さを上下限で区切って、安定した学習を実現します。

学習の速さは、例えるなら山の斜面を下る速さのようなものです。急な斜面では速く下れますが、勢い余って谷底を通り過ぎてしまうかもしれません。緩やかな斜面ではゆっくり下りますが、なかなか目的地にたどり着かないかもしれません。この手法は、この速さを適切に調整する仕組みです。

具体的には、学習の速さが遅くなりすぎそうな時は、下限値を設定することで最低限の速さを確保します。これは、緩やかな斜面でも確実に目的地に向かうことを意味します。

逆に、学習の速さが速くなりすぎそうな時は、上限値を設定することで速さを制限します。これは、急な斜面でも勢い余って谷底を通り過ぎないようにブレーキをかけることを意味します。

このように、上限と下限を設けることで、学習の速さが適切な範囲内に収まり、効率よく学習を進めることができます。ちょうど、自転車に乗る時にペダルを漕ぐ速さを調整するように、学習の速さも調整することで、スムーズに目的地に到達することができるのです。

この手法は、従来の手法よりも安定して学習を進めることができ、より良い結果を得られる可能性を高めます。つまり、より正確な予測や判断ができるようになるということです。

この手法は、様々な分野で活用が期待されています。例えば、画像認識や音声認識、自然言語処理など、人工知能が活躍する様々な場面で、より精度の高い学習を実現することが期待されています。

| 手法名 | 改良型平均二乗勾配手法 |

|---|---|

| 目的 | 学習の進み具合の調整機構の改良、安定した学習の実現 |

| 仕組み | 学習の速さ(勾配)に上限と下限を設定 |

| 下限設定のメリット | 学習の速さが遅くなりすぎるのを防ぎ、最低限の速さを確保(緩やかな斜面でも確実に進む) |

| 上限設定のメリット | 学習の速さが速くなりすぎるのを防ぎ、速さを制限(急な斜面でも行き過ぎない) |

| 全体的な効果 | 学習速度を適切な範囲に収め、効率的な学習を実現 |

| 期待される成果 | 従来手法より安定した学習、より良い結果(正確な予測や判断) |

| 応用分野 | 画像認識、音声認識、自然言語処理など人工知能が活躍する様々な場面 |

他の手法との比較

学習の効率と安定性を両立させる手法として、様々な最適化アルゴリズムが提案されてきました。その中で、広く使われている手法の一つにAdamがあります。Adamは、処理の速さから初期の学習が速いという長所を持っています。しかし、最終的な学習結果の精度が低いという課題も抱えています。つまり、学習の収束性が低いのです。この問題を解決するために、Adamを改良したAMSGradが登場しました。AMSGradは、Adamよりも収束性を向上させることに成功しましたが、学習の歩幅である学習率が小さくなりすぎるという新たな問題を生み出してしまいました。学習率が小さすぎると、学習の進みが遅くなり、最適な結果にたどり着くまでに時間がかかってしまうのです。

これらの問題点を克服するために開発されたのがAMSBoundです。AMSBoundは、AMSGradをベースとして、学習率に上限と下限を設けるという工夫を加えています。上限を設けることで、Adamのように学習率が大きくなりすぎることを防ぎ、安定した学習を実現します。また、下限を設けることで、AMSGradのように学習率が小さくなりすぎることを防ぎ、適切な学習速度を維持します。このように、AMSBoundは、AdamとAMSGradの長所を取り入れつつ、短所を克服することで、より効率的で安定した学習を可能にします。

AMSBoundと似た手法にAdaBoundがあります。AdaBoundもAdamをベースとして、学習率に制限を加えることで安定性を高めています。しかし、AMSBoundはAMSGradをベースとしているため、AdaBoundよりもさらに高度な最適化を実現することができます。AMSGradはAdamの改良版であるため、その特性を活かすAMSBoundは、より洗練された学習を実現し、高精度な結果を得られる可能性を秘めていると言えるでしょう。

| 手法 | ベース | 長所 | 短所 |

|---|---|---|---|

| Adam | – | 初期学習が速い | 学習結果の精度が低い(収束性が低い) |

| AMSGrad | Adam | Adamより収束性が向上 | 学習率が小さくなりすぎる |

| AMSBound | AMSGrad | 学習率に上限と下限を設定することで、Adamのような学習率の大きくなりすぎと、AMSGradのような学習率の小さくなりすぎを防ぎ、安定した学習を実現 | – |

| AdaBound | Adam | 学習率に制限を加えることで安定性を向上 | AMSBoundほど高度な最適化はできない |

利点と応用

AMSBoundは、機械学習モデルの学習において重要な役割を果たす最適化アルゴリズムの一つです。その最大の利点は、安定した学習過程と高い収束性にあります。

従来の最適化手法では、学習率の設定が難しく、適切な値を見つけ出すのに試行錯誤が必要でした。学習率が大きすぎると、モデルのパラメータが発散し、最適な解にたどり着くことができません。逆に学習率が小さすぎると、学習速度が遅くなり、膨大な時間を要してしまいます。AMSBoundは、これらの問題を解決するために開発されました。

AMSBoundは、各パラメータに対して個別に学習率を調整することで、安定した学習を実現します。具体的には、過去のパラメータの更新量に基づいて学習率を動的に変更します。これにより、最適な学習率を自動的に探索し、モデルを効率的に最適なパラメータへと導きます。結果として、従来の手法に比べてより速く、より正確な学習が可能になります。

このAMSBoundの優れた特性は、様々な機械学習の課題に役立ちます。特に、複雑な構造を持つ深層学習モデルの学習において、その真価を発揮します。例えば、画像の分類、文章の生成、音声の認識など、多様な応用が期待されています。画像認識では、より高い精度で画像を分類するモデルを学習することができます。自然言語処理では、より自然で滑らかな文章を生成するモデルを構築することが可能になります。音声認識では、より高い精度で音声を認識するモデルを開発することができます。このように、AMSBoundは機械学習の様々な分野で革新的な進歩をもたらす可能性を秘めています。今後の発展に大いに期待が寄せられています。

| 項目 | 説明 |

|---|---|

| アルゴリズム名 | AMSBound |

| 種類 | 最適化アルゴリズム |

| 利点 | 安定した学習過程、高い収束性 |

| 従来手法の問題点 | 学習率の設定が難しい、適切な値を見つけるのに試行錯誤が必要 |

| 学習率 | 各パラメータに対して個別に学習率を調整、過去のパラメータの更新量に基づいて動的に変更 |

| 効果 | 最適な学習率の自動探索、モデルの効率的な最適化 |

| 応用分野 | 深層学習モデルの学習(画像分類、文章生成、音声認識など) |

今後の展望

機械学習の分野では、学習を効率的に進めるための最適化手法が日々研究されています。その中で、注目を集めている手法の一つにAMSBoundがあります。AMSBoundは、これまでの手法の良い点を組み合わせ、より安定して高精度な学習を可能にする手法として期待されています。しかし、AMSBoundも完成形ではなく、更なる改良の余地を残しています。

例えば、現在のAMSBoundでは、学習率の上限と下限は固定されています。この上限と下限を、学習の進捗状況に合わせて動的に調整することで、より効率的な学習を実現できる可能性があります。具体的には、学習の初期段階では学習率を大きく設定し、徐々に小さくしていくことで、より早く最適な解に近づくことができると考えられます。また、学習が停滞してきた場合には、学習率を一時的に大きくすることで、局所的な最適解から抜け出す助けとなるかもしれません。

さらに、AMSBoundを画像認識や自然言語処理といった特定のタスクに特化させることで、より高い性能を引き出すことができると考えられます。それぞれのタスクに合わせた調整を行うことで、より効果的な学習を実現できるでしょう。

AMSBoundの理論的な側面の解明も今後の重要な課題です。なぜAMSBoundが効果的なのか、どのような条件下で最適な性能を発揮するのかを数学的に明らかにすることで、より効果的な利用方法や更なる改良への指針を得ることができます。現状では、経験的な結果に基づいてAMSBoundの有効性が示されている段階であり、理論的な裏付けが不足しています。この理論的な解明が進むことで、AMSBoundはより信頼性の高い手法となり、機械学習の発展に大きく貢献することが期待されます。これらの研究は、機械学習の未来を切り開く重要な鍵となるでしょう。

| 課題 | 内容 | 期待される効果 |

|---|---|---|

| 学習率の動的調整 | 学習の進捗状況に合わせて学習率の上限と下限を動的に調整する。例えば、学習初期は高く、徐々に低くする。学習が停滞したら一時的に高くする。 | より効率的な学習、より早く最適な解への収束、局所的な最適解からの脱出 |

| タスク特化 | 画像認識や自然言語処理といった特定のタスクにAMSBoundを特化させる。 | タスクに応じた効果的な学習、より高い性能 |

| 理論的解明 | AMSBoundの有効性、最適な性能を発揮する条件を数学的に明らかにする。 | 効果的な利用方法の確立、更なる改良への指針、信頼性の向上、機械学習の発展への貢献 |