AIC:モデル選択の指標

AIを知りたい

先生、「赤池情報量基準」って、結局どういうものなんですか?難しくてよくわからないです。

AIエンジニア

そうだね、難しいよね。簡単に言うと、データにどれくらいうまく合っているかと、モデルがどれくらい複雑か、のバランスをみてくれる指標なんだ。ちょうど良い具合の複雑さを持つモデルを見つけ出すのに役立つんだよ。

AIを知りたい

複雑すぎるとダメなんですか?

AIエンジニア

複雑すぎると、今のデータにはすごくよく合っても、新しいデータではうまくいかないことがあるんだ。これを「過学習」と言うんだけど、AICは過学習を防ぐためにも役立つんだよ。だから、複雑すぎず、かつデータにもよく合うモデルを選ぶことが大切なんだ。

赤池情報量基準とは。

人工知能の分野でよく使われる「赤池情報量基準」について説明します。この基準は、統計モデルがどれくらい良いかを評価するために使われます。統計モデルを作るときには、どれくらいデータにうまく合っているかと、モデルがどれくらい複雑かという二つのことを考えなければなりません。データにぴったり合うモデルが良いように思えますが、実は、学習に使ったデータだけに合うように作られた、複雑すぎるモデルになってしまうことがあります。このような状態を「過学習」と言います。過学習を防ぐためには、モデルはなるべく単純な方が良いと考えられています。つまり、データへの当てはまりとモデルの複雑さのバランスが重要になります。赤池情報量基準は、このバランスをうまく捉えて、モデルを適切に評価するための基準です。

赤池情報量基準とは

赤池情報量基準(AIC)は、統計的な計算式を用いて、いろいろな予測式の中から最も良いものを選ぶための方法です。たとえば、商品の売れ行きを予想する式を作りたいとします。売れ行きに影響を与える要素として、商品の値段や広告費、気温など様々なものが考えられます。これらの要素を組み合わせて、いくつもの予測式を作ることができます。しかし、要素を多く含む複雑な式は、過去のデータによく合うように作れても、未来の売れ行きを正しく予測できるとは限りません。AICは、このような予測式の複雑さと、過去のデータへの当てはまりの良さをバランスよく評価し、最適な式を選ぶために使われます。

具体的には、AICは「当てはまりの良さ」を表す指標と「複雑さ」を表す指標を組み合わせて計算されます。「当てはまりの良さ」は、予測式が過去のデータにどれだけ近いかを示す値で、値が小さいほど過去のデータによく合っています。「複雑さ」は、予測式に含まれる要素の数で決まり、要素が多いほど複雑になります。AICは、これらの指標を組み合わせ、「当てはまりの良さ」の指標をなるべく小さく、「複雑さ」の指標もなるべく小さくすることで、最も良いバランスの取れた予測式を選びます。

AICを使うことで、過去のデータに過剰に適合した複雑すぎる式を選ぶことを避けることができます。これは、将来の予測精度を高める上で非常に重要です。AICは、様々な分野で予測式を選ぶ際に広く使われており、データ分析を行う上で非常に役立つ方法です。計算は少し複雑ですが、統計ソフトなどを使えば簡単に計算できます。複数の予測式の中から最適なものを選ぶ際には、ぜひAICを活用してみてください。

| 項目 | 説明 |

|---|---|

| 赤池情報量基準(AIC) | 統計的な計算式を用いて、様々な予測式の中から最適なものを選ぶ方法 |

| 目的 | 予測式の複雑さと過去のデータへの当てはまりの良さをバランスよく評価し、最適な式を選ぶ |

| 評価指標 | 当てはまりの良さ、複雑さ |

| 当てはまりの良さ | 予測式が過去のデータにどれだけ近いかを示す値。値が小さいほど、当てはまりが良い。 |

| 複雑さ | 予測式に含まれる要素の数。要素が多いほど複雑。 |

| AICの計算 | 「当てはまりの良さ」と「複雑さ」を組み合わせて計算。両方の指標をなるべく小さくすることで、最適なバランスを見つける。 |

| 利点 | 過去のデータに過剰に適合した複雑すぎる式を選ぶことを避け、将来の予測精度を高める。 |

| 活用例 | 様々な分野で予測式を選ぶ際に広く使用。 |

当てはまりと複雑さの両立

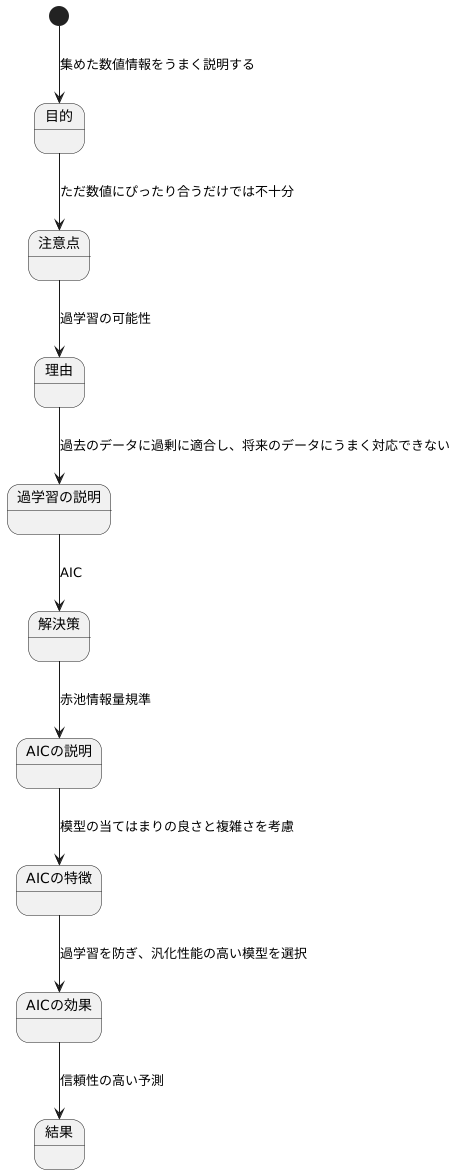

{統計的な模型を作る目的は、集めた数値情報をうまく説明することです。}けれども、ただ単に数値にぴったり合う模型を作れば良いというものではありません。例えば、過去の販売実績の数値に完全に一致する複雑な模型を作ったとしましょう。一見すると完璧な模型に見えますが、この模型は将来の販売実績を予測する際には、うまく働かない可能性があります。

これは、過去の数値の細かい上がり下がりまで覚え込んでしまい、将来の数値に当てはめることができないからです。このような現象を「過学習」と言います。

「過学習」とは、いわば過去の試験問題の解答を丸暗記したような状態で、少し問題が変わると途端に解けなくなってしまう状態です。統計的な模型を作る際には、この「過学習」を避けることが重要になります。

そこで登場するのが「AIC」と呼ばれる指標です。AICは「赤池情報量規準」の略で、統計学者である赤池弘次氏が提唱したものです。

AICは、模型の当てはまりの良さだけでなく、模型の複雑さも考慮に入れた指標です。複雑な模型は、たくさんの部品を組み合わせて作られた精巧な機械のようなものです。部品が多いほど、過去のデータに細かく合わせることができますが、将来のデータにはうまく対応できない可能性があります。

AICは、模型の複雑さを「罰則」として加えることで、過学習を防ぎ、将来のデータにも対応できる、汎化性能の高い模型を選ぶのに役立ちます。つまり、AICを用いることで、過去のデータにもよく当てはまり、かつ将来のデータにも対応できる、バランスの取れた模型を選ぶことができるのです。

これは、過去の試験問題の傾向を理解し、応用力も身につけるような学習方法に似ています。丸暗記ではなく、本質的な理解を深めることで、未知の問題にも対応できるようになるのです。AICも同様に、統計的な模型の本質的な良さを評価することで、より信頼性の高い予測を可能にします。

赤池情報量基準の計算方法

赤池情報量基準(AIC)は、統計モデルの良さを評価するための指標です。複数のモデルの中から、どれがデータに最もよく当てはまっているかを選ぶ際に役立ちます。AICは、モデルの当てはまりの良さとモデルの複雑さのバランスを考慮して計算されます。

まず、モデルの当てはまりの良さは、対数尤度という値で評価します。対数尤度は、観測されたデータが、そのモデルからどれくらいの確率で生じるかを示す指標です。対数尤度の値が大きいほど、モデルはデータをよく説明できていると考えられます。つまり、モデルがデータにうまく当てはまっているほど、対数尤度は大きくなります。

次に、モデルの複雑さは、モデルに含まれるパラメータの数で評価します。パラメータとは、モデルを特定するために必要な値のことです。例えば、直線を表す式 y=ax+b には、傾きaと切片bという2つのパラメータがあります。パラメータの数が多いほど、モデルは複雑になります。複雑なモデルは、データに過剰に適合してしまう可能性があります。過剰適合とは、モデルが学習データの特徴を捉えすぎてしまい、新しいデータに対する予測精度が低下する現象です。

AICは、これらの2つの要素を組み合わせて計算されます。具体的には、AIC=-2×(対数尤度)+2×(パラメータ数)という式で計算されます。この式からわかるように、対数尤度が大きいほどAICは小さくなり、パラメータ数が大きいほどAICは大きくなります。つまり、AICは、モデルの当てはまりの良さと複雑さのバランスを評価していると言えます。複数のモデルを比較する場合、AICが最も小さいモデルが、最も良いモデルと判断されます。

AICを用いることで、様々な統計モデルを客観的に比較し、最適なモデルを選択することができます。これは、データ分析を行う上で非常に重要なプロセスです。

| 項目 | 説明 |

|---|---|

| 赤池情報量基準(AIC) | 統計モデルの良さを評価する指標。複数のモデルから最適なものを選択する際に使用。 |

| 対数尤度 | モデルの当てはまりの良さの指標。観測データがモデルから生じる確率を示す。値が大きいほど、モデルはデータをよく説明できている。 |

| モデルの複雑さ | モデルに含まれるパラメータの数で評価。パラメータ数が多いほど複雑になる。 |

| パラメータ | モデルを特定するために必要な値。例:直線 y=ax+b の場合、傾きaと切片bの2つがパラメータ。 |

| 過剰適合 | 複雑なモデルが学習データに過剰に適合し、新しいデータへの予測精度が低下する現象。 |

| AICの計算式 | AIC = -2 × (対数尤度) + 2 × (パラメータ数) |

| AICの解釈 | AICが小さいほど良いモデル。対数尤度が大きく、パラメータ数が少ないモデルが選ばれる。 |

赤池情報量基準の使い方

複数の統計モデルの中から、どれが最もデータに適合しているかを選ぶことは、データ分析において非常に大切です。赤池情報量基準(AIC)は、まさにこのモデル選択を助ける強力な道具です。AICは、様々なモデルを比較し、データへの当てはまりの良さとモデルの簡潔さをバランス良く評価する基準です。

AICを使うためには、まず比較したい複数のモデルを用意します。例えば、商品の売上を予測したい場合、売上と広告費の関係を直線で表すモデルや、複雑な曲線で表すモデルなど、複数のモデルを考えられます。次に、それぞれのモデルについてAICを計算します。AICは、モデルがデータをどれくらいうまく説明できるかを表す指標と、モデルの複雑さを表す指標を組み合わせて計算されます。モデルが複雑になるほど、データへの当てはまりは良くなりますが、同時に過剰にデータに合わせこんでしまう危険性も高まります。AICは、この両方の側面を考慮することで、最適なバランスのモデルを選ぶことを可能にします。

AICは相対的な値であるため、一つのモデルのAICだけを見て、そのモデルが良いか悪いかを判断することはできません。必ず複数のモデルのAICを計算し、比較する必要があります。AICの値が最も小さいモデルが、データに最も適合したモデルと判断されます。例えば、売上予測モデルA、B、Cがあり、それぞれのAICが100、90、110だったとします。この場合、AICが最も小さいモデルBが、最もデータに適合したモデルと判断されます。

AICは便利な指標ですが、万能ではありません。あくまで統計的な指標の一つであり、モデルの良し悪しを完全に判断できるわけではありません。モデルの解釈のしやすさや、将来の予測性能など、AIC以外の要素も考慮して、総合的にモデルを評価することが重要です。また、AICは大量のデータがある場合に有効な指標であり、データが少ない場合は、他の情報量基準を使う方が適切な場合もあります。様々な要因を考慮しながら、AICを適切に活用することで、より精度の高いデータ分析が可能になります。

| AICとは | 複数の統計モデルから最適なモデルを選択するための基準 |

|---|---|

| 目的 | データへの当てはまりの良さとモデルの簡潔さのバランスを評価 |

| 使い方 |

|

| AICの計算 | モデルのデータへの当てはまりを表す指標とモデルの複雑さを表す指標を組み合わせて計算 |

| AICの解釈 | 相対的な値であり、複数のモデルのAICを比較して、最小のモデルが最適と判断 |

| AICの注意点 |

|

他のモデル選択基準との比較

様々な統計モデルの中から、最適なものを選ぶことは、データ分析において非常に大切です。最適なモデルとは、データの特徴をうまく捉えつつ、複雑すぎないモデルのことを指します。このモデル選択のために、様々な基準が提案されています。よく知られている基準の一つに、赤池情報量基準、いわゆるAICがあります。 AIC以外にも、様々なモデル選択基準が存在します。例えば、ベイズ情報量基準、BICや、最小記述長、MDLなどです。これらの基準は、それぞれ異なる考え方や特徴を持っています。

AICは、予測の良さを重視した基準です。AICが小さいモデルほど、将来のデータに対する予測精度が高いと期待されます。一方で、BICはAICよりもモデルの複雑さをより強く罰する傾向があります。つまり、同じデータに対して、AICでは複雑なモデルが選ばれる場合でも、BICではより単純なモデルが選ばれることがあります。これは、BICが真のモデル、つまりデータを生み出した真の構造に近いモデルを選択することを目的としているからです。真のモデルは必ずしも複雑とは限らないという考え方に基づいています。

MDLは、データとモデルを符号化、つまり一定の規則に基づいて短い記号列に変換するために必要なビット数、情報量を最小にするモデルを選択します。MDLは、データの圧縮という観点からモデル選択を行う基準と言えるでしょう。MDLで選ばれたモデルは、データに含まれる情報を効率的に表現できるモデルです。

このように、AIC、BIC、MDLはそれぞれ異なる特徴を持つため、データの性質や分析の目的に合わせて適切な基準を選択する必要があります。例えば、データの数が少ない場合は、AICよりもBICの方が真のモデルに近いモデルを選択できる可能性が高いため、BICが適している場合があります。また、モデルの解釈性を重視する場合、つまり、モデルから得られる知見を分かりやすく説明したい場合は、MDLの方が適している場合があります。これは、MDLによって選ばれたモデルが、データの本質的な構造を捉えている可能性が高いためです。目的に最適なモデル選択基準を選ぶことで、より精度の高い分析が可能になります。

| モデル選択基準 | 考え方 | 特徴 | 適切な場合 |

|---|---|---|---|

| AIC (赤池情報量基準) | 予測の良さ | 将来のデータに対する予測精度が高いモデルを選択 | – |

| BIC (ベイズ情報量基準) | 真のモデルに近いモデルを選択 | AICよりもモデルの複雑さを強く罰する。データ数が少ない場合に適している。 | データ数が少ない場合 |

| MDL (最小記述長) | データとモデルの符号化に必要なビット数を最小化 | データの圧縮という観点からモデル選択。モデルの解釈性を重視する場合に適している。 | モデルの解釈性を重視する場合 |

まとめ

統計モデルを構築する際には、データにどれだけうまく当てはまっているかだけでなく、モデルの複雑さも考慮する必要があります。複雑すぎるモデルは、観測データにはよく合致するかもしれませんが、将来のデータに対する予測性能は低い可能性があります。これは、過学習と呼ばれる現象です。

赤池情報量基準(AIC)は、このモデルの当てはまり具合と複雑さのバランスを評価するための指標です。AICは、モデルの対数尤度(データへの当てはまり具合を示す指標)からモデルのパラメータ数(複雑さを示す指標)を引いた値で計算されます。AICが小さいほど、良いモデルとされます。

具体的には、複数のモデルの中からAICが最小のモデルを選ぶことで、過学習を避け、将来のデータにもよく合うモデルを選択することができます。たとえば、売上予測モデルをいくつか作った場合、AICを用いて最適なモデルを選ぶことができます。

AICは万能ではありません。あくまでも統計的な指標の一つであり、他の指標も参考にしながら総合的に判断する必要があります。例えば、モデルの解釈のしやすさや、実務的な観点なども考慮に入れるべきです。また、AICは相対的な比較に用いるもので、AICの値自体に絶対的な意味はありません。複数のモデルを比較した際に、AICが最も小さいモデルが相対的に良いモデルであると判断できます。

AIC以外にも、ベイズ情報量基準(BIC)やクロスバリデーションなど、様々なモデル選択基準が存在します。これらの基準は、それぞれ異なる考え方や特徴を持っているため、データの特性や分析の目的に合わせて適切な基準を選択することが重要です。AICを正しく理解し、他の基準と組み合わせて適切に利用することで、より精度の高い予測や分析を行うことができます。

| 項目 | 説明 |

|---|---|

| 赤池情報量基準(AIC) | モデルの当てはまり具合と複雑さのバランスを評価するための指標。AICが小さいほど良いモデル。 |

| AICの計算方法 | モデルの対数尤度 – モデルのパラメータ数 |

| AICの目的 | 過学習を避け、将来のデータにもよく合うモデルを選択する。 |

| AICの注意点 |

|

| AIC以外のモデル選択基準 | ベイズ情報量基準(BIC)、クロスバリデーションなど |