AIの透明性:信頼への道

AIを知りたい

先生、AIの『透明性』ってよく聞くんですけど、難しくてよくわからないです。簡単に説明してもらえますか?

AIエンジニア

そうだね、難しいよね。『透明性』というのは、AIがどういう根拠でその答えを出したのかがわかるかどうかということだよ。例えば、AIが『この人は病気です』と診断した時、なぜそう判断したのか理由がわからないと困るよね?

AIを知りたい

確かにそうですね。理由がわからないと不安です。どうすればAIの判断の理由がわかるようになるんですか?

AIエンジニア

色々な方法が研究されているんだけど、例えば、AIが注目した情報を見えるようにしたり、判断の過程を段階的に説明できるようにしたりする方法などがあるよ。ただ、完全にわかるようにするのはまだ難しいんだ。

透明性とは。

人工知能に関する言葉で「透明性」というものがあります。今のよく使われている人工知能の多くは、深層学習という方法を使っています。これはとてもたくさんの調整する点があって、入力したものと出力されたものの関係が複雑で、中身がどうなっているのか分からなくなってしまいやすいのです。例えるなら、黒い箱の中身が見えないような感じです。このため、どうしてそういう結果になったのかを理解するのがとても難しいという問題があります。特に医療などに使われる場合は、この問題の影響が大きいことは想像できるでしょう。そこで、人工知能が出した結果に至るまでの過程を、できるだけ分かりやすくしようという取り組みが行われています。分かりやすくする方法はいくつか提案されていて、大切な特徴を判断する手法としてシャープ(SHAP)やライム(LIME)といったものがあります。しかし、完全に分かりやすくすることは難しく、技術の進歩に加えて、倫理的な指針を作ることや利用者との話し合いが大切です。

説明責任の必要性

近頃、人工頭脳は、暮らしの様々な場面で見かけるようになり、私たちの生活を大きく変えています。病気の診断やお金のやり取り、車の自動運転など、人工頭脳の活躍の場は広く、その影響力は日に日に増しています。しかし、人工頭脳、特に深い学びを使った仕組みは、複雑な作りと膨大な要素を持つため、どのように判断しているのか人間には分かりにくいという問題があります。これは「黒い箱」と呼ばれ、人工頭脳の判断の理由がはっきりしないことから、信頼できるか、責任の所在はどこにあるのかという点で心配の声が上がっています。

例えば、病気の診断で人工頭脳が間違った判断をした場合、その原因が分からなければ正しい対策を立てることはできません。車の自動運転で事故が起きた場合、人工頭脳の責任はどこまでなのかをはっきりさせるためには、どのような判断をしたのかを調べられるようにしておく必要があります。このように、人工頭脳の判断の過程を明らかにすることは、安全に使うため、そして皆が安心して受け入れるために欠かせません。

人工頭脳が信頼できるものとなるためには、その判断の過程を人間が理解し、確かめられる仕組みが必要です。具体的には、人工頭脳がどのような情報をもとに、どのような手順で判断に至ったのかを記録し、分かりやすく示す必要があります。また、人工頭脳の判断に偏りがないか、倫理的に問題がないかをチェックする仕組みも必要です。さらに、人工頭脳の開発者や利用者は、責任ある行動を心がけ、問題が発生した場合には適切な対応をとる必要があります。人工頭脳は、私たちの生活を豊かにする大きな可能性を秘めていますが、その恩恵を最大限に受けるためには、透明性と責任ある利用を徹底することが重要です。今後、人工頭脳技術がさらに発展していく中で、これらの課題に取り組み、信頼できる人工頭脳を実現していく努力が求められます。

| 項目 | 内容 |

|---|---|

| 人工知能の現状 | 様々な場面で活用され、生活を変えているが、判断過程が不透明な「黒い箱」問題がある。 |

| 問題点 | 判断過程が不明瞭なため、信頼性、責任所在に懸念がある。誤診や事故発生時の原因究明や責任判断が困難。 |

| 具体例 | 医療診断の誤診、自動運転車の事故 |

| 解決策 | 判断過程の記録と可視化、偏りや倫理的問題のチェック、開発者・利用者の責任ある行動、透明性と責任ある利用の徹底。 |

| 将来展望 | 技術発展に伴い、課題解決と信頼できるAIの実現が必要。 |

透明化に向けた取り組み

人工知能が物事をどのように判断しているのか、その過程が分かりにくいという問題があります。この、中身が見えない箱のような状態を『ブラックボックス』と呼び、この問題を解決するために多くの研究者が取り組んでいます。その研究の中心にあるのが『説明できる人工知能』と呼ばれる技術です。この技術は、人工知能の判断過程を人が理解できる言葉で説明できるようにすることを目指しています。

具体的には、入力されたデータのどの部分が人工知能の判断に影響を与えたのか、あるいはどのような理由でその判断に至ったのかを、図表などを用いて分かりやすく示す技術が開発されています。よく使われる方法としては、『シェープリー加法説明』や『局所解釈可能モデルに依存しない説明』などがあります。これらの方法は、人工知能が判断した根拠を特定し、人が理解しやすい形で示すことで、人工知能の判断過程を明らかにすることを目指しています。まるで、人工知能の思考過程を覗き込むかのように、その判断の理由を理解できるようになるのです。

しかし、これらの方法にもまだ課題が残っています。特に、複雑な仕組みを持つ人工知能の判断過程を完全に明らかにすることは、依然として難しい課題です。そのため、技術的な進歩を続けるだけでなく、人工知能を使う上での倫理的な指針を定めたり、利用者と意見交換をするなどして、人工知能の透明性について、より深く理解していく必要があります。人工知能が社会にとってより良いものとなるためには、その判断過程を分かりやすく説明できる仕組みが不可欠であり、今後の更なる発展が期待されます。

| 問題点 | 解決策 | 具体的な方法 | 課題 | 今後の展望 |

|---|---|---|---|---|

| 人工知能の判断過程が分かりにくい(ブラックボックス問題) | 説明できるAI技術の開発 | シェープリー加法説明、局所解釈可能モデルに依存しない説明(LIME)など | 複雑なAIの判断過程を完全に説明することは困難 | 技術的進歩、倫理指針策定、利用者との意見交換などを通してAIの透明性を高める |

倫理的な側面

人工知能は、私たちの暮らしを大きく変える力を持っています。便利な道具であると同時に、使い方を誤ると社会に悪影響を与える可能性も秘めています。そのため、人工知能の開発や利用には、倫理的な配慮が欠かせません。

人工知能が社会に広く受け入れられるためには、その仕組みの透明性が重要です。人工知能は、大量のデータから規則やパターンを学び、それをもとに判断や予測を行います。もし、学習に使われたデータに偏りがあれば、人工知能の判断にも偏りが生じ、差別や不公平につながる恐れがあります。例えば、採用活動に人工知能を使う場合、過去の採用データに女性が少ないという偏りがあれば、人工知能も女性を不利に評価してしまう可能性があります。このような事態を防ぐためには、学習データの内容を公開し、偏りがないか確認できるようにする必要があります。

また、人工知能の判断の過程も明らかにしておく必要があります。人工知能が出した結論だけでなく、なぜそのような結論に至ったのか、その根拠を示すことが大切です。もし、人工知能が不適切な判断をした場合、その原因を特定し、修正するためにも、判断過程の透明性は必要不可欠です。

さらに、人工知能の利用目的を明確にし、人権を侵害しないように注意を払う必要があります。人工知能は、個人に関する大量の情報を扱うため、プライバシー保護の観点からも慎重な対応が求められます。人工知能の開発者や利用者は、倫理的な責任を強く認識し、社会にとってより良い形で人工知能を活用していく必要があるでしょう。

| 項目 | 内容 |

|---|---|

| 人工知能の性質 | 便利な道具だが、使い方を誤ると社会に悪影響を与える可能性あり |

| 倫理的な配慮の必要性 | 開発や利用には倫理的な配慮が不可欠 |

| 透明性の重要性 | 社会に広く受け入れられるためには、仕組みの透明性が重要 |

| 学習データの偏り | 偏りのあるデータで学習すると、人工知能の判断にも偏りが生じ、差別や不公平につながる恐れあり |

| 偏りの対策 | 学習データの内容を公開し、偏りがないか確認できるようにする |

| 判断過程の透明性 | 結論だけでなく、根拠を示すことが重要。不適切な判断の場合、原因特定と修正に必要 |

| 利用目的の明確化 | 人権を侵害しないよう、利用目的を明確にする |

| プライバシー保護 | 個人情報扱うため、プライバシー保護の観点からも慎重な対応が必要 |

| 開発者・利用者の責任 | 倫理的な責任を強く認識し、社会にとってより良い形で活用していく必要あり |

人とAIの協調

人工知能(AI)は目覚ましい発展を遂げ、私たちの暮らしの様々な場面で活用され始めています。しかし、AIは万能ではありません。AIはあくまでも道具であり、その能力を最大限に引き出すためには、人とAIの協調が欠かせません。

AIによる判断過程の透明性を高めることは、人とAIが協調していく上で非常に重要です。AIがどのように結論に至ったのかを人が理解できるようにすることで、AIに対する信頼感が高まります。もし、AIの判断に誤りがあった場合でも、その原因を特定し、修正することが容易になります。これは、AIをより安全に、そして効果的に利用することに繋がります。

AIは膨大な量の情報を処理し、複雑な計算を行うことができますが、人間の持つ経験や直感、倫理観などは持ち合わせていません。最終的な判断は、常に人間が行うべきです。AIが出した結果を鵜呑みにするのではなく、人間がその妥当性を検証し、必要に応じて修正を加えることが大切です。例えば、医療診断の場面でAIが病気を診断した場合でも、最終的な診断は医師が行い、患者の状況に合わせて治療方針を決定します。

AIと人間はそれぞれ異なる強みを持っています。AIは大量のデータ処理や反復作業が得意であり、人間は創造性や倫理的な判断が得意です。互いの強みを理解し、AIを人間の活動を支援する道具として適切に活用することで、より効率的に作業を進め、より良い結果を得ることが可能になります。

人とAIが協調し、互いに補完し合うことで、様々な課題を解決し、より良い社会を実現できると考えられます。そのためには、AIに対する理解を深め、AIとどのように協調していくかを考えていくことが重要です。

| 項目 | 説明 |

|---|---|

| AIの役割 | 道具、人間の活動を支援 |

| AIの強み | 膨大な情報処理、複雑な計算、大量のデータ処理、反復作業 |

| AIの弱み | 経験、直感、倫理観の欠如 |

| 人とAIの協調の重要性 | AIの能力を最大限に引き出すため、より良い結果を得るため、様々な課題を解決し、より良い社会を実現するため |

| AIの透明性の重要性 | AIへの信頼感向上、誤りの原因特定と修正の容易化、安全で効果的な利用 |

| 最終判断 | 常に人間が行う |

| 人間の役割 | AIの妥当性検証、必要に応じた修正、創造性、倫理的な判断 |

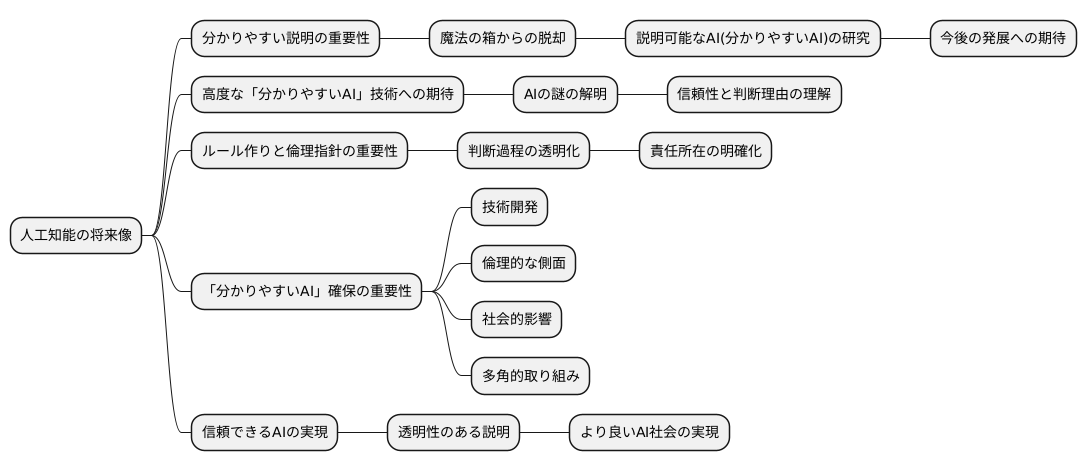

今後の展望

人工知能の将来像を考える上で、その仕組みを分かりやすく説明できることは大変重要です。現在、人工知能の内部 workings は複雑で、まるで魔法の箱のように扱われがちです。この「魔法の箱」状態を解消し、どのように判断や予測に至るのかを明らかにする研究が盛んに行われています。この研究分野は、説明可能な人工知能、つまり「分かりやすい人工知能」と呼ばれ、今後の発展が期待されています。

今後、さらに高度な「分かりやすい人工知能」技術が開発されることで、人工知能の謎めいた部分が解き明かされると期待されます。これにより、人工知能が出した結果が本当に信頼できるものなのか、どのような理由でその結果に至ったのかを理解できるようになります。また、人工知能を使う際のルール作りや倫理的な指針を示すことも重要です。人工知能が社会の様々な場面で使われるようになるにつれて、その判断過程を透明化し、責任の所在を明確にする必要性が高まっています。

人工知能技術の進歩と社会への導入が進む中で、「分かりやすい人工知能」の確保に向けた取り組みはますます重要性を増していくでしょう。技術的な開発だけでなく、倫理的な側面や社会的な影響についても深く考える必要があります。技術開発、倫理的な検討、そして社会全体での話し合い、これら3つのバランスを取りながら、多角的に取り組むことが求められます。人工知能が真に信頼できる存在となり、社会に役立つものとなるためには、その仕組みを分かりやすく説明できることが不可欠です。今後も、人工知能の透明性について議論を深め、より良い人工知能社会を実現するために、たゆまぬ努力を続けていく必要があります。