AIの責任:信頼を築く大切な要素

AIを知りたい

先生、「アカウンタビリティ」って言葉、AIの文脈でよく聞くんですけど、何のことかよくわかっていないんです。説明してもらえますか?

AIエンジニア

そうだね。「アカウンタビリティ」は簡単に言うと「説明責任」のことだよ。AIが何か問題を起こした時、なぜそうしたのか、誰が責任を持つのかをはっきりさせる必要があるんだ。

AIを知りたい

なるほど。でも、AI自身が責任を持つのは難しそうですね…。

AIエンジニア

その通り。だから、AIの開発者や使用者など、AIに関わる人たちが、AIの動作や結果に対して責任を持つ必要がある。AIの仕組みを分かりやすく説明できるようにしたり、問題が起きた時の対応を決めておくことも「アカウンタビリティ」の一つと言えるね。

アカウンタビリティとは。

人工知能に関する言葉である「アカウンタビリティ」(人工知能や機械学習システムにおけるアカウンタビリティ)について説明します。

説明責任の重要性

近ごろ、人工知能が暮らしの様々な場面で見られるようになってきました。それに伴い、人工知能が出した答えに対して、誰がどのように責任を持つのかという問題が、ますます大切になってきています。人工知能の判断は、複雑な計算に基づいて行われるため、その過程を人が理解するのは容易ではありません。もし問題が起きた時、責任の所在をはっきりさせることが難しい場合もあります。

そのため、人工知能システムを作る時、動かす時、そして使う時に、説明責任をはっきりさせることが欠かせません。人工知能への信頼を築き、社会に広く使ってもらうためには、人工知能の行動や結果に対して、誰がどのような責任を持つのかを、きちんと決めて、関係者で共有する必要があります。これは、人工知能システムがどのように動くのかを分かりやすくし、使う人や社会全体の理解と信頼を得るためにも、とても大切です。

また、問題が起きた時の対応策を前もって決めておくことで、迅速かつ適切な対応ができ、被害が広がるのを防ぐことにも繋がります。例えば、人工知能が誤った判断をした場合、誰がどのように訂正し、影響を受けた人にどのように対応するのかを、あらかじめ決めておく必要があります。さらに、人工知能の開発や運用に携わる人たちが、倫理的な考え方を共有することも重要です。人工知能を、人々の生活を豊かにするために使うという意識を、関係者全員が持つことで、責任ある開発と運用が実現し、社会全体の利益につながるでしょう。

| 項目 | 内容 |

|---|---|

| 背景 | AIの普及に伴い、AIの判断に対する責任の所在が曖昧になっている。AIの判断過程は複雑で、人が理解しにくい。 |

| 課題 | 問題発生時の責任所在の明確化。AIへの信頼構築と社会普及のための説明責任の確立。 |

| 解決策 | AIシステムの開発・運用・利用時における責任分担の明確化と共有。AIの動作と結果の説明責任を果たすことで、利用者と社会の理解と信頼を得る。問題発生時の対応策を事前に決定し、迅速かつ適切な対応を行う。AI開発・運用関係者間で倫理的な考え方を共有し、責任ある開発と運用を実現する。 |

| 目的 | AIを人々の生活向上に役立てる。社会全体の利益に貢献する。 |

責任範囲の明確化

人工知能技術の利用が広まるにつれて、責任の所在を明らかにすることがますます重要になっています。人工知能システムの開発、運用、利用に関わる全ての人が、それぞれの役割において責任を負う必要があります。人工知能システムの開発者は、倫理的な指針に沿ってシステムを設計する責任があります。これは、偏見や差別を助長しないように配慮すること、個人のプライバシーを保護すること、そして説明責任を果たせるようにシステムを構築することを意味します。開発者は、システムの安全性と信頼性を確実にするために、厳密な試験を実施する必要もあります。潜在的な危険性や誤動作を早期に発見し、修正することで、利用者への悪影響を防ぐことができます。また、開発者は利用者にシステムの限界や適切な使用方法を明確に伝える責任も負っています。

人工知能システムの運用者は、システムが意図したとおりに動作するように維持管理する責任があります。定期的な点検や更新を行い、システムの性能を最適な状態に保つ必要があります。さらに、運用者は問題発生時に迅速かつ適切な対応をとる責任も負います。システムの誤動作や予期せぬ結果が生じた場合、原因を究明し、再発防止策を講じる必要があります。利用者への影響を最小限に抑え、信頼を維持するためには、迅速な対応が不可欠です。

人工知能システムの利用者は、システムの利用規約を遵守する責任があります。また、人工知能が出力した結果を無批判に受け入れるのではなく、自身の知識や経験に基づいて慎重に検討する必要があります。人工知能はあくまでも道具であり、最終的な判断は人間が行うべきです。利用者は、人工知能の特性と限界を理解し、責任ある行動をとる必要があります。これらの責任範囲を明確にすることで、人工知能システムに関わる全ての人が自らの役割を理解し、責任ある行動をとることが可能になります。そして、これこそ、人工知能技術を安全かつ効果的に利用していくために必要不可欠です。

| 役割 | 責任 |

|---|---|

| 開発者 |

|

| 運用者 |

|

| 利用者 |

|

透明性の高いAI構築

人工知能(じんこうちのう)の判断(はんだん)の仕組みは、複雑(ふくざつ)でわかりにくいことが多く、その判断がなぜそうなるのかを説明することが難しい場合があります。そのため、人工知能を使ったシステムがどのような責任(せきにん)を持つのかを明らかにするためには、人工知能の仕組みをわかりやすくすることがとても重要です。人工知能がどのような情報をもとに、どのように判断を下したのかを、人が理解できる形で説明できる必要があります。

説明可能な人工知能(せつめいかのうなじんこうちのう)と呼ばれる技術(ぎじゅつ)は、人工知能の判断の仕組みを目に見えるようにし、人が理解できるように説明することを目的としています。この技術を使うことで、人工知能がなぜそのような判断をしたのかという理由を明らかにし、システムへの信頼感を高めることができます。

たとえば、ある人工知能が猫の画像を「猫」と判断したとします。説明可能な人工知能であれば、「耳の形」「目の形」「ひげ」といった具体的な特徴をもとに判断したことを示すことができます。従来の人工知能では、このような判断の根拠を人が理解することは困難でした。

また、人工知能システムが使う情報の透明性を確保することも重要です。どのような情報がどのように集められ、どのように使われているのかを明らかにすることで、人工知能システムの偏りや不公平さを防ぐことができます。たとえば、特定の地域の情報だけが学習データに使われていると、その地域に偏った判断をする可能性があります。情報の透明性を高めることで、このような偏りを防ぎ、より公正な人工知能システムを実現することができます。

透明性の高い人工知能システムを構築することは、人工知能の信頼性を高め、社会への普及を促進するために不可欠です。今後、人工知能が様々な分野で活用されるにつれて、透明性の重要性はますます高まっていくでしょう。

| 項目 | 内容 |

|---|---|

| 人工知能の判断の仕組み | 複雑でわかりにくく、説明が難しい |

| 説明可能なAIの目的 | AIの判断の仕組みを目に見えるようにし、人が理解できるように説明する |

| 説明可能なAIの例 | 猫の画像を「猫」と判断する際に、「耳の形」「目の形」「ひげ」といった具体的な特徴をもとに判断したことを示す |

| 情報の透明性の重要性 | AIシステムが使う情報の透明性を確保することで、偏りや不公平さを防ぐ |

| 情報の透明性の例 | 特定の地域の情報だけが学習データに使われていると、その地域に偏った判断をする可能性があるため、情報の透明性を高めることで偏りを防ぐ |

| 透明性の高いAIシステムの構築 | AIの信頼性を高め、社会への普及を促進するために不可欠 |

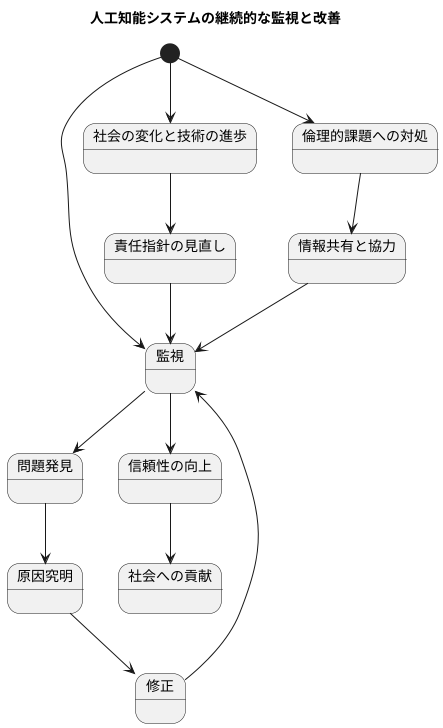

継続的な監視と改善

人工知能システムは、一度作り上げたらそれで終わりというわけではありません。あたかも生き物のように、常に変化する状況に合わせて育て、より良いものへと磨き上げていく必要があります。この継続的な監視と改善こそが、人工知能システムを安全に、そして社会にとって有益なものとしていく上で欠かせません。

まず、人工知能システムが社会にどのような影響を与えるのかを注意深く見守る必要があります。人々の生活を豊かにするのか、それとも新たな問題を生み出しているのか。もし問題があれば、速やかに原因を突き止め、修正していく必要があります。これは、まるで医師が患者の状態を常に観察し、適切な処置を施すのと同じように、人工知能システムにとっても必要不可欠なプロセスです。

また、私たちの社会は常に変化しており、技術も進歩し続けています。人工知能システムの責任の所在を明確にするための指針も、こうした変化に合わせて見直していく必要があります。例えば、新しい法律ができたり、技術的な革新によって人工知能の能力が向上したりした場合、それに合わせて責任の範囲や内容も調整する必要があるでしょう。

人工知能技術は日進月歩で進化を続けており、それに伴い、倫理的な課題も次々と生まれてきます。例えば、人工知能が人間の仕事を奪うのではないか、あるいは個人情報が悪用されるのではないかといった懸念があります。これらの課題に適切に対処するためには、人工知能システムの開発者、運用者、そして利用者が互いに最新の情報を共有し、協力していくことが不可欠です。まるでチームで一つの船を漕ぎ進めるように、全員が同じ方向を目指して努力することで、人工知能システムをより良いものへと導くことができます。

このように、継続的な監視と改善によって、人工知能システムの信頼性を保ち、社会への貢献を高めることができます。人工知能は、正しく使えば私たちの生活を大きく豊かにする可能性を秘めています。だからこそ、責任を持って育て、社会にとって真に役立つ存在へと成長させていく必要があるのです。

多様な関係者による協力

人工知能という技術が広く使われるようになり、その責任の所在を明らかにすることが課題となっています。これは、特定の人や組織だけが取り組むべき問題ではなく、様々な立場の人々が力を合わせる必要があるのです。人工知能を作る人、使う人、管理する人だけでなく、国や地方自治体、研究所、市民団体など、多くの関係者が知恵を出し合い、協力していく必要があります。

それぞれの立場によって、人工知能に対する考え方や感じ方は違います。だからこそ、それぞれの考えを共有し、理解し合うことが重要です。立場が違う人々が議論することで、より良い対策を考え出すことができるでしょう。人工知能は私たちの社会全体に大きな影響を与える可能性を秘めています。だからこそ、社会全体で人工知能の責任について話し合い、責任ある開発と利用を進めていく必要があります。

人工知能は急速に発展しており、使い方によっては社会に大きな利益をもたらす一方で、予想外の害をもたらす可能性も否定できません。そのため、人工知能の倫理的な指針やルール作りにおいても、様々な立場の人々の協力が不可欠です。どのような技術が良いのか、悪いのかを判断する基準や、問題が起きた際の責任の所在、適切な利用方法などを、皆で話し合い、決めていく必要があります。

開かれた議論と協力を通してこそ、人工知能を社会にとって有益なものへと導くことができるのです。未来の社会をより良いものにするために、皆で協力して人工知能との付き合い方を考えていく必要があります。人工知能という新しい技術とどのように向き合っていくのか、共に未来を築いていくためにも、多様な関係者による協力が不可欠なのです。

| 立場 | 役割 |

|---|---|

| 人工知能を作る人 | 倫理的な指針やルールに基づいた開発、責任ある技術の提供 |

| 人工知能を使う人 | 適切な利用方法の理解、問題発生時の対応 |

| 人工知能を管理する人 | 利用状況の監視、ルール違反への対処 |

| 国・地方自治体 | 法整備、ガイドライン策定、社会基盤の整備 |

| 研究所 | 技術研究、リスク評価、倫理的課題の検討 |

| 市民団体 | 市民への啓発活動、意見提言、監視活動 |

| 市民 | AIリテラシーの向上、意見表明、責任ある利用 |

社会全体の責任

人工知能の責任の所在をはっきりさせることは、特定の会社や人の問題ではなく、社会全体で取り組むべき重要な課題です。人工知能技術は目覚ましい速さで発展を続け、私たちの暮らしの様々な場面に入り込んでいます。だからこそ、人工知能が道徳的に問題なく、安全に使えるように、社会全体で責任を負う必要があります。

人工知能についての教育を進め、人工知能に関する知識や理解を深めることで、一人ひとりが人工知能と適切に関われる社会を作っていくことが大切です。子供たちから大人まで、人工知能がどのように動くのか、どのような影響を及ぼすのかを理解し、正しく使うための知識を身につける必要があります。学校教育だけでなく、地域社会や職場など、様々な場所で人工知能に関する学習機会を提供することで、より多くの人が人工知能と上手に付き合えるようになるでしょう。

また、人工知能の開発や使い方に関するルール作りにも、市民が積極的に加わることが必要です。専門家だけでなく、一般の人々も意見を出し合い、どのようなルールが必要なのか、どのように運用していくのかを議論することで、より多くの人にとって納得感のあるルールを作ることができます。人工知能は社会全体の財産となるものですから、その方向性を決める過程にも、広く市民の声が反映されるべきです。

人工知能技術の進歩は、私たちに多くの利益をもたらす可能性を秘めていますが、同時に危険性も持っています。社会全体で人工知能の責任の所在について考え、適切な方法を実行することで、人工知能の恩恵を最大限に受け、危険性を最小限に抑えることができるでしょう。人工知能は道具であり、使い方次第で良くも悪くもなります。だからこそ、社会全体で責任を持って人工知能と向き合い、より良い未来を築いていく必要があるのです。

| 項目 | 説明 |

|---|---|

| 責任の所在 | 特定の会社や人ではなく、社会全体で取り組むべき課題 |

| 教育の必要性 | 子供から大人まで、人工知能の仕組みや影響、正しい使い方を理解する必要がある |

| 教育の実施場所 | 学校、地域社会、職場など、様々な場所で学習機会を提供 |

| ルール作りへの参加 | 専門家だけでなく、一般市民もルール作りに積極的に参加する必要がある |

| 人工知能の性質 | 道具であり、使い方次第で良くも悪くもなる |

| 未来への展望 | 社会全体で責任を持って人工知能と向き合い、より良い未来を築く |