ADAM:最適化の賢者

AIを知りたい

先生、ADAMの説明で『勾配の小さい方向にもスムーズに更新が可能』ってあるんですけど、どういうことでしょうか?

AIエンジニア

いい質問だね。たとえば、RMSpropで使われている勾配の二乗和 *v* がとても大きくなってしまうと、更新量が小さくなってしまうよね?

AIを知りたい

はい、そうなると学習が進みにくくなりますよね。

AIエンジニア

そう。ADAMでは、 *v* の値が大きくても、モーメンタム項 *m* の影響で、更新を続けられるんだ。 *m* は過去の勾配の情報を蓄積しているので、たとえ現在の勾配が小さくても、過去の勾配の影響を受けて更新が行われる。だから、『勾配の小さい方向にもスムーズに更新が可能』なんだよ。

ADAMとは。

人工知能で使われる『アダム』という用語について説明します。アダムは、勢いと揺れ具合の調整を組み合わせた最適化の方法です。パラメータ(数値の調整)を更新する式は画像の通りで、勢いに関する調整を『み』で、揺れ具合に関する調整を『ぶい』で表しています。この方法を使うと、変化の少ない方向にも滑らかに更新を進めることができ、少なくとも学習は進むため、最初に試すのに適しています。

はじめに

機械学習は、まるで人間の学習のように、データから規則性やパターンを見つけ出す技術です。この技術をうまく使うためには、学習モデルの調整が欠かせません。この調整作業は最適化と呼ばれ、様々な方法が研究されています。その中で、近年、ADAMという手法が注目を集めています。ADAMは、他の手法と比べて、より効率的に、そして安定して学習モデルを調整できるという利点があります。

ADAMは、過去の調整結果を踏まえながら、次にどのように調整するかを判断します。具体的には、過去の調整量を記憶し、その情報を用いて、次の調整量を計算します。この時、調整量の大きさだけでなく、調整する方向も重要です。ADAMは、過去の調整方向も考慮することで、より正確に最適な値へと近づいていきます。まるで、過去の経験を活かして、より良い判断を下していく人間の学習過程のようです。

ADAMは、様々な分野で応用されています。例えば、画像認識の分野では、ADAMを用いることで、画像に写っている物体をより正確に識別できるようになります。また、自然言語処理の分野では、ADAMを用いることで、文章の意味をより深く理解できるようになります。このように、ADAMは、機械学習の様々なタスクにおいて、その性能を向上させるために役立っています。

ADAMは、計算の負担が比較的軽いため、大規模なデータセットにも適用可能です。さらに、複雑なモデルにも対応できる柔軟性も備えています。これらの利点から、ADAMは、機械学習の実務家にとって非常に有用な手法と言えるでしょう。今後、ADAMはさらに進化し、より高度な機械学習技術の発展に貢献していくことが期待されます。

| 項目 | 内容 |

|---|---|

| 定義 | データから規則性やパターンを見つけ出す技術 |

| 学習モデル調整 | 最適化と呼ばれる調整作業が必要 |

| ADAM | 効率的・安定的に学習モデルを調整できる手法 |

| ADAMの特徴 | 過去の調整結果(量と方向)を記憶し、次の調整量を計算 |

| 応用分野 | 画像認識、自然言語処理など |

| 利点 | 計算の負担が軽い、大規模データセットに適用可能、複雑なモデルに対応できる |

| 将来性 | より高度な機械学習技術の発展に貢献 |

ADAMの仕組み

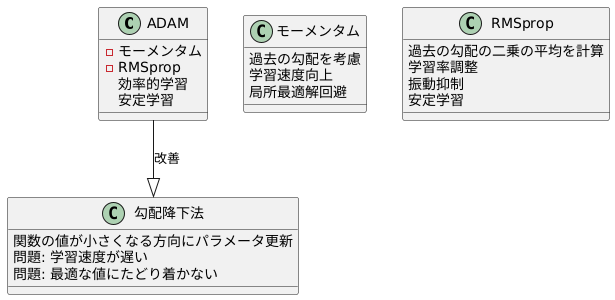

ADAM(アダム)は、機械学習でよく使われる最適化手法の一つで、勾配降下法を改良したものです。勾配降下法は、山の斜面を下るように、関数の値が小さくなる方向に向かってパラメータを更新していく手法です。しかし、単純な勾配降下法では、学習の進みが遅かったり、最適な値にたどり着かなかったりする問題があります。そこで、ADAMは、「モーメンタム」と「RMSprop」という二つの工夫を組み合わせることで、これらの問題を解決しています。

モーメンタムは、過去の勾配の情報を考慮することで、パラメータ更新の勢いを保ちます。これは、まるでボールが坂道を転がるように、勾配が小さい場所でも勢いによって進み続けるイメージです。これにより、学習の速度を上げ、局所的な最適解に陥ることを防ぎます。

一方、RMSpropは、過去に観測された勾配の二乗の平均を計算し、それを利用して学習率を調整します。勾配が大きい方向には学習率を小さく、勾配が小さい方向には学習率を大きくすることで、パラメータ更新の振動を抑え、安定した学習を実現します。これは、でこぼこした道を歩くときに、一歩一歩慎重に進むイメージです。

ADAMは、これらの二つの手法の利点を組み合わせることで、より効率的で安定した学習を実現しています。具体的には、パラメータを更新する際に、過去の勾配の情報を用いたモーメンタムの項と、過去の勾配の二乗の平均を用いたRMSpropの項を両方とも考慮します。これにより、勾配が小さい方向にもスムーズに進みつつ、振動を抑えて安定した学習を行うことができます。ADAMは、様々な機械学習のタスクで優れた性能を発揮することが知られており、広く利用されています。

ADAMの利点

ADAMは、機械学習における最適化アルゴリズムの一つであり、多くの利点を持っています。その中でも特に注目すべきは、学習の安定性と効率性の高さです。ADAMは、モーメンタムと呼ばれる手法とRMSpropと呼ばれる手法、それぞれの利点を組み合わせたアルゴリズムです。

モーメンタムは、過去の勾配の情報を用いて、現在の更新方向を決定する手法です。これにより、学習過程における振動や急激な変化を抑え、よりスムーズに最適解へと近づいていくことが可能になります。まるでボールが坂道を転がり落ちるように、勢いをつけながら最適解へと向かうイメージです。

一方、RMSpropは、過去の勾配の二乗平均平方根を用いて、学習率を調整する手法です。これにより、勾配の大きい方向への更新を抑え、勾配の小さい方向への更新を促進することができます。これは、まるででこぼこ道を歩く際に、大きな段差では慎重に、小さな段差では速く進むようなイメージです。

ADAMは、これら二つの手法を組み合わせることで、安定した学習を実現しながら、効率的に最適解へと近づいていくことが可能になります。さらに、ADAMはハイパーパラメータの調整が比較的容易であることも大きな利点です。学習率などのパラメータを適切に設定することで、画像認識や自然言語処理など、様々な問題に対して高い性能を発揮することができます。

また、ADAMは勾配の小さい方向にもスムーズに更新できるため、局所解に陥りにくいという特徴も持っています。局所解とは、最適解ではないものの、その近傍では最適な解のことです。従来のアルゴリズムでは、局所解に陥ってしまうと、そこから抜け出すのが難しい場合がありました。しかし、ADAMは、勾配の小さい方向にも適切に更新を行うことで、局所解を脱出し、より良い解、つまり大域的な最適解を見つけ出す可能性を高めます。これは、まるで山登りで、目の前の小さな丘に惑わされず、より高い山頂を目指すようなイメージです。

ADAMの応用例

ADAMは、様々な分野で応用されている、優れた学習方法です。その活用例をいくつかご紹介します。

まず、画像を認識する技術において、ADAMは重要な役割を担っています。写真に写っているものが何なのかをコンピュータに理解させるためには、大量の画像データを使って学習させる必要があります。この学習過程で、ADAMは効率的に学習を進めるための調整役を果たします。例えば、畳み込みニューラルネットワークと呼ばれる技術と組み合わせることで、高い精度で画像を認識することが可能になります。最近では、自動運転技術などにも応用され、周囲の状況を判断するために活用されています。

次に、私たちが日常的に使っている言葉、つまり自然言語を処理する技術においても、ADAMは活躍しています。文章を生成したり、異なる言語に翻訳したりする際に、ADAMは言葉の繋がりや意味を学習し、より自然で滑らかな文章を作り出すことを可能にします。例えば、ADAMを使って学習させた人工知能は、人間が書いたような文章を作成できるため、文章の要約や翻訳作業の効率化に役立っています。

さらに、人間の声を認識する技術である音声認識においても、ADAMは重要な役割を果たします。音声を認識するためには、音の波形の特徴を学習させる必要があります。ADAMはこの学習過程を最適化し、高い精度で音声を認識することを可能にします。例えば、スマートスピーカーや音声入力システムなど、私たちの生活に身近な技術にもADAMは活用されており、音声による機器操作をよりスムーズに行えるようになっています。

このように、ADAMは画像認識、自然言語処理、音声認識など、様々な分野で機械学習の精度向上に貢献しており、私たちの生活をより便利で豊かにする技術の発展を支えています。

| 分野 | ADAMの役割 | 応用例 |

|---|---|---|

| 画像認識 | 効率的な学習、高い精度での画像認識 | 自動運転技術、周囲の状況判断 |

| 自然言語処理 | 言葉の繋がりや意味の学習、自然で滑らかな文章生成 | 文章生成、翻訳、要約 |

| 音声認識 | 学習過程の最適化、高精度な音声認識 | スマートスピーカー、音声入力システム、音声による機器操作 |

他の最適化手法との比較

学習の効率を高める手法は様々ありますが、その中でもADAMは多くの場面で優れた成果を示します。ADAMは他の手法と比べて、どのような点が優れているのでしょうか。また、どのような点に注意が必要なのでしょうか。

まず、よく使われる手法の一つに、確率的勾配降下法(SGD)があります。SGDは勾配に従って段階的に最適な値を探しますが、ADAMはSGDよりも安定して学習を進めることができます。SGDは学習の過程で振動が起こりやすく、最適な値にたどり着くまでに時間がかかることがあります。一方、ADAMは過去の勾配の情報を利用することで、この振動を抑え、より効率的に最適な値へと近づきます。つまり、ADAMはSGDよりも速く、そして安定して学習を進めることができるのです。

次に、モーメンタムという手法に着目してみましょう。モーメンタムは、勾配の勢いを考慮することで、学習の速度を向上させる手法です。RMSpropは、過去の勾配の二乗平均平方根を用いることで、学習率を調整する手法です。ADAMは、これらのモーメンタムとRMSpropの利点を組み合わせた手法と言えます。ADAMは過去の勾配の情報と過去の勾配の二乗平均平方根の両方を用いることで、より効率的かつ安定した学習を実現します。

ADAMは多くの場合で優れた性能を発揮しますが、全ての問題において最適な手法であるとは限りません。問題によっては、SGDやモーメンタム、RMSpropなど、他の手法の方が適しているケースもあります。そのため、最適な手法を見つけるためには、複数の手法を試して比較検討することが重要です。それぞれの学習データやモデルの特性に合わせて、最適な手法を選択することで、より良い結果を得ることができるでしょう。

| 手法 | 説明 | 長所 | 短所 |

|---|---|---|---|

| 確率的勾配降下法(SGD) | 勾配に従って段階的に最適な値を探す | 実装がシンプル | 振動が起こりやすく、最適な値にたどり着くまでに時間がかかることがある |

| モーメンタム | 勾配の勢いを考慮することで、学習の速度を向上させる | 学習の速度を向上させる | – |

| RMSprop | 過去の勾配の二乗平均平方根を用いることで、学習率を調整する | 学習率を調整する | – |

| Adam | モーメンタムとRMSpropの利点を組み合わせた手法。過去の勾配の情報と過去の勾配の二乗平均平方根の両方を用いる | SGDよりも速く、そして安定して学習を進めることができる | 全ての問題において最適な手法であるとは限らない |

まとめ

この記事では、学習の最適化手法であるADAMについて、その仕組みから利点、応用例までを詳しく説明しました。

ADAMは、「勢い」に着目したモーメンタムと、「変化の度合い」を考慮したRMSpropという、二つの優れた最適化手法の長所を組み合わせた強力なアルゴリズムです。それぞれの良い点をうまく取り入れることで、様々な機械学習の課題において高い性能を示します。

ADAMの大きな利点の一つは、学習の安定性が高いことです。学習過程で起こりがちな振動を抑え、滑らかに最適な値へと近づいていくため、効率的に学習を進めることができます。また、学習の効率性も高いことが挙げられます。パラメータの更新を適切に行うことで、少ない試行回数で目標値に到達することが可能です。さらに、ハイパーパラメータの調整が比較的容易である点も魅力です。複雑な調整を必要とせずとも、安定した性能を発揮できるため、初心者にも扱いやすい手法と言えるでしょう。

画像認識や自然言語処理など、幅広い機械学習の分野でADAMは活用されています。例えば、画像認識では、画像に写っている物体を正確に識別するために、ADAMを用いてモデルの学習を行います。自然言語処理では、文章の理解や生成といったタスクにおいて、ADAMが最適なパラメータを見つけ出す役割を担います。このように、ADAMは多様な機械学習の課題に適用可能であり、高い成果を上げています。

ADAMは、機械学習における最適化手法として非常に優れており、最初に試してみる価値の高い手法と言えるでしょう。今後も更なる改良が加えられ、より複雑で高度な機械学習の課題にも適用されていくことが期待されます。そして、ADAMの発展は、機械学習全体の進歩にも大きく貢献していくことでしょう。

| 項目 | 内容 |

|---|---|

| 手法名 | ADAM |

| 特徴 | モーメンタムとRMSpropの長所を組み合わせたアルゴリズム |

| 利点 |

|

| 応用例 |

|