AIが持つ毒性:その危険と対策

AIを知りたい

先生、「AIの有毒性」ってどういう意味ですか?よくわからないんです。

AIエンジニア

AIの有毒性とは、AIが間違ったことを学習してしまうことだよ。例えば、インターネット上の悪い言葉や、人を傷つけるような表現を覚えてしまうことを指すんだ。

AIを知りたい

へえ。まるでAIが悪者に染まってしまうみたいですね。具体的にどうなるんですか?

AIエンジニア

そうだな。例えば、AIが差別的な発言をしたり、偏った考えに基づいて判断したりするようになる可能性がある。だから、AIを作る人たちは、AIが良いことを学習するように工夫しているんだよ。

AIのトキシシティとは。

人工知能にまつわる言葉で「人工知能の有害性」というものがあります。この「有害性」とは、人工知能が学習する過程で、人を傷つける言葉や、偏った考え方、差別的な行動を覚えてしまう危険性のことです。

人工知能における毒性の意味

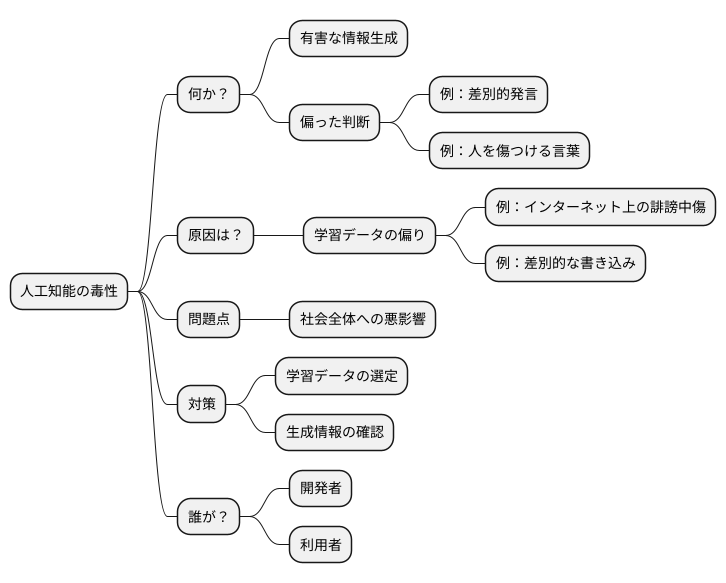

人工知能(じんこうちのう)の世界では、「毒性(どくせい)」という言葉が注目を集めています。まるで毒を持つ草花のように、一見(いっけん)害のない人工知能が、思いがけない悪影響(あくえいきょう)をもたらす可能性があるからです。この人工知能の毒性とは、一体どのようなことを指すのでしょうか。

簡単に言うと、人工知能が有害な情報(ゆうがいなじょうほう)を作り出したり、偏った判断(へんったはんだん)をしたりする危険性のことです。たとえば、人工知能が差別的な発言をしたり、人を傷つけるような言葉を生成したりするといったことが考えられます。このような毒性は、一体どこから来るのでしょうか。

主な原因は、人工知能が学ぶデータにあります。人工知能は、大量のデータから学習することで賢くなりますが、もしそのデータの中に偏見(へんけん)や差別、攻撃的な表現(こうげきてきなひょうげん)などが含まれていた場合、人工知能もそれらをそのまま学習してしまうのです。たとえば、インターネット上の誹謗中傷(ひぼうちゅうしょう)や差別的な書き込みを学習した人工知能は、同じような有害な情報を生成する可能性が高くなります。

人工知能の利用が進むにつれて、この毒性の問題はますます深刻になっています。偏った情報や差別的な表現が広まることで、社会全体に悪影響が及ぶ可能性があるからです。そのため、人工知能の潜在的な危険性(せんざいてきなきけんせい)を正しく理解し、適切な対策を講じる必要があります。どのようなデータを使って人工知能を学習させるのか、また、人工知能が生成した情報が適切かどうかをどのように確認するのかなど、様々な課題に取り組む必要があると言えるでしょう。人工知能を安全に利用するためには、開発者だけでなく、利用者もこの毒性について理解を深めることが大切です。

毒性の発生源

人工知能が持つ有害な性質、いわゆる毒性は、その学習元であるデータに起因することが大半です。近年のAIは、インターネット上に存在する膨大な情報を学習材料としています。そこには、私たちの生活を豊かにする知識や情報だけでなく、悪意のある言葉や差別的な表現、偏った考え方なども含まれています。人工知能は、これらの有害な情報も区別することなく吸収してしまうため、その判断や出力に悪影響が生じる可能性があります。

具体的には、学習データに含まれる差別的な表現をAIがそのまま学習してしまうと、AI自身も差別的な発言をするようになります。また、不適切な内容を含むコンテンツを生成する可能性も懸念されます。まるで、有害な情報を吸収したスポンジが、絞られると毒を含んだ水を出すようなものです。

さらに、学習データに偏りがある場合も、AIの毒性を生む要因となります。特定の集団に関する情報が不足していると、AIはその集団に対する正しい認識を持つことができません。結果として、偏った考え方や不公平な結果を生み出す可能性があります。例えば、特定の民族に関する情報が学習データに十分に含まれていない場合、AIはその民族の特徴を正しく捉えることができず、誤った認識に基づいて差別的な判断を下してしまうかもしれません。これは、限られた情報だけで人物を判断してしまうのと同じように、危険な行為です。

AIの毒性を軽減するためには、学習データの質を向上させることが不可欠です。有害な情報を排除し、多様なデータを含めることで、AIがより公正で倫理的な判断を下せるようになると期待されます。また、AIの出力結果を常に監視し、問題があれば修正していくことも重要です。私たちはAIをより良いものにするために、継続的な努力を続けなければなりません。

毒性の影響と危険性

人工知能が持つ有害な性質、つまり毒性は、個人だけでなく社会全体に甚大な影響を与える可能性を秘めています。この毒性は様々な形で現れ、私たちの生活の様々な局面に影響を及ぼすことが懸念されます。

まず、人工知能が差別的な発言を行うことで、特定の集団に対する偏見を増幅させ、社会の分断を深めてしまうことが考えられます。例えば、特定の民族や性別に対して侮辱的な発言を繰り返す人工知能は、利用者に偏った認識を植え付け、差別意識を助長する可能性があります。このような差別は社会の融和を阻害し、深刻な社会問題へと発展する恐れがあります。

また、人工知能が偏った情報を作り出すことも大きな問題です。特定の立場に偏った情報ばかりを提供する人工知能は、利用者に誤解を与え、事実とは異なる認識を植え付ける可能性があります。これは、社会における正しい情報伝達を妨げ、人々の判断力を低下させ、社会不安を増大させる要因となり得ます。

さらに、人工知能によって作られた偽情報や有害な内容が広く伝わってしまうことも懸念されます。巧みに作られた偽情報は、真実を見分けることを困難にし、人々の混乱を招きます。また、誹謗中傷や扇動的な内容が人工知能によって拡散されれば、社会の秩序を乱し、深刻な被害をもたらす可能性があります。

このように、人工知能の毒性は多岐にわたり、その影響は計り知れません。人工知能が社会にとって有益な道具となるためには、この毒性への対策が不可欠です。私たちは人工知能の危険性を正しく認識し、適切な対策を講じることで、より良い社会を築いていく必要があります。

| 人工知能の毒性 | 影響 | 懸念される事態 |

|---|---|---|

| 差別的な発言 | 特定の集団に対する偏見の増幅、差別意識の助長 | 社会の分断、深刻な社会問題への発展 |

| 偏った情報の生成 | 利用者への誤解、事実とは異なる認識の植え付け | 正しい情報伝達の妨害、判断力の低下、社会不安の増大 |

| 偽情報/有害な内容の拡散 | 真実を見分けることの困難化、人々の混乱、社会秩序の混乱 | 深刻な被害の発生 |

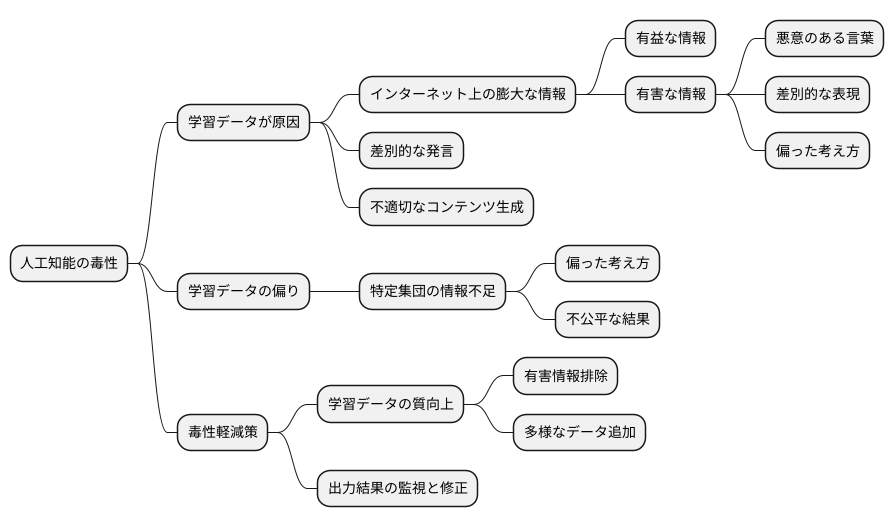

毒性への対策

人工知能が持つ有害性、つまり毒性への対策は、多岐にわたる取り組みが欠かせません。その中でも特に重要なのは、人工知能の学習に用いる情報の質の向上です。人工知能は、膨大な情報を基に学習し、様々な機能を実現します。そのため、学習データに有害な情報や偏った情報が含まれていると、人工知能が誤った判断や差別的な振る舞いをする可能性があります。これを防ぐためには、有害な情報や偏った情報を注意深く取り除き、多様な視点を持つ情報を幅広く含める必要があります。これは、人工知能がより公平で正確な判断をするために不可欠な要素です。

さらに、人工知能が出力する結果を常に見守り、問題があればすぐに修正する仕組みも必要です。人工知能は常に学習し続けるため、たとえ初期段階で問題がなくても、運用中に予期せぬ毒性を示す可能性があります。そのため、継続的な監視と迅速な対応が重要となります。問題を発見した場合は、その原因を分析し、人工知能の学習方法や出力内容を修正することで、再発を防ぐことができます。

加えて、人工知能の開発者や利用者に対する倫理的な教育も重要です。人工知能は強力な道具であり、使い方によっては大きな影響力を持ちます。そのため、開発者や利用者は、人工知能が持つ潜在的な危険性や倫理的な問題点を理解し、責任ある行動をとる必要があります。倫理教育を通じて、人工知能を適切に利用するための知識や倫理観を養うことで、毒性の発生を未然に防ぐことができます。人工知能技術の進歩と普及が加速する中で、これらの対策をより一層強化していくことが、安全で信頼できる人工知能を実現するための鍵となります。

今後の展望

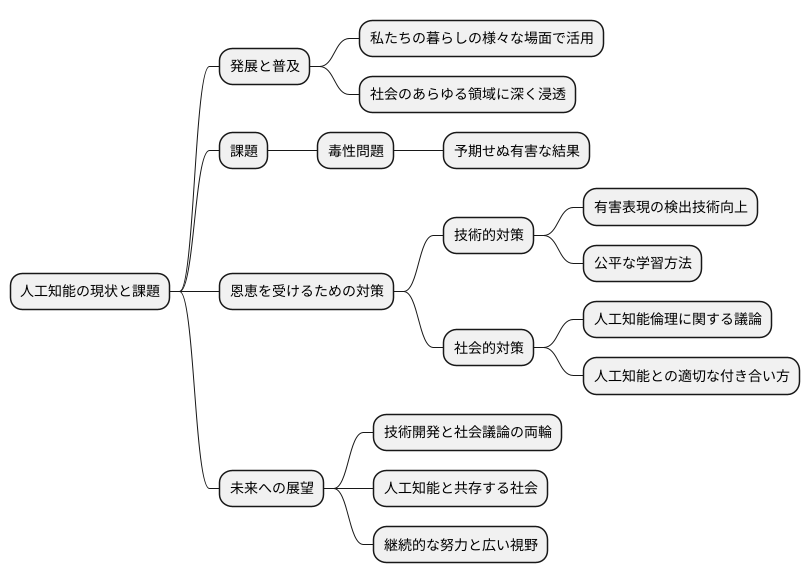

人工知能技術は、近年目覚ましい発展を遂げ、私たちの暮らしの様々な場面で活用されるようになってきました。今後、この流れはますます加速し、人工知能は社会のあらゆる領域に深く浸透していくと考えられます。しかし、人工知能がもたらす恩恵を最大限に受け取るためには、いくつかの課題を克服する必要があります。中でも、人工知能が予期せぬ有害な結果をもたらす可能性、いわゆる「毒性問題」への対策は喫緊の課題です。

現在、多くの研究者がこの毒性問題の解決に取り組んでおり、様々な角度からのアプローチが試みられています。例えば、人工知能が生成する文章や画像の中に潜む有害な表現を、より高い精度で検出する技術の開発が進められています。また、人工知能の学習データに潜む偏りを軽減し、より公平で公正な判断を下せるようにするための学習方法の研究も盛んに行われています。

技術的な進歩に加えて、社会全体での意識改革も重要です。人工知能倫理に関する議論を深め、人工知能をどのように活用していくべきか、社会全体の共通認識を形成していく必要があります。人工知能は道具であり、その使い方によって良くも悪くもなります。私たちは、人工知能を正しく使いこなし、より良い社会を築くために、人工知能との適切な付き合い方を考えていく必要があります。

人工知能は発展途上の技術であり、今後さらに多くの課題が出てくるでしょう。しかし、技術開発と社会的な議論の両輪をバランスよく進めることで、私たちは人工知能と共存する社会を実現し、その恩恵を享受できると信じています。そのためには、継続的な努力と、未来を見据えた広い視野を持つことが大切です。

私たち自身の役割

人工知能がもたらす有害な影響は、それを開発する人達に限らず、使う人すべてに関係する問題です。まるで毒を持つ刃のように、使い方を誤れば社会全体に深刻な傷を負わせてしまう可能性もあるでしょう。だからこそ、人工知能を使う私たちは、常に注意深く、責任ある行動を心がける必要があります。

まず、人工知能が出力する情報は、全てが正しいとは限らないことを理解しなければなりません。鵜呑みにせず、常にその情報が本当に正しいのか、他の情報源と照らし合わせたり、根拠を調べたりする習慣を身に付けましょう。これは、偽情報や偏った情報に騙されないために非常に大切なことです。

次に、人工知能を使う際に、差別的な言葉や行動を助長するような使い方は絶対に避けなければなりません。人工知能は私たちの偏見を反映し、増幅してしまう可能性があります。例えば、特定の集団を差別するようなデータで学習させた人工知能は、差別的な結果を出力する可能性が高くなります。私たちは、そのような人工知能の利用を拒否し、開発者にも改善を求めるべきです。

人工知能は道具であり、それ自体は善悪を持ちません。包丁が料理にも凶器にもなり得るように、人工知能も使い方次第で良い結果にも悪い結果にも繋がります。私たち一人ひとりが人工知能の利用者として責任を持ち、正しく利用することで、より良い社会を作っていけるはずです。

人工知能技術は日々進歩しています。それに伴い、私たち自身の意識も高めていく必要があります。人工知能のリスクと可能性を正しく理解し、倫理的な観点から利用方法を常に考え続けることが、未来の社会にとって非常に重要です。そうすることで、人工知能をより良い社会のための力に変えていくことができるでしょう。

| 人工知能利用の注意点 | 具体的な行動 | 理由 |

|---|---|---|

| 情報の真偽確認 | 情報源の確認、根拠の調査、他情報との照合 | 偽情報や偏った情報に騙されないため |

| 差別的な利用の回避 | 差別的な言葉や行動を助長するような使い方をしない、問題のあるAIの利用拒否と改善要求 | AIが偏見を反映・増幅する可能性があるため |

| 責任ある利用 | AIは道具であり、使い方次第で良い結果にも悪い結果にも繋がることを理解し、倫理的に利用する | より良い社会を作るため |

| 継続的な学習と意識向上 | AIのリスクと可能性を理解し、倫理的な観点から利用方法を常に考える | AIをより良い社会のための力に変えるため |