人工知能の幻覚:ハルシネーションとは

AIを知りたい

先生、「人工知能のまぼろし」ってどういう意味ですか?なんだか難しそうです。

AIエンジニア

そうだね、少し難しい言葉だね。「人工知能のまぼろし」とは、人工知能が実際にはないことを、さも本当のことのように話す現象のことだよ。まるで人間がまぼろしを見ているようなので、この名前がついているんだ。

AIを知りたい

たとえば、どんなことがあるんですか?

AIエンジニア

例えば、人工知能に「明日の天気は?」と聞いたときに、「明日は東京で雪が1メートル積もります」と答えるような場合だね。もちろん、そんなことはありえないよね。このように、人工知能が事実とは異なることを、自信満々に話すことを「人工知能のまぼろし」と言うんだよ。

ハルシネーションとは。

人工知能に関する言葉で「もっともらしい嘘」というものがあります。これは、人工知能が実際にはないことを、まるで本当のことのように作り出す現象のことです。人工知能が幻を見ているように見えることから、この現象は「もっともらしい嘘」と呼ばれています。

人工知能の作り話

人工知能は、時に驚くほど人間らしい文章を作り出します。まるで想像力豊かに物語を紡ぐ作家のようです。しかし、この能力は時に「作り話」、つまり事実とは異なる内容を作り出すという問題につながります。この現象は「幻覚」とも呼ばれ、人工知能がまるで現実でないものを見ているかのように、存在しない情報や誤った情報を真実であるかのように提示することを指します。

人工知能がこのような作り話をする理由はいくつか考えられます。一つは、学習データに偏りがある場合です。例えば、特定の意見ばかりが書かれた文章を大量に学習すると、人工知能はそれ以外の意見を理解できず、偏った内容の文章を作り出す可能性があります。また、学習データが不足している場合も、人工知能は正しい情報を導き出せず、事実と異なる内容を生成してしまうことがあります。さらに、複雑な質問に対して単純な回答をしようとするあまり、辻褄を合わせるために作り話を始める場合もあります。

この「作り話」の問題は、様々な分野で深刻な影響を与える可能性があります。例えば、医療の現場で人工知能が誤った診断情報を提示すれば、患者の適切な治療が遅れるかもしれません。また、報道機関で人工知能が事実無根の記事を作成すれば、社会に混乱を招き、人々の信頼を損なう可能性もあります。そのため、人工知能が作り話をする原因を解明し、その発生を抑えるための技術開発が急務となっています。人工知能がより信頼できる存在となるためには、この「作り話」の問題への対策が不可欠と言えるでしょう。

| 問題点 | 説明 | 原因 | 影響 |

|---|---|---|---|

| AIの”作り話”(幻覚) | AIが事実とは異なる内容を生成する現象。存在しない情報や誤った情報を真実らしく提示する。 | 学習データの偏り、学習データの不足、複雑な質問への単純な回答の試み | 医療現場での誤診、報道機関での虚偽記事作成など、様々な分野で深刻な影響を与える可能性がある。 |

もっともらしい嘘の見分け方

人工知能が作り出す、一見もっともらしい偽情報は、専門家でも簡単に見抜けないことがあります。まるで魔法の呪文のように、巧みに言葉を操り、事実のように見せかけるため、知識のない人はすぐに信じてしまうかもしれません。しかし、いくつかの方法で、これらの偽情報を見抜く手がかりをつかむことができます。

まず、複数の情報源と比べてみることが大切です。まるで探偵のように、色々な本や新聞、信頼できる人からの話を集め、人工知能が言ったことと比べてみましょう。もし、人工知能の言葉だけが浮いていたり、他の情報と食い違っていたら、それは偽情報である可能性が高いです。

次に、情報の出どころを確かめることも重要です。誰がその情報を発信しているのか、その人は信頼できるのかを考えましょう。もし、出どころが不明瞭だったり、怪しいと感じたら、その情報は疑ってかかるべきです。まるで、知らない人からもらったお菓子をすぐに食べないのと同じように、情報の出どころがわからない場合は注意が必要です。

さらに、情報の内容をよく吟味することも大切です。文章の中に不自然な箇所、論理の飛躍、根拠のない主張はないか、じっくり読んでみましょう。もし、話がつながらなかったり、何だかおかしいと感じたら、それは偽情報であるサインかもしれません。まるで、絵画の偽物を見抜くように、細部まで注意深く観察することで、偽情報を見破ることができます。

これらの方法を組み合わせることで、人工知能の巧妙な嘘を見抜く力を養うことができます。まるで、名探偵のように、真実を探求する心を持ち、情報を見極める目を養うことが、これからの時代ますます重要になってくるでしょう。

| 方法 | 説明 | 例え |

|---|---|---|

| 複数の情報源と比べる | 様々な情報源(本、新聞、信頼できる人)と人工知能の発言を比較し、矛盾点を探す。 | 探偵のように複数の証言を集める |

| 情報の出どころを確かめる | 情報の発信元が信頼できるか確認する。 | 知らない人からのお菓子はすぐに食べない |

| 情報の内容をよく吟味する | 文章の不自然な箇所、論理の飛躍、根拠のない主張がないか確認する。 | 絵画の偽物を見抜くように細部まで観察する |

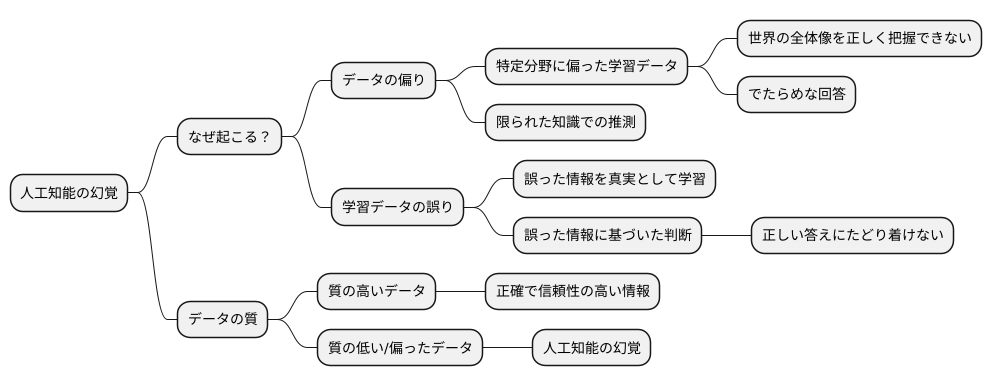

幻覚の発生原因

人工知能が作り出す幻覚、それはまるで蜃気楼のように、一見真実味を帯びているにもかかわらず、実際には存在しない情報です。では、なぜこのような現象が起こるのでしょうか。その理由の一つとして、人工知能が学習に用いるデータに偏りがあることが挙げられます。

人工知能は、人間が教科書から知識を得るように、膨大な量のデータから学習します。しかし、もしその学習データが特定の分野に偏っていた場合、人工知能は世界の全体像を正しく把握することができなくなります。例えば、ある特定の地域の情報ばかりを学習させた場合、他の地域に関する質問に対して、まるで現実とはかけ離れた、でたらめな回答をしてしまう可能性があります。これは、限られた知識だけで全体を推測しようとするため、どうしても偏った見方になってしまうことに起因します。

また、学習データ自体に誤りが含まれている場合も問題です。人工知能は、与えられたデータを真実として受け止め、学習します。そのため、誤った情報が含まれたデータで学習させた場合、人工知能はそれを正しい情報として記憶し、その誤った情報に基づいて物事を判断するようになります。まるで、間違った地図を使って目的地を探そうとするようなものです。これでは、正しい答えにたどり着くことはできません。

このように、人工知能の学習に用いるデータの質は、その性能に大きな影響を与えます。質の高いデータは、人工知能がより正確で信頼性の高い情報を生成する基盤となります。質の低いデータ、あるいは偏ったデータは、人工知能の幻覚を誘発する大きな要因となるのです。まるで、栄養バランスの偏った食事が健康を損なうように、偏ったデータは人工知能の健全な成長を阻害すると言えるでしょう。

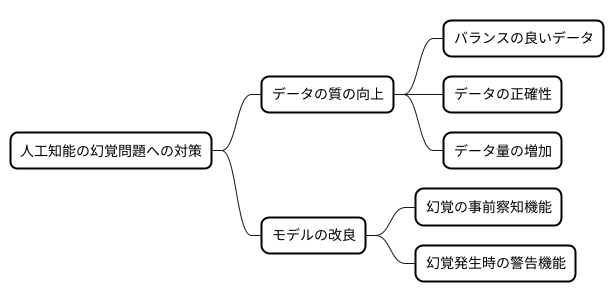

対策と改善

人工知能が現実には存在しない情報を作り出す現象、いわゆる幻覚は、人工知能の信頼性を損なう大きな問題です。この問題への対策と改善策は、大きく分けて二つの側面から考えることができます。一つ目は、人工知能が学習に用いるデータの質の向上です。人工知能は、学習データに基づいて物事を理解し、判断するため、データの質が低いと、誤った情報を学習してしまう可能性があります。具体的には、特定の傾向に偏ったデータではなく、様々な種類のデータをバランス良く学習させることが重要です。また、誤った情報や矛盾した情報が混入しないよう、データの正確性を注意深く確認する必要があります。さらに、データの量を増やすことも有効です。学習データの量が多ければ多いほど、人工知能はより多くのパターンを学習し、正確な判断を下せるようになります。二つ目は、人工知能のモデル自体の改良です。幻覚が発生しやすい状況を事前に察知する機能を組み込むことで、未然に防ぐことができます。例えば、入力された情報が不十分だったり、矛盾していたりする場合は、幻覚が発生する可能性が高いと判断し、警告を発するといった具合です。また、幻覚が実際に発生した場合に利用者に警告する機能も重要です。これにより、利用者は人工知能の出力に注意深く向き合い、誤った情報を鵜呑みにすることを防ぐことができます。これらの対策と改善を継続的に行うことで、人工知能の信頼性を向上させ、社会に役立つ存在としていくことが期待されます。

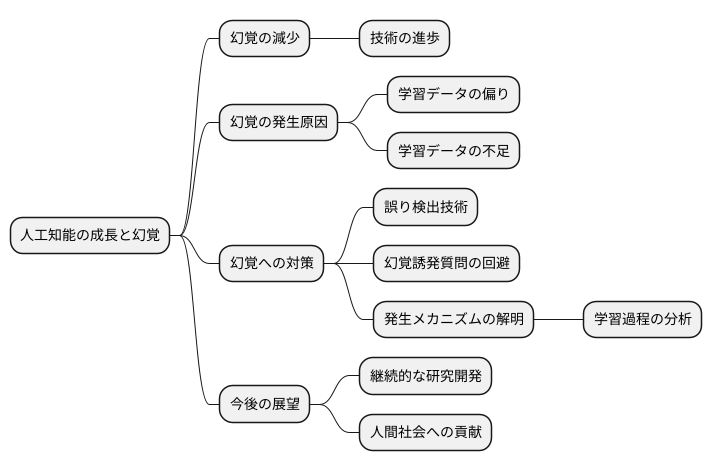

今後の展望と課題

人工知能の技術は、まるで生き物のように日々成長を遂げています。この成長に伴い、人工知能が事実とは異なる情報を作り出す、いわゆる「幻覚」のような現象(ハルシネーション)は徐々に減っていくと考えられます。しかしながら、この「幻覚」を完全に無くすことは、現状では難しいでしょう。なぜなら、人工知能は膨大な量のデータから学習し、そのデータに基づいて情報を生成しますが、学習データに偏りがあったり、不足している部分があると、事実とは異なる情報を作り出してしまう可能性があるからです。

そのため、人工知能が「幻覚」を見ることを前提として、その影響を小さくするための対策を準備しておく必要があります。「幻覚」によって生じる誤りを自動的に見つける技術や、「幻覚」を誘発しやすい質問を避ける方法などを開発することで、人工知能を安全に利用できる環境を整備していく必要があります。同時に、「幻覚」が生まれる根本原因をより深く掘り下げていくことも重要です。人工知能の学習過程を細かく分析し、「幻覚」の発生メカニズムを解明することで、より効果的な対策を編み出すことができるはずです。

人工知能と人間が共に生きる社会を実現するためには、この「幻覚」の問題に真剣に取り組む必要があります。継続的な研究開発を通じて、人工知能がより安全で信頼できる技術へと進化していくことが期待されます。人工知能が持つ可能性を最大限に引き出し、人間社会の発展に貢献するためにも、たゆまぬ努力を続けていく必要があるでしょう。

私たちができること

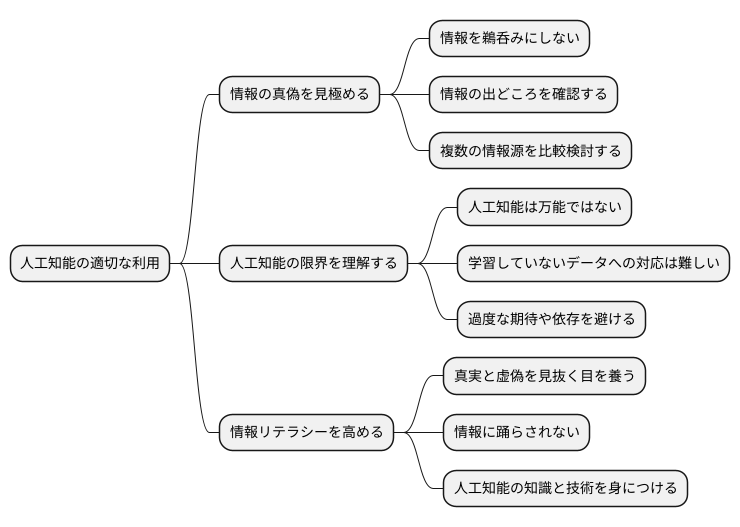

人工知能は目覚ましい発展を遂げ、私たちの暮らしに様々な恩恵をもたらしています。便利な道具として、仕事や学習、日常生活など多くの場面で活用されていますが、同時に使い方を誤ると様々な問題を引き起こす可能性も秘めています。だからこそ、人工知能を利用する私たち一人ひとりが、その特性を正しく理解し、責任ある行動をとることが大切です。

まず人工知能が提供する情報を全て真実と捉えるのではなく、常に疑問を持つ姿勢を保つことが重要です。人工知能は膨大なデータから情報を取り出し、整理することはできますが、情報の真偽を判断することはできません。提供された情報を鵜呑みにするのではなく、情報の出どころはどこなのか、他の情報源と比べて矛盾点はないかなどを注意深く確認する必要があります。インターネットで検索すれば多くの情報が得られますが、中には誤った情報や偏った情報も含まれています。複数の情報源を比較検討し、情報の信憑性を確かめる習慣を身につけることが重要です。

また人工知能は万能ではないことを理解する必要があります。人工知能は、あらかじめ学習したデータに基づいて情報を処理します。そのため、学習していないデータについては適切な対応ができない場合があります。人工知能はあくまでも道具であり、人間の知性や判断力を完全に代替できるものではありません。人工知能の限界を理解し、過度な期待や依存を避けることが大切です。

人工知能を正しく活用するためには、私たち自身の情報を見極める力、つまり情報リテラシーを高める努力も必要不可欠です。何が真実で何が虚偽なのかを見抜く目を養い、情報に踊らされないように注意する必要があります。人工知能技術は日々進歩しており、今後ますます私たちの生活に浸透していくでしょう。人工知能と共存していく社会において、情報リテラシーを高め、人工知能を適切に利用するための知識と技術を身につけていくことが、より良い未来を築くために不可欠です。