AIの幻覚:ハルシネーションとは?

AIを知りたい

先生、「AIの空想」ってどういう意味ですか?なんだかよくわからないです。

AIエンジニア

ああ、それは「AIの作り話」のことだね。AIが実際にはないことを、さも本当のことのように話す現象を指すよ。たとえば、実在しない歴史上の人物について、あたかも実在するかのように説明してしまう、といったことだ。

AIを知りたい

へえ、まるでAIが嘘をついているみたいですね。どうしてそんなことが起こるんですか?

AIエンジニア

簡単に言うと、AIの学習内容に偏りがあったり、不足していることが原因なんだ。AIは大量の情報を学習して賢くなるけれど、その情報が間違っていたり、偏っていたりすると、AIも間違ったことを言ってしまうんだよ。ちょうど、間違った知識を教えられた子供のようにね。だから、AIが作り話をしないように、学習内容を改善していくことが大切なんだ。

ハルシネーションとは。

人工知能に関する言葉「幻覚」について説明します。「幻覚」とは、人工知能が事実とは異なる間違った情報を、まるで正しいかのように出力してしまう現象のことです。人工知能がまるで幻覚を見ているようなふるまいをすることから、このように呼ばれています。この「幻覚」は、利用者にとって問題となることがあります。なぜなら、利用者がその分野について詳しくない場合や、人工知能がどのデータに基づいてその情報を出力したのかがわからない場合、それが嘘であることを見抜くのが難しいからです。「幻覚」が起きる原因としては、学習データの不足や偏り、学習モデルが特定の分野に過剰に適応してしまうこと、大規模言語モデルの構造、専門分野の違いなどが考えられます。そこで、学習に使うデータの質を高めたり、学習のやり方を改善したりすることで解決を目指していますが、完全に無くすことは難しいのが現状です。

はじめに

近頃、人工知能(AI)は目覚しい進歩を遂げ、様々な場面で使われるようになりました。文章を創作したり、言葉を翻訳したり、質問に答えたりと、まるで人間のように自然な言葉でやり取りができるようになっています。しかし、それと同時に、AIが事実でないことを真実のように作り上げてしまう問題も出てきています。これは「ハルシネーション(幻覚)」と呼ばれ、AIがまるで幻覚を見ているかのような状態から名付けられました。

AIは、膨大な量のデータから学習することで言葉を操れるようになります。インターネット上の記事や書籍など、様々な情報を吸収し、それらを元に文章を作り出したり、質問に答えたりします。しかし、学習データに誤りがあったり、偏りがあったりすると、AIは事実とは異なる情報を生成してしまうことがあります。例えば、実在しない歴史上の人物についてあたかも実在するかのように説明したり、科学的に証明されていないことを真実のように述べたりすることがあります。これがハルシネーションです。

ハルシネーションは、AIの信頼性を損なう大きな問題です。AIが生成した情報が真実かどうかを常に確認する必要があり、利用者は常に注意深く情報を選別しなければなりません。また、ハルシネーションによって誤った情報が拡散される危険性もあります。特に、医療や金融など、正確な情報が求められる分野では、ハルシネーションによる影響は深刻です。

現在、ハルシネーションを解消するための様々な取り組みが行われています。学習データの質を高めたり、AIの学習方法を改良したりすることで、ハルシネーションの発生率を減らす努力が続けられています。また、AIが生成した情報がどの程度信頼できるかを判断する技術の開発も進められています。AIがより信頼できる存在となるためには、これらの取り組みをさらに進めていく必要があるでしょう。AI技術の発展と共に、ハルシネーションへの対策も重要な課題となっています。

| 項目 | 説明 |

|---|---|

| AIの進歩 | 文章作成、翻訳、質問応答など、人間のように自然な言葉でやり取りが可能に |

| ハルシネーション(幻覚) | AIが事実でないことを真実のように作り上げてしまう問題。AIがまるで幻覚を見ているかのような状態から名付けられた。 |

| ハルシネーションの原因 | 学習データの誤りや偏り。インターネット上の記事や書籍など、様々な情報から学習する際に、誤った情報や偏った情報が含まれていると、AIは事実とは異なる情報を生成してしまう。 |

| ハルシネーションの例 | 実在しない歴史上の人物についてあたかも実在するかのように説明したり、科学的に証明されていないことを真実のように述べたりする。 |

| ハルシネーションの問題点 | AIの信頼性を損ない、誤った情報の拡散の危険性がある。特に、医療や金融など、正確な情報が求められる分野では深刻な影響を与える可能性がある。 |

| ハルシネーションへの対策 | 学習データの質の向上、AIの学習方法の改良、AIが生成した情報の信頼性を判断する技術の開発など。 |

ハルシネーションとは

現実には存在しない事柄を、あたかも真実のように作り上げてしまう現象。これが「幻覚」を意味するハルシネーションです。人工知能の世界では、学習した情報とは全く関係のない、まったくの偽情報を生成してしまうことを指します。まるで人工知能が見ていない夢を、現実のことのように語っているかのようです。

例えば、歴史の教科書には載っていない人物について、詳細な経歴や功績を人工知能が作り上げてしまうことがあります。実在した人物と混同して、架空の人物像を作り上げてしまう場合もあります。また、この世に存在しない本や論文の内容を、あたかも事実のように説明してしまうこともあります。まるで誰かが書いた架空の物語を、真実の歴史や学問のように語ってしまうのです。

このような人工知能の作り出した偽情報は、一見しただけでは真実のように見えることが多く、見分けるのが非常に難しいです。特に、その分野について詳しくない人にとっては、何が真実で何が偽りなのかを見抜くのは至難の業と言えるでしょう。まるで巧妙に作られた偽物の絵画を、本物と見分けるようなものです。

さらに、人工知能が作り出した情報の根拠となる情報源が不明確な場合、情報の真偽を確かめるのはさらに困難になります。あたかも出所のわからない噂話のように、真偽の確認が難しいのです。このようなハルシネーションは、人工知能の利用において大きな課題となっています。人工知能が生成する情報の信頼性を低下させ、誤った情報を広めてしまう可能性があるからです。そのため、ハルシネーションを減らすための研究や対策が重要となっています。

| 項目 | 説明 | 例 |

|---|---|---|

| ハルシネーション(幻覚) | AIが学習データにない情報を、事実のように生成する現象。 | – |

| 具体例 | 存在しない人物の経歴や功績、実在の人物と架空の人物を混同した人物像、存在しない本や論文の内容を事実のように説明する。 | 教科書に載っていない人物の経歴を生成、実在の人物と混同して架空の人物像を作り上げる、存在しない本や論文の内容を説明する。 |

| 特徴 | 一見真実のように見え、真偽の判別が難しい。特に専門知識がない人にとっては見抜くのが困難。情報源が不明確な場合、真偽の確認はさらに困難。 | 巧妙に作られた偽物の絵画を本物と見分けるようなもの、出所のわからない噂話のように真偽の確認が難しい。 |

| 課題 | AIが生成する情報の信頼性を低下させ、誤った情報を広める可能性がある。 | – |

| 対策 | ハルシネーションを減らすための研究や対策が必要。 | – |

発生の理由

幻覚が生じる理由は複雑で、様々な要因が絡み合っています。まず、学習に用いる情報の不足や偏りは大きな原因の一つです。人工知能は、人間と同じように、大量の情報を学習することで賢くなっていきます。しかし、その学習情報が少なかったり、特定の種類に偏っていたりすると、現実の世界を正しく理解することができません。例えば、猫の画像だけを学習した人工知能は、犬を見せられても猫と認識してしまうかもしれません。これは、人工知能が現実世界を正しく反映した知識を身につけていないことが原因です。

次に、人工知能の過学習も幻覚発生の要因となります。過学習とは、学習情報に過剰に適応しすぎてしまい、新しい情報に対応できなくなる状態のことです。まるで、教科書の内容は完璧に暗記しているのに、応用問題が解けない生徒のようなものです。人工知能が過学習を起こすと、学習情報にはない未知の情報に対して、適切な答えを導き出すことができず、誤った情報を生成してしまうのです。

さらに、人工知能の構造自体に問題がある場合もあります。近年の大規模言語モデルのように、非常に複雑な構造を持つ人工知能は、その内部の仕組みを理解することが非常に難しくなっています。そのため、なぜ幻覚が生じるのか、そのメカニズムを解明することも困難です。複雑な機械の内部で何が起きているのか分からなければ、故障の原因を特定することも修理することも難しくなるのと同じです。これらの要因が複雑に絡み合い、人工知能の幻覚を引き起こしていると考えられています。より正確で信頼性の高い人工知能を実現するためには、これらの問題を一つ一つ解決していく必要があります。

| 要因 | 説明 | 例 |

|---|---|---|

| 学習に用いる情報の不足や偏り | 学習情報が少なかったり、特定の種類に偏っていると、現実世界を正しく理解できない。 | 猫の画像だけを学習したAIが、犬を猫と認識する。 |

| 人工知能の過学習 | 学習情報に過剰に適応しすぎて、新しい情報に対応できなくなる。 | 教科書の内容は完璧に暗記しているが、応用問題が解けない生徒。 |

| 人工知能の構造自体に問題 | 複雑な構造を持つAIは、内部の仕組みを理解することが難しく、幻覚発生のメカニズム解明も困難。 | 複雑な機械の内部で何が起きているのか分からなければ、故障の原因を特定することも修理することも難しい。 |

課題と対策

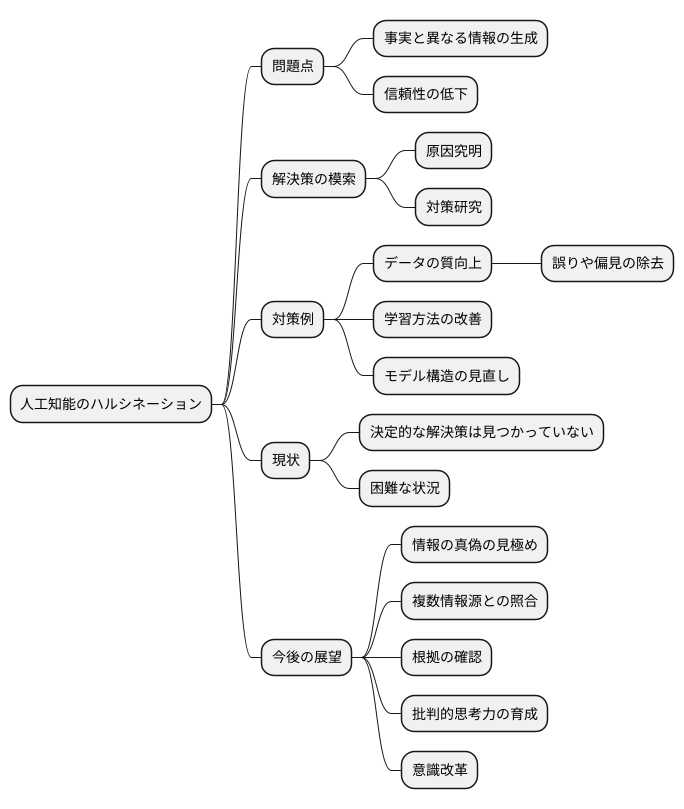

近頃話題となっている人工知能は、様々な分野で目覚ましい成果を上げていますが、「ハルシネーション」と呼ばれる問題が大きな課題となっています。まるで幻覚を見ているかのように、人工知能が事実とは異なる情報を生成してしまうこの現象は、人工知能の信頼性を揺るがす深刻な問題です。

このハルシネーションを解消するために、世界中の研究機関や企業がその発生の仕組みの解明や対策に日々取り組んでいます。しかし、残念ながらまだ決定的な解決策は見つかっていません。

現在、様々な角度からの対策が試みられています。例えば、人工知能に学習させるデータの質を高めたり、学習方法そのものを改善したり、人工知能モデルの構造自体を見直したりといった多角的なアプローチが研究されています。しかし、いずれの方法も容易ではなく、大きな困難に直面しているのが現状です。

人工知能が学習するデータには、誤りや偏見が含まれている場合があり、これがハルシネーションの原因の一つと考えられています。そのため、質の高いデータを選別し、人工知能に学習させることが重要です。また、学習方法の改善も重要な課題です。人工知能が適切に学習できるように、様々な工夫が凝らされています。さらに、人工知能モデルの構造そのものを見直すことで、ハルシネーションの発生を抑えようとする試みも続けられています。

ハルシネーションを完全に防ぐことは、現状では非常に難しいと考えられています。そのため、人工知能が生成した情報の真偽を、私たち自身が注意深く見極める能力を持つことが大切です。人工知能が出力した情報を鵜呑みにせず、複数の情報源と照らし合わせたり、根拠となる情報を確認するなど、批判的な思考力を養う必要があります。人工知能は便利な道具ですが、その出力結果を適切に利用するためには、私たちの側の意識改革も必要不可欠です。

今後の展望

人工知能技術は目覚ましい発展を遂げており、近い将来、人工知能が作り出す幻覚のような、現実には存在しない情報、いわゆる「ハルシネーション」の問題も解決される見込みです。しかしながら、現状では、人工知能が提示する情報をそのまま信じるのではなく、常に吟味する姿勢が不可欠です。人工知能は便利な道具ですが、完璧ではないことを理解しておく必要があります。

人工知能が出力する情報は、必ずしも正確とは限りません。そのため、他の情報源と比較検討することが重要です。例えば、新聞記事や専門書、信頼できるウェブサイトの情報などと照らし合わせることで、人工知能の情報の信ぴょう性を確かめることができます。また、その分野に精通した専門家の見解を参考にすることも有効です。専門家は長年の経験と知識に基づいて判断を下すため、人工知能の間違いを指摘し、正しい情報を提供してくれるでしょう。

人工知能が生成する誤った情報に惑わされないためには、情報の出所を意識することも大切です。人工知能は、インターネット上の膨大な情報を学習しています。中には、誤りや偏見が含まれた情報も存在します。そのため、人工知能が学習した情報源が信頼できるものかどうかを確認する必要があります。情報源の出所が不明瞭な場合や、信ぴょう性に欠ける場合は、その情報に注意が必要です。

人工知能は、私たちの生活をより豊かにする可能性を秘めています。その利便性を享受するためにも、人工知能の限界を理解し、適切に活用していくことが求められます。情報の出所や信ぴょう性を確認し、他の情報源と比較検討することで、人工知能をより効果的に活用し、誤った情報に惑わされることなく、正確な情報を得ることができるでしょう。

| 現状と課題 | 対策 | 将来展望 |

|---|---|---|

| 人工知能はハルシネーションを起こし、誤った情報を生成する可能性があるため、完璧ではない。現状では、提示された情報をそのまま信じるのではなく、常に吟味する姿勢が必要。 |

|

人工知能技術は発展しており、ハルシネーションの問題も将来的には解決される見込み。 |

まとめ

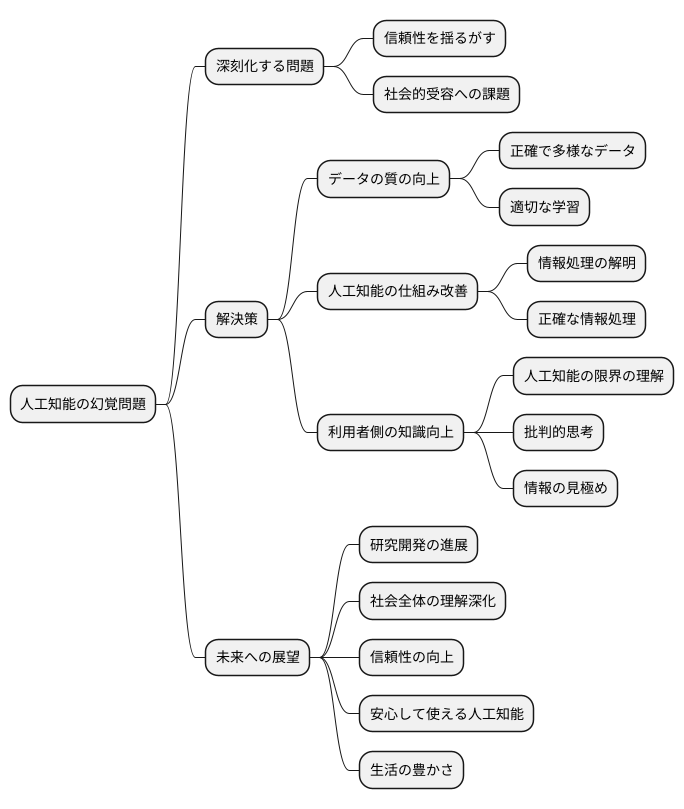

人工知能の幻覚は、人工知能技術の進歩に伴って深刻さを増す問題となっています。まるで人間が見ているかのような、しかし実際には存在しないものを見せる、まるで幻覚を見ているかのような現象です。この問題は、人工知能の信頼性を揺るがす大きな課題であり、その解決策を見つけることは、人工知能が社会に広く受け入れられ、活用されるために不可欠です。

人工知能の幻覚を減らすためには、人工知能の学習に使うデータの質を高めることが重要です。偏った情報や誤った情報が含まれるデータで学習させると、人工知能は間違った認識を学習し、幻覚を起こしやすくなります。そのため、正確で多様なデータを用いて、人工知能を適切に学習させる必要があります。また、人工知能の仕組みそのものを改善していくことも重要です。人工知能がどのように情報を処理し、どのような理由で幻覚を起こすのかを詳しく解明することで、より正確な情報処理を行う人工知能の開発につながります。

さらに、人工知能を使う私たち側の知識を高めることも重要です。人工知能は万能ではなく、時には誤った情報を出す可能性があることを理解し、その出力結果を鵜呑みにせず、批判的に吟味する必要があります。情報の出所を確認したり、他の情報源と比較したりするなど、情報の見極め方を学ぶことで、人工知能の幻覚に惑わされずに、正しい情報を判断できるようになります。

人工知能と人間が共に生きていくためには、人工知能の長所と短所を理解し、その特性に合わせて適切に利用することが大切です。今後の研究開発の進展や、社会全体で人工知能への理解が深まることで、幻覚の問題が解決され、より信頼性が高く、安心して使える人工知能が実現すると期待されています。人工知能は、私たちの生活を豊かにする大きな可能性を秘めています。その可能性を最大限に活かすためにも、幻覚の問題を克服し、信頼できる人工知能を築き上げていく必要があるでしょう。