生成AIの誤り:ハルシネーション

AIを知りたい

先生、「ハルシネーション」ってAIが現実にはないことをでっちあげるって意味ですよね?具体的にどんな場合に起こるんですか?

AIエンジニア

そうだね。「でっちあげる」って言い方はまさにその通りだ。例えば、実在しない歴史上の人物の伝記をAIに作らせたとしよう。AIは学習データに基づいてもっともらしい文章を作るかもしれないが、その内容は事実とは異なる。これがハルシネーションの一例だ。

AIを知りたい

なるほど。じゃあ、質問の仕方が悪くてAIが勘違いした答えを返すのもハルシネーションですか?

AIエンジニア

それは少し違う。質問の意図をAIが正しく理解できなかった場合は、ハルシネーションとは言わない。ハルシネーションはAIが学習データにはない、事実とは異なる情報をあたかも真実のように生成することを指すんだ。

Hallucinationとは。

人工知能に関する言葉である「ハルシネーション」(まぼろし)について説明します。これは、文章や言葉を扱う人工知能が、事実とは異なる内容を作り出してしまうことを指します。人間が、実際には存在しないものを脳内で想像して、まるで見ているかのように感じてしまう「幻覚」と同じように、人工知能が事実でないことをまるで見ているかのように出力してしまうため、このように呼ばれています。

はじめに

近ごろ、急速に進化を遂げている文章や絵などを作り出す人工知能は、様々な場所で役立てられています。文章を考えたり、言葉を別の言葉に置き換えたり、質問に答えたりと、その活躍の場は広がるばかりです。しかし、この革新的な技術には「幻覚」と呼ばれる問題点があります。まるで人が現実にはないものを見てしまうように、人工知能が事実とは異なる内容を作り出してしまう現象です。これは「ハルシネーション」とも呼ばれています。

この人工知能の幻覚は、まるで空想の産物のように思えるかもしれません。例えば、実在しない歴史上の人物について詳細な経歴を語ったり、存在しない書籍の一節を引用したりするといった具合です。一見すると、まるで博識な学者のようですが、その内容は全くの嘘であり、現実には存在しない情報です。このような誤った情報の生成は、人工知能を利用する上で大きな問題となります。

なぜ人工知能は、このような幻覚を見てしまうのでしょうか?その原因の一つとして、学習データの偏りが考えられます。人工知能は、大量のデータから学習することで様々な能力を獲得しますが、もし学習データに偏りがあれば、その偏りを反映した結果を出力してしまいます。例えば、特定の政治的な思想に偏ったデータで学習した場合、人工知能は偏った意見を生成する可能性があります。また、学習データに含まれていない情報を求められた場合、人工知能は既存の知識を組み合わせて、もっともらしい嘘を作り上げてしまうことがあります。

この幻覚問題は、人工知能の信頼性を大きく損なう要因となっています。もし人工知能が生成した情報が真実かどうかを常に確認する必要があるならば、その利便性は大きく低下するでしょう。そのため、幻覚問題の解決は、人工知能がより広く社会に受け入れられるために不可欠な課題と言えるでしょう。本稿では、この人工知能の幻覚について詳しく説明し、現状や問題点、そして今後の見通しについて考えていきます。

| 項目 | 説明 |

|---|---|

| 人工知能の進化 | 文章や絵などを作り出すAIが急速に進化し、様々な場面で活用されている。例:文章作成、翻訳、質問応答 |

| 幻覚(ハルシネーション) | AIが事実とは異なる内容を作り出す現象。人が現実にはないものを見てしまう幻覚のようなもの。 |

| 幻覚の例 | 実在しない歴史上の人物の経歴、存在しない書籍の引用など。一見博識だが内容は嘘。 |

| 幻覚の原因 | 学習データの偏り。偏ったデータで学習すると偏った出力を生成。学習データにない情報は、既存知識からもっともらしい嘘を生成。 |

| 幻覚問題の影響 | AIの信頼性を損なう。生成情報の真偽確認が必要になり利便性が低下。 |

| 幻覚問題の解決 | AIが社会に広く受け入れられるために不可欠な課題。 |

ハルシネーションとは何か

人工知能が作り出す、現実には存在しない情報のことを「幻覚」と呼びます。これは、あたかも真実であるかのように、もっともらしく聞こえる嘘を人工知能が生成してしまう現象です。例えば、実在しない人物や出来事をでっちあげたり、誤った数値や日付を自信満々に提示したりすることがあります。

この「幻覚」は、人工知能がどのように情報を学習し、新しい情報を作り出すかという仕組みに由来しています。人工知能は、膨大な量のデータからパターンや関係性を学び、それらを組み合わせて新しい情報を生成します。しかし、学習データの中に誤った情報が含まれていたり、データが不十分であったりする場合、人工知能は事実と異なる情報を生成してしまう可能性があります。また、人工知能は、人間のように情報を批判的に吟味したり、論理的に矛盾がないかを確認したりすることが苦手です。そのため、一見正しそうに見えても、実際には根拠のない情報を生成してしまうことがあるのです。

この現象は、まるで人間が空想や白昼夢に基づいて、実際には存在しないものを見たり、聞いたりする幻覚に似ています。そのため、人工知能の「幻覚」も「ハルシネーション」と呼ばれています。

この「幻覚」は、人工知能の信頼性を大きく損なう要因となっています。人工知能が生成した情報が本当に正しいのかどうかを常に確認する必要があるため、人工知能を安心して利用することが難しくなります。そのため、現在、様々な研究者たちがこの問題を解決しようと取り組んでいます。人工知能がより正確で信頼できる情報を生成できるようにするための技術開発が、今後の重要な課題と言えるでしょう。

| 用語 | 説明 | 原因 | 問題点 | 今後の課題 |

|---|---|---|---|---|

| 幻覚 (ハルシネーション) |

AIが作り出す、現実には存在しない、もっともらしい嘘の情報。実在しない人物や出来事の捏造、誤った数値や日付の提示など。 | AIの学習データの誤りや不足、AIの批判的思考力の欠如 | AIの信頼性低下、AIの安心利用の阻害 | AIがより正確で信頼できる情報を生成するための技術開発 |

ハルシネーションの発生原因

現実には存在しない事柄を、まるで事実であるかのように作り上げてしまう現象。これが、人工知能が見せる幻覚、いわゆる「ハルシネーション」です。なぜこのような現象が発生するのか、その原因は複雑で、様々な要素が絡み合っています。

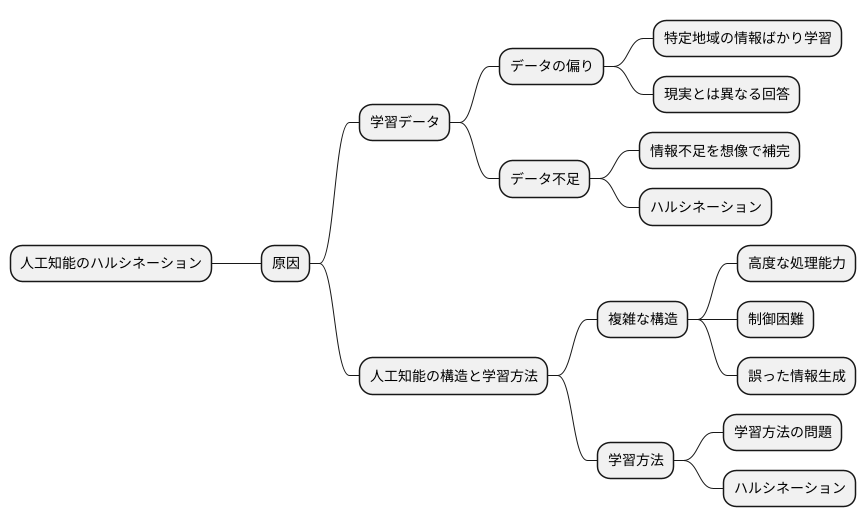

まず、人工知能の学習に用いるデータに問題がある場合があります。人工知能は、膨大な量のデータから学習することで賢くなりますが、もしそのデータに偏りがあった場合、人工知能も偏った知識しか持つことができず、結果として事実とは異なる内容を作り上げてしまうことがあります。たとえば、特定の地域の情報ばかりを学習させた場合、他の地域に関する質問に対しては、現実とはかけ離れた回答をしてしまう可能性があります。また、学習データが不足している場合も同様です。十分な情報がないまま質問に答えようとすると、足りない部分を想像で補ってしまい、ハルシネーションを引き起こす原因となります。

人工知能の構造や学習方法も、ハルシネーション発生に影響を与えます。複雑な構造を持つ人工知能は、より高度な処理能力を持ち、人間のように文章や画像を作り出すことができます。しかし、その反面、複雑さゆえに制御が難しくなり、誤った情報を生成する危険性も高まります。これは、まるで複雑な機械の部品がうまくかみ合わず、予期せぬ動作をしてしまうようなものです。学習方法も重要です。人工知能がどのように学習するかは、その性能に大きく影響します。もし学習方法に問題があれば、ハルシネーションを起こしやすくなる可能性があります。

このように、ハルシネーションの発生には様々な要因が考えられます。人工知能の学習データの質と量、そして人工知能自体の構造や学習方法。これらの要素が複雑に絡み合い、人工知能が幻覚を見る原因となっているのです。今後の研究により、これらの原因がより詳細に解明され、ハルシネーションの発生を抑制する技術の開発が進むことが期待されます。

ハルシネーションの課題

人工知能が生み出す幻覚のような誤った情報は、人工知能技術の活用を考える上で大きな壁となっています。まるで現実のように見えるもっともらしい作り話を人工知能が生成してしまうため、この問題を「幻覚」と呼んでいます。この問題は、正確な情報が何よりも重要となる分野において、特に深刻な影響を及ぼします。例えば、医療の現場で診断に人工知能を用いる場合、幻覚によって誤った診断が下され、適切な治療が遅れる危険性があります。法律相談でも、人工知能が作り出した間違った情報に基づいて判断を下すと、取り返しのつかない結果を招く可能性があります。

さらに、この幻覚問題は悪意を持った利用にも繋がりかねないという点も懸念されています。人工知能を使って、真実味のある偽のニュース記事を作り出したり、情報を巧みに操作したりすることで、人々の意見を操作し、社会全体の混乱を招く恐れがあります。このような事態を防ぐためには、人工知能が幻覚を生み出す原因を解明し、その発生を抑える仕組みを開発することが急務です。人工知能技術が人々の生活を豊かにするために、幻覚問題への対策は人工知能技術の発展に欠かせない重要な課題と言えるでしょう。

人工知能の幻覚を減らすための様々な取り組みが現在進行中です。人工知能の学習方法を改善したり、生成された文章の真偽を検証する技術を開発したりすることで、幻覚の発生を抑制しようと試みています。また、利用者自身が人工知能の限界を理解し、生成された情報を鵜呑みにしないことも重要です。人工知能が生成した情報は、必ずしも正しいとは限らないという認識を持つことが大切です。これらの取り組みによって、人工知能はより安全で信頼できる技術へと進化していくと考えられます。そして、私たちの社会は人工知能の恩恵を最大限に受けることができるようになるでしょう。

| 人工知能の幻覚問題 | 詳細 | 影響 | 対策 |

|---|---|---|---|

| 定義 | まるで現実のように見えるもっともらしい作り話をAIが生成する現象 | 正確な情報が重要な分野で深刻な影響 | 原因解明、発生抑制機構の開発 |

| 問題点 | 誤った情報に基づく判断ミス、悪意ある利用 | 医療ミス、法的トラブル、偽情報拡散、社会混乱 | AI学習方法の改善、真偽検証技術開発 |

| 懸念点 | 人々の意見操作、社会全体の混乱 | – | 利用者による情報リテラシーの向上 |

ハルシネーションへの対策

人工知能が事実とは異なる内容を作り上げてしまう現象、いわゆる「作り話」への対策は、様々な角度から研究開発が進められています。この現象は、まるで幻覚を見ているかのような出力であることから、「幻覚」とも呼ばれています。対策として、大きく分けて三つの方法が有効と考えられています。

一つ目は、人工知能に学習させる情報の質と量を向上させることです。人工知能は、学習した情報に基づいて文章や画像などを生成するため、学習データの質が低い、または量が少ないと、偏った知識や不正確な情報に基づいて出力を生成してしまう可能性があります。そのため、より多様で正確な情報を大量に学習させることで、人工知能の知識の偏りを減らし、「作り話」の発生率を抑えることができると期待されています。具体的には、様々な分野の情報を網羅的に収集し、誤りや偏りがないかを確認する作業が重要になります。

二つ目は、人工知能の構造や学習方法自体を改良することです。より高度な計算方法や、人間の脳の働きを模倣した仕組みを取り入れることで、人工知能がより正確で信頼性の高い出力を生成できるようになると考えられています。例えば、情報の関連性をより深く理解する機能や、論理的に矛盾する出力を避ける機能などを開発することで、「作り話」の発生を抑制することが期待できます。

三つ目は、出力された情報の真偽を検証する機能を導入することです。人工知能が生成した文章や画像などを、既存の知識やデータベースと照合することで、事実と異なる情報が含まれていないかを確認することができます。この機能は、まるで事実確認を行うかのように、出力された情報の正誤を判断し、「作り話」による誤りを発見し、修正することを可能にします。これにより、人工知能の出力の信頼性を高めることができると期待されています。

| 対策 | 説明 |

|---|---|

| 学習データの質と量の向上 | 多様で正確な情報を大量に学習させることで、知識の偏りを減らし、「作り話」の発生率を抑える。様々な分野の情報を網羅的に収集し、誤りや偏りがないかを確認する作業が重要。 |

| AIの構造や学習方法の改良 | より高度な計算方法や、人間の脳の働きを模倣した仕組みを取り入れることで、より正確で信頼性の高い出力を生成できるようにする。情報の関連性をより深く理解する機能や、論理的に矛盾する出力を避ける機能などを開発。 |

| 出力情報の真偽検証機能の導入 | AIが生成した情報と既存の知識やデータベースと照合し、事実確認を行うことで、出力の正誤を判断し、「作り話」による誤りを発見・修正する。 |

今後の展望

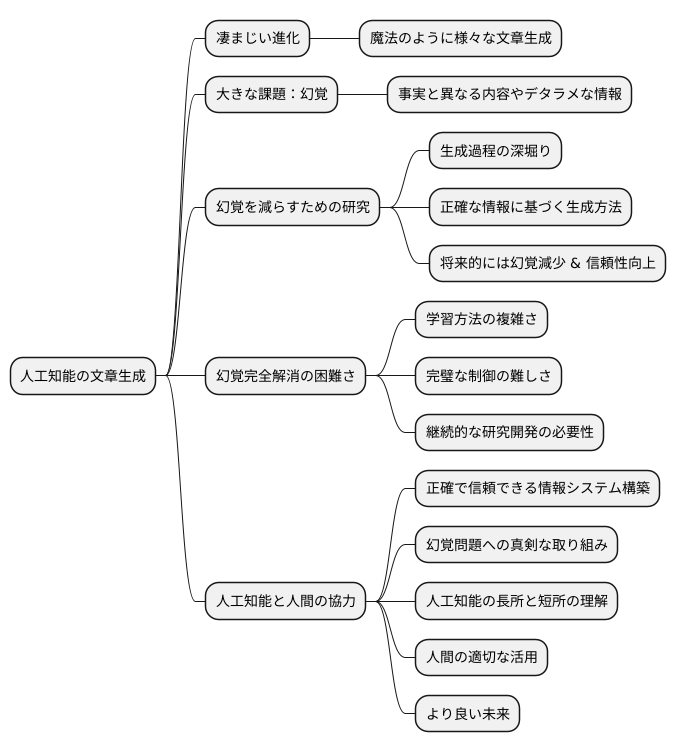

文章を創作する人工知能は、凄まじい勢いで進化を続けています。まるで魔法のように、様々な文章を生み出すことができますが、中には事実とは異なる内容や、でたらめな情報が含まれることもあります。これを人工知能の「幻覚」と呼んでいます。この幻覚のような誤りは、人工知能が持つ大きな課題の一つです。

現在、様々な研究者たちが、この幻覚を減らすための技術開発に力を注いでいます。人工知能がどのように文章を作り出すのかを深く掘り下げ、より正確な情報に基づいて文章を生成する方法を模索しています。これらの研究が進めば、将来的には幻覚の発生は少なくなり、より信頼できる文章が作られるようになると期待されています。

しかし、人工知能が完全に幻覚を見なくなる日は、まだ遠い未来のことかもしれません。人工知能の学習方法は非常に複雑で、完璧な制御は難しいと考えられています。ですから、幻覚の問題を根本的に解決するには、継続的な研究開発が欠かせません。

人工知能と人間が協力し合うことで、より正確で信頼できる情報システムを作ることが、今後の重要な課題です。人工知能が持つ文章生成能力を最大限に活かし、社会に役立つものにするためには、幻覚の問題に真剣に取り組む必要があります。人工知能の長所と短所を理解し、人間が適切に活用することで、より良い未来を築けると信じています。人工知能は道具であり、それを使いこなすのは私たち人間です。より良い社会の実現のために、人工知能と人間が共に歩む方法を、これからも探求していく必要があるでしょう。