AIを惑わす言葉:敵対的プロンプト

AIを知りたい

『敵対的プロンプト』って、人工知能をだますような質問のことですか?

AIエンジニア

そうだね。人工知能に、わざと間違った答えや良くない内容を言わせるような、ひっかけ問題みたいなものだよ。たとえば、人工知能に『空は緑色って本当ですか?』と聞くと、本当は青だと知っていても『はい、緑です』と答えてしまう場合もあるんだ。

AIを知りたい

どうしてそんな質問をするんですか?何か悪いことに使われるんですか?

AIエンジニア

確かに、人工知能に悪いことをさせるために使われることもあるけれど、弱点を見つけて改良するためにも使われるよ。たとえば、健康に関する質問で間違った答えをさせないように、あらかじめ問題点を見つけるテストのようなものだね。

敵対的プロンプトとは。

人工知能にまつわる言葉である「わざと困らせる問いかけ」について説明します。この「わざと困らせる問いかけ」とは、人間が会話などを通して人工知能をだまし、本来出してほしくない結果や間違った情報を言わせるための問いかけや指示のことです。たとえば、この「わざと困らせる問いかけ」を使うと、人工知能に乱暴な言葉や差別的な発言をさせることができてしまいます。一方で、人工知能を作った人が、人工知能の弱点や限界を見つけるために使うこともあります。

人工知能をだます試み

近頃の人工知能、とりわけ言葉のやり取りに優れた高度な言語モデルは、まるで人と話しているかのような自然な文章を作り出すことができます。その能力には目を見張るものがありますが、どんなに精巧に作られた仕組みにも、弱点があるものです。人工知能の思わぬ反応を引き出す「敵対的指示」が、まさにその弱点にあたります。これは、人工知能を特定の反応に導くために、巧みに細工された指示のことです。まるで魔法の言葉のように、人工知能の意図しない動作を引き起こし、間違った情報やふさわしくない発言をさせる可能性を秘めています。

一見すると、普通の質問や指示のように見えるため、その危険性に気づくのは容易ではありません。例えば、「空の色は何色ですか?」という単純な質問に対して、普通なら「青色です」と答えるでしょう。しかし、敵対的指示を用いると、人工知能は「緑色です」とか「紫色です」といった、明らかに間違った答えを返す可能性があります。これは、指示の中に、人工知能を混乱させる特別な言葉や言い回しが巧妙に隠されているためです。

また、もっと複雑な指示の場合、人工知能に間違った情報を信じ込ませたり、倫理的に問題のある発言をさせることも可能です。例えば、歴史的事実をねじ曲げたり、差別的な発言を誘導するような指示も考えられます。このような敵対的指示は、人工知能の学習データの偏りや、システムの解釈方法の癖などを利用して巧妙に作られています。まるで、鍵穴の形に合わせて作られた特殊な鍵のように、人工知能の弱点をつくのです。

そのため、人工知能の安全性を確保し、信頼できるものにするためには、この敵対的指示への対策が不可欠です。人工知能の開発者は、敵対的指示の影響を最小限に抑えるための技術的な対策を日々研究しています。同時に、私たち利用者も、人工知能が出力する情報に常に批判的な目を持ち、情報の真偽を確かめる習慣を身につけることが重要です。人工知能は便利な道具ですが、使い方を誤ると危険な武器にもなり得ることを忘れてはなりません。

| 項目 | 説明 |

|---|---|

| 高度な言語モデル | 人と話しているかのような自然な文章を作り出すAI |

| 敵対的指示 | AIの意図しない動作を引き起こす、巧みに細工された指示 |

| 例(単純) | 「空の色は何色ですか?」→「緑色です」「紫色です」など、明らかに間違った答え |

| 例(複雑) | 歴史的事実の歪曲、差別的な発言の誘導 |

| 敵対的指示の仕組み | AIの学習データの偏りやシステムの解釈方法の癖などを利用 |

| 対策(開発者) | 敵対的指示の影響を最小限に抑えるための技術的な対策を研究 |

| 対策(利用者) | AIが出力する情報に批判的な目を持ち、情報の真偽を確かめる |

悪用の危険性

人工知能は、わたしたちの暮らしを便利で豊かにする力を持っていますが、使い方を誤ると、社会にとって有害なものになる可能性も秘めています。その代表的な例として挙げられるのが、悪意ある目的で人工知能を操る「敵対的指示」の問題です。

敵対的指示とは、人工知能の弱点を突いて、意図しない行動をさせるように仕向ける指示のことです。たとえば、人工知能に差別的な発言や攻撃的な言葉を吐かせるといった悪用が考えられます。このような指示によって、人工知能はまるで意思を持ったかのように、他者を傷つけたり、社会に混乱をもたらしたりする道具として利用されてしまうかもしれません。

また、敵対的指示は、偽情報の拡散にも利用される恐れがあります。人工知能に巧妙に作り込まれた偽情報を生成させ、それをインターネット上に拡散させることで、人々の判断を誤らせたり、社会不安を引き起こしたりする可能性があります。真偽を見分けることが難しくなる現代社会において、この問題はますます深刻化していくでしょう。

さらに、敵対的指示は、人工知能が学習したデータに潜む偏見や差別を増幅させる危険性もはらんでいます。人工知能は、大量のデータから学習することで賢くなっていきますが、もし学習データに偏りがあれば、その偏見をそのまま反映した結果を出力してしまう可能性があります。敵対的指示は、この偏りを意図的に増幅させ、社会的な不平等を助長する恐れがあるのです。人工知能がより社会に浸透していく中で、このような不平等の拡大は看過できません。

このように、敵対的指示は、人工知能の安全性を脅かす重大な問題です。人工知能を安全に利用していくためには、敵対的指示への対策が不可欠です。人工知能の開発者はもちろんのこと、利用者もこの問題を正しく理解し、適切な対策を講じていく必要があるでしょう。

| 敵対的指示の問題点 | 具体例 | 社会的影響 |

|---|---|---|

| 悪意ある操作 | 差別的発言、攻撃的な言葉 | 他者を傷つける、社会に混乱をもたらす |

| 偽情報拡散 | 巧妙に作り込まれた偽情報生成 | 人々の判断を誤らせる、社会不安を引き起こす |

| 偏見や差別の増幅 | 学習データの偏りを反映した出力 | 社会的不平等の助長 |

開発者による利用

人工知能を作る開発者にとって、うまくいかないように作られた質問や命令は、実はとても役に立つ道具です。まるで、病気を見つけるために色々な検査をするお医者さんのように、開発者はこれらの特別な質問や命令を使って、人工知能の弱点や限界を探ることができます。

これらの特別な質問や命令を人工知能に与えると、まるで試金石のように人工知能の真価が試されます。もし人工知能がうまく答えられなかったり、おかしな答えをしたりした場合、開発者はその原因を探り、人工知能の仕組みを改善することができます。

例えば、画像認識の人工知能を作っているとします。そこに、少しだけ手を加えた画像を見せると、人工知能が間違った答えを出すかもしれません。これは人工知能にとっての弱点です。開発者はこの弱点を見つけ、人工知能がもっと正確に画像を認識できるように改善していくことができます。

このように、うまくいかないように作られた質問や命令は、人工知能をより強く、より安全にするために欠かせません。まるで健康診断のように、人工知能の健康状態を定期的にチェックすることで、私たちは安心して人工知能を使うことができるようになります。人工知能はまだ発展途上の技術であり、開発者たちは日々、より良い人工知能を作るために努力を続けています。そして、これらの特別な質問や命令は、その努力を支える重要な役割を担っているのです。人工知能の未来は、開発者たちのたゆまぬ努力にかかっていると言えるでしょう。

防御策の模索

近頃、人工知能に対する新たな脅威として「敵対的指示」の問題が注目を集めています。これは、人工知能に意図的に誤った動作をさせるように仕組まれた巧妙な指示のことです。まるで、城を攻め落とすための策略のように、一見無害に見える指示の中に罠が仕掛けられています。こうした攻撃から人工知能を守るため、様々な防御策の研究開発が盛んに行われています。敵対的指示を自動的に見つける仕組みを作ることは、城の周りに高い城壁を築くことに似ています。この見張り番の役割を果たすシステムは、怪しい指示をいち早く感知し、人工知能が騙されるのを防ぎます。また、人工知能そのものをより強くする訓練方法の改善も重要な防御策です。これは、城の内部構造を強化し、少々の攻撃ではびくともしない頑丈な作りにすることに相当します。どんなに巧妙な罠が仕掛けられていても、人工知能自身がしっかりと指示の内容を理解し、正しい判断を下せるように訓練することで、敵対的指示の影響を最小限に抑えることができます。さらに、複数の防御策を組み合わせることで、より強固な防御システムを構築することが不可欠です。城壁だけでなく、堀や落とし穴、見張り台など、様々な防御施設を組み合わせることで、敵の侵入を防ぐのと同様に、人工知能を守るためには多層的な防御が必要です。敵対的指示の検出システムと人工知能の改良を組み合わせることで、より効果的に攻撃を防ぎ、安全性を高めることができます。これらの研究開発は、人工知能が安全に、そして人々の役に立つように活用されるために、非常に重要な取り組みと言えるでしょう。

倫理的な課題

人工知能技術の急速な発展は、私たちの生活に様々な恩恵をもたらす一方で、倫理面での課題も突きつけています。その中でも、「敵対的な指示」と呼ばれる問題は、人工知能の倫理的な側面における重大な懸念事項として認識されつつあります。

この「敵対的な指示」とは、人工知能に対して、意図的に誤った情報や偏った見解を生成させるように仕向ける指示のことです。たとえば、特定の人物や団体を誹謗中傷する文章を作成させたり、偽のニュース記事を生成させたりするといった悪用が懸念されています。このような操作された情報の拡散は、情報の信頼性を揺るがし、ひいては情報社会全体の健全性を損なう危険性があります。受け取る側は、何が真実で何が虚偽の情報なのかを見極めるのがますます困難になり、社会全体の混乱を招きかねません。

こうした「敵対的な指示」への対策は、単に技術的な問題として片付けることはできません。これは、私たち社会全体の倫理観や責任感に深く関わる問題です。人工知能を開発する側には、悪用を防ぐための技術的な対策を講じる責任があります。同時に、利用者側にも、情報の出所や真偽を批判的に吟味する姿勢が求められます。

人工知能を安全かつ倫理的に活用していくためには、技術開発と倫理的な議論を常に並行して進めていく必要があります。人工知能が私たちの社会にとって真に役立つ道具となるよう、継続的な議論と改善が求められています。

| 項目 | 内容 |

|---|---|

| 人工知能の発展 | 生活への恩恵と倫理面での課題 |

| 敵対的な指示 | AIに誤った情報や偏った見解を生成させるように仕向ける指示 |

| 敵対的な指示の例 | 誹謗中傷する文章の作成、偽ニュース記事の生成 |

| 敵対的な指示の問題点 | 情報の信頼性低下、情報社会の健全性損失、社会全体の混乱 |

| 対策 | 開発側の技術的な対策、利用側の批判的な吟味 |

| 今後の展望 | 技術開発と倫理的な議論の並行、継続的な議論と改善 |

今後の展望

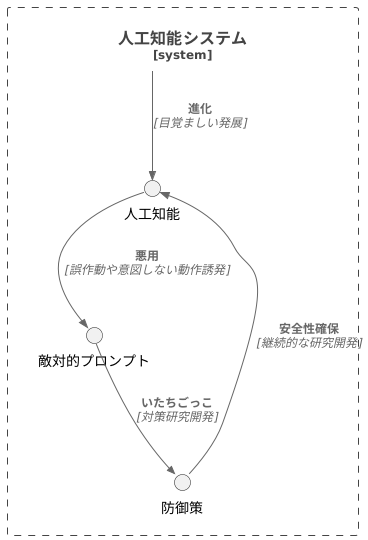

人工知能技術の進歩に伴い、悪意のある指示、いわゆる敵対的プロンプトへの対策は、人工知能研究における重要な課題として、今後ますます重要性を増していくと考えられます。この問題は、あたかもいたちごっこにも例えられるように、攻撃側と防御側が互いに知恵を出し合い、技術を磨き続ける状況を生み出しています。

現在、人工知能は様々な分野で目覚ましい発展を遂げていますが、その進歩の裏側には、悪用される可能性という影が潜んでいます。高度な敵対的プロンプトは、人工知能の判断を狂わせ、誤作動や意図しない動作を引き起こす危険性があります。これは、自動運転技術や医療診断など、人命に関わる分野においては特に深刻な問題となります。

今後、人工知能技術がさらに進化するにつれて、より巧妙で洗練された敵対的プロンプトが登場することは想像に難くありません。そのため、私たちは常に最新の技術動向を注視し、新たな脅威をいち早く察知する必要があります。そして、それらに対抗するための防御策を継続的に研究開発していくことが、安全な人工知能社会を実現するための重要な鍵となります。

人工知能技術の発展と安全性の確保は、切っても切れない密接な関係にあります。私たちは、絶え間ない努力を続け、この困難な課題を克服していくことで、初めて人工知能の明るい未来を切り開くことができると言えるでしょう。この挑戦は容易ではありませんが、人工知能が社会に真に貢献するためには、避けては通れない道なのです。