Grad-CAMで画像認識の根拠を視覚化

AIを知りたい

先生、「グラッドカム」って、なんだか難しそうでよくわからないんですけど、簡単に説明してもらえますか?

AIエンジニア

そうだね、難しそうに見えるかもしれないけど、大丈夫だよ。簡単に言うと、AIが画像を見て何かを判断した時に、「どうしてそう思ったの?」という理由を、私たち人間にもわかるように色で示してくれる技術なんだ。例えば、AIが「これは猫だ」と判断したら、猫の顔や体に色が濃くついて、「ここを見て猫だと判断したんだよ」と教えてくれるようなものだよ。

AIを知りたい

なるほど!じゃあ、色が濃いところは、AIが特に注目したところってことですね!でも、どうやって色をつけるんですか?

AIエンジニア

いい質問だね!AIの中身は複雑な計算をしているんだけど、その計算の過程で、どの部分がどれくらい重要かを数値で表すことができるんだ。その数値が高い部分ほど、色が濃くなるように調整しているんだよ。この色のついた図を「ヒートマップ」と呼ぶんだ。グラッドカムのように、AIの判断の根拠を説明できるAIを「説明できるAI」と言うんだよ。

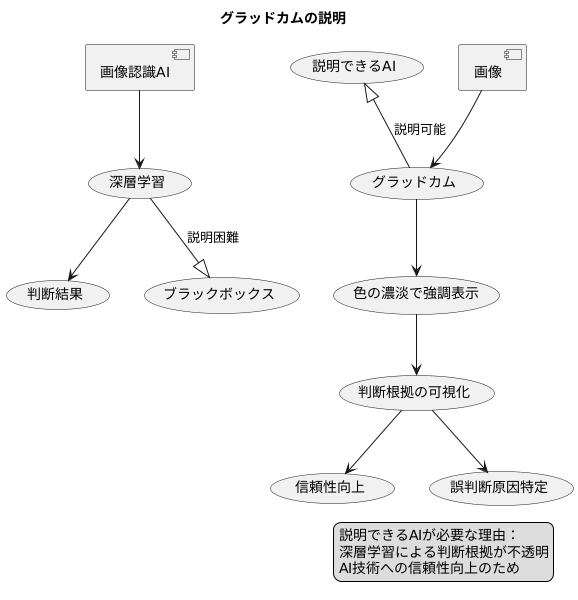

Grad-CAMとは。

人工知能にまつわる『グラッドカム』という用語について説明します。グラッドカムは、画像認識の作業で、画像のどの部分が判断の根拠になったのかを分かりやすく表示する方法です。グラッドカムは、色の濃淡で示した図を用います。色が濃いほど、判断の根拠になっている可能性が高いことを表します。この色の濃淡で示した図は、畳み込み層と呼ばれる部分の勾配を使って作られます。グラッドカムのように、判断の理由を人間にも理解できるように説明できる人工知能を、説明可能な人工知能と呼びます。

Grad-CAMの概要

近年の技術革新により、人の目では判別できない微妙な違いも見抜くことができる画像認識の技術は目覚しい進歩を遂げました。特に、深層学習と呼ばれる技術を用いた画像認識は、その精度の高さから様々な分野で活用されています。しかし、深層学習は複雑な計算過程を経て結果を導き出すため、どのような根拠でその判断に至ったのかを人間が理解することは容易ではありません。まるで中身の見えない黒い箱のような、このブラックボックス化された状態は、AI技術への信頼を損なう一因となっています。そこで、AIの判断の理由を明らかにし、人間にも理解できるようにする技術が求められるようになりました。これを説明可能なAI、つまり説明できるAIと呼びます。

この説明できるAIを実現する代表的な方法の一つが、今回紹介するグラッドカムと呼ばれる技術です。グラッドカムは、AIが画像のどの部分に着目して判断を下したのかを、色の濃淡で表現した図として示してくれます。例えば、AIが一枚の写真を見て「ねこ」と判断したとします。このとき、グラッドカムを使うと、ねこの耳や尻尾といった、ねこだと言える特徴的な部分が、図の中で明るく強調されて表示されます。つまり、AIはこれらの部分を見て「ねこ」だと判断したことが視覚的に分かるようになります。

グラッドカムは、AIの判断根拠を分かりやすく示すことで、AI技術のブラックボックス化された部分を解消するのに役立ちます。これは、AIの判断に対する信頼性を高めるだけでなく、AIが誤った判断をした場合に、その原因を特定するのにも役立ちます。例えば、AIが「ねこ」ではなく「いぬ」と誤って判断した場合、グラッドカムで表示される図を見ることで、AIが誤って「いぬ」の特徴と判断した部分が分かります。このように、グラッドカムは、AIの判断過程を理解し、改善していく上で非常に重要な役割を果たします。そして、AI技術をより深く理解し、より安全に活用していくための、重要な技術と言えるでしょう。

畳み込み層と勾配

畳み込み層は、画像認識を得意とする畳み込みニューラルネットワーク(CNN)の心臓部と言える重要な構成要素です。CNNは、人間の視覚野の仕組みを模倣した階層的な構造を持っており、複数の畳み込み層を積み重ねることで、画像から様々な特徴を段階的に抽出していきます。

各畳み込み層には、特定の模様や形に反応するフィルターが備わっています。このフィルターは、まるで虫眼鏡のように画像全体をくまなく走査し、対応する特徴を見つけ出す役割を担います。例えば、初期の層では、単純な直線や曲線といった低レベルな特徴が抽出され、後の層に進むにつれて、それらが組み合わさり、より複雑な模様や形状、例えば目や鼻、口といった高レベルな特徴が抽出されていきます。

Grad-CAMは、この畳み込み層の働きを分析するための強力な手法です。「猫」や「犬」といった特定の対象を認識する際に、どの部分がどれほど重要なのかを視覚的に示すことができます。具体的には、CNNの最終的な畳み込み層の出力を利用し、特定の対象(例えば「猫」)に対する確率についての勾配を計算します。この勾配は、各フィルターがその対象の認識にどれだけ貢献しているかを示す重要な指標となります。つまり、勾配の値が大きいフィルターほど、そのフィルターが捉えた特徴が「猫」の認識に大きく寄与していると言えるのです。Grad-CAMは、この勾配情報を基に、画像のどの領域が対象の認識に重要だったのかを強調表示するヒートマップを作成します。これにより、CNNがどのように画像を解釈し、判断を下しているのかを深く理解することが可能になります。

| 項目 | 説明 |

|---|---|

| 畳み込み層 | CNNの心臓部。画像から特徴を抽出する。フィルターが画像を走査し、低レベルな特徴から高レベルな特徴まで段階的に抽出。 |

| CNN(畳み込みニューラルネットワーク) | 人間の視覚野を模倣した階層構造を持つニューラルネットワーク。複数の畳み込み層を積み重ねることで画像認識を行う。 |

| フィルター | 畳み込み層が持つ、特定の模様や形に反応する要素。画像全体を走査し、対応する特徴を見つけ出す。 |

| Grad-CAM | 畳み込み層の働きを分析する手法。特定の対象を認識する際に、どの部分が重要かを視覚的に示す。 |

| 勾配 | Grad-CAMで利用される、特定の対象に対する確率についての勾配。各フィルターが対象の認識にどれだけ貢献しているかを示す。 |

| ヒートマップ | Grad-CAMが作成する、対象の認識に重要な画像領域を強調表示した図。CNNの解釈と判断過程を理解するのに役立つ。 |

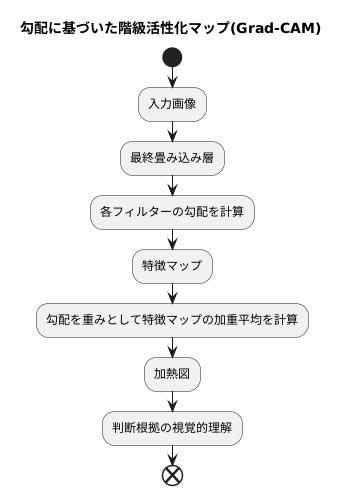

ヒートマップの作成

勾配に基づいた階級活性化マップ(Grad-CAM)は、画像認識などにおいて、人工知能がどのように判断を行っているのかを視覚的に分かりやすく示すための手法です。この手法を用いることで、人工知能が注目している画像の領域を強調表示した図、すなわち加熱図を作成することができます。

加熱図の作成過程を見ていきましょう。まず、人工知能の中枢にある畳み込み層に着目します。畳み込み層は、複数のフィルターを通して画像の特徴を捉えます。それぞれのフィルターは、特定の模様や形に反応するように学習されています。Grad-CAMでは、最終的な畳み込み層の出力を利用し、各フィルターの勾配を計算します。勾配とは、各フィルターの出力が最終的な判断にどの程度影響を与えているかを示す指標です。

次に、計算された勾配を重みとして用いて、最終畳み込み層の特徴マップの加重平均を計算します。特徴マップとは、各フィルターが画像から抽出した特徴を表す図です。加重平均を計算することで、最終的な判断に大きく影響を与えている特徴が強調されます。

こうして得られた加重平均が加熱図となります。加熱図上では、人工知能が注目している領域ほど明るい色で表示されます。例えば、赤い色は強い注目を示し、青い色は弱い注目を示します。このように、色の濃淡によって人工知能の判断根拠を視覚的に把握することができます。例えば、猫を認識する人工知能の場合、加熱図によって猫の耳や尻尾といった特徴的な部分が赤く表示されることで、人工知能がこれらの部分に着目して猫を認識していることが分かります。

Grad-CAMは、複雑な計算処理を経て加熱図を作成しますが、最終的には視覚的に分かりやすい形で結果を出力します。そのため、人工知能の専門家でなくても、人工知能の判断根拠を直感的に理解することができます。これは、人工知能の判断の透明性を高め、信頼性を向上させる上で重要な役割を果たします。

XAIにおける役割

説明可能な人工知能(エックスエーアイ)とは、人工知能の判断の理由を人間が理解できるようにする技術です。この技術は、人工知能が信頼できるものとなるために、そして社会に広く受け入れられるために、とても重要です。説明可能な人工知能の中でも、グラッドカムと呼ばれる技術は中心的な役割を担っています。グラッドカムは、人工知能が画像を見て、どのように判断したのかを、視覚的に分かりやすく示すことができます。グラッドカムは、人工知能の判断の根拠を説明するだけでなく、人工知能の誤りを発見し、性能を向上させるためにも役立ちます。

例えば、画像認識の人工知能が、猫の画像を見て「犬」と誤って判断したとします。このとき、グラッドカムを使うと、人工知能が画像のどの部分を見て「犬」と判断したのかが分かります。もし、人工知能が猫の耳ではなく、背景のソファに注目していたとしたら、人工知能は猫の特徴を正しく学習できていないと考えられます。このような場合、人工知能に与える学習データをより多くの猫の画像を含むように変更したり、人工知能の構造そのものを調整することで、より正確な判断ができるように改善することができます。

グラッドカムは、医療診断や自動運転といった、人の命に関わる重要な分野でも期待されています。医療診断では、人工知能がレントゲン写真から病気を診断する際に、グラッドカムを使うことで、医師は人工知能の診断根拠を確認できます。もし人工知能が誤った部分を見て診断していた場合、医師はそれに気付き、適切な判断を下すことができます。自動運転では、人工知能が周囲の状況をどのように認識し、どのような行動をとろうとしているのかをグラッドカムで確認することで、より安全な自動運転システムを作ることが可能になります。このように、グラッドカムは、人工知能の判断を透明化し、人間と人工知能の協調を実現することで、より安全で信頼性の高い人工知能システムの構築に貢献していくと考えられます。

| 項目 | 説明 |

|---|---|

| 説明可能なAI (XAI) | AIの判断理由を人間が理解できるようにする技術。AIの信頼性向上と社会受容に重要。 |

| Grad-CAM | XAIの中心的技術。AIの画像判断の根拠を視覚的に分かりやすく表示。AIの誤り発見や性能向上にも役立つ。 |

| Grad-CAMの活用例 (猫の誤認識) | 猫を犬と誤認識した場合、Grad-CAMでAIが注目した部分を特定 (例: 背景のソファ)。学習データやAI構造の調整で改善可能。 |

| Grad-CAMの応用分野 | 医療診断 (レントゲン写真診断の根拠確認)、自動運転 (AIの状況認識と行動確認による安全性向上) など。 |

| Grad-CAMのメリット | AIの判断を透明化し、人間とAIの協調を実現。より安全で信頼性の高いAIシステム構築に貢献。 |

適用事例

Grad-CAM(勾配加重クラス活性化マップ)は、画像の中のどの部分がAIの判断に影響を与えたかを視覚的に分かりやすく示してくれる技術です。この技術は、様々な場面で活用されています。

例えば、写真に説明文をつける画像説明生成では、Grad-CAMを使うことで、説明文のそれぞれの単語が、写真のどの部分に基づいて生成されたのかを色分けして示すことができます。「青い空」という単語に対応する空の部分が青く強調して表示され、「白い雲」に対応する雲の部分が白く強調して表示されるといった具合です。これにより、AIがどのように画像を理解し、説明文を生成しているのかを詳しく調べることができます。

画像の中から特定のものを探し出す物体検出では、検出したもののどの部分が、そのものの認識に役立ったのかを、色の濃淡で表現した図で示すことができます。例えば、写真の中から「猫」を検出した場合、猫の耳や尻尾といった特徴的な部分が、色の濃い部分として表示されるでしょう。この技術は、AIの認識精度を高めるのに役立ちます。

医療画像診断での活用も目覚ましいものがあります。例えば、胸のレントゲン写真から肺炎を見つけるAIの場合、Grad-CAMを使うことで、AIが肺炎だと判断した根拠となる肺の炎症部分を、色の濃淡で示すことができます。これにより、医師はAIの判断の理由を理解し、診断の正確さを高めることができます。また、AIが誤って判断した場合にも、その原因を特定し、AIの改良につなげることができます。このように、Grad-CAMは、AI技術の発展、そして様々な分野への応用に大きく貢献しています。

| 分野 | Grad-CAMの活用例 | メリット |

|---|---|---|

| 画像説明生成 | 説明文の各単語に対応する画像部分を色分け表示 | AIが画像をどのように理解し、説明文を生成しているかを詳しく調べることができる |

| 物体検出 | 検出したものの認識に役立った部分を色の濃淡で表示 | AIの認識精度を高めるのに役立つ |

| 医療画像診断 | AIが判断した根拠となる部分を色の濃淡で表示 (例:肺炎の診断) |

医師がAIの判断の理由を理解し、診断の正確さを高めることができる AIが誤って判断した場合の原因を特定し、AIの改良につなげることができる |

今後の展望

説明可能な人工知能(XAI)を実現するための強力な手法として、勾配に基づくクラス活性化マップ(Grad-CAM)が注目されています。この手法は、画像認識などにおいて、人工知能が特定の判断を下した根拠を視覚的に分かりやすく示すことができます。具体的には、人工知能が注目した画像の領域を、色の濃淡で表現したヒートマップとして表示します。例えば、猫の画像を認識する際に、Grad-CAMを用いると、人工知能が猫の耳や目に注目して判断していることが分かります。

しかし、Grad-CAMは発展途上の技術であり、いくつかの課題も残されています。例えば、現在のGrad-CAMでは、生成されるヒートマップの解像度が十分ではない場合があります。そのため、人工知能が具体的に画像のどの部分に注目しているのかを、より詳細に把握することが難しい場合があります。また、複雑な構造を持つ人工知能モデルへの適用が難しいという課題もあります。今後の研究では、これらの課題を克服し、より高精度で汎用性の高いGrad-CAMの開発が期待されます。

さらに、Grad-CAMは、人工知能の判断根拠と画像の特定領域との相関関係を示すものであり、因果関係を明らかにするものではないという点に注意が必要です。つまり、ヒートマップで強調された領域が、必ずしも人工知能の判断に直接的に影響を与えているとは限りません。例えば、猫の画像認識で、猫の周りの背景がヒートマップで強調されたとしても、人工知能が背景を見て猫と判断しているとは限らないのです。相関関係と因果関係の違いを理解した上で、Grad-CAMの結果を解釈することが重要です。

今後、Grad-CAMの改良や新たなXAI技術の開発が進むことで、人工知能のブラックボックス部分が解消され、人工知能はより人間にとって理解しやすく、信頼できる存在になると期待されます。特に、人工知能の倫理的な側面が重視される現代において、XAI技術の発展は人工知能の社会実装を進める上で欠かせない要素と言えるでしょう。人工知能がどのように判断を下しているかを理解することで、我々は人工知能をより効果的に活用し、より良い社会を築くことができるはずです。

| 項目 | 内容 |

|---|---|

| 手法 | 勾配に基づくクラス活性化マップ(Grad-CAM) |

| 目的 | 説明可能なAI(XAI)の実現、AIの判断根拠の視覚化 |

| 機能 | AIが注目した画像領域をヒートマップで表示 |

| 利点 | AIの判断根拠を視覚的に理解できる |

| 課題 |

|

| 今後の展望 |

|