スキップ結合:深層学習の革新

AIを知りたい

先生、「スキップ結合」がよくわからないのですが、教えていただけますか?

AIエンジニア

はい。スキップ結合とは、建物を建てる時に、途中の階を飛ばして、下の階と上の階を直接つなぐようなものです。例えば、1階と3階を直接つなぐ階段を作るようなイメージです。こうすることで、情報がスムーズに伝わるようになります。

AIを知りたい

なるほど。階段の例えだと分かりやすいです。情報がスムーズに伝わるのは、なぜですか?

AIエンジニア

下の階の情報を上の階に直接伝えることで、情報が薄まったり、途中で途切れたりするのを防ぐことができるからです。建物の例でいうと、1階の荷物を持って3階まで行くときに、2階を通らずに階段で直接行けば、2階に荷物を一旦置いておく必要がないので、荷物が無くなる心配もありませんよね。ResNetという有名な建物は、このスキップ結合をうまく使って、とても高い建物を作ることができました。

スキップ結合とは。

人工知能の分野で使われる「飛び越し結合」という用語について説明します。飛び越し結合は、畳み込みニューラルネットワークという画像認識などでよく使われる技術において、複数の層を飛び越えて繋げる方法です。通常、ニューラルネットワークは層が深くなるほど学習が難しくなりますが、この飛び越し結合を使うことで、より深い層を持つネットワークを構築し、性能を向上させることができます。飛び越し結合を使った代表的な例として、ResNet(「残差ネットワーク」と訳されます)が挙げられます。

概要

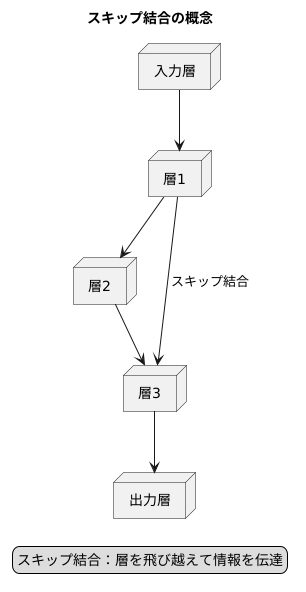

畳み込みニューラルネットワーク(CNN)において、層と層の間を飛び越えて情報を伝える機構がスキップ結合です。従来のCNNでは、情報は層を順々に通過し、次の層へと伝えられていきます。まるで階段を一段一段上るように、情報はネットワークの中を深く進んでいきます。しかし、この方法には問題点がありました。ネットワークが深くなると、学習がうまく進まなくなる、勾配消失問題と呼ばれる現象が発生してしまうのです。深いネットワークは複雑な事柄を学習するのに適していますが、この問題によって、その能力を十分に発揮できませんでした。

スキップ結合は、この問題を解決する画期的な手法です。ある層の出力を、より深い層に直接伝えることで、情報の伝達経路を短縮します。階段を一段ずつ上るのではなく、数段まとめて飛び越えるイメージです。これにより、勾配が消失しにくくなり、深いネットワークでも効率的に学習を進めることができます。

スキップ結合によって、ネットワークはより複雑な情報を捉えることができるようになります。例えば、画像認識のタスクでは、初期の層では単純な輪郭や色を認識し、深い層ではより複雑な形状や模様を認識します。スキップ結合は、これらの異なるレベルの情報を統合し、より正確な認識を可能にします。また、スキップ結合は、ネットワークの表現力を向上させる効果もあります。情報伝達経路が複数になることで、ネットワークは多様な情報を学習し、より柔軟に表現できるようになります。これは、精度の向上に大きく貢献します。スキップ結合は、CNNの設計における重要な技術であり、様々な分野で活用されています。

勾配消失問題への対処

深い構造を持つ神経網の学習では、勾配消失という問題に直面することがあります。これは、誤差を逆方向に伝える際に、勾配の値が層を遡るごとに小さくなり、入力に近い層の重みがうまく調整できなくなる現象です。この問題は、深い神経網をうまく学習させる上で大きな壁となります。

この勾配消失問題への対策として、様々な工夫が考えられてきました。その中でも、層と層を飛び越えて繋ぐ「スキップ結合」は有効な方法の一つです。通常、神経網では前の層の出力が次の層の入力となりますが、スキップ結合では、例えば1つ前の層の出力を、2つ後の層の入力に直接加えます。これにより、勾配が途中で小さくなることなく、深い層から入力に近い層まで直接伝わるようになります。

スキップ結合の利点は、勾配消失問題を緩和するだけでなく、学習の速度を上げる効果も期待できることです。深い層からの勾配が直接浅い層に伝わることで、浅い層の重みも早く最適な値に近づくためです。また、スキップ結合を導入することで、異なる層の特徴を組み合わせる効果も得られます。例えば、画像認識において、浅い層は局所的な特徴を捉え、深い層は大域的な特徴を捉えているとします。スキップ結合によってこれらの特徴を組み合わせることで、より豊かな情報を学習に活用できます。

このように、スキップ結合は勾配消失問題を克服し、深い神経網の学習を効率的に行う上で重要な役割を果たしています。様々な種類のスキップ結合が提案されており、それぞれの特性を理解して適切に活用することが、高性能な神経網の構築に繋がります。

代表的な応用例:ResNet

残差ネットワーク(ResNet)は、層を深く積み重ねたニューラルネットワークにおける勾配消失問題に対処するために考案された、画期的なネットワーク構造です。このResNetは、層と層の間に「スキップ結合」と呼ばれる近道を作ることで、学習を効率化しています。

ResNetの要となるのは、残差学習という考え方です。従来のニューラルネットワークは、層を重ねるごとに複雑な特徴を抽出していきます。しかし、層が深くなるにつれて、勾配が小さくなり、学習が進まなくなるという問題がありました。ResNetでは、この問題を解決するために、各層で入力そのものに加えるべき変化量、つまり「残差」を学習するように設計されています。

スキップ結合は、入力データをそのまま数層先の層に伝える経路です。ResNetでは、このスキップ結合を恒等写像として用いています。つまり、入力データを何も変換せずにそのまま伝えるのです。そして、各層では、この入力データに加えるべき残差を学習します。学習した残差と入力データを足し合わせることで、次の層への入力が作られます。

この残差学習とスキップ結合の組み合わせが、ResNetの大きな成果の鍵です。残差を学習することで、各層はわずかな変化量だけを学習すればよくなります。これにより、勾配消失問題を効果的に抑えることができます。また、スキップ結合によって、入力情報がネットワークの深い層まで直接伝わるため、情報の伝達効率も向上します。

ResNetの登場は、画像認識をはじめ、様々な分野で目覚ましい成果を上げました。特に画像認識の分野では、従来の方法をはるかに上回る精度を達成し、深層学習の発展に大きく寄与しました。今では、ResNetは画像認識だけでなく、自然言語処理や音声認識など、様々な分野で広く活用されています。

多様な構造

様々な構造を持つスキップ結合について説明します。スキップ結合とは、ニューラルネットワークにおいて、ある層の出力を、より深い層へと直接伝達する経路のことです。この仕組みにより、勾配消失問題の緩和や、特徴情報の伝達効率向上といった効果が期待できます。代表的な構造として、残差ネットワーク(ResNet)で用いられる恒等写像があります。これは、入力された情報をそのまま何の変換も加えずに、出力へと渡す構造です。この単純な構造でありながら、勾配消失問題を効果的に抑制し、深いネットワークの学習を可能にしました。

しかし、スキップ結合は恒等写像以外にも、様々な構造を取り得ます。例えば、畳み込み層を用いたスキップ結合では、入力情報に畳み込み処理を施してから、深い層へと伝達します。これにより、特徴量の抽出を強化し、表現力の向上を図ることができます。また、プーリング層を用いることで、入力情報の解像度を調整し、計算量を削減することも可能です。スキップ結合は恒等写像以外にも、畳み込み層やプーリング層など、様々な構成要素を組み合わせることができ、ネットワークの特性や学習データの性質に合わせて、最適な構造を選択することが重要です。

近年では、スキップ結合の構造を自動的に設計する手法も研究されています。これは、従来のように人手で試行錯誤的に構造を決定するのではなく、アルゴリズムによって最適な構造を探索するという画期的な試みです。この技術により、より高性能なネットワークを効率的に構築することが期待され、今後の発展が注目されています。スキップ結合は深層学習において重要な技術であり、その多様な構造と自動設計技術の発展により、更なる性能向上が期待できます。

| スキップ結合の種類 | 説明 | 効果 |

|---|---|---|

| 恒等写像 | 入力情報をそのまま出力へ渡す | 勾配消失問題の抑制 |

| 畳み込み層を用いたスキップ結合 | 入力情報に畳み込み処理を施してから深い層へ伝達 | 特徴量の抽出強化、表現力の向上 |

| プーリング層を用いたスキップ結合 | 入力情報の解像度を調整 | 計算量の削減 |

| 自動設計 | アルゴリズムによって最適な構造を探索 | 高性能なネットワークの効率的な構築 |

今後の展望

飛び越し結合は、近年の深層学習において欠かせない技術になりつつあります。まるで建物の階層を飛び越えるエレベーターのように、神経回路網の層を飛び越えて情報を伝えることで、学習の効率と精度を向上させる革新的な手法です。特に、画像の認識や自然言語の処理、音声の認識といった様々な分野で、その効果が証明されています。

飛び越し結合が注目される理由の一つに、勾配消失問題の緩和があります。深い神経回路網では、誤差逆伝播法を用いて学習を進める際に、勾配が小さくなってしまい、学習が停滞する勾配消失問題が発生しやすいです。飛び越し結合は、層を飛び越えて情報を伝えることで、この問題を緩和し、深い神経回路網でも効率的に学習を進めることを可能にします。また、異なる階層の特徴を組み合わせることで、より豊かな表現力を獲得できる点も大きな利点です。例えば、画像認識では、初期の層で抽出された輪郭や色の情報と、後の層で抽出された物体全体の特徴を組み合わせることで、より正確な認識を可能にします。

今後の研究開発においては、より高度な飛び越し結合の設計手法が求められます。現在の主流は、単純に層を飛び越えて結合する手法ですが、結合の仕方や重み付けを工夫することで、更なる性能向上が期待できます。例えば、特定の条件下でのみ情報を伝達する、動的な飛び越し結合なども考えられます。また、新たな応用分野の開拓も重要な課題です。現在、画像認識や自然言語処理といった分野で成果を上げていますが、他の分野への応用も積極的に模索することで、深層学習の可能性は更に広がると考えられます。例えば、医療分野における画像診断や、金融分野におけるリスク予測など、様々な分野での活用が期待されます。

飛び越し結合は、深層学習の進化を支える重要な要素として、今後も研究開発が活発に行われ、更なる発展を遂げるでしょう。その進化は、人工知能技術全体の発展にも大きく貢献していくと考えられます。

| 項目 | 内容 |

|---|---|

| 定義 | 神経回路網の層を飛び越えて情報を伝える技術 |

| 効果 | 学習の効率と精度向上 |

| 応用分野 | 画像認識、自然言語処理、音声認識など |

| 勾配消失問題への効果 | 勾配消失問題を緩和し、深い神経回路網でも効率的な学習を可能にする |

| 利点 |

|

| 今後の研究開発 |

|

実装の容易さ

飛び越え接続は、仕組みは単純ですが効果的な方法であり、既存の神経網構造にも簡単に組み込むことができます。多くの深層学習の道具箱では、飛び越え接続を簡単に実現するための機能が用意されているので、開発者は複雑な処理を書かなくても、飛び越え接続の恩恵を受けることができます。

この手軽さも、飛び越え接続が広く使われるようになった理由の一つと言えるでしょう。色々な種類の網で試行錯誤を行い、最適な構造を探す上で、飛び越え接続は強力な道具となります。例えば、画像認識の分野でよく使われる畳み込み神経網では、飛び越え接続を使うことで、深い層の情報が浅い層に直接伝わるようになります。これは、深い層で学習した特徴が薄まるのを防ぎ、精度の向上に繋がります。

また、飛び越え接続は、勾配消失問題の軽減にも役立ちます。勾配消失問題とは、深い層ほど学習が進みにくくなる現象で、精度の低下を招く原因となります。飛び越え接続によって、勾配がショートカットされるため、深い層まで勾配がしっかりと伝わり、学習が効率的に行えるようになります。

さらに、飛び越え接続は、様々な変形が可能です。例えば、入力と出力をそのまま足し合わせる方法だけでなく、畳み込み処理を挟んだり、重み付けを行ったりするなど、様々な工夫が考えられます。これらの工夫によって、より効果的に情報を伝達し、性能の向上を図ることができます。このように、飛び越え接続は実装が容易であるだけでなく、高い柔軟性も備えているため、様々な場面で活用され、深層学習の発展に大きく貢献しています。

| メリット | 説明 | 具体例 |

|---|---|---|

| 単純で効果的 | 仕組みがシンプルで効果が高い | 既存の神経網構造に容易に組み込み可能 |

| 実装が容易 | 多くの深層学習ツールでサポートされている | 複雑な処理を記述する必要がない |

| 最適な構造の探索に役立つ | 様々な種類の網で試行錯誤しやすい | 画像認識で最適な構造を探索する際に強力な道具となる |

| 深い層の情報が浅い層に伝わる | 深い層で学習した特徴が薄まるのを防ぐ | 画像認識における畳み込み神経網で精度向上 |

| 勾配消失問題の軽減 | 深い層まで勾配が伝わりやすくなる | 学習の効率化 |

| 様々な変形が可能 | 入力と出力の足し合わせ以外も可能 | 畳み込み処理の追加や重み付けなど |