大規模言語モデルのスケーリング則

AIを知りたい

先生、「スケーリング則」って一体何ですか?難しそうでよくわからないです。

AIエンジニア

そうだね、一見難しそうに見えるけど、簡単に言うと「モデルの大きさやデータ量、計算量を増やすほど、AIの性能が向上する」という法則のことだよ。例えば、大きなAIモデルを、たくさんのデータで学習させ、より多くの計算を行うと、性能が良くなる傾向があるんだ。

AIを知りたい

なるほど。つまり、AIを賢くするには、大きくして、たくさん勉強させて、たくさん計算させればいいってことですか?

AIエンジニア

そうとも言えるね。もちろん、闇雲に大きくすれば良いというわけではなく、適切なバランスが大切だよ。でも、基本的には「規模を大きくすると性能が上がる」という関係があると考えていいよ。

スケーリング則とは。

人工知能の言葉で「規模の法則」というものがあります。(ちなみに、規模の法則という言葉は物理や生物の分野にもありますが、ここでは人工知能、特に言葉の処理における規模の法則について説明します。)

はじめに

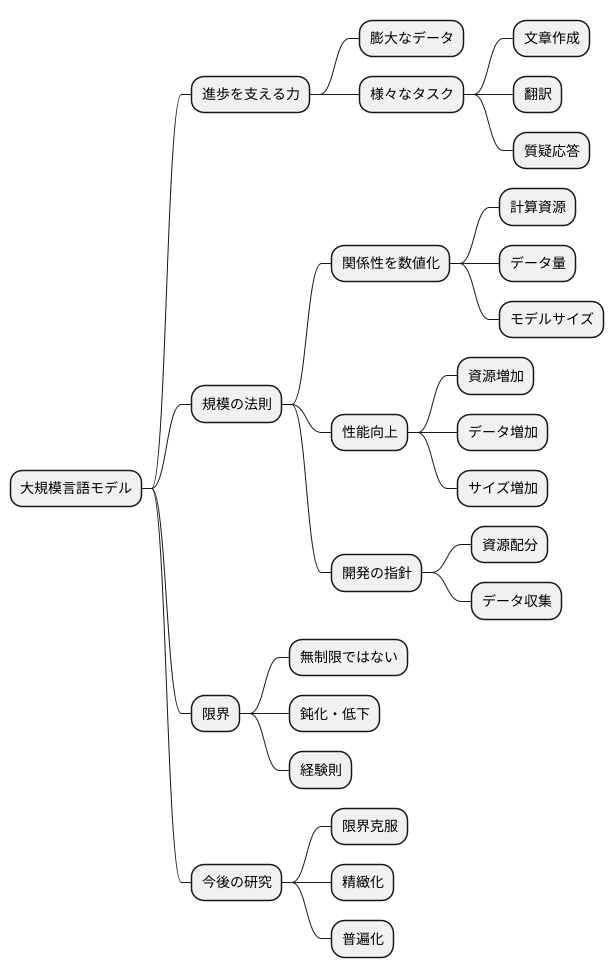

近頃は、人工知能、とりわけ言葉を扱う技術が、驚くほどの進歩を見せています。この進歩を支える大きな力の一つが、大規模言語モデルです。膨大な量のデータを使って鍛えられたこれらのモデルは、文章を作ったり、言葉を翻訳したり、質問に答えたりと、様々な仕事で目を見張るような成果を上げています。こうした大規模言語モデルの働きぶりを左右する重要な要素として、「規模の法則」が注目を集めています。「規模の法則」とは、モデルの性能が、計算に使う資源の量、学習に使うデータの量、そしてモデル自体の大きさといった要素と、どのように関係しているかを数値で示す法則です。

この法則によると、計算資源、データ量、モデルサイズを増やすほど、モデルの性能は向上する傾向にあります。つまり、より多くの計算資源を使って、より多くのデータをより大きなモデルで学習させれば、より精度の高い結果が得られる可能性が高くなります。これは直感的には理解しやすい考え方ですが、規模の法則は、この関係性をより具体的に、数値で示すことで、大規模言語モデルの開発に重要な指針を与えてくれます。例えば、ある程度の性能向上を目指す場合、どの程度計算資源を増やすべきか、どの程度のデータを追加で収集すべきか、といった具体的な目安を立てることができます。

規模の法則は、大規模言語モデルの開発において非常に重要な役割を果たしていますが、同時に限界も存在します。例えば、計算資源やデータ量を無制限に増やせば性能が上がり続けるとは限りません。ある一定の規模を超えると、性能向上の度合いが鈍化したり、場合によっては逆に性能が低下したりする可能性もあります。また、規模の法則はあくまで経験則であり、全ての状況で成り立つとは限りません。今後の研究では、これらの限界を克服し、より精緻で普遍的な法則を確立することが重要となります。そうすることで、大規模言語モデルの更なる発展、そして人工知能全体の進化に大きく貢献することが期待されます。

スケーリング則とは

計算機の性能向上やデータ量の増大に伴い、近年、機械学習モデルはますます巨大化しています。こうした巨大なモデルを扱う際に、「投入する資源に対して、モデルの性能はどのように変化するのか」を予測することは、開発の効率を上げる上で非常に重要です。これを体系的に示したものが「スケーリング則」です。

スケーリング則は、モデルの性能、例えば誤りの少なさや正答率といった指標が、計算資源、学習データの量、そしてモデルの大きさといった要素と、どのように関係しているかを数式で表したものです。これまで、これらの要素を増やすとモデルの性能が良くなることは、多くの実験を通して分かっていました。しかし、スケーリング則を用いることで、この関係をより精密に、そして数量的に把握することができるようになりました。

多くの場合、この関係は「べき乗則」と呼ばれる数式で近似できます。べき乗則は、ある変数を大きくすると、別の変数もそれに比例して大きくなる、という関係を表すものです。例えば、モデルの大きさを二倍にすると、性能も二倍ではなく、二倍の何乗か、という形で向上します。この乗数は、扱う問題やモデルの種類によって異なりますが、一般的には、モデルを大きくすればするほど、性能向上の度合いは緩やかになっていきます。

スケーリング則は、今後のモデル開発において、限られた計算資源やデータをどのように配分すれば、最も効果的に性能を向上させられるのかを判断する上で、重要な指針となります。また、将来、どれだけの資源を投入すれば、目標とする性能に到達できるのかを予測するのにも役立ちます。つまり、スケーリング則は、巨大なモデルを開発する際の羅針盤となる重要な法則と言えるでしょう。

| 要素 | 関係性 | 詳細 |

|---|---|---|

| 計算資源, 学習データ量, モデルサイズ | モデル性能との相関 | 要素増加に伴いモデル性能向上。べき乗則で近似可能。 |

| べき乗則 | 変数間の比例関係 | 一方の変数の増加に伴い、他方の変数も比例的に増加 (例: モデルサイズ2倍 -> 性能2倍のn乗)。nは問題/モデルの種類に依存。 |

| モデルサイズ増加 | 性能向上度合いの変化 | サイズ増加に伴い、性能向上は緩やかに。 |

| スケーリング則の活用 | 資源配分, 性能予測 | 効率的な資源配分による性能向上、目標性能達成に必要な資源予測。 |

計算資源、データ量、モデルサイズ

近年の技術革新により、人工知能は目覚ましい発展を遂げています。この発展を支える重要な柱の一つに、計算資源、データ量、そしてモデルサイズの増大があります。これらは人工知能、特に深層学習モデルの性能向上に深く関わっており、互いに密接に影響し合っています。

まず、計算資源とは、モデルの訓練に必要となる計算能力を指します。具体的には、使用する計算機の処理能力や数、そして計算に費やす時間などが挙げられます。高性能な計算機を多数用い、十分な時間を費やすことで、より複雑で大規模なモデルの訓練が可能となります。

次に、データ量は、モデル学習に用いるデータの量を指します。例えば、文章を扱うモデルの場合、学習に用いる文章の量や単語数がデータ量に該当します。一般的に、データ量が多いほど、モデルは様々なパターンを学習できるため、より高い性能を発揮できると考えられています。

最後に、モデルサイズは、モデルの複雑さを示す指標であり、モデル内部にある調整可能な要素の数(パラメータ数)で表されます。モデルサイズが大きいほど、モデルは複雑な表現を学習できますが、同時に過剰適合(学習データに特化しすぎてしまい、未知のデータに対応できない状態)のリスクも高まります。

これらの3つの要素は、バランスが重要です。モデルサイズを大きくすれば、より複雑な事象を捉えられる可能性が高まりますが、それに合わせてデータ量と計算資源も増やさなければ、効果は限定的です。十分なデータ量がないままモデルサイズだけを大きくすると、過剰適合を起こし、未知のデータに対する性能が低下する可能性があります。同様に、計算資源が不足すると、大規模なモデルの訓練に時間がかかりすぎたり、訓練自体が不可能になる場合もあります。したがって、高性能な人工知能モデルを開発するためには、これらの要素の最適なバランスを見極めることが不可欠です。

| 要素 | 説明 | 影響 | 注意点 |

|---|---|---|---|

| 計算資源 | モデル訓練に必要な計算能力(計算機の処理能力、数、計算時間など) | 複雑で大規模なモデルの訓練を可能にする | 不足すると、訓練時間が増加したり、訓練が不可能になる場合も |

| データ量 | モデル学習に用いるデータの量(例:文章の量、単語数) | データ量が多いほど、モデルは様々なパターンを学習し、高性能を発揮 | 不足すると、モデルが十分に学習できず、性能が低下する可能性も |

| モデルサイズ | モデルの複雑さを示す指標(パラメータ数) | 複雑な表現を学習できる | 大きすぎると、過剰適合のリスクが高まる |

スケーリング則の応用

大きさを変える法則は、作った模型の働き具合を想像するだけでなく、模型作りをもっとうまくやるのにも役立ちます。

例えば、使える計算機が少ない時、どのくらいの大きさの模型と、どのくらいの量の練習データを使えば一番良い働きが得られるかを、前もって想像できます。そうすれば、少ない計算機でも良い結果が得られます。また、これからどれくらい働きが良くなるかを想像することで、研究開発の目標を決めたり、人やお金などの資源の使い方を一番良くしたりできます。

大きさを変える法則は、模型がどのように学ぶかを理解するのにも役立ちます。模型は、練習データからどのように知識を得て、色々な場面で使える力をつけるのか。それを解き明かすヒントを、大きさを変える法則は持っているかもしれません。

さらに、計算機の資源を効率的に使うという点でも、この法則は役立ちます。模型の大きさとデータの量をうまく調整することで、無駄な計算を減らし、必要な計算だけを行うようにできます。

また、新しい模型を作る時にも、大きさを変える法則は力を発揮します。過去のデータから、どのくらいの大きさの模型を作れば、目標とする性能が得られるかを予測することができます。そうすれば、試行錯誤を減らし、効率的に開発を進めることができます。

このように、大きさを変える法則は、模型作りを様々な面から助けてくれる、大切な道具と言えるでしょう。

| 効果 | 説明 |

|---|---|

| 模型の働き具合の予測 | 模型の大きさやデータ量から、期待される性能を予測し、少ない計算資源でも効果的な開発を可能にする。 |

| 研究開発の効率化 | 性能向上予測に基づき、目標設定や資源配分を最適化し、研究開発を効率的に進める。 |

| 模型の学習理解 | 模型がデータから知識を獲得し、汎化能力を高める仕組みの解明に役立つ可能性がある。 |

| 計算資源の効率化 | 模型の大きさとデータ量を調整し、無駄な計算を削減し、必要な計算のみに資源を集中させる。 |

| 新規模型開発の効率化 | 過去のデータに基づいて適切な模型サイズを予測し、試行錯誤を減らし、開発を効率化。 |

今後の展望

今後の展望として、大規模言語モデルの開発において鍵となるスケーリング則の研究を深めていく必要があります。スケーリング則とは、モデルの大きさや学習データ量を増やすことで、モデルの性能が向上する割合を示す法則のことです。現状では、この法則は経験に基づいて導き出されたものであり、なぜそのような関係が成り立つのかという理論的な裏付けは十分ではありません。まるで、料理のレシピを手順通りに試してみたら美味しくできたけれど、なぜその分量で美味しくなるのか、科学的な根拠はわからない、というような状態です。

今後の研究では、このスケーリング則の謎を解き明かし、理論的な根拠を確立することが重要です。いわば、美味しい料理のレシピの背後にある科学的な原理を解明するようなものです。もし、この原理が分かれば、より効率的に、より高性能なモデルを開発するための指針が得られるはずです。また、現状のスケーリング則は、ある程度の範囲内でのみ有効である可能性も考えられます。例えば、モデルの規模やデータ量を今の10倍、100倍と増やしていったときにも、同じ法則が成り立つとは限りません。この限界についても、今後の研究で明らかにしていく必要があります。まるで、レシピの分量を単純に10倍にしても、同じように美味しくなるとは限らないのと同じです。

スケーリング則の研究がさらに進展すれば、より高性能で大規模な言語モデルの開発が可能になります。これは、様々な分野での革新につながる可能性を秘めています。例えば、より自然で人間らしい会話ができる対話システムや、高度な推論能力を持つ人工知能の開発などが期待されます。さらに、スケーリング則の研究は、人工知能がどのように学習し、知識を獲得していくのかという基本的な仕組みの解明にもつながる可能性があります。これは、人間の知能の理解にも役立つと考えられます。まるで、料理の科学的な原理を理解することで、人間の味覚の仕組みについてもより深く理解できるようになるのと同じです。

| 項目 | 説明 | 料理の例え |

|---|---|---|

| スケーリング則 | モデルの大きさや学習データ量を増やすことで、モデルの性能が向上する割合を示す法則。現状は経験則。 | 手順通りに試したら美味しくできたレシピ(なぜ美味しくなるかは不明) |

| 今後の研究の焦点 | スケーリング則の理論的根拠の確立、有効範囲の特定 | 美味しい料理のレシピの背後にある科学的な原理の解明、レシピの分量を単純に増やしても美味しくなるとは限らないことの検証 |

| 研究の進展による成果 | 高性能で大規模な言語モデルの開発、様々な分野での革新(例:自然な対話システム、高度な推論能力を持つAI)、人工知能の学習・知識獲得の仕組みの解明、人間の知能の理解 | 料理の科学的な原理の理解による人間の味覚の仕組みの理解 |

おわりに

この文章では、大規模言語モデルにおける規模の法則について説明しました。この法則は、モデルの性能向上を理解し予測する上で重要な道具となります。計算に使う資源、情報の量、そしてモデルの大きさの関係を数値で示すことで、より効率的なモデル開発を可能にします。これからの研究によって、この規模の法則への理解が深まることで、人工知能の進歩はさらに速まると期待されます。

大規模言語モデルの開発は、日ごとに新しい発見があり、急速に進んでいます。これからますます高度な機能が実現するでしょう。規模の法則は、この進化を支える重要な基礎技術として、さらに注目を集めることは間違いありません。より性能の高いモデルを作ることで、様々な社会問題の解決や新しい価値の創造に役立つことが期待されます。

例えば、医療の分野では、病気の診断や治療法の開発に役立つ可能性があります。また、教育の分野では、生徒一人ひとりに合わせた学習支援を行うことが可能になります。さらに、企業の業務効率化や新製品開発など、様々な分野での応用が期待されています。規模の法則を理解し、より効率的にモデルを開発することで、人工知能は私たちの生活をより豊かにする力となるでしょう。今後の研究の進展によって、さらに革新的な技術が生まれることを期待し、この文章を締めくくりたいと思います。

| テーマ | 内容 |

|---|---|

| 規模の法則 | モデルの性能向上を理解し予測する重要な道具。計算資源、情報量、モデルの大きさの関係を数値化し、効率的なモデル開発を可能にする。 |

| 大規模言語モデルの将来 | 日進月歩で進化し、高度な機能実現が期待される。規模の法則は進化を支える重要な基礎技術。 |

| 応用分野 | 医療(診断、治療法開発)、教育(個別学習支援)、企業(業務効率化、新製品開発)など様々な分野での活用が期待される。 |

| 規模の法則の意義 | より性能の高いモデル作成を可能にし、社会問題解決や新たな価値創造に貢献する。AIは生活を豊かにする力となる。 |

| 今後の展望 | 研究の進展により、革新的な技術の誕生が期待される。 |