RNN:時系列データの理解

AIを知りたい

先生、「RNN」って、普通のニューラルネットワークと何が違うんですか?難しそうでよくわからないです。

AIエンジニア

良い質問だね。普通のニューラルネットワークは、入力された情報を個別に処理するのに対して、RNNは前の情報も覚えているところが違うんだ。だから、連続した情報、例えば言葉の並びのようなものを理解するのが得意なんだよ。

AIを知りたい

前の情報も覚えている?どういうことですか?

AIエンジニア

RNNには、ループ構造があるから、前の情報を次の処理に使えるように取っておけるんだ。だから、まるで人間が言葉を理解するように、前の言葉の流れを踏まえて、次に来る言葉を予測できるんだよ。例えば「お早うご」の次は「ざいます」と予測できるのと同じようにね。

RNNとは。

人工知能で使われる「再帰型ニューラルネットワーク」、略して「RNN」について説明します。RNNは、時間とともに変化するデータや連続したデータを理解するために作られたネットワークです。データの一つ一つが、その前後のデータの影響を受けてどのように変化するかを計算し、次の結果を予測します。RNNは、特に人の言葉を扱う分野でよく使われています。

従来のニューラルネットワークは、入力されたデータがそれぞれ独立していると考えていました。これは、例えば画像を扱う場合は問題ありませんが、言葉のようにデータが連続して意味を持つ場合はうまくいきません。RNNは、この問題を解決するために、過去の入力を覚えておくためのループをネットワークの中に組み込んでいます。

この仕組みのおかげで、RNNは言葉のような時間とともに変化するデータを扱うことができるようになりました。そして、機械翻訳、文章の作成、音声認識など、様々な用途で使われています。RNNの構造は、従来のニューラルネットワークやCNNとほとんど同じですが、過去の情報を記憶するループを持っている点が違います。これは人間の脳の働きに似ていて、特に会話の中では、新しい情報ほど重要視されるのと同じように、RNNも新しいデータに大きな重みをつけて計算を行います。

再帰型ニューラルネットワークとは

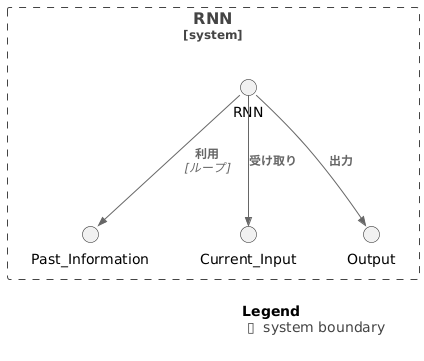

再帰型ニューラルネットワーク(RNN)は、人工知能の分野で広く使われている、特殊な構造を持ったニューラルネットワークです。通常のニューラルネットワークは、入力を受け取って出力する単純な構造をしていますが、RNNは過去の情報も利用することで、より複雑な処理を可能にしています。

通常のニューラルネットワークでは、それぞれの入力は独立して処理されます。しかし、RNNでは、前の時刻の入力の情報が現在の時刻の入力の処理に影響を与えます。これは、まるで人間の脳が過去の経験を記憶して、現在の状況判断に役立てているかのようです。この仕組みにより、RNNは時間的な繋がりを持つデータ、つまり時系列データの解析に非常に優れています。

例えば、音声認識を考えてみましょう。音声は、時間とともに変化する音の連続です。「あ」という音の後に「い」という音が続くことで、「あい」という言葉が認識されます。RNNは、「あ」という音の情報を受け取った後もその情報を保持し、「い」という音が入力された際に、保持していた「あ」の情報と組み合わせて処理を行うため、「あい」を正しく認識できるのです。

同様に、文章の解析でもRNNは力を発揮します。「私はご飯を食べる」という文章において、「食べる」という動詞の主語は「私」です。RNNは、「私」という単語の情報を受け取った後もそれを記憶しておき、「食べる」という単語が現れた時に、記憶していた情報と組み合わせて、「私」が「食べる」という行為を行うと正しく理解します。

このように、RNNは過去の情報を記憶し、現在の入力と組み合わせて処理することで、時系列データに潜む複雑な関係性を捉えることができます。そのため、音声認識、機械翻訳、文章生成など、様々な分野で応用されています。近年では、さらに進化したRNNとして、LSTMやGRUといった技術が登場し、より長期の記憶を保持できるようになり、精度の向上が実現しています。

従来のニューラルネットワークとの違い

従来のニューラルネットワークとRNNの最も大きな違いは、時間的関係性の理解にあります。従来のニューラルネットワークは、入力された情報を個別に処理し、それぞれの情報が互いに独立していることを前提としています。例えば、画像認識であれば、一つ一つの画素は他の画素とは無関係に処理され、全体像はその集合体として認識されます。

しかし、現実世界の多くのデータは時間的な繋がりを持っています。例えば、会話の内容は発言の順序によって意味が大きく変わり、天気も昨日の気温が今日の気温に影響を与えます。このような時系列データを扱う場合、従来のニューラルネットワークでは情報の時間的な繋がりを捉えることが難しく、正確な予測や分析ができません。

一方、RNNは再帰的な構造を持つことでこの問題を解決します。RNNは過去の情報を内部状態として保持し、現在の入力情報と合わせて処理を行います。つまり、過去の情報が現在の出力に影響を与えるため、時間的な文脈を理解することができます。これは、まるで人間が過去の経験を元に現在の状況を判断するのと似ています。

具体的に文章を例に挙げると、従来のニューラルネットワークでは「青い」「空」という単語が並んでいても、それぞれの単語の意味しか理解できません。しかし、RNNは「青い」という単語の後に「空」という単語が来たという順序情報も利用することで、「青い空」という全体の意味を理解できます。このように、RNNは時間的な繋がりを考慮することで、従来のニューラルネットワークでは困難であった時系列データの処理を可能にし、より高度な認識や予測を実現しています。

| 項目 | 従来のニューラルネットワーク | RNN |

|---|---|---|

| 時間的関係性の理解 | × | 〇 |

| 入力情報の処理 | 個別に処理、情報同士は独立 | 過去の情報と現在の入力を合わせて処理 |

| 時系列データの処理 | 困難 | 可能 |

| 例 | 「青い」「空」を別々に認識 | 「青い空」として認識 |

RNNの仕組み

再帰型ニューラルネットワーク(RNN)は、時間的な繋がりを持つデータ、例えば音声や文章といった時系列データの処理に優れた能力を発揮します。この能力の秘密は、その名の通り「再帰的」な構造、つまり過去の情報を記憶し、現在の処理に役立てる仕組みを持つことにあります。

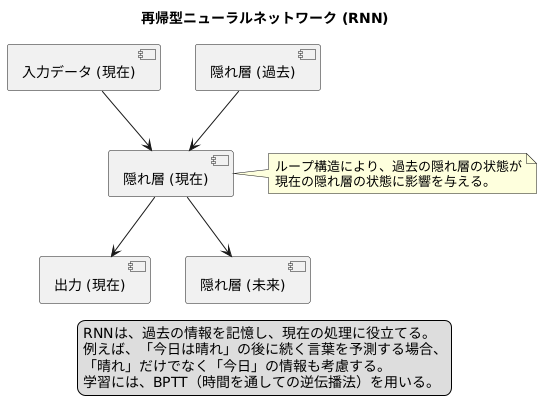

RNNの中核を担うのは、隠れ層と呼ばれる層です。この隠れ層には、ループ構造が組み込まれており、過去の隠れ層の状態が現在の隠れ層の状態に影響を与えます。具体的な動作を見てみましょう。RNNは、まず現在の入力データを受け取ります。それと同時に、一つ前の時点の隠れ層の状態も受け取ります。これら二つを組み合わせ、新しい隠れ層の状態と出力を生成します。この処理は、時系列データの各時点に対して、まるで鎖のように次々と繋がれていきます。

過去の情報が現在の処理に影響を与えるこの仕組みにより、RNNは過去の文脈を理解しながら文章を読み進めたり、過去の音の繋がりから次の音を予測したりすることが可能になります。例えば、「今日は晴れ」の後に続く言葉を予測する場合、「晴れ」だけでなく、「今日」という情報も考慮することで、「です」や「なので」といった、より自然な言葉を予測できるようになります。

RNNの学習には、誤差逆伝播法を時間方向に拡張したBPTT(時間を通しての逆伝播法)と呼ばれる手法が用いられます。BPTTは、出力と正解データの差、つまり誤差を計算し、その誤差に基づいてネットワークの繋がり方を調整します。この調整は、時間的な繋がりを考慮しながら行われるため、RNNは時系列データ特有の複雑なパターンを学習することができるのです。このように、RNNは過去の情報を巧みに利用することで、時系列データの解析において力を発揮します。

RNNの応用例

繰り返し使えるニューラルネットワーク(RNN)は、データの繋がりを把握する能力に長けており、様々な分野で活用されています。特に、時間とともに変化するデータ、いわゆる時系列データの解析に力を発揮します。

代表的な応用例として、まずは言葉に関する分野が挙げられます。例えば、異なる言語の間で言葉を置き換える機械翻訳では、RNNは前後の文脈を理解することで、より自然で正確な翻訳を可能にします。また、文章を自動的に作る文章生成や、文章に込められた気持ちを読み取る感情分析でもRNNは活躍しています。これらの技術は、私たちのコミュニケーションをより豊かに、そして便利にする可能性を秘めています。

次に、音声に関する分野での応用です。人間の声を文字データに変換する音声認識は、RNNによって高精度化が進んでいます。RNNは音声データの時間的な変化を捉えることができるため、発音の繋がりやイントネーションを考慮した認識が可能になるのです。これにより、音声入力による機器操作や、音声データの文字起こしなどがよりスムーズに行えるようになります。

さらに、RNNは未来予測にも役立ちます。過去のデータに基づいて未来の値を予測する時系列予測は、経済から気象、交通まで様々な分野で利用されています。例えば、株価の変動予測、天気予報、交通量の予測など、RNNは私たちの生活に密接に関わる様々な予測を支援しています。過去のデータの傾向を学習することで、将来の出来事を予測し、適切な対応策を立てるのに役立つのです。

このように、RNNは時系列データという、時間とともに変化するデータの解析に非常に優れており、様々な分野で応用されています。今後の技術発展により、RNNの活躍の場はさらに広がっていくと考えられます。

| 分野 | 応用例 | RNNの役割 |

|---|---|---|

| 言葉 | 機械翻訳 | 文脈理解による自然で正確な翻訳 |

| 言葉 | 文章生成 | 自動的な文章作成 |

| 言葉 | 感情分析 | 文章に込められた感情の読み取り |

| 音声 | 音声認識 | 音声データの時間変化の把握、発音やイントネーションの考慮 |

| 予測 | 時系列予測 | 株価、天気、交通量などの予測 |

RNNの課題

再帰型ニューラルネットワーク(RNN)は、時系列データの解析に優れた能力を示し、様々な分野で活用されています。しかし、RNNは万能ではなく、いくつかの課題も抱えています。

まず、勾配消失問題について説明します。これは、長い時系列データを学習する際に、誤差逆伝播法によって計算される勾配が、時間の経過とともに指数関数的に小さくなってしまう現象です。勾配が小さすぎると、ネットワークの重みの更新がほとんど行われなくなり、学習が停滞してしまいます。過去の情報が現在の出力に影響を与える必要があるにも関わらず、勾配消失によって長期的な依存関係を学習することが困難になります。例えば、文章の冒頭部分にある単語が、文章の後半部分の意味理解に重要な役割を果たす場合がありますが、勾配消失はこのような関係性を捉えることを難しくします。

次に、計算コストの高さについて説明します。RNNは、時系列データの各時点に対して逐次的に処理を行うため、データの長さに比例して計算時間が増加します。そのため、非常に長い時系列データを扱う場合、計算時間が膨大になり、実用上の問題となることがあります。特に、近年の深層学習モデルでは、大量のデータを用いて学習を行うことが一般的であるため、RNNの計算コストは大きなボトルネックとなります。

これらの課題を克服するために、様々な改良型のRNNが提案されています。長・短期記憶(LSTM)やゲート付き回帰型ユニット(GRU)などは、ゲートと呼ばれる機構を導入することで、勾配消失問題を軽減し、長期的な依存関係を学習することを可能にしています。これらの改良型RNNは、従来のRNNよりも高い性能を発揮することが多く、自然言語処理や音声認識など、様々な分野で広く利用されています。RNNの研究開発は現在も活発に行われており、更なる性能向上や新たな応用が期待されています。

| 課題 | 説明 | 例 | 解決策 |

|---|---|---|---|

| 勾配消失問題 | 長い時系列データを学習する際に、誤差逆伝播法によって計算される勾配が時間の経過とともに指数関数的に小さくなってしまう現象。過去の情報が現在の出力に影響を与える必要があるにも関わらず、勾配消失によって長期的な依存関係を学習することが困難になる。 | 文章の冒頭部分にある単語が、文章の後半部分の意味理解に重要な役割を果たす場合。 | LSTMやGRUなどのゲート機構を持つ改良型RNN |

| 計算コストの高さ | RNNは、時系列データの各時点に対して逐次的に処理を行うため、データの長さに比例して計算時間が増加する。特に、近年の深層学習モデルでは、大量のデータを用いて学習を行うことが一般的であるため、RNNの計算コストは大きなボトルネックとなる。 | 非常に長い時系列データを扱う場合、計算時間が膨大になる。 | (解決策は明示的に記載されていない) |