モデル縮小:小さくても賢いAI

AIを知りたい

先生、「モデル圧縮」って、どういう意味ですか?難しそうでよくわからないです。

AIエンジニア

そうだね、少し難しいね。簡単に言うと、賢いコンピュータを作るための設計図を、小さく軽くする技術のことだよ。設計図が大きくて複雑だと、作るのも使うのも大変だからね。

AIを知りたい

設計図を小さく軽くする、ですか? でも、小さくしたら賢くなくなってしまうんじゃないですか?

AIエンジニア

いい質問だね!小さく軽くしても、できるだけ賢さはそのままに保つ工夫をするんだよ。例えば、いらない部分を削ったり、簡略化したりするんだ。そうすることで、小さく軽くても賢いコンピュータを作ることができるんだよ。

モデル圧縮とは。

人工知能の用語で「模型の圧縮」というものがあります。模型の圧縮とは、模型の正確さを落とさずに、データの大きさを小さくする方法のことです。深い学習では、模型の正確さを上げるためには層を増やすなどしますが、そうすると計算の量が増えて、お金も時間もたくさんかかってしまいます。そこで、機械学習では模型の圧縮が必要になります。代表的な方法として「蒸留」「刈り込み」「量子化」の3つがあります。

モデル縮小とは

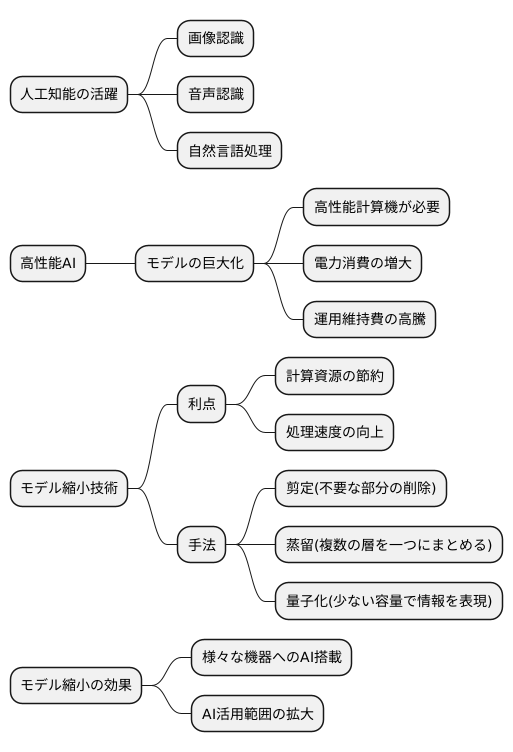

近年の技術革新により、様々な場面で人工知能が活躍しています。画像認識、音声認識、自然言語処理など、多くの分野で人工知能は目覚ましい成果を上げています。こうした人工知能の性能向上を支えているのが、大規模なモデルです。

しかし、より高性能な人工知能を実現しようとすると、モデルは必然的に複雑かつ巨大化します。この巨大化は、高性能な計算機を必要とし、多くの電力を消費します。結果として、運用維持費の高騰という深刻な問題を引き起こします。限られた資源で人工知能を運用しなければならない状況では、大きな制約となります。

この問題を解決する有効な手段として、「モデル縮小」という技術が注目を集めています。モデル縮小とは、人工知能の精度を保ちつつ、その規模を小さくする技術です。モデルの規模を小さくすることで、計算に必要な資源を節約し、処理速度を高めることができます。

モデル縮小には様々な方法があります。例えば、不要な部分を削除する剪定という手法や、複数の層を一つにまとめる蒸留という手法、少ない容量で情報を表現する量子化という手法などが挙げられます。これらの手法を組み合わせることで、モデルの規模を大幅に縮小しつつ、性能低下を最小限に抑えることが可能になります。

モデル縮小技術によって、限られた計算資源でも高性能な人工知能を動かすことが可能になります。これは、スマートフォンや家電製品など、様々な機器への人工知能搭載を後押しする重要な技術となります。今後、ますます普及が進むと考えられる、人工知能の活用範囲拡大に大きく貢献する技術と言えるでしょう。

代表的な3つの手法

ここでは、模型を小さくする代表的な三つの方法、つまり「蒸留」「枝切り」「量子化」について詳しく説明します。「蒸留」とは、例えるなら、熟練した職人の技を弟子に伝えるような方法です。大きな、そして優れた性能を持つ模型(教師模型)が持つ知識を、もっと小さな模型(弟子模型)に受け継がせます。教師模型が出した結果を真似するように弟子模型を訓練することで、精度の高い小さな模型を作ることができます。まるで、熟練の職人の動きを真似て、弟子が技術を習得していくように、小さな模型は大きな模型の知識を受け継ぎ、成長していくのです。

次に「枝切り」は、木を剪定するように、模型の中にある不要な繋がりを切る方法です。模型の中には、たくさんの繋がりが存在しますが、その中には重要度の低いものも含まれます。これらの不要な繋がりを削除することで、計算に必要な手間を減らし、模型の大きさを小さくします。木を剪定して不要な枝を落とすことで、木全体がスッキリするように、模型も無駄な部分を削ぎ落とすことで、より効率的に動作するようになります。

最後に「量子化」は、模型の情報を表現するのに使う数値の精度を落とす方法です。模型の情報は、数値で表現されていますが、これらの数値をより少ない桁数で表現することで、記憶に使う場所を減らし、計算の速度を上げます。例えば、細かい目盛りの定規から、少し大雑把な目盛りの定規に変えるようなものです。細かい精度が必要ない場合は、大雑把な定規でも十分に用が足ります。これと同じように、模型の情報も、必要な精度に合わせて表現することで、効率を上げることができます。

これらの方法は、それぞれ単独で使うこともできますし、組み合わせて使うこともできます。目的に合わせて最適な方法を選ぶことで、より効果的に模型を小さくすることができます。

| 方法 | 説明 | 例え |

|---|---|---|

| 蒸留 | 大きな模型(教師模型)の知識を小さな模型(弟子模型)に継承させることで、精度の高い小さな模型を作る。 | 熟練した職人が弟子に技を伝える |

| 枝切り | 模型の中の重要度の低い繋がりを削除し、計算の負担を減らして模型を小さくする。 | 木の剪定 |

| 量子化 | 模型の情報の数値精度を落とし、記憶容量と計算速度を向上させる。 | 細かい目盛りの定規から大雑把な目盛りの定規に変える |

蒸留

蒸留とは、まるで熟練した職人が長年培ってきた技を弟子に伝えるように、巨大な規模を持つ人工知能モデルが持つ知識を、より小さな規模の人工知能モデルに受け継がせる技術です。

巨大な人工知能モデルは、膨大な量のデータと莫大な計算資源を費やして学習させることで、高い精度を達成します。しかし、その高い性能の裏には、大きな計算コストがかかるという問題も抱えています。この問題を解決するために、巨大なモデルを教師役として、小さなモデルに効率よく知識を伝える方法が蒸留です。小さなモデルは生徒役として、教師役の巨大なモデルから知識を学び取ります。

具体的には、教師役のモデルが、ある入力に対してどのように反応するか、つまりどのような確率でそれぞれの答えを選ぶかを表す確率分布を、生徒役のモデルが模倣するように学習させます。例えば、画像に写っているものが「猫」である確率を教師モデルが80%、「犬」である確率を15%、「その他」である確率を5%と予測した場合、生徒モデルもなるべく同じような確率分布を出力するように学習します。

このようにして学習することで、生徒役のモデルは教師役のモデルに匹敵する精度を、より少ない計算量で実現できるようになります。これは、教師役のモデルが学習したデータの特徴や、データの中にある様々な要素間の関係性などを、効率よく生徒役のモデルに伝えることができるからです。

結果として、蒸留によって、限られた計算資源でも高性能な人工知能モデルを利用できるようになり、様々な機器への組み込みや、より多くの人が人工知能の恩恵を受けられるようになることが期待されています。

枝切り

枝切りとは、木の手入れと同じように、不要な枝を切ることで、仕組全体をより良くする手法です。この場合の仕組とは、様々な情報処理に使われる「モデル」のことを指します。モデルは、たくさんの繋ぎ目(「接続」と呼びます)でできています。それぞれの繋ぎ目は情報のやり取りを行う役割を持ち、全体として複雑な計算を行っています。しかし、これらの繋ぎ目の全てが重要なわけではありません。中には、計算結果にほとんど影響を与えない繋ぎ目も存在します。

枝切りでは、これらの重要度の低い繋ぎ目を特定し、取り除きます。まるで庭師が木をよく観察し、不要な枝を見極めて剪定するように、不要な繋ぎ目を注意深く選び出す必要があります。繋ぎ目の重要度は、その繋ぎ目が持つ値の大きさや、情報の流れへの影響度合いなどから判断します。具体的には「重み」や「勾配情報」といった数値を参考にします。

繋ぎ目を減らすことで、モデルの大きさを小さくすることができます。これは、処理に必要な記憶領域を減らし、計算速度を上げる効果があります。また、不要な繋ぎ目がなくなることで、モデルの構造が分かりやすくなり、処理内容の理解がしやすくなるという利点もあります。

ただし、繋ぎ目を切り落とす際には注意が必要です。重要な繋ぎ目を誤って削除してしまうと、モデルの性能が低下する可能性があります。これは、木にとって必要な枝を切ってしまい、木の成長に悪影響を与えるのと同じです。そのため、繋ぎ目を削除した後は、モデルの性能を改めて確認する必要があります。もし性能が下がっている場合は、再度学習を行い、性能を回復させる作業を行います。これは、剪定後の木に肥料を与え、成長を促すようなものです。このように、枝切りは、モデルの性能を維持しながら、効率を高めるための重要な技術と言えるでしょう。

量子化

模型を小さく軽くする技術、量子化について説明します。模型を作るには、たくさんの数値を使います。これらの数値は、普通は32個の小さな点で表現されます。この小さな点をたくさん使うことで、滑らかで正確な模型を作ることができます。しかし、これらの点は模型を大きく重くしてしまいます。そこで、量子化の出番です。量子化は、これらの点をもっと少なくして、模型を小さく軽くする技術です。

たとえば、32個の点の代わりに、8個の点を使うとどうなるでしょうか。模型の大きさは4分の1になり、使う記憶場所も4分の1になります。また、計算も速くなります。これは、大きな絵を小さな絵にするようなものです。小さな絵は場所を取らず、見るのも楽です。

しかし、点を少なくすると、細かい部分が失われてしまう可能性があります。32個の点で描いた滑らかな曲線が、8個の点ではガタガタになってしまうかもしれません。これは、色の種類をたくさん使った絵と、少しの色で描いた絵の違いのようなものです。色の種類が少ないと、微妙な色の違いが表現できません。

量子化では、この点の数を減らすことで、模型の大きさと計算速度を改善します。もちろん、点の数を減らしすぎると、模型の質が落ちてしまいます。そこで、どの程度点を減らせば、模型の質をあまり落とさずに済むのかを carefullyに見極める必要があります。多くの場合、少し点を減らしただけでも、模型の大きさと計算速度は大きく改善されます。これは、絵を描く際に、使う色の種類を少し減らしても、絵の印象があまり変わらないのと同じです。

このように、量子化は、必要な情報だけを残して、無駄な情報を削ることで、模型を効率的に小さく軽くする技術です。少しの情報で多くのことを表現する、知恵と工夫が詰まった技術と言えるでしょう。

今後の展望

人工知能技術の広がりを考える上で、計算量の少ない小さなモデルを作る技術は欠かせないものとなっています。今後、より高性能な人工知能モデルが作られるにつれて、この小さなモデルを作る技術は更に重要になっていくでしょう。特に、持ち運びできる機器や携帯電話といった計算能力の低い環境で人工知能を使うためには、この技術がどうしても必要です。これから、より精巧な小型化技術や、様々な人工知能モデルへの応用といった、更なる技術の進歩が望まれます。

小さなモデルを作る技術が発展していくことで、限られた計算資源でも高度な人工知能を動かすことが可能になります。例えば、画像認識や音声認識といった機能を、消費電力の少ない機器で実現できるようになるでしょう。これにより、電池の持ちが長持ちする携帯電話や、より賢い家電製品の開発につながります。また、インターネットに繋がりにくい場所でも人工知能を活用したサービスを提供できるようになるため、様々な場面での利便性向上に貢献します。

さらに、誰でも簡単に小さなモデルを作れるような道具や仕組みの開発も進んでいます。専門家でなくても手軽に使えるようになれば、多くの人が人工知能技術に触れる機会が増え、新たな発想やサービスが生まれることが期待されます。このような技術革新は、人工知能の普及を後押しし、社会全体の発展を加速させる力となるでしょう。人工知能技術が身近なものになり、私たちの生活をより豊かにしていく未来は、そう遠くないはずです。

| 小さなモデルを作る技術の重要性 | メリット | 今後の展望 |

|---|---|---|

| 高性能AIモデル開発に伴い重要性が増す 計算能力の低い環境でのAI利用に不可欠 |

限られた計算資源での高度なAI利用 消費電力の少ない機器でのAI機能実現 電池持ちの良い携帯電話、賢い家電の開発 オフライン環境でのAIサービス提供 |

小型化技術や様々なAIモデルへの応用 誰でも簡単にモデルを作れる道具/仕組み開発 AI普及促進、社会全体の発展 |