LeNet:手書き文字認識の先駆け

AIを知りたい

先生、「LeNet」って初めて聞きました。どんなものなんですか?

AIエンジニア

LeNetは、手書きの数字を認識するための、初期の画像認識AIの一つだよ。1998年にAT&T Labsで開発されたんだ。簡単に言うと、たくさんの数字の画像を学習することで、新しい手書きの数字を見せても、それがどの数字かを高い精度で判別できるようになるんだよ。99.3%の精度で判別できるんだ。

AIを知りたい

すごいですね!どうやって数字を判別しているんですか?

AIエンジニア

それは畳み込み層とプーリング層という仕組みを使って画像の特徴を捉え、最後に全結合層で判断しているんだ。今使われている画像認識AIと違う点は、活性化関数にシグモイド関数を使っているところと、データの縮小にサブサンプリングを使っているところだね。今はReLU関数やMaxプーリングが主流だよ。

LeNetとは。

「人工知能に関係する言葉、『LeNet』について説明します。LeNetは1998年にアメリカの電話会社AT&Tの研究所で作られた、畳み込みニューラルネットワークと呼ばれる技術のひな形です。LeNetは手書きの文字を99.3%の正しさで見分けることができます。仕組みとしては、画像の特徴を抜き出す畳み込み層と、情報を絞り込むプーリング層を何回か繰り返した後、最後に全ての情報をまとめて結果を出す層で答えを出します。今の畳み込みニューラルネットワークと大きく違う点は、情報の活性化に使われる関数です。LeNetではシグモイド関数というものが使われていますが、今はReLU関数というものが使われています。また、LeNetではデータを小さくするために一部のデータだけを抜き出す方法を使っていますが、今はMaxプーリングと呼ばれる、一番大きな値だけを残す方法が使われています。」

LeNetの起源

一九九八年、エーティーアンドティー研究所のヤン・ルカン氏を中心とした研究陣が、畳み込みニューラルネットワークという、新しい仕組みを持つ計算模型を開発しました。これは後に、レネットと呼ばれるようになります。当時、手書きの文字を機械で読み取る技術は、郵便番号の自動仕分けなど、様々な分野で必要とされていましたが、なかなか精度が上がらず、困っていました。既存の方法では、なかなか良い成果が出なかったのです。レネットの登場は、この状況を一変させる画期的な出来事でした。

レネットは、手書きの数字の画像を高い精度で読み取ることができました。これは、まるで人間が目で見て判断するかのようで、当時の技術水準をはるかに超えるものでした。レネットという名前は、開発者の一人であるヤン・ルカン氏にちなんで付けられました。

レネットの成功は、深層学習という、人間の脳の仕組みを模倣した学習方法の可能性を示す重要な出来事でした。そして、画像認識技術の分野に、全く新しい時代を切り開いたのです。

レネット以前は、コンピュータに文字を認識させるのは非常に難しい作業でした。しかし、レネットは画像を小さな領域に分割し、それぞれの領域の特徴を捉えることで、全体像を把握する手法を用いました。これは、人間がものを見るときに、無意識に行っていることに似ています。例えば、私たちは「3」という数字を見るとき、全体の形だけでなく、曲線や線の組み合わせなど、細かい特徴を捉えて判断しています。レネットも同様に、画像の細部を読み取ることで、高い精度を実現したのです。

今日では、様々な画像認識技術が発展し、私たちの生活を豊かにしています。自動運転技術や顔認証システムなど、多くの技術がレネットの登場によって築かれた土台の上に成り立っていると言えるでしょう。手書き文字認識の先駆けとなったレネットの功績は、今も高く評価されています。

| 項目 | 内容 |

|---|---|

| 開発年 | 1998年 |

| 開発者 | ヤン・ルカン氏を中心としたAT&T研究所の研究陣 |

| 名称 | レネット(LeNet) |

| 目的 | 手書き文字の機械読み取り(精度向上) |

| 成果 | 手書き数字画像の高精度読み取り |

| 革新性 | 人間のような文字認識、深層学習の可能性を示唆、画像認識技術の新時代を開拓 |

| 仕組み | 画像を小領域に分割、各領域の特徴を捉え全体像を把握(人間の視覚認識に近い) |

| 影響 | 現代の様々な画像認識技術(自動運転、顔認証など)の土台 |

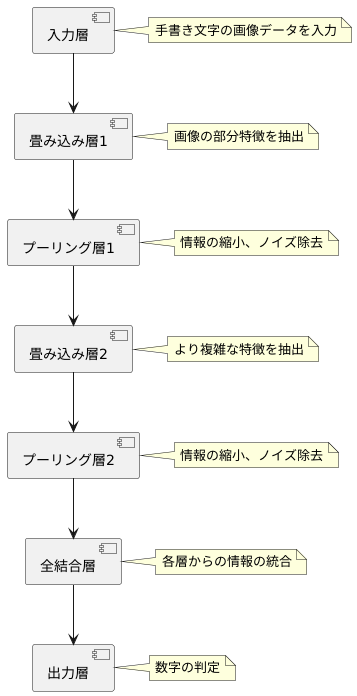

LeNetの構造

手書き文字認識の先駆けとして知られる「LeNet」は、幾つかの層を積み重ねた構造を持っています。まるで建物を建てるように、各層がそれぞれの役割を果たし、全体として文字を認識する仕組みです。

まず、一番下の層を入力層と呼び、ここに手書き文字の画像データを入れます。LeNetは、この画像データから数字の特徴を段階的に読み解いていきます。そのために畳み込み層とプーリング層という二つの層を交互に積み重ねて使います。

畳み込み層は、小さな窓(フィルター)を画像の上で少しずつずらしていくことで、一部分の特徴を捉えます。このフィルターは、文字の輪郭や線の太さなど、細かい部分に注目して、重要な情報を取り出します。

次にプーリング層は、畳み込み層で得られた情報を縮小します。これにより、無駄な情報を取り除き、計算の負担を軽くします。また、多少画像が歪んでいても、同じ文字として認識できるようにする効果もあります。

畳み込み層とプーリング層を何回か繰り返すことで、文字のより複雑な特徴を捉えます。そして最後に、全結合層の出力を統合し、出力層でどの数字かを判断します。

このように、LeNetは複数の層を組み合わせ、複雑な手書き文字のパターンを学習し、高い精度で認識します。これは当時としては画期的な構造であり、後の画像認識技術に大きな影響を与えました。

LeNetの精度

手書きの数字をコンピュータに認識させる技術は、かつては非常に難しい課題でした。しかし、画期的な手法であるLeNetの登場により、状況は大きく変わりました。LeNetは、手書き数字の画像を集めた、エムニストと呼ばれるデータセットを使って学習と評価を行いました。その結果、99.3%という驚くべき認識精度を達成したのです。これは、当時の他の方法と比べてはるかに高い数値であり、LeNetの有効性をはっきりと示しました。

この高い精度は、手書き文字認識の実用化を大きく前進させました。例えば、金融機関における小切手の処理や、郵便物の自動仕分けといった作業に利用され、社会に大きな影響を与えました。従来、これらの作業は人手で行われていましたが、LeNetの技術によって自動化が可能になり、作業効率の向上とコスト削減に大きく貢献しました。

LeNetの優れた点は、畳み込みニューラルネットワークという仕組みを用いていることです。これは、画像の特徴を効率的に捉えることができる革新的な方法でした。LeNetはこの仕組みを初めて本格的に活用したモデルの一つであり、その成功は、後の画像認識技術の発展に大きな影響を与えました。現在でも、LeNetは畳み込みニューラルネットワークの基礎モデルとして、教育や研究の場で広く使われており、多くの技術者や研究者に学習されています。その先駆的な技術は、今もなお、私たちの生活を支える様々な技術の礎となっています。

| 項目 | 内容 |

|---|---|

| 課題 | コンピュータによる手書き数字認識の難しさ |

| 解決策 | LeNetの登場 |

| データセット | エムニスト(手書き数字画像) |

| 認識精度 | 99.3% |

| 成果 | 小切手処理、郵便物自動仕分けなどの自動化による効率向上とコスト削減 |

| 技術的特徴 | 畳み込みニューラルネットワークの活用 |

| 影響 | 画像認識技術の発展に貢献、現在でも基礎モデルとして教育・研究で使用 |

活性化関数

画像認識の分野で重要な役割を果たす畳み込みニューラルネットワーク(CNN)には、活性化関数というものが欠かせません。活性化関数は、入力された値を特定の規則に従って変換する関数で、これによりネットワークは複雑な情報を学習することができます。初期のCNNであるLeNetでは、活性化関数としてシグモイド関数が採用されていました。

シグモイド関数は、入力値を0から1の範囲の値に変換する関数です。この関数は滑らかな曲線を描くため、微分が可能であり、学習の過程で重要な勾配計算に利用できます。また、0から1への変換は、確率のような表現にも適しており、出力値をある事象の発生確率として解釈することも可能です。しかし、シグモイド関数には勾配消失問題という欠点があります。これは、ネットワークの層が深くなるにつれて、学習に必要な勾配の値が非常に小さくなってしまい、学習の効率が著しく低下する現象です。

現在のCNNでは、この勾配消失問題を克服するために、ReLU関数が活性化関数として広く使われています。ReLU関数は、入力値が0以下の場合は0を出力し、0より大きい場合はそのまま入力値を出力する、非常に単純な関数です。この単純さ故に計算コストが低く、シグモイド関数に比べて学習速度が速いという利点があります。また、勾配消失問題も起こりにくいという特性も持っています。

LeNetが開発された当時は、ReLU関数はまだ知られておらず、シグモイド関数が主流でした。勾配消失問題という欠点がありながらも、LeNetは当時としては高い認識精度を達成しており、その設計の優秀さを示しています。現代のCNNは活性化関数としてReLU関数を採用することで、更なる高精度を実現しています。このように、活性化関数の進化がCNNの発展に大きく寄与してきたと言えるでしょう。

| 活性化関数 | 概要 | 利点 | 欠点 | 使用モデル |

|---|---|---|---|---|

| シグモイド関数 | 入力値を0から1の範囲に変換 | 微分可能、確率表現に適している | 勾配消失問題 | LeNet |

| ReLU関数 | 入力値が0以下なら0、0より大きいならそのまま出力 | 計算コストが低い、学習速度が速い、勾配消失問題が起こりにくい | – | 現代のCNN |

プーリング

「プーリング」とは、画像認識において、画像データの大きさを縮小し、計算量を減らすとともに、画像の変形に強いモデルを作るための重要な技術です。初期の畳み込みニューラルネットワーク(CNN)であるLeNetでは、「サブサンプリング」という手法が使われていました。これは、画像を小さな区画に分け、それぞれの区画の平均値を求めることで、画像全体の解像度を下げる方法です。

サブサンプリングを使うことで、計算に使うデータの量が減り、処理速度を上げることができました。また、多少画像が変形しても、平均値を取ることで影響を抑え、認識精度を保つ効果もありました。しかし、現在広く使われているCNNでは、「最大値プーリング(Maxプーリング)」という手法が主流となっています。これは、小さな区画の中で一番大きな値だけを取り出す方法です。

最大値プーリングは、サブサンプリングに比べて、画像の中で最も目立つ特徴を効率よく捉えることができます。例えば、画像の中に「3」という数字が書かれていたとして、その数字の輪郭部分の値が大きければ、その部分を効果的に抽出できます。このように、最大値プーリングを使うことで、より高い精度で画像認識を行うことが可能になります。

LeNetでは、計算機の性能が限られていたことや、最大値プーリングの考え方がまだ広く知られていなかったことなどから、サブサンプリングが使われていました。それでもLeNetは、当時の技術水準において、高い認識性能を実現するために、様々な工夫が凝らされていました。時代の流れとともに、計算機の性能が向上し、様々な研究開発が進んだ結果、現在では最大値プーリングが主流となっています。これは、技術の進歩が画像認識の精度向上に大きく貢献していることを示す一つの例と言えるでしょう。

| 手法 | 説明 | メリット | デメリット | 使用モデル |

|---|---|---|---|---|

| サブサンプリング | 画像を小さな区画に分け、それぞれの区画の平均値を求める | 計算量の削減、画像の変形に強い | 特徴の抽出が弱い | LeNet |

| 最大値プーリング (Maxプーリング) | 小さな区画の中で一番大きな値だけを取り出す | 最も目立つ特徴を効率よく捉える、高い精度 | – | 現在のCNN |

LeNetの影響

手書き数字認識を目的として開発された「レネット」は、その後の画像認識技術に大きな影響を与えました。レネットが持つ畳み込み層とプーリング層を組み合わせた構造は、現在の畳み込みニューラルネットワーク、いわゆる「しーえぬえぬ」の基本的な構成要素となっています。

レネット以前の画像認識は、手作業で抽出された特徴量に基づいて行われていました。しかし、この方法は、対象物が複雑になると特徴量の抽出が困難になるという課題がありました。レネットは、畳み込み層を用いることで、画像データから自動的に特徴量を抽出することを可能にしました。また、プーリング層を用いることで、抽出された特徴量の位置ずれに対する耐性を高めることにも成功しました。

レネットの高い認識精度は、深層学習の可能性を示す重要な出来事となり、多くの研究者に刺激を与えました。当時、深層学習は計算量の多さから、実用的な手法とは考えられていませんでした。しかし、レネットが手書き数字認識において高い精度を達成したことで、深層学習の有用性が実証されました。この成果は、後の深層学習ブームの火付け役となり、多くの研究者が深層学習の研究に取り組むきっかけとなりました。

レネットの登場により、画像認識の分野は大きく発展しました。今日では、物体検出、画像分類、画像生成など、様々な課題で「しーえぬえぬ」が活用されています。自動運転技術や医療画像診断など、私たちの生活に密接した分野でも、レネットの技術が応用されています。レネットは、深層学習の歴史における重要な一歩であり、その功績は今も高く評価されています。現代の人工知能技術の発展を語る上で、レネットは欠かすことのできない存在です。

レネットは、深層学習という新たな時代の扉を開いた、まさに先駆的な存在と言えるでしょう。その影響は、現代社会の様々な場面に及んでおり、今後もその技術は進化し続け、更なる発展に貢献していくことでしょう。

| 項目 | 内容 |

|---|---|

| 目的 | 手書き数字認識 |

| 主要技術 | 畳み込み層とプーリング層の組み合わせ構造 |

| 利点 | 画像データからの自動的な特徴量抽出、位置ずれに対する耐性向上 |

| 影響 | 深層学習の可能性を実証、CNNの基礎、深層学習ブームの火付け役 |

| 応用分野 | 物体検出、画像分類、画像生成、自動運転、医療画像診断など |

| 評価 | 深層学習の歴史における重要な一歩、現代AI技術発展に不可欠 |