多層パーセプトロン入門

AIを知りたい

先生、「多層パーセプトロン」って、たくさんの層が重なっているっていうのはなんとなくわかるんですけど、それぞれの層は何をしているんですか?

AIエンジニア

良い質問だね。それぞれの層は、前の層から受け取った情報を処理して次の層に渡す役割を持っているんだ。入力層は、最初にデータを受け取る場所で、出力層は最終的な結果を出す場所だよ。そして、入力層と出力層の間にある隠れ層が、データの特徴を捉えて複雑な処理を行う重要な部分なんだ。

AIを知りたい

隠れ層が大切なんですね。でも、複雑な処理って具体的にどんなことをしているんですか?

AIエンジニア

例えば、たくさんの数字の組み合わせから、猫の画像かどうかを判断する場合を考えてみよう。隠れ層では、前の層から受け取った数字を組み合わせて、耳の形や目の位置などの特徴を少しずつ見つけていくんだ。そして、次の層にその情報を渡していくことで、最終的に猫かどうかを判断できるようになるんだよ。

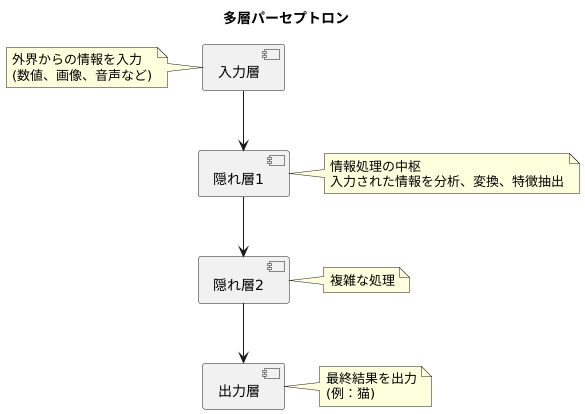

多層パーセプトロンとは。

人工知能の分野でよく使われる「多層パーセプトロン」という言葉について説明します。多層パーセプトロンとは、人間の脳の神経細胞の繋がりを模した、データ処理の仕組みです。これは、データを受け取る入力層、処理を行う隠れ層(中間層)が一つ以上、そして結果を出力する出力層が順番につながった構造をしています。以前の単純パーセプトロンでは、直線で区切れるような単純な問題しか解けませんでしたが、この多層パーセプトロンは、複雑で直線では区切れないような問題も解くことができます。これは、誤差逆伝播法と呼ばれる、処理の精度を上げるための特別な学習方法のおかげです。

多層構造

人間の脳の神経回路網を真似た仕組みである多層構造は、多層パーセプトロンの重要な特徴です。まるで層をなしたケーキのように、複数の層が重なり合うことで複雑な情報を処理することができます。一番外側にある入力層は、外界からの情報を様々な形(数値、画像、音声など)で受け取る最初の窓口です。この入力層が受け取った情報は、次にある隠れ層へと送られます。

隠れ層は、入力層と出力層の間に位置し、いわば情報処理の中枢です。複数の隠れ層が複雑に絡み合い、入力された情報を分析し、変換し、特徴を抽出していきます。それぞれの隠れ層で行われる処理は、人間が意識的に理解するのは難しいほど複雑なものですが、この複雑さこそが、多層パーセプトロンの力を生み出しています。隠れ層での処理を経て、情報は最終的に出力層へと届けられます。

出力層は、隠れ層で処理された情報を最終的な結果として出力する役割を担います。例えば、画像認識の場合、入力された画像が「猫」であると判断された結果が出力されます。このように、入力層から隠れ層、そして出力層へと、情報は一方通行で流れていきます。この順伝播型ネットワークと呼ばれる構造のおかげで、情報の伝達経路が明確になり、仕組みを理解しやすくなっています。まるで整然とした工場のラインのように、情報が各層を順々に流れていくことで、複雑な問題を効率的に解決できるのです。

活性化関数と非線形性

神経回路網を構築する上で、活性化関数は欠かせない要素です。それぞれの層にある神経細胞は、受け取った情報を活性化関数という処理を通して変換します。この活性化関数の働きによって、多層パーセプトロンは複雑な問題を解く能力を獲得します。

もし活性化関数が存在しないと、神経回路網は単純な線形変換の繰り返しになってしまいます。線形変換とは、入力に比例した出力を出す処理のことです。このような単純な変換だけでは、現実世界に存在する多くの複雑な事象、例えば画像認識や音声処理といった非線形問題を扱うことができません。非線形問題とは、入力と出力の関係が単純な比例関係で表せない問題のことです。

活性化関数は、入力信号を非線形に変換することで、この問題を解決します。具体的には、入力信号を特定の値の範囲に変換する働きを持ちます。例えば、シグモイド関数は入力を0から1の範囲の値に変換し、ReLU関数は負の入力は0に、正の入力はそのまま出力します。これらの関数は非線形変換を行うため、多層パーセプトロンが非線形問題を学習する能力を高めます。

活性化関数の種類は様々で、それぞれ異なる特徴を持っています。シグモイド関数は古くから使われてきましたが、勾配消失問題と呼ばれる学習の停滞を引き起こす可能性があります。一方、ReLU関数は計算が単純で学習速度が速いという利点があります。他にも、なめらかな性質を持つシグモイド関数の改良版であるtanh関数や、ReLU関数の改良版であるLeakyReLU関数など、様々な活性化関数が開発されています。

どの活性化関数を選ぶかは、神経回路網の性能を大きく左右します。問題の種類やデータの性質に合わせて適切な活性化関数を選択することで、より精度の高いモデルを構築することが可能になります。

| 活性化関数 | 特徴 | 利点 | 欠点 |

|---|---|---|---|

| シグモイド関数 | 入力を0から1の範囲に変換 | – | 勾配消失問題 |

| ReLU関数 | 負の入力は0に、正の入力はそのまま出力 | 計算が単純、学習速度が速い | – |

| tanh関数 | シグモイド関数の改良版、なめらか | – | – |

| LeakyReLU関数 | ReLU関数の改良版 | – | – |

学習の仕組み

学ぶとは、経験から知識や技能を得て、より良い行動や判断ができるようになることです。機械学習もこれと同じ考え方で、データという経験からパターンや法則を見つけ出し、未知のデータに対しても適切な予測や判断ができるようにする技術です。その中でも、多層知覚器は、人間の脳の神経回路網を模した構造を持ち、複雑な関係を学習することができます。

多層知覚器は、入力層、隠れ層、出力層という複数の層で構成されています。それぞれの層は、多数の節点(ニューロン)が結合してできており、この節点間の結合の強さを表すのが重みと呼ばれる数値です。学習の目的は、与えられた入力データに対して、正しい出力データが得られるように、この重みを調整することです。

重みの調整には、誤差逆伝播法という手法が広く使われています。これは、まず出力層で得られた結果と正解データとの差、つまり誤差を計算します。次に、この誤差を、出力層から入力層に向かって逆方向に伝播させていきます。それぞれの層で、誤差がどの程度重みに起因しているかを計算し、その値に基づいて重みを修正します。この過程を繰り返すことで、徐々に重みが最適な値に近づき、多層知覚器は入力データと出力データの関係を正しく学習していきます。

まるで人間が何度も試行錯誤を繰り返して学ぶように、多層知覚器も誤差を修正しながら学習を進めます。最初はうまくいかないことや間違えることもありますが、繰り返し学習することで、データの中に隠されたパターンや規則性を見つけ出し、次第に精度の高い予測や判断ができるようになります。このように、多層知覚器は、人間のように経験から学ぶことができるのです。

単純パーセプトロンとの違い

単純パーセプトロンと多層パーセプトロンの大きな違いは、扱える問題の複雑さにあります。単純パーセプトロンは、データを直線や平面で分割できる場合にのみ、正しく分類できます。言い換えれば、線形分離可能な問題しか解けません。例えば、リンゴとミカンを大きさで分類する場合、ある大きさよりも大きいものをリンゴ、小さいものをミカンとすれば、直線で二つの種類を区別できます。このような単純な問題には有効ですが、複雑な問題には対応できません。

一方、多層パーセプトロンは、隠れ層と呼ばれる中間層を持つことで、非線形な問題も解くことができます。隠れ層は、入力層から受け取った情報を加工し、より複雑な特徴を抽出する役割を担います。これにより、直線や平面では分離できないような複雑なデータも分類できるようになります。例えば、リンゴとミカンを大きさだけでなく、色や形なども考慮して分類する場合、単純な直線では分類できません。しかし、多層パーセプトロンは、隠れ層でこれらの特徴を組み合わせて、より複雑な分類基準を作り出すことができます。

この違いを端的に示す例として、XOR問題が挙げられます。XORは、二つの入力が異なる場合に1を、同じ場合に0を出力する論理演算です。この問題は、単純パーセプトロンでは解くことができません。なぜなら、XORの入出力の関係は直線で分離できないからです。しかし、多層パーセプトロンは、隠れ層を用いることで、XOR問題を解くことができます。隠れ層が、入力データの組み合わせを学習し、非線形な関係を表現できるようになるからです。

このように、隠れ層の数や構造を調整することで、多層パーセプトロンは複雑な問題にも対応できる柔軟性を持ちます。解きたい問題の複雑さに応じて、適切な隠れ層の設計が必要となります。適切な設計をすることで、単純パーセプトロンでは不可能だった複雑な分類や予測が可能になるのです。

| 項目 | 単純パーセプトロン | 多層パーセプトロン |

|---|---|---|

| 扱える問題 | 線形分離可能な問題 | 非線形な問題 |

| 隠れ層 | なし | あり |

| 例 | リンゴとミカンの大きさによる分類 | リンゴとミカンの大きさ、色、形等による分類 |

| XOR問題 | 解けない | 解ける |

| 柔軟性 | 低い | 高い |

応用分野

多層構造を持ったパーセプトロンは、様々な分野で応用されています。これは、多層パーセプトロンが持つ高い汎用性によるものです。

まず、画像を認識する分野では、手書き文字の認識や顔の認識などで使われています。パーセプトロンは、画像の中から特定の特徴を捉えることで、文字や顔を識別します。例えば、手書き文字認識では、文字の形状や線の太さなどを分析し、どの文字に該当するかを判断します。顔認識では、目や鼻、口などの位置や形状から個人を特定します。

次に、音声を認識する分野では、音声から文字を書き起こす技術に利用されています。音声データは波形として表現されますが、パーセプトロンはこの波形の特徴を捉え、どの音素や単語に該当するかを判断します。これにより、人間の音声を文字に変換することが可能になります。

また、言葉を扱う分野でも多層パーセプトロンは活躍しています。例えば、異なる言葉の間の翻訳をしたり、文章の意味を理解して質問に答えることができます。これは、パーセプトロンが大量の文章データを学習することで、言葉の意味や文法的な構造を理解できるようになるためです。

さらに、医療の分野では、病気の診断を支援するシステムや新しい薬を研究開発する場面でも利用されています。患者の症状や検査データを入力することで、パーセプトロンは病気を予測したり、適切な治療法を提案したりすることができます。また、創薬研究では、薬の候補となる物質の効果や安全性を予測するために用いられています。

お金を扱う分野でも、不正なお金のやり取りを見つけるシステムや株価の動きを予測するシステムなどに活用されています。過去の取引データや市場の動向を学習することで、パーセプトロンは不正な取引のパターンを検知したり、将来の株価変動を予測したりすることが可能になります。

このように、多層パーセプトロンは、様々な分野でなくてはならない技術となっています。今後も、更なる発展と応用が期待されています。

| 分野 | 応用例 | パーセプトロンの役割 |

|---|---|---|

| 画像認識 | 手書き文字認識、顔認識 | 画像から特定の特徴を捉え、文字や顔を識別 |

| 音声認識 | 音声から文字起こし | 波形の特徴を捉え、音素や単語を識別 |

| 自然言語処理 | 翻訳、質問応答 | 言葉の意味や文法構造を理解 |

| 医療 | 病気診断支援、新薬研究開発 | 症状や検査データから病気を予測、治療法提案、薬の効果・安全性を予測 |

| 金融 | 不正検知、株価予測 | 取引データや市場動向から不正パターン検知、株価変動予測 |