Grad-CAM:画像認識の解釈

AIを知りたい

先生、「Grad CAM」って一体何ですか?難しそうです。

AIエンジニア

簡単に言うと、AIが画像を見て、何の画像かを判断するときに、画像のどの部分を見て判断したのかを色付きの地図のように表示してくれる技術だよ。たとえば、AIが「猫」の画像と判断したとき、Grad CAMを使うと、猫の耳や尻尾といった、AIが「猫」と判断するのに使った部分が赤く表示されるんだ。

AIを知りたい

なるほど!つまり、AIの思考過程を視覚化してくれるんですね。でも、なんで色付きの地図で表示できるんですか?

AIエンジニア

それはね、AIが見ている部分を数値で表して、その数値が高い部分を赤く、低い部分を青く表示しているんだよ。数値が高い部分は、AIが判断するのに重要な部分ってことになるね。

Grad CAMとは。

『勾配で重み付けしたクラス活性化マップ』を略して『グラッドカム』といいます。これは、人工知能に関連する用語で、予測結果への影響の大きさを色の濃淡で示すことで、画像のどの部分が重要かを目に見えるようにする技術です。主に画像認識の分野で使われており、人工知能がどのように画像を分類したのか、その根拠を分かりやすく説明する手法の一つです。グラッドカムを使うと、人工知能が分類のために注目した領域が色分けされて表示されます。この技術は、予測結果に大きく影響する部分が、分類の際に重要な部分だと考えられるという発想に基づいています。影響の大きさについては、最後の畳み込み層と呼ばれる部分での、予測結果への影響度合いが使われます。

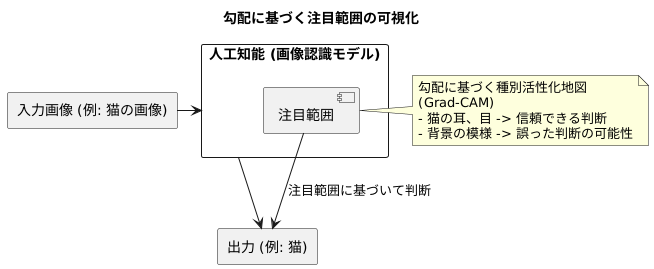

勾配に基づく注目範囲の可視化

画像認識の仕組みを深く理解するには、人工知能がどのように物事を判断しているのかを解き明かす必要があります。そのための強力な道具として「勾配に基づく注目範囲の可視化」、すなわち勾配に基づく種別活性化地図があります。この技術は、画像認識に使われる人工知能が、画像のどの部分を見て、例えば猫だと判断したのかを、視覚的に分かりやすく示してくれます。

たとえば、猫の画像を認識する場面を考えてみましょう。人工知能が猫の耳や目に注目して「猫」と判断したのであれば、その判断は信頼できます。しかし、もし背景の模様や周りの景色に注目して「猫」と判断したのであれば、その判断は誤っている可能性があります。このように、人工知能が何に着目して判断を下したのかを理解することは、その判断の信頼性を評価する上でとても重要です。

勾配に基づく種別活性化地図は、まさに人工知能の注目範囲を可視化する技術です。人工知能は複雑で分かりにくい仕組みを持っているため、しばしばブラックボックスと呼ばれます。この技術は、そのブラックボックスの中身を少しだけ覗かせてくれる、貴重な存在と言えるでしょう。この技術のおかげで、画像認識の分野での説明責任を果たしやすくなり、人工知能に対する理解を深めることができます。人工知能がどのように学習し、どのように判断を下しているのかを明らかにすることで、私たちはより良い人工知能を開発し、活用していくことができるのです。

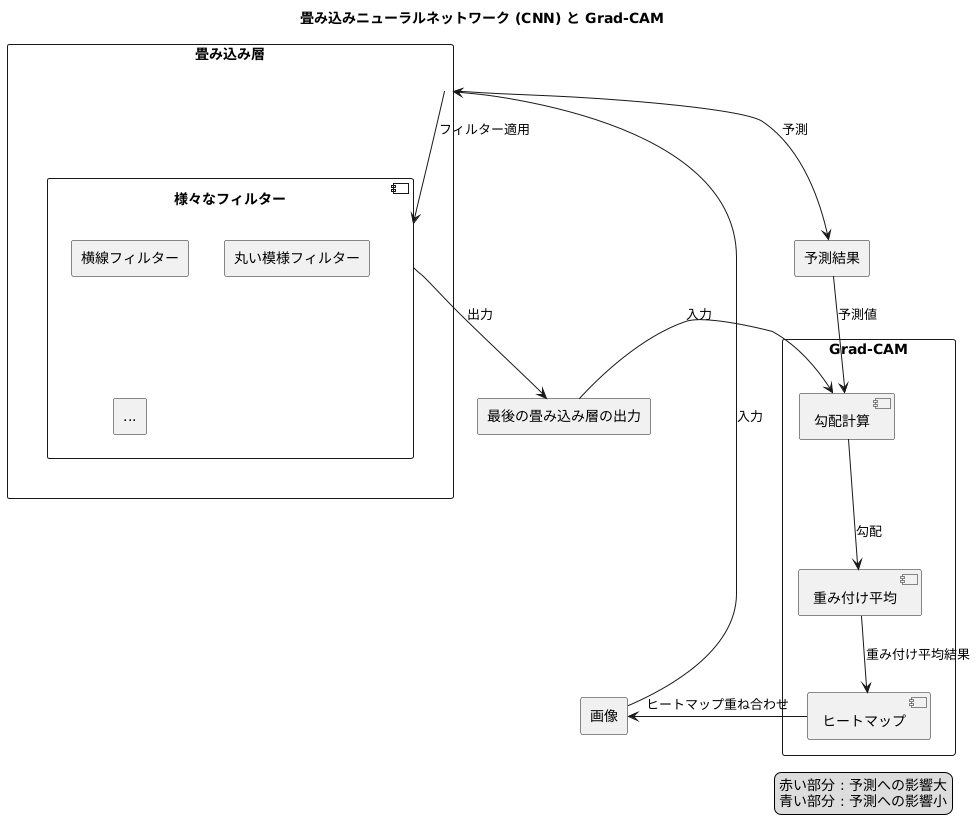

畳み込み層と勾配の役割

畳み込みニューラルネットワーク(CNN)は、画像認識において力を発揮する技術です。CNNは、人の目で見ているような「特徴」を画像から掴み取る仕組みを持っています。この仕組みにおいて、畳み込み層は特に重要な役割を担います。

畳み込み層は、様々な大きさや模様のフィルターのようなものを画像全体に滑らせながら適用し、画像の様々な部分を捉えます。例えば、横線のフィルターは、画像の中に横線があれば強く反応し、そうでなければ反応が弱くなります。同様に、丸い模様のフィルターは、画像の中に丸い模様があれば強く反応します。このように、フィルターを適用することで、画像のどこにどのような模様があるのかを数値として表現できます。CNNには様々なフィルターが数多く備わっており、それらを組み合わせることで複雑な模様も捉えることができます。

Grad-CAMという技術は、CNNの最後の畳み込み層の出力を利用して、画像のどの部分が予測に影響を与えているかを視覚的に表現します。CNNは最終的に画像が何であるかを予測しますが、その予測に至る過程は複雑で、人間には理解しにくい場合があります。Grad-CAMは、この過程を解き明かすためのツールの一つです。

Grad-CAMの中核を担うのが「勾配」です。勾配とは、ある関数の入力の変化に対して出力がどれだけ変化するかを表す値です。ここでは、CNNの予測値に対する、最後の畳み込み層の出力の勾配を計算します。この勾配は、それぞれのフィルターの出力が予測値にどれだけ影響を与えているかを示しています。勾配の値が大きいフィルターは、予測に大きな影響を与えていると解釈できます。

Grad-CAMは、これらの勾配を重みとして用いて、最後の畳み込み層の出力を重み付け平均します。そして、その結果をヒートマップとして可視化することで、画像のどの部分が予測に大きく寄与しているかを分かりやすく示します。ヒートマップにおいて、赤い部分は勾配が大きく、予測への影響が強いことを示し、青い部分は勾配が小さく、予測への影響が弱いことを示します。このように、Grad-CAMを用いることで、CNNがどのように画像を認識し、予測を行っているのかを視覚的に理解することができます。

カラーマップによる可視化

色のついた地図を使うことで、物事を分かりやすく目に見えるようにする技術があります。この技術は、Grad-CAMと呼ばれる、人工知能がどのように物事を判断しているのかを理解するのに役立つ方法で使われています。具体的には、人工知能が画像を見ている時に、どの部分に注目しているのかを色で表現した地図を、元の画像の上に重ねて表示します。

この色のついた地図は、一般的に暖色と寒色を使って表現されます。例えば、赤色は人工知能が最も注目した部分を指し示し、青色はあまり注目していない部分を指し示します。色の濃淡も重要で、鮮やかな赤色ほど注目度が高く、薄い青色ほど注目度が低いことを示しています。

例えば、犬の写真を人工知能に見せた場合を考えてみましょう。もし、犬の顔の部分が赤く表示されていれば、人工知能は正しく犬の顔の特徴を捉えて、「これは犬だ」と判断していることが分かります。これは、私たち人間が犬の写真を見るとき、犬の顔に注目するのと同じような働きをしていると言えるでしょう。

逆に、もし犬の周りの背景、例えば草むらや空の部分が赤く表示されているとしたら、人工知能は犬ではなく背景の特徴に注目して判断を下している可能性があります。これは、人工知能が間違った判断をしている可能性を示唆しており、人工知能の改良が必要となるかもしれません。

このように、色のついた地図を使うことで、人工知能がどのように物事を判断しているのかを視覚的に理解することができます。これは、人工知能の判断の理由を説明するのに役立ち、人工知能の開発や改良をよりスムーズに進める上で非常に重要な役割を果たします。

画像認識における説明可能性

近年の技術革新により、画像認識は目覚ましい発展を遂げ、様々な分野で活用されています。しかし、従来の深層学習モデルは、高精度な予測を実現する一方で、その判断理由が人間には理解しづらいという問題を抱えていました。この問題点は「説明可能性の欠如」と呼ばれ、信頼性や安全性が求められる分野での応用を阻む要因となっていました。例えば、医療診断支援システムが病気を診断したとしても、その根拠が不明瞭であれば、医師は安心してシステムの判断を参考にすることができません。

この説明可能性の欠如という課題に対し、近年注目を集めているのが「Grad-CAM」と呼ばれる技術です。Grad-CAMは、深層学習モデルが画像のどの部分に注目して判断を下したのかを、視覚的に分かりやすく表示します。具体的には、モデルが注目した画像領域を色の濃淡で示し、注目度が高いほど色が濃くなるように表現します。例えば、猫の画像を認識するモデルでGrad-CAMを用いると、モデルが猫の耳や目に注目して「猫」と判断したことが視覚的に確認できます。

Grad-CAMは、画像認識モデルの判断根拠を理解するだけでなく、モデルの改良や信頼性評価にも役立ちます。例えば、モデルが誤った予測をした場合、Grad-CAMを用いてモデルが画像のどの部分に注目したのかを確認することで、誤りの原因を特定しやすくなります。また、モデルが適切な特徴に注目しているかを確認することで、モデルの信頼性を評価することも可能です。

Grad-CAMは、医療画像診断、自動運転、製造業における品質検査など、様々な分野で応用が期待されています。これらの分野では、AIシステムの信頼性と安全性が特に重要となるため、Grad-CAMのような説明可能性技術の活用は不可欠です。今後、Grad-CAMの更なる発展と普及により、より安全で信頼性の高いAIシステムが実現すると期待されています。

| 課題 | 技術 | 説明 | 効果 | 応用分野 |

|---|---|---|---|---|

| 深層学習モデルの説明可能性の欠如 | Grad-CAM | 深層学習モデルが画像のどの部分に注目して判断を下したのかを視覚的に表示する技術。注目度が高いほど色が濃くなる。 | 判断根拠の理解、モデルの改良、信頼性評価 | 医療画像診断、自動運転、製造業における品質検査など |

応用分野と今後の展望

深層学習モデルがどのように判断しているのかを視覚的に理解できる勾配に基づくクラス活性化マップ、通称「勾配カム」は、画像認識にとどまらず、様々な分野で活用されています。例えば、文章を種類分けする作業において、この勾配カムを使うことで、モデルがどの単語に着目して分類したのかを視覚的に把握できるようになります。これは、モデルの判断根拠を理解する上で大変役立ちます。また、試行錯誤を通して学習する強化学習では、学習主体であるエージェントが、どの状況に着目して行動を選んでいるのかを分析するために勾配カムが用いられています。このように勾配カムの応用範囲は広がり続けており、様々な分野での活用が期待されています。

勾配カムは今後、より複雑なモデルや作業にも適用されるようになると考えられます。例えば、動画認識や立体データへの適用は、今後の重要な研究課題となるでしょう。また、勾配カム自体の視覚化手法もさらに高度化していくと予想されます。より詳細な情報を見やすく表示することで、モデルの判断過程をより深く理解できるようになるでしょう。これらの発展は、人工知能がどのように判断を下しているのかを人間が理解するのを助けるだけでなく、信頼できる人工知能システムを作る上でも重要です。人工知能の判断過程がブラックボックス化されているという問題は、人工知能の社会実装における大きな課題の一つです。勾配カムのような技術の発展により、このブラックボックス問題が解決され、人間にとってより理解しやすく、信頼性の高い人工知能システムが実現すると期待されています。人工知能が社会の様々な場面で活躍する未来において、勾配カムは重要な役割を担うことになるでしょう。

| 勾配カム(Grad-CAM)の概要 | 深層学習モデルの判断根拠を視覚的に理解するための技術 |

|---|---|

| 活用分野 | 画像認識、文章分類、強化学習など |

| 活用例 | – 文章分類:モデルがどの単語に着目して分類したかを視覚化 – 強化学習:エージェントがどの状況に着目して行動を選んでいるかを分析 |

| 今後の発展 | – より複雑なモデルや作業への適用(動画認識、立体データなど) – 視覚化手法の高度化 |

| 期待される効果 | – 人工知能の判断過程の理解促進 – 信頼できる人工知能システムの構築 – 人工知能のブラックボックス問題の解決 |