全結合層:ニューラルネットワークの要

AIを知りたい

先生、「全結合層」ってよくわからないのですが、教えていただけますか?

AIエンジニア

はい。全結合層とは、ニューラルネットワークの層の一つで、前の層の全ての点と、次の層の全ての点が線でつながっている層のことです。 例えば、たくさんの点を線でつないで、模様を判別する機械を想像してみてください。全結合層は、模様の特徴をまとめあげて、最終的な判断をする部分にあたります。

AIを知りたい

なるほど。模様の特徴をまとめあげる部分ですか。では、具体的にどんな役割があるのでしょうか?

AIエンジニア

例えば、手書きの数字を認識する機械を考えてみましょう。前の層までは、線の向きや丸みを認識しています。全結合層では、これらの特徴を総合的に見て、「これは1だな」とか「これは7だな」と判断する役割を果たします。つまり、バラバラな特徴をまとめて、最終的な答えを出す部分と言えるでしょう。

全結合層とは。

人工知能の分野でよく使われる「全結合層」という言葉について説明します。全結合層とは、神経回路網の中で、ある層の全ての点が次の層の全ての点とつながっている層のことです。特に画像認識に使われる畳み込みニューラルネットワーク(CNN)では、最終的な出力層に全結合層がよく使われます。この層では、前の層から得られた特徴をまとめて、最終的に欲しい一次元の数値を出力します。この数値は、元の画像がどの種類に属するかの確率を表しています。

つながるしくみ

あらゆるものが複雑に絡み合う現代社会のように、神経が集まって網の目のように情報をやり取りする仕組みを模したものが全結合層です。これは、人工知能の学習モデルであるニューラルネットワークを構成する重要な層の一つです。この層では、前の層にある全ての神経細胞が、次の層にある全ての神経細胞と一つずつ繋がっています。

それぞれの繋がりには、情報の重要度を表す重みが割り当てられています。この重みは、まるで情報の交通整理を行う信号機のように、どの情報がどの程度重要なのかを判断する役割を担っています。学習の過程で、この重みが調整されることで、ネットワーク全体の性能が向上します。丁度、経験を積むことで判断能力が向上する人間のように、ニューラルネットワークも学習を通して成長していくのです。

入力された情報は、これらの重みを掛け合わされた後に合計され、次の層へと送られます。この過程は、様々な情報を集約し、最終的な判断材料を作り出す過程に似ています。集約された情報は、そのまま次の層に送られるのではなく、活性化関数と呼ばれる特別な処理を通過します。活性化関数は、情報の取捨選択を行い、より重要な情報だけを次の層に伝える役割を担っています。

活性化関数の種類は様々ですが、よく使われるものには、緩やかな変化を生み出すものや、一定の値を超えると反応するものなどがあります。これらの関数は、ネットワークに柔軟性を与え、複雑な問題にも対応できるようにする重要な役割を果たしています。このように、全結合層は、前の層から受け取った情報を重みに基づいて変換し、活性化関数を通して次の層に伝えることで、ニューラルネットワーク全体の学習に貢献しています。まるで、様々な部署が連携して一つの組織を動かすように、全結合層も他の層と協調して複雑な処理を実現しているのです。

画像認識での役割

画像を認識する仕組みにおいて、畳み込みニューラルネットワーク(略して畳み込みニューラル網)は重要な役割を果たします。中でも、全結合層と呼ばれる部分は特に大切です。畳み込みニューラル網は、画像の特徴を捉えるために、畳み込み層とプーリング層を何層も重ねた構造をしています。これらの層を通ることで、画像は次第に抽象化された情報へと変換されていきます。しかし、最終的には画像がどの種類に属するのかを判断しなければなりません。そこで、全結合層が活躍します。

畳み込み層やプーリング層で抽出された特徴は、複雑な多次元のデータとして表現されます。これを、全結合層が一次元のベクトルへと変換します。このベクトルは、それぞれの種類に属する確率を表しています。例えば、猫、犬、鳥の画像を見分ける畳み込みニューラル網を考えてみましょう。最終的な出力は、入力画像が猫である確率、犬である確率、鳥である確率の3つの数値になります。これらの確率は、全結合層によって計算されます。

具体的には、全結合層はまず、前の層から受け取った特徴マップを平らに展開します。そして、そのすべての要素と結合することで、画像全体の情報を1つにまとめます。次に、あらかじめ学習しておいた重み付けに基づいて、各種類への所属確率を計算し、出力します。このように、全結合層は畳み込みニューラル網の中で、最終的な分類を決定する重要な役割を担っています。

そのため、全結合層の設計や学習方法が、画像認識の精度に大きく影響します。適切な設計と学習を行うことで、より正確な画像認識が可能になります。言い換えれば、全結合層は、画像認識の性能を左右する重要な鍵を握っていると言えるでしょう。

他の層との関係

全結合層は、それ単体で使用されることは稀で、多くの場合、他の層と組み合わせて活用されます。様々な層と連携することで、初めてその真価を発揮する層と言えるでしょう。

例えば、画像認識でよく用いられる畳み込みニューラルネットワーク(CNN)を見てみましょう。CNNでは、まず画像データが畳み込み層とプーリング層を通過します。これらの層は、画像の中から重要な特徴を抽出する役割を担っています。具体的には、畳み込み層はフィルターと呼ばれる小さな窓を画像全体に滑らせながら、画像の特徴を捉え、プーリング層はデータの量を減らしつつ、重要な情報を保持します。こうして抽出された特徴マップは、その後、全結合層に入力されます。全結合層は、これらの特徴マップから、最終的な画像の分類を行います。つまり、CNNにおける全結合層は、前段の層で抽出された特徴を統合し、最終的な判断を下す役割を担っているのです。

また、多層パーセプトロン(MLP)と呼ばれる構造でも、全結合層は重要な役割を果たします。MLPは、複数の全結合層を積み重ねた構造をしています。各層は、前の層の出力を次の層へと渡していきます。この過程で、それぞれの層は独自の変換を行い、情報を徐々に洗練させていきます。複数の全結合層を積み重ねることで、複雑な非線形関数を近似することが可能になります。これは、単一の層では表現できない複雑な関係性を学習できることを意味します。

このように、全結合層は他の層と密接に関係しながら動作します。前段の層で抽出・加工された情報を受け取り、それを最終的な出力へと変換する役割を担うため、他の層との連携は非常に重要です。例えば、CNNでは、畳み込み層やプーリング層から出力される特徴マップの大きさに合わせて、全結合層の入力の大きさを調整する必要があります。また、各層の出力に適用する活性化関数も、他の層との組み合わせを考慮して適切に選択する必要があります。適切な活性化関数を選ぶことで、学習効率を向上させることができます。

全結合層を効果的に活用するためには、他の層との関係性を深く理解し、適切な設計を行うことが不可欠です。他の層とのバランスを考慮することで、ニューラルネットワーク全体の性能を向上させることができます。様々な層とどのように連携させるかを工夫することで、より高度なタスクをこなせる強力なネットワークを構築することができるのです。

学習の仕組み

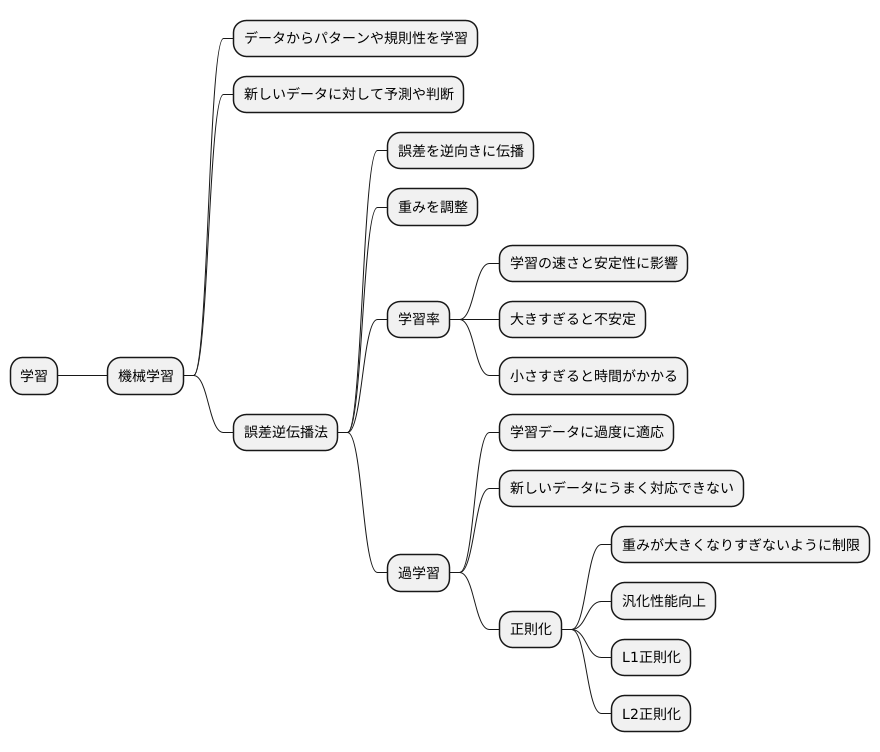

学習とは、経験から知識や技能を獲得する過程であり、様々な場面で見られます。機械学習も人間と同じように、データからパターンや規則性を学び、新しいデータに対して予測や判断を行うことを目指します。その中心的な仕組みとなるのが、誤差逆伝播法です。

誤差逆伝播法は、まるで先生からの指導のように、出力された結果と正解データとの差、つまり誤差をもとに学習を進めます。この誤差を出力層から入力層に向かって逆向きに伝播させ、それぞれの層での重みを調整します。重みとは、各要素がどれほど影響力を持つのかを示す数値です。

具体的には、誤差が小さくなるように重みを調整することで、より正確な予測ができるように学習が進みます。この調整の度合いを学習率という数値で制御します。学習率は、学習の速さと安定性に大きく影響します。学習率が大きすぎると、一度に大きく重みを変更するため、最適な値を飛び越えてしまい、学習が不安定になることがあります。逆に学習率が小さすぎると、少しずつしか重みが変わらないため、学習に時間がかかってしまいます。そのため、適切な学習率を設定することが重要です。

さらに、学習には過学習という問題も付きまといます。過学習とは、学習データに過度に適応しすぎてしまい、新しいデータに対してうまく対応できなくなる現象です。これは、まるで特定の教科の問題ばかり解いて、他の教科の問題が解けなくなるようなものです。この過学習を防ぐために、正則化という手法が用いられます。正則化は、重みが大きくなりすぎないように制限を加えることで、過学習を抑え、未知のデータに対しても適切に予測できる能力、つまり汎化性能を向上させます。代表的な正則化の手法には、L1正則化やL2正則化などがあります。

このように、誤差逆伝播法、学習率の調整、正則化といった様々な技術を組み合わせることで、効果的な学習を実現し、高精度な予測を可能にします。

今後の展望

あらゆるものを繋ぐ層である全結合層は、人の脳の神経細胞のように情報を伝達する役割を担い、これからも様々な分野で活躍が期待されています。特に、近年目覚ましい発展を遂げている深層学習の分野では、複雑かつ大規模な情報の繋がりを扱うため、全結合層の重要性はますます高まっています。

現在、多くの研究者が全結合層の計算にかかる負担を軽くしたり、より効果的な学習方法を見つけ出そうと、活発に研究開発に取り組んでいます。例えば、不要な繋がりを減らす「間引き」と呼ばれる技術は、計算の負担を軽減する効果があります。また、情報の細かさを調整する「量子化」と呼ばれる技術は、計算の負担と記憶領域の使用量を共に減らすことができます。これらの技術によって、全結合層の学習効率が向上するため、今後の発展に大きな期待が寄せられています。

さらに、全く新しい構造の層を作る研究も進んでおり、全結合層の考え方を発展させた、より高性能な層が登場する可能性も秘めています。例えば、「注意機構」と呼ばれる仕組みは、入力された情報のどの部分に注目すべきかを自動的に学習するもので、全結合層の代わりとして使われることもあります。このように、全結合層は常に進化を続けており、今後の発展が大きく期待される分野です。深層学習の進歩と共に、全結合層も更なる進化を遂げ、様々な分野で応用されていくことでしょう。

| 項目 | 説明 |

|---|---|

| 全結合層の役割 | あらゆるものを繋ぐ層であり、人の脳の神経細胞のように情報を伝達する。 |

| 深層学習における重要性 | 複雑かつ大規模な情報の繋がりを扱うため、重要性が増している。 |

| 研究開発の現状 | 計算の負担軽減や効果的な学習方法の研究が活発に行われている。 |

| 間引き | 不要な繋がりを減らし、計算の負担を軽減する技術。 |

| 量子化 | 情報の細かさを調整し、計算の負担と記憶領域の使用量を減らす技術。 |

| 新しい構造の層の研究 | 全結合層の考え方を発展させた、より高性能な層の登場が期待される。 |

| 注意機構 | 入力された情報のどの部分に注目すべきかを自動的に学習する仕組み。全結合層の代わりとして使われることもある。 |

| 今後の展望 | 深層学習の進歩と共に、更なる進化と様々な分野への応用が期待される。 |