二つの再帰型ネットワークで注意機構を実現

AIを知りたい

先生、「Encoder-Decoder Attention」って、何ですか?なんだか難しそうでよくわからないです。

AIエンジニア

そうですね、少し複雑ですね。簡単に言うと、文章を別の文章に変換する仕組みです。例えば、日本語を英語に翻訳する時などに使える技術なんですよ。

AIを知りたい

文章を変換する仕組み…ですか?具体的にはどのように変換するのでしょうか?

AIエンジニア

まず、入力の文章を「Encoder」と呼ばれる部分で分析して、重要な情報をまとめていきます。次に、「Decoder」と呼ばれる部分で、まとめられた情報をもとに、出力の文章を生成します。「Attention」は、Decoderが文章を生成する際に、入力のどの部分に注目すれば良いかを教えてくれる役割を担っています。 例えば、「私は猫が好きです」を英語に翻訳する場合、「猫」に対応する英語の単語「cat」を生成する際に、「猫」という言葉に注目するようにDecoderに指示するのです。

Encoder-Decoder Attentionとは。

人工知能で使われる「エンコーダ・デコーダ・アテンション」という用語について説明します。これは、エンコーダとデコーダという二つの再帰型ニューラルネットワーク(それぞれ長期短期記憶ネットワークを使用)をアテンションという仕組みでつないだものです。主に、系列から系列への変換、例えば機械翻訳などに使われています。

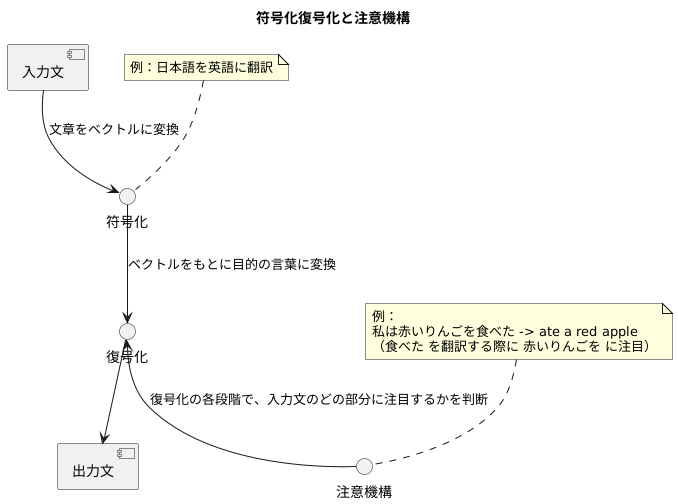

符号化復号化と注意機構

近年、言葉を扱う技術の分野で、符号化復号化という仕組みと注意機構という仕組みを組み合わせた方法が注目を集めています。この二つの仕組みを組み合わせることで、機械翻訳や文章の要約といった作業の精度が大きく向上しています。

まず、符号化復号化について説明します。これは、入力された言葉を別の形に変換する二段階の処理です。最初の段階である符号化では、入力された文章を、決まった長さのベクトルと呼ばれる数値の列に変えます。これは、文章の意味を数値で表現したようなものです。次に、復号化という段階では、この数値の列をもとに、目的の言葉に変換します。例えば、日本語を英語に翻訳する場合、日本語の文章をベクトルに変換し、そのベクトルから英語の文章を作り出す、といった具合です。

しかし、単に符号化復号化を行うだけでは、長い文章を扱うのが難しいという問題がありました。そこで登場するのが注意機構です。注意機構は、復号化の各段階において、入力された言葉のどの部分に注目すれば良いのかを判断する仕組みです。例えば、「私は赤いりんごを食べた」という文章を英語に翻訳する場合、「食べた」という言葉を翻訳する際に、「赤いりんごを」という部分に注目することで、「ate a red apple」という正しい翻訳文を作り出すことができます。

注意機構を用いることで、入力された文章の全体像を捉えながら、より正確な翻訳や要約を行うことが可能になります。翻訳だけでなく、文章の要約や文章の書き換えといった様々な応用が考えられており、今後の発展が期待されています。例えば、長文を要約する場合、重要な箇所に注目して、簡潔で分かりやすい要約文を作成することができます。このように、符号化復号化と注意機構の組み合わせは、言葉を扱う技術において重要な役割を果たしているのです。

二つの再帰型ネットワーク

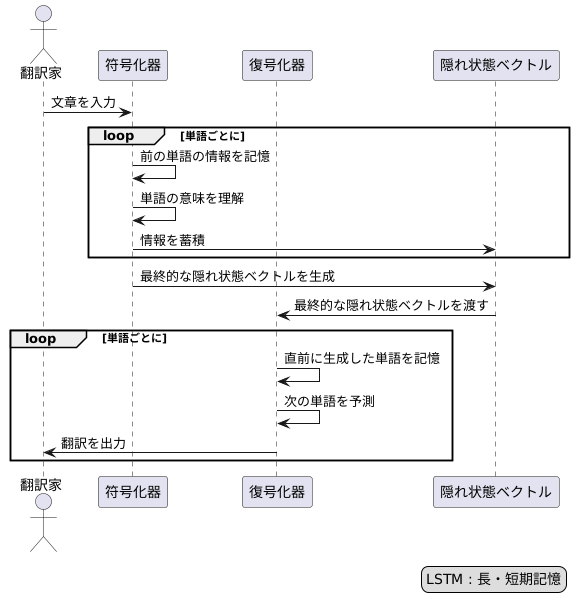

二つの再帰型ネットワークを組み合わせた符号化復号化モデルは、まるで翻訳家の脳のように働きます。まず、符号化器と呼ばれる最初のネットワークは、入力となる文章を単語ごとに読み込みます。この時、前の単語の情報も記憶しながら、各単語の意味を理解し、その情報を隠れ状態ベクトルと呼ばれる特別な記憶領域に蓄積していきます。まるで、翻訳家が原文を読みながら、重要な情報や文脈を頭の中に留めていく作業に似ています。

この隠れ状態ベクトルは、入力された文章全体の要約のようなもので、文章の核心となる意味が濃縮されています。符号化器が全ての単語を読み終えると、最終的な隠れ状態ベクトルが生成されます。これが、原文全体の意味を凝縮したメモのような役割を果たします。

次に、復号化器と呼ばれる二番目のネットワークが登場します。復号化器は、符号化器から受け取った最終的な隠れ状態ベクトルを手がかりに、翻訳を始めます。このベクトルは、翻訳の出発点となる重要な情報源です。復号化器は、この情報と、直前に生成した単語をもとに、次の単語を予測し出力します。まるで、翻訳家が頭の中のメモと、既に訳した部分を見ながら、次の言葉を紡ぎ出すように、一つずつ単語を生成していくのです。

この符号化復号化モデルでよく使われるのが、長・短期記憶(LSTM)と呼ばれる特別な再帰型ネットワークです。LSTMは、過去の情報をより長く記憶できるため、文章中の単語同士の複雑な関係や、遠く離れた単語間の関連性も捉えることができます。そのため、より自然で正確な翻訳を生成することが可能になります。まるで、記憶力の良い翻訳家が、文章全体の流れを理解しながら翻訳を進めていくかのようです。

注意機構の仕組み

注意機構は、文章を扱う人工知能の仕組みの一つで、特に翻訳や文章の要約などで力を発揮します。まるで人間の目が重要な情報に注目するように、機械も情報の重要度を理解し、処理を行います。

注意機構の仕組みは、読み取る文章(入力)と、書き出す文章(出力)の関連性を分析することから始まります。出力の各部分を生成する際に、入力のどの部分が特に関連しているかを判断します。

具体的な例として翻訳を考えましょう。日本語の「私は猫が好きです」を英語に翻訳する場合、「猫」に対応する英語の単語「cat」を生成する段階では、入力文の「猫」という部分に注目する必要があります。注意機構は、「猫」と他の単語(「私」「は」「好き」「です」)との関連の強さを数値で表します。この数値は、二つの単語の関連性が強いほど大きな値になり、「注意の重み」と呼ばれます。

注意の重みは、計算によって求められます。計算方法は様々ですが、多くの場合、出力側の単語と入力側の単語のそれぞれの意味をベクトルで表現し、それらのベクトルの類似度を計算することで重みを算出します。

こうして計算された重みを用いて、入力の各単語の情報に重み付けを行い、重み付けされた情報をまとめて出力に反映させます。翻訳の例では、「cat」を生成する際に、「猫」の重みが最も大きくなり、他の単語の重みは小さくなります。このようにして、注意機構は、入力文全体の中から、出力の各部分に関連する重要な情報を選び出し、その情報に重点を置いて処理を行うことができます。

従来の機械翻訳では、入力文全体を一つの情報に圧縮してから翻訳していたため、長い文章を扱うのが苦手でした。しかし、注意機構を用いることで、入力文のどの部分に注目すべきかを動的に判断できるようになり、長い文章でも高い精度で翻訳できるようになりました。

このように、注意機構は、人工知能が文章をより深く理解し、人間のように情報を処理することを可能にする重要な技術です。

| 項目 | 説明 |

|---|---|

| 定義 | 文章を扱う人工知能の仕組み。翻訳や要約で力を発揮。人間の目が重要な情報に注目するように、機械も情報の重要度を理解し処理。 |

| 仕組み | 入力と出力の関連性を分析。出力の各部分を生成する際に、入力のどの部分が特に関連しているかを判断。 |

| 例(翻訳) | 日本語の「私は猫が好きです」を英語に翻訳する場合、「猫」に対応する英語「cat」を生成する段階で、入力文の「猫」に注目。 |

| 注意の重み | 二つの単語の関連性の強さを数値で表したもの。関連性が強いほど大きな値。計算によって求められる。 |

| 計算方法 | 出力側の単語と入力側の単語の意味をベクトルで表現し、ベクトルの類似度を計算することで重みを算出。 |

| 処理 | 計算された重みを用いて入力の各単語の情報に重み付けを行い、重み付けされた情報をまとめて出力に反映。 |

| 従来の機械翻訳との比較 | 従来は入力文全体を一つの情報に圧縮してから翻訳していたため、長い文章を扱うのが苦手だった。注意機構では、入力文のどの部分に注目すべきかを動的に判断できるため、長い文章でも高精度で翻訳可能。 |

| まとめ | 人工知能が文章をより深く理解し、人間のように情報を処理することを可能にする重要な技術。 |

機械翻訳への応用

言葉の壁を取り払う技術として、機械翻訳は目覚ましい発展を遂げてきました。この進歩の中心にあるのが、符号化復号化モデルと注意機構です。

従来の機械翻訳では、入力された文章全体を一つの短い情報に圧縮していました。これは、長い文章を扱う際に問題を引き起こしました。ちょうど、たくさんの荷物を小さな袋に詰め込もうとすると、大切なものが壊れてしまうように、長い文章を短い情報に圧縮すると、重要な情報が失われてしまい、正確な翻訳ができなかったのです。特に、主語と述語が遠く離れた複雑な文章では、この問題は顕著でした。

この問題を解決するために導入されたのが、注意機構です。注意機構は、翻訳の過程で、入力された文章のどの部分に注目すべきかを判断する機能です。人間が翻訳する際、文章全体を一度に理解するのではなく、それぞれの単語や句に注目しながら意味を理解していくのと似ています。例えば、「昨日は、駅前で友達に会った」という文章を翻訳する場合、注意機構は「昨日」という単語を処理する際には「は」や「駅前で」といった周囲の単語に注目し、「友達」を処理する際には「に」や「会った」といった単語に注目します。このように、注意機構は、翻訳の各段階で、入力文章の関連する部分に焦点を当てることで、文脈を正確に捉え、より自然で正確な翻訳を可能にします。

特に、主語と述語が離れている長い文章や、複数の節を持つ複雑な文章において、注意機構の効果は絶大です。注意機構によって、離れた単語間の関係性を捉えることができるため、従来の手法では困難であった複雑な文章の翻訳精度が飛躍的に向上しました。これにより、機械翻訳はより高度な知的作業をこなせるようになり、グローバルなコミュニケーションを促進する上で、ますます重要な役割を果たすと期待されています。

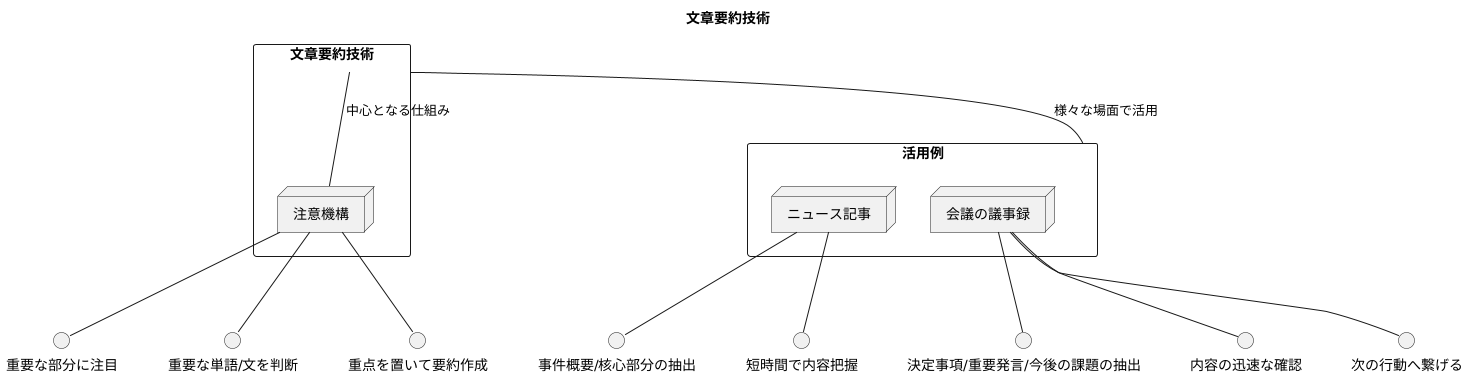

文章要約における利用

文章を要約する技術は、様々な場面で活用されています。それはまるで、熟練した職人が、複雑な作品から重要なエッセンスだけを抜き出し、簡潔で美しい形にまとめ上げるかのようです。この技術の中心となるのが、注意機構と呼ばれる仕組みです。

注意機構は、人間の目のように、文章全体を見渡し、重要な部分に注目する役割を果たします。長い文章の中から、どの単語や文が重要なのかを自動的に判断し、それらに重点を置いて要約を作成します。まるで、文章の中から宝石を見つけ出すかのようです。

例えば、ニュース記事を要約する場合を考えてみましょう。記事全体には、様々な情報が含まれています。事件の発生日時や場所、関係者の名前、事件の背景など、細かな情報が満載です。しかし、注意機構を使うことで、記事の中で最も重要な情報、つまり事件の概要や核心部分だけを抜き出すことができます。これにより、読者は短時間で記事の内容を把握できるようになります。

また、会議の議事録を要約する場合にも、注意機構は力を発揮します。長時間にわたる議論の中から、決定事項や重要な発言、今後の課題などを効率的にまとめることができます。これにより、参加者は会議の内容を素早く確認し、次の行動に繋げることができます。

このように、注意機構を用いた文章要約は、情報過多の現代社会において、効率的に情報を処理するために不可欠な技術と言えるでしょう。膨大な量の文章の中から重要な情報だけを抽出し、人々の時間を節約し、より良い意思決定を支援することに貢献しています。

今後の展望

符号化復号化モデルと注意機構は、近年の自然言語処理技術において中心的な役割を担っています。これは、文章の生成や翻訳、要約といった様々な作業で成果を上げており、既に多くの場面で活用されています。これらの技術は、人間が言葉を理解し扱う仕組みに近い方法で情報を処理します。すなわち、文章を一つずつ単語に分解し、その繋がりを分析することで、文章の意味を理解しようとするのです。

今後、これらの技術はさらに複雑な作業にも適用されていくと期待されます。例えば、複数の種類の情報(例えば、画像と文章)を同時に扱うマルチモーダルという手法は、今後の研究の重要な方向性の一つです。画像の内容を説明する文章を自動生成したり、逆に文章に基づいて画像を検索するといった技術が実現可能になります。また、人間が理解しやすい形で情報を処理する注意機構の開発も重要です。これは、人工知能がどのような根拠で判断を下したのかを理解する上で不可欠であり、今後の技術開発において重要な要素となるでしょう。

深層学習とこれらの技術の組み合わせは、今後の自然言語処理の発展を大きく加速させると考えられます。深層学習は、大量のデータから複雑な規則性を自動的に学習することができます。この能力を自然言語処理に応用することで、より高度な文章理解や生成が可能になります。例えば、文章全体の文脈をより深く理解することで、より自然で正確な翻訳や要約を作成できるようになります。また、大量のデータから学習することで、これまで人間の手で作成していた辞書や規則を自動的に生成することも可能になるでしょう。これらの技術革新は、私たちの生活を大きく変える可能性を秘めています。例えば、より高度な自動翻訳技術は、言葉の壁を越えたコミュニケーションを容易にし、国際的な交流を促進するでしょう。また、文章理解技術の進歩は、大量の文書を効率的に処理することを可能にし、ビジネスや研究の効率化に貢献するでしょう。このように、符号化復号化モデル、注意機構、そして深層学習の組み合わせは、今後の情報社会を支える基盤技術となることが期待されます。

| 技術 | 概要 | 今後の展望 | 応用例 |

|---|---|---|---|

| 符号化復号化モデル 注意機構 |

文章を単語に分解し、その繋がりを分析することで意味を理解する。人間が言葉を理解する仕組みに近い。 | マルチモーダル(複数種類の情報を同時に扱う) 人間が理解しやすい情報処理 |

文章生成、翻訳、要約 画像の説明文生成、文章に基づく画像検索 |

| 深層学習 | 大量のデータから複雑な規則性を自動的に学習。 | より高度な文章理解や生成 辞書や規則の自動生成 |

より自然で正確な翻訳・要約 大量の文書の効率的な処理 |