活性化関数:神経回路の要

AIを知りたい

先生、「活性化関数」ってどういうものですか?難しそうでよくわからないです。

AIエンジニア

活性化関数は、人間の脳の神経細胞の働きをまねたものです。脳の神経細胞は、ある一定以上の刺激を受けると、次の神経細胞に信号を伝えるという仕組みになっています。活性化関数は、この仕組みを数式で表したもので、人工知能が情報を処理する際に、どの情報を重要視するかを判断する役割を果たします。

AIを知りたい

人間の脳の働きに似ているんですね!でも、数式で表すっていうのが少し難しいです…。具体的にはどんな時に使うんですか?

AIエンジニア

例えば、犬と猫の画像を見分ける人工知能を作るとします。活性化関数は、画像の中に犬の特徴(例えば、耳の形や鼻の形)がどのくらい強く現れているかを数値化し、その数値が一定の値を超えた場合に「これは犬だ」と判断するのに役立ちます。様々な種類があり、それぞれ得意な処理が違います。

活性化関数とは。

人工知能でよく使われる「活性化関数」について説明します。活性化関数は、人間の脳の神経細胞のように、情報を伝える時に、どのくらい強く伝えるかを決める役割を果たします。それぞれの神経細胞が、次の神経細胞にどのくらい信号を送るかを調整する働きに似ています。この調整によって、情報がどのように伝わるかが変わり、最終的な結果にも影響を与えます。活性化関数の種類はいくつかあり、状況に応じて「シグモイド関数」や「ソフトマックス関数」など、適切なものが選ばれます。

活性化関数の役割

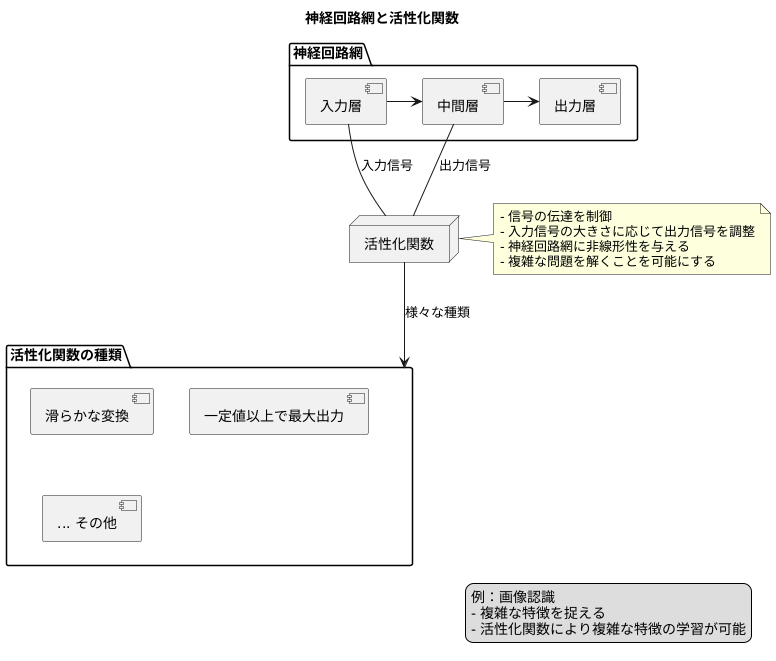

人工知能の中核技術である神経回路網では、人間の脳の神経細胞の繋がりを模倣することで複雑な計算を可能にしています。この神経回路網は、入力層、中間層、出力層の三層構造から成り、各層が複雑に絡み合いながら情報を処理しています。この情報処理において、活性化関数は信号の伝達を制御する重要な役割を担っています。

神経回路網に入力された情報は、各層の繋がりを介して伝達されます。この時、活性化関数は、受け取った入力信号の大きさに応じて、次の層への出力信号の大きさを調整します。これは、人間の脳神経細胞の働きと似ています。脳神経細胞は、他の神経細胞から信号を受け取りますが、ある一定の強さの信号を受け取らないと、次の神経細胞に信号を伝えません。活性化関数も同様に、入力信号がある一定の値を超えた場合にのみ、大きな出力信号を生成します。

活性化関数がなければ、神経回路網は単純な比例関係の計算しか行うことができず、複雑な問題を解くことができません。例えば、画像認識では、画像の中に写っている物体が何であるかを判断するために、複雑な特徴を捉える必要があります。活性化関数は、神経回路網に複雑な計算を可能にする非線形性を与え、これによって複雑な特徴の学習を可能にします。

活性化関数の種類は様々で、それぞれ異なる特徴を持っています。例えば、よく使われるものとして、入力信号を滑らかに変換するものや、一定の値以上であれば常に最大の信号を出力するものなどがあります。目的に合わせて適切な活性化関数を選ぶことで、音声認識や画像認識、文章理解といった様々な分野で高い性能を発揮する人工知能システムを構築することができます。

シグモイド関数:滑らかな活性化

弓なりの曲線を描く、シグモイド関数。これは、人工知能の学習において、情報の受け渡しを滑らかに繋ぐ重要な役割を担っています。

人工知能は、人間の脳の仕組みを模倣して作られています。脳の中では、無数の神経細胞が電気信号をやり取りすることで、情報を処理しています。この電気信号の受け渡しを人工知能で再現するために、活性化関数というものが使われています。シグモイド関数は、この活性化関数の代表的な一つです。

シグモイド関数の特徴は、その滑らかな変化にあります。入力値が小さい時は、出力値も小さくなります。入力値が大きくなるにつれて、出力値は徐々に大きくなり、最終的には1に近づきます。この0から1の間を滑らかに変化する性質は、例えばある事象が起こる確率を表現するのに最適です。そのため、人工知能が最終的な判断を下す出力層で、シグモイド関数はよく使われています。

シグモイド関数のもう一つの利点は、微分が容易であるという点です。微分とは、関数の変化の度合いを測る計算のことです。人工知能は、学習を通じて、より良い判断ができるように、内部の繋がり方を調整していきます。この調整を行う際に、微分が重要な役割を果たします。シグモイド関数は、滑らかな曲線を描くため、微分計算が比較的簡単です。これは、人工知能の学習を効率的に進める上で、大きなメリットとなります。

しかし、シグモイド関数にも弱点があります。入力値が極端に大きい場合や小さい場合、出力値の変化が非常に小さくなってしまうのです。これは、まるで緩やかな坂道を登るように、学習の進みが遅くなってしまうことを意味します。この現象は勾配消失と呼ばれ、人工知能の学習を停滞させる原因の一つとなっています。

| 項目 | 内容 |

|---|---|

| 名称 | シグモイド関数 |

| 形状 | 弓なりの曲線 |

| 役割 | 人工知能の学習において情報の受け渡しを滑らかに繋ぐ |

| 特徴 | 滑らかな変化(0から1) |

| 用途 | 事象発生確率の表現、出力層 |

| 利点 | 微分が容易、学習効率向上 |

| 弱点 | 勾配消失問題(入力値が極端な場合、学習が停滞) |

ソフトマックス関数:確率分布の出力

多くの選択肢の中から、どれが一番ありそうかを計算する時によく使われるのが、ソフトマックス関数です。これは、人工知能の分野、特に複数の答えが考えられる問題を扱うニューラルネットワークという仕組みの中で活躍します。例えば、写真を見て何が写っているかを当てる場合を考えてみましょう。猫、犬、鳥など、いくつかの可能性があります。ソフトマックス関数は、写真が猫である確率、犬である確率、鳥である確率といった具合に、それぞれの可能性を数値で表すのに役立ちます。

ソフトマックス関数のすごいところは、計算されたそれぞれの数値が、確率としてきちんと扱えるところです。つまり、全ての数値を合計すると必ず1になります。これは、百分率で考えると100%と同じです。それぞれの数値は0から1の間の値を取り、例えば猫の確率が0.7、犬が0.2、鳥が0.1だとすると、猫である可能性が一番高いと判断できます。

では、ソフトマックス関数はどのようにして確率を計算するのでしょうか?まず、それぞれの選択肢に点数のような数値が与えられているとします。この数値を、指数関数という特別な計算に通します。指数関数は、入力された数値を大きく変化させる働きがあり、これにより選択肢間の点数の差が強調されます。次に、指数関数の結果を全て足し合わせます。最後に、それぞれの選択肢に対応する指数関数の結果を、全体の合計で割ります。こうして計算された数値が、各選択肢の確率となります。

この計算方法のおかげで、最終的に得られる確率は必ず0から1の間に収まり、合計すると1になることが保証されます。そのため、ソフトマックス関数は、写真に何が写っているか、文章がどんな感情を表しているかなど、様々な分類問題で広く使われています。たくさんの選択肢の中から、どれが一番ありそうかを判断する必要がある時に、ソフトマックス関数はとても便利な道具なのです。

| 項目 | 説明 |

|---|---|

| ソフトマックス関数 | 複数の選択肢から最も可能性の高いものを確率で表す関数。ニューラルネットワークでよく使われる。 |

| 用途 | 画像認識(写真に何が写っているか)、文章の感情分析など、様々な分類問題。 |

| 出力 | 各選択肢の確率。0から1の間の値で、合計は必ず1(100%)。 |

| 計算方法 | 1. 各選択肢にスコアを割り当てる。 2. 各スコアを指数関数に通す。 3. 指数関数の結果を合計する。 4. 各選択肢の指数関数の結果を合計値で割る。 |

| 特徴 | 出力値は確率として扱える(0から1の間、合計は1)。 指数関数により選択肢間のスコアの差が強調される。 |

様々な活性化関数

色々な計算のやり方を決める関数を活性化関数と言います。活性化関数は、人工知能の学習において、情報の伝わり方を調整する重要な役割を果たします。よく知られたものとして、シグモイド関数やソフトマックス関数などがありますが、他にも多くの種類があります。

例えば、近年注目を集めているのが、計算の手間が少なく、勾配消失問題と呼ばれる問題を軽減できる「正規化線形関数」です。この関数は、入力された値が0以下であれば0を、0より大きければその値と同じものを出力します。とても単純な仕組みですが、学習のスピードを速くし、精度を上げる効果が期待できます。

また、シグモイド関数に似た形を持つ「双曲線正接関数」もよく使われます。こちらは、出力される値が-1から1の間になります。シグモイド関数と似ていますが、出力値の範囲が違うため、使う場面によって使い分ける必要があります。

このように、活性化関数はそれぞれ異なる特徴を持っています。そのため、解きたい問題や人工知能の構造に合わせて、適切な関数を選ぶことが重要です。適切な関数を選ぶことで、学習の効率や精度が向上することが期待できます。

最近では、「スウィッシュ関数」や「ミッシュ関数」など、さらに高度な活性化関数の研究開発も活発に行われています。これらの新しい関数は、人工知能技術の進化を支える重要な要素となっています。

| 活性化関数名 | 特徴 |

|---|---|

| 正規化線形関数 (ReLU) | 入力値が0以下なら0、0より大きければその値を出力。計算が単純で、勾配消失問題を軽減。学習速度向上、精度向上に貢献。 |

| 双曲線正接関数 (tanh) | 出力値が-1から1の間。シグモイド関数と似ているが、出力値の範囲が異なるため、使い分けが必要。 |

| シグモイド関数 | よく知られた活性化関数。 |

| ソフトマックス関数 | よく知られた活性化関数。 |

| スウィッシュ関数 | 高度な活性化関数。研究開発が活発。 |

| ミッシュ関数 | 高度な活性化関数。研究開発が活発。 |

活性化関数の選択

人の脳神経を模した仕組みである人工知能の学習において、活性化関数の選定は結果に大きな影響を与えます。活性化関数は、人工神経細胞の出力を調整する役割を担い、まるで人間の脳細胞のように情報を処理し、次の細胞へ伝えるかどうかの判断材料となります。この関数を適切に選ぶことで、人工知能の学習はスムーズに進み、精度の高い結果を得ることができるのです。

活性化関数の種類は豊富にあり、それぞれに特徴があります。例えば、結果を確率で表したい場合、よく使われるのがシグモイド関数とソフトマックス関数です。シグモイド関数は、0から1の間の値に変換し、ソフトマックス関数は、複数の出力値の合計が1になるように調整します。これらは、画像認識でどの物体に該当するかを判断する際などに役立ちます。

一方、人工知能の内部で情報を処理する中間層では、レルー関数やハイパボリックタンジェント関数がよく使われます。レルー関数は、計算が単純で学習速度が速い点が利点です。ハイパボリックタンジェント関数は、出力値が正負の両方を持つため、より複雑な情報を表現できます。

学習の過程で問題となるのが、勾配消失問題です。これは、学習が進むにつれて変化量が小さくなり、学習が停滞してしまう現象です。この問題を避けるためには、レルー関数が有効です。

近年では、様々な活性化関数が提案されており、それぞれに利点と欠点があります。そのため、目的や人工知能の構造に合わせて最適な関数を選ぶ必要があります。どの関数が最適かは、実際に試してみないと分からない場合も多いので、色々な関数を試して結果を比較することが大切です。適切な活性化関数を選ぶことで、より正確な予測と効率的な学習を達成できるのです。

| 活性化関数 | 特徴 | 用途 |

|---|---|---|

| シグモイド関数 | 0から1の間の値に変換 | 確率の表現、画像認識 |

| ソフトマックス関数 | 複数の出力値の合計が1になるように調整 | 確率の表現、画像認識 |

| ReLU関数 | 計算が単純、学習速度が速い、勾配消失問題を回避 | 中間層の処理 |

| ハイパボリックタンジェント関数 | 出力値が正負両方、複雑な情報を表現 | 中間層の処理 |