倫理的なAIへの道筋

AIを知りたい

先生、「倫理的AI成熟度モデル」って難しそうでよくわからないです。簡単に教えてもらえますか?

AIエンジニア

そうだね、少し難しい言葉だね。「倫理的AI成熟度モデル」とは、AIを使う会社が、倫理的に正しいAIの使い方をしているかをチェックするための道具のようなものだよ。AIが正しく使われているかを自分でチェックして、より良い使い方に改善していくためのものなんだ。

AIを知りたい

なるほど。AIの使い方をチェックする道具ですか。具体的にはどんなことをチェックするんですか?

AIエンジニア

いい質問だね。例えば、AIが偏った判断をしていないか、個人情報が守られているか、AIの判断の理由がちゃんと説明できるか、といったことをチェックするんだよ。透明性や公平性、個人情報の守りなどをチェックすることで、責任あるAIの使い方を目指しているんだ。

倫理的AI成熟度モデルとは。

人工知能を使うにあたっての倫理的な問題について、組織がどのくらいきちんと対応できているかを測るための『倫理的な人工知能の成熟度モデル』というものがあります。このモデルは、組織が人工知能技術を倫理的に使うための方法を評価し、より良くするための枠組みです。組織は、今の倫理的な人工知能への取り組み方を評価し、責任ある信頼できる人工知能の使い方へと進む方法をこのモデルを使って知ることができます。具体的には、透明性や公平性、データのプライバシー保護、責任の所在、予測の偏りといった問題を扱っています。

倫理的なAIとは

近頃よく耳にする人工知能、いわゆるAIは、暮らしの様々な場面で活躍し、多くの恩恵を私たちにもたらしています。買い物をする時の商品のおすすめや、車の自動運転、病気の診断など、私たちの生活はAIによって大きく変わりつつあります。しかし、AIは便利な道具であると同時に、使い方を誤ると様々な問題を引き起こす可能性も秘めていることを忘れてはなりません。

そこで重要になるのが、倫理的なAIという考え方です。倫理的なAIとは、人の尊厳や権利、大切にすべき価値観を尊重し、社会全体にとって良い影響を与えるように作られ、使われるAIのことです。これは、単にAIの技術的な側面を考えるだけでなく、社会や文化、哲学といった広い視野も必要とする複雑な問題です。

倫理的なAIを実現するためには、公平性、透明性、説明責任という三つの大切な柱があります。公平性とは、AIが特定の人々を不当に差別することなく、すべての人々に平等に接することです。透明性とは、AIの仕組みや判断の根拠がわかりやすいように作られていることです。説明責任とは、AIによって問題が起きた時に、誰が責任を負うのかが明確になっていることです。

AIを作る技術者、AIを使う私たち、そしてAIに関するルールを作る政治家など、AIに関わるすべての人が協力して、倫理的なAIを実現していく必要があります。AIの技術は日々進歩しています。倫理的な配慮を怠ると、社会の不平等や差別、個人のプライバシーの侵害といった深刻な問題につながる危険性があります。

AIと人間が共に生きる未来を作るために、私たちはAIの倫理について真剣に考え続け、適切な指針を作り上げていく必要があるでしょう。倫理的なAIは、未来への希望の光となるだけでなく、責任ある技術革新の象徴となるはずです。

| 項目 | 説明 |

|---|---|

| AIの恩恵 | 商品のおすすめ、自動運転、病気の診断など |

| 倫理的なAIの定義 | 人の尊厳や権利、大切にすべき価値観を尊重し、社会全体にとって良い影響を与えるように作られ、使われるAI |

| 倫理的なAIの3つの柱 | 公平性、透明性、説明責任 |

| 公平性 | AIが特定の人々を不当に差別することなく、すべての人々に平等に接すること |

| 透明性 | AIの仕組みや判断の根拠がわかりやすいように作られていること |

| 説明責任 | AIによって問題が起きた時に、誰が責任を負うのかが明確になっていること |

| AI倫理に関わる人々 | AIを作る技術者、AIを使う人々、AIに関するルールを作る政治家など |

| 倫理的配慮を怠った場合のリスク | 社会の不平等や差別、個人のプライバシーの侵害といった深刻な問題 |

成熟度モデルの活用

人工知能の倫理的な活用は、現代社会において大変重要になっています。そのため、組織は自らの取り組みを評価し、より良いものにする方法を常に考える必要があります。倫理的な人工知能成熟度モデルは、まさにそのための道具です。このモデルは、組織が人工知能技術を倫理的に使うための現在の実力や進捗状況を測る物差しのようなものです。

このモデルを使うことで、組織は自分たちの現在地を客観的に知ることができます。まるで地図上で現在地を確認するように、倫理的な人工知能活用における自分たちの立ち位置がはっきりと分かります。そして、目指すべき方向、つまりより高い倫理レベルへの道筋を立てることができます。このモデルには段階が設けられており、一段ずつ着実に進んでいくことができます。各段階には具体的な目標と達成するための基準が示されているので、組織は無理なく、自分たちのペースで倫理的な人工知能の活用を進めることができます。

たとえば、最初の段階では、倫理的な人工知能についての基本的な知識を学ぶことが目標となります。次の段階では、学んだ知識を基に、組織内でのルール作りや行動規範の作成に取り組みます。さらに進むと、実際に人工知能システムを開発・運用する際に、倫理的な側面を考慮した設計や検証を行う段階となります。このように、段階的に目標を達成していくことで、組織全体の倫理的な意識を高め、責任ある人工知能の活用を促進することができます。

倫理的な人工知能成熟度モデルは、組織が人工知能技術を正しく活用するための道しるべとなります。このモデルを活用することで、組織は倫理的な課題に適切に対処し、社会全体の信頼を勝ち取ることができるでしょう。人工知能技術がますます進化していく中で、このモデルは、組織が倫理的な指針を失わずに進んでいくための重要な羅針盤となるでしょう。

透明性の確保

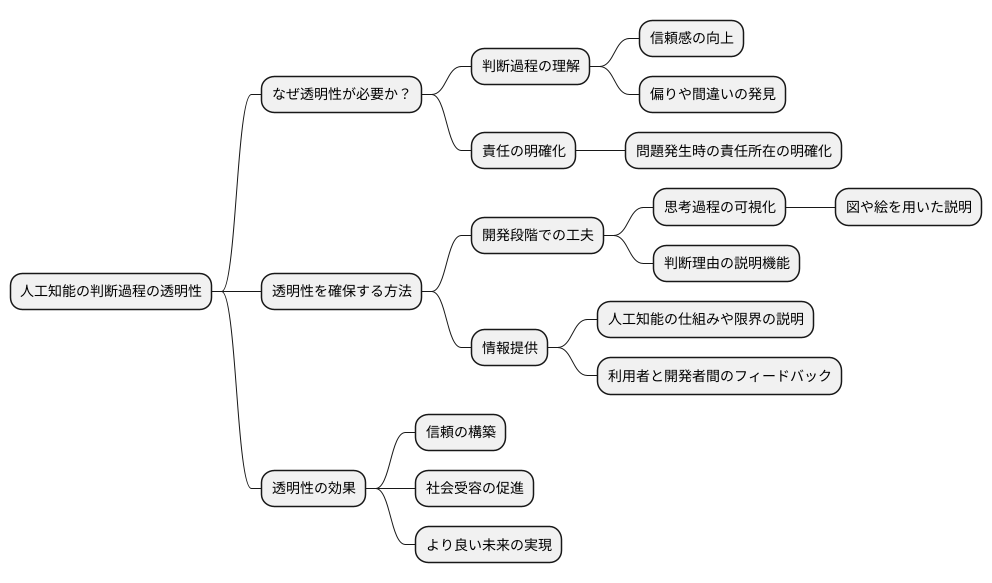

人工知能を使った仕組みの判断の過程は、複雑で分かりにくく、まるで中身の見えない箱のようです。そのため、どのような理由でその判断に至ったのかが分からず、不安を抱く人が少なくありません。人工知能が倫理的に適切に動くためには、この判断の過程を明らかにすることがとても大切です。人工知能がどのように考えて結論を出したのかが分かれば、その仕組みへの信頼感が増し、隠れた偏りや間違いを発見しやすくなります。透明性を確保することは、人工知能の責任を明らかにするためにも欠かせません。もし、人工知能の動きが不透明なまま、何か問題が起きた場合、誰が責任を取るのかを判断するのが難しくなります。

人工知能を開発する際には、最初から分かりやすさを重視する必要があります。例えば、人工知能の思考過程を絵や図で分かりやすく示す道具や、判断の理由を説明する機能を作るのが有効です。さらに、人工知能を作った人や使う人は、人工知能がどのように動くのか、どのような限界があるのかを、利用者や関係者に積極的に伝えるべきです。分かりやすい情報提供は、利用者と開発者側、双方にとって有益です。開発者側は、利用者からのフィードバックを通して人工知能の改善点を発見でき、利用者側は安心して人工知能を利用できます。

透明性の確保は、人工知能に対する信頼を築き、社会全体で人工知能技術を受け入れていくために、なくてはならない要素です。人工知能が社会にとってより良いものとなるためには、技術的な進歩だけでなく、誰もが理解し、安心して使えるような仕組みづくりが重要です。透明性の向上は、人工知能が社会に受け入れられ、より良い未来を作るための重要な一歩となるでしょう。

公平性の担保

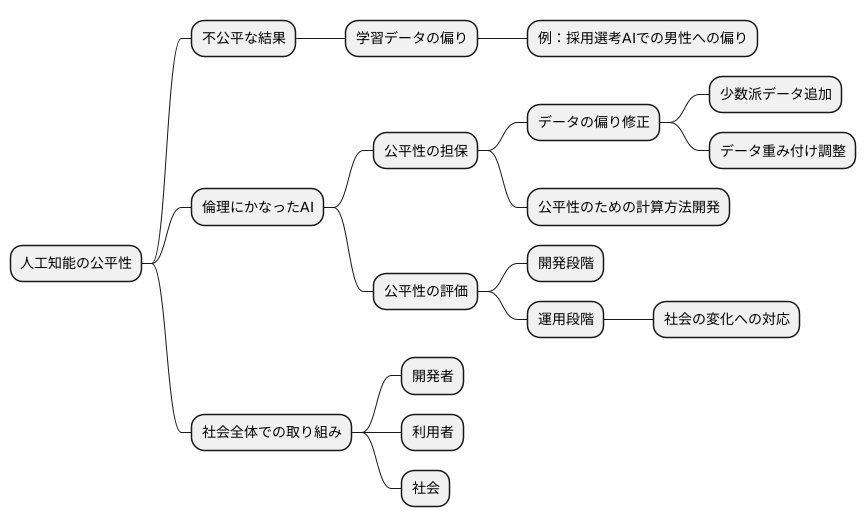

人工知能は、その学習内容によって、ある特定の集団にとって不公平な結果を生み出す可能性があります。学習に使われるデータに偏りがある場合、その偏りを反映した結果が出力されるからです。例えば、ある人工知能が採用選考に使われるとして、過去の採用データに男性が多い場合、その人工知能は男性を採用する傾向が強くなる可能性があります。これは、女性にとって不公平な結果をもたらすと言えるでしょう。

倫理にかなった人工知能を実現するには、この公平性をどのように担保するかが重要な課題となります。人工知能が人種、性別、年齢、宗教など、あらゆる属性に基づく差別を助長しないように、開発者は注意深く開発を進める必要があります。具体的には、学習データに偏りがある場合は、その偏りを修正する必要があります。例えば、少数派のデータを追加したり、データの重み付けを調整したりすることで、偏りの影響を軽減することができます。また、公平性を担保するための特別な計算方法を開発することも必要です。

さらに、人工知能の公平性を評価するための基準を設け、定期的に評価を行うことも重要です。この評価は、人工知能の開発段階だけでなく、実際に運用する段階においても継続的に行う必要があります。人工知能は、社会の中で使われるものなので、公平性の基準は時代とともに変化する可能性があるからです。社会の変化に合わせて、人工知能の公平性も常に監視し、必要に応じて修正していく必要があります。

公平性の担保は、人工知能が社会全体にとって有益なものとなるために欠かせない要素です。人工知能が社会的不平等を助長するのではなく、すべての人にとって公平な社会を実現するために役立つように、私たちは倫理にかなった人工知能の実現に向けて努力を続けなければなりません。これは、開発者だけでなく、利用者、そして社会全体で取り組むべき課題です。

説明責任の明確化

人工知能がもたらす結果について、誰が責任を負うのかを明らかにすることは、倫理に沿った人工知能の活用に欠かせません。人工知能を作る人、使う人、そして政策を決める人、それぞれが責任を分け合い、協力して問題を解決していく必要があります。

まず、人工知能を作る人は、システムの安全性、信頼性、公平性を保つ責任があります。具体的には、誤作動や意図しない結果を引き起こさないように注意深く設計し、様々な状況で適切に動作することを確認する必要があります。さらに、特定の集団に不利益を与えたり、差別を助長したりしないように、公平性を意識した設計を行うことが求められます。

次に、人工知能を使う人は、システムを適切な目的で使い、倫理的な配慮を怠らない責任があります。人工知能は便利な道具ですが、使い方を誤れば大きな問題を引き起こす可能性があります。そのため、利用者は常に倫理的な側面を意識し、責任ある行動をとる必要があります。

そして、政策を決める人は、人工知能技術の活用に関する適切な規則や指針を作り、倫理的な利用を促す責任があります。人工知能技術は急速に発展しており、それに伴う社会的な影響も大きくなっています。だからこそ、政策立案者は常に最新の技術動向を把握し、適切な規制や支援策を講じる必要があります。

人工知能を作る過程や使う際のはっきりとした規則と指針を作ることで、責任の所在を明確にし、問題が起きた際の対応を素早く行うことができます。また、人工知能の利用によって倫理的な問題が生じた場合、誰がどのように判断を下すのかをあらかじめ決めておくことも重要です。

責任を明らかにすることは、人工知能に対する信頼を作り、社会全体で人工知能技術を受け入れてもらうために欠かせない要素です。人工知能が社会にとってより良いものとなるよう、関係者全員が責任感を持って取り組む必要があります。

| 役割 | 責任 | 具体的な行動 |

|---|---|---|

| 人工知能を作る人 | システムの安全性、信頼性、公平性を保つ | 誤作動や意図しない結果を防ぐ設計、様々な状況での適切な動作確認、公平性を意識した設計 |

| 人工知能を使う人 | システムを適切な目的で使い、倫理的な配慮を怠らない | 倫理的な側面を意識し、責任ある行動をとる |

| 政策を決める人 | 人工知能技術の活用に関する適切な規則や指針を作り、倫理的な利用を促す | 最新の技術動向を把握し、適切な規制や支援策を講じる |