AI開発と炎上対策、多様性の確保

AIを知りたい

先生、「炎上対策」と「ダイバーシティ」って、AIを作る上でどうして大切なんですか?

AIエンジニア

良い質問だね。例えば、ある会社のAIが特定の人たちにとって不公平な判断をして、みんなから非難されることを想像してみて。これが「炎上」だよ。それを防ぐために「炎上対策」が必要なんだ。「ダイバーシティ」は、色々な考え方や背景を持つ人がいる状態のこと。AIを作る時に色々な人が関わっていれば、偏ったAIになることを防ぎやすくなるんだよ。

AIを知りたい

なるほど。色々な人がAI作りに参加すれば、炎上を防げるんですね。でも、具体的にはどうすればいいんですか?

AIエンジニア

そうだね。例えば、AIを作るチームに、様々な考え方や育ってきた環境が違う人、男の人も女の人も、色々な国の人も入れるようにするんだ。そうすることで、より多くの人に配慮したAIを作ることができるんだよ。

炎上対策とダイバーシティとは。

人工知能を作る上で大切なこととして、『悪い評判が広まるのを防ぐこと』と『色々な考え方を取り入れること』があります。人工知能を作った会社で、色々な考え方の人がいなくて、差別的だと悪い評判が広がってしまうことがあります。そうならないために、人工知能を作るチームに様々な価値観や背景を持つ人を加えることが大切です。

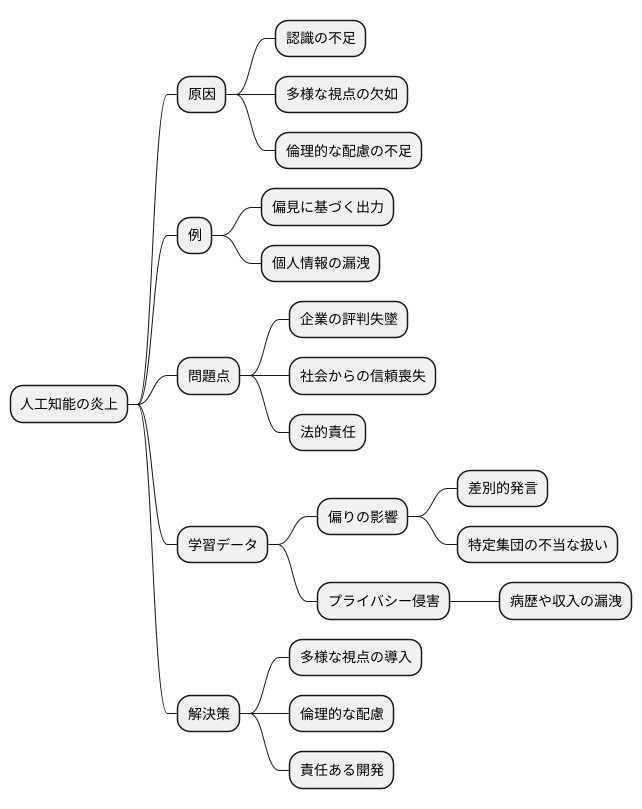

人工知能における炎上とは

人工知能(じんこうちのう)の開発において、しばしば問題となるのが「炎上」と呼ばれる現象です。これは、人工知能が示す反応や行動が、社会的に受け入れられない、不適切だと多くの人から非難され、大きな反発を受ける事態を指します。このような事態は、開発に携わった人たちの認識の不足や、多様な視点を取り入れることの欠如、倫理的な配慮の不足など、様々な要因が絡み合って起こります。

例えば、ある特定の人種や性別に対して偏った見方を持つような結果を出力したり、個人の生活に関わる大切な情報を漏らしてしまうようなデータの使い方をしたりするといったことが考えられます。一度このような炎上が発生すると、企業の評判は地に落ち、社会からの信頼を失うだけでなく、場合によっては法律に基づいて責任を問われる可能性も出てきます。

人工知能は、学習データと呼ばれる大量の情報に基づいて判断や予測を行います。そのため、もし学習データに偏りがあれば、その偏りが人工知能の出力にも反映されてしまうのです。偏ったデータで学習した人工知能は、差別的な発言をしてしまったり、特定の集団を不当に扱ってしまう可能性があります。

また、人工知能が利用するデータが、個人が特定できないように適切に処理されていなかった場合、個人のプライバシーを侵害する危険性も高まります。例えば、病歴や収入といった、個人が公開を望まない情報が漏洩してしまうかもしれません。このような事態は、企業にとって大きな損失となるだけでなく、社会全体に悪影響を及ぼすことが懸念されます。だからこそ、人工知能の開発においては、多様な視点を取り入れ、倫理的な配慮を欠かさないことが重要です。そして、常に社会的な影響を考えながら、責任ある開発を進めていく必要があります。

多様性の確保

人工知能を作る過程で、色々な人が関わることはとても大切です。これは、問題を起こさず、みんなにとって公平で正しい人工知能を作るために欠かせません。色々な人とは、開発チームのメンバーの属性、例えば人種や性別、年齢、育ってきた環境や考え方の違いだけでなく、人工知能に学習させるデータの種類も含まれます。

開発チームに様々な人種、性別、年齢、文化背景、価値観を持つ人がいれば、色々な視点から物事を考えることができ、偏りのない人工知能を作ることができます。例えば、ある文化圏では問題ないとされる表現が、別の文化圏では差別的と捉えられることがあります。色々な人が開発に関わることで、このような文化の違いにも気を配った人工知能を作ることができるのです。

人工知能に学習させるデータも、色々な種類を揃えることが重要です。特定の集団のデータばかりが多く、他の集団のデータが少ないと、人工知能が出す答えはデータの多い集団に偏ってしまいます。色々なデータをたくさん集め、バランスよく学習させることで、より公平な人工知能を作ることができます。偏ったデータで学習させた人工知能は、特定の人々を不公平に扱う可能性があり、社会的な問題を引き起こす可能性があります。例えば、採用選考で使う人工知能が、過去の採用データに基づいて学習されていると、過去の採用傾向が反映され、特定の属性の人々が不利になる可能性があります。

多様なデータを用いることで、このような偏りを減らし、誰もが平等に扱われる人工知能を実現できます。また、多様な人材が開発に携わることで、様々な視点から問題点を洗い出し、より安全で信頼できる人工知能を開発することができます。人工知能は社会の様々な場面で使われるようになってきています。だからこそ、開発段階から多様性を意識することで、みんなにとってより良い社会を実現するために人工知能を活用できるのです。

| 要素 | 重要性 | 具体例 | 結果 |

|---|---|---|---|

| 開発チームの多様性 (人種、性別、年齢、文化背景、価値観) |

様々な視点を取り入れ、偏りのないAIを作る | 文化圏ごとの表現の違いを考慮 | 文化の違いに配慮したAI |

| 学習データの多様性 | 特定の集団への偏りを防ぎ、公平なAIを作る | 採用選考AIにおける過去の採用データの偏り | 公平なAI、社会問題の回避 |

| 多様なデータ | 偏りを減らし、平等なAIを実現 | – | 誰もが平等に扱われるAI |

| 多様な人材 | 様々な視点から問題点を洗い出し、安全で信頼できるAI開発 | – | 安全で信頼できるAI |

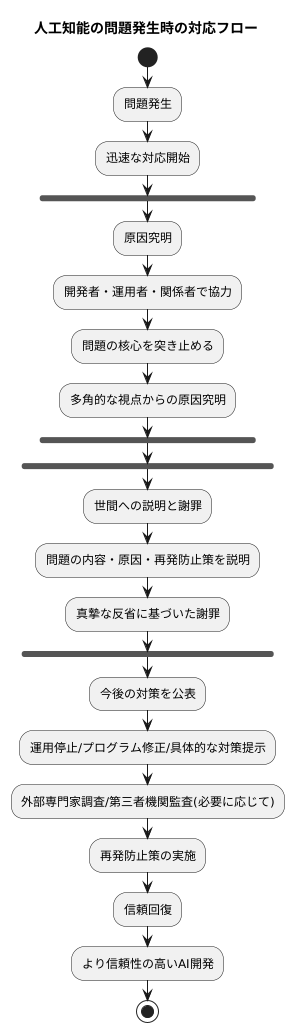

炎上への対処法

人工知能が世間を騒がせるような問題を起こしてしまった場合、迅速で的確な対応が求められます。対応が遅れれば遅れるほど、非難の声は大きくなり、信頼回復はより困難になります。まずは、何が問題となっているのか、その原因を徹底的に調べなければなりません。人工知能の開発者、運用者、そして関係者全員で協力し、問題の核心を突き止めます。具体的な問題点だけでなく、なぜそのような問題が発生したのか、開発過程や運用体制に問題がなかったかなど、多角的な視点から原因を究明します。

原因究明と並行して、世間への説明と謝罪も必要です。問題の内容、原因、そして再発防止策について、包み隠さず誠実に説明しなければなりません。何が問題だったのか、なぜその問題が発生したのか、今後どのように改善していくのか、具体的に説明することで、信頼回復への第一歩を踏み出せます。謝罪は形式的なものではなく、真摯な反省の気持ちに基づいたものでなければなりません。

今後の対策についても公表する必要があります。人工知能の運用を一時的に停止するのか、プログラムを修正するのか、具体的な対策を示すことで、更なる問題発生を防ぎ、信頼を回復していくことができます。場合によっては、外部の専門家による調査や、第三者機関による監査なども検討する必要があります。

このような騒動は、企業にとって大きな危機ではありますが、同時に貴重な学習機会でもあります。問題の根本原因を分析し、再発防止策を徹底することで、より信頼性の高い、安全な人工知能開発につなげることができます。この経験を活かし、より良い技術開発、より良い社会貢献を目指していくことが重要です。

倫理的な人工知能

人工知能は、私たちの暮らしを大きく変える力を持っています。便利な道具となる一方で、使い方を誤れば、社会に思わぬ悪い影響を与える可能性も秘めています。だからこそ、人工知能を作る際には、倫理的な配慮が欠かせません。

人工知能の開発において、最も大切なのは人間の尊厳を尊重することです。人工知能は人の役に立つ道具であるべきであり、人を傷つけたり、差別や偏見を助長するようなことがあってはなりません。例えば、採用活動で人工知能を使う場合、特定の属性の人を不当に不利に扱うようなことがあってはならないのです。そのため、開発の段階から倫理的な指針をしっかりと守ることが重要です。

人工知能の判断や予測の過程を明らかにする「透明性」も重要な要素です。人工知能がどのように考えて結論を出したのかが分からなければ、人は人工知能を信頼することができません。信頼がなければ、人工知能を安心して使うことも難しくなります。透明性を高めることで、人工知能の信頼性を高め、より安心して使えるようにする必要があるのです。

さらに、人工知能を何のために使うのか、その目的を明確にすることも大切です。人工知能は様々なことができますが、全てが社会にとって良いことばかりとは限りません。人工知能の利用目的を明確にし、人々の暮らしをより良くするために役立つように、社会全体にとって有益な形で使われるよう配慮しなければなりません。

倫理に配慮した人工知能開発は、社会全体に利益をもたらします。そして、人工知能技術がこれから先も発展していくための土台となります。倫理的な側面を常に意識し、責任ある開発を行うことで、人と人工知能が共存するより良い社会を築くことができるでしょう。

| 倫理的な観点 | 内容 | 具体例 |

|---|---|---|

| 人間の尊厳の尊重 | 人を傷つけたり、差別や偏見を助長しない | 採用活動で特定の属性の人を不当に不利に扱わない |

| 透明性 | 判断や予測の過程を明らかにする | 人工知能の思考過程を理解できるようにする |

| 利用目的の明確化 | 何のために使うのかを明確にする | 社会全体にとって有益な形で使う |

多様性を持つチーム作り

近年、人工知能の開発が急速に進んでいますが、開発チームの多様性を確保することは、偏りのない倫理的な人工知能開発を実現する上で非常に重要です。多様な人材とは、性別、年齢、国籍、文化背景、専門分野といった様々な属性を持つ人材を指します。このような多様な人材を採用し、それぞれの個性を尊重する職場環境を整備することで、様々な視点や発想を取り入れた開発が可能になります。

異なる文化背景を持つ人材は、それぞれの文化圏における慣習や価値観を理解しています。例えば、ある文化圏では適切とされる表現や行動が、別の文化圏では不適切とされる場合もあります。このような文化的な違いを考慮せずに人工知能を開発すると、予期せぬ問題が発生する可能性があります。多様な文化背景を持つ人材が開発チームに参加することで、人工知能が文化的な違いを考慮した適切な動作をするように開発を進めることができます。

また、異なる専門分野を持つ人材が協働することも重要です。人工知能開発には、情報工学の専門家だけでなく、倫理学、哲学、社会学、心理学、法律学など、様々な分野の専門知識が必要となります。それぞれの専門分野を持つ人材が協働することで、技術的な課題だけでなく、倫理的な課題や社会的な影響についても多角的に検討することができます。例えば、人工知能が人の仕事に取って代わることによる失業問題や、人工知能による差別や偏見といった問題についても、多様な専門家による議論が必要です。

多様なチームは、より創造的で革新的な人工知能開発を促進し、社会全体の進歩に貢献します。均質なチームでは、発想が固定化され、革新的なアイデアが生まれにくい傾向があります。一方、多様なチームでは、異なる視点や発想がぶつかり合うことで、新しいアイデアが生まれやすくなります。そのため、企業は積極的に多様な人材を採用し、誰もが能力を発揮できる環境を整備することが求められます。研修制度や交流の場を設けるなど、多様な人材が活躍できる土壌作りが重要です。

| 項目 | 説明 | 例/利点 |

|---|---|---|

| 多様な人材の必要性 | 偏りのない倫理的なAI開発を実現するために重要 | 性別、年齢、国籍、文化背景、専門分野など |

| 文化背景の多様性 | 文化的な違いを考慮したAI開発 | ある文化圏では適切な表現が、別の文化圏では不適切な場合も。多様な人材がいれば、このような問題を回避可能。 |

| 専門分野の多様性 | 技術的課題だけでなく、倫理的課題や社会的影響も多角的に検討可能 | 情報工学、倫理学、哲学、社会学、心理学、法律学など。AIによる失業問題や差別問題への対応も可能に。 |

| 多様なチームの利点 | 創造的で革新的なAI開発を促進、社会全体の進歩に貢献 | 均質なチームより新しいアイデアが生まれやすい。 |

| 企業の役割 | 多様な人材の採用、能力を発揮できる環境整備 | 研修制度や交流の場の設置など |

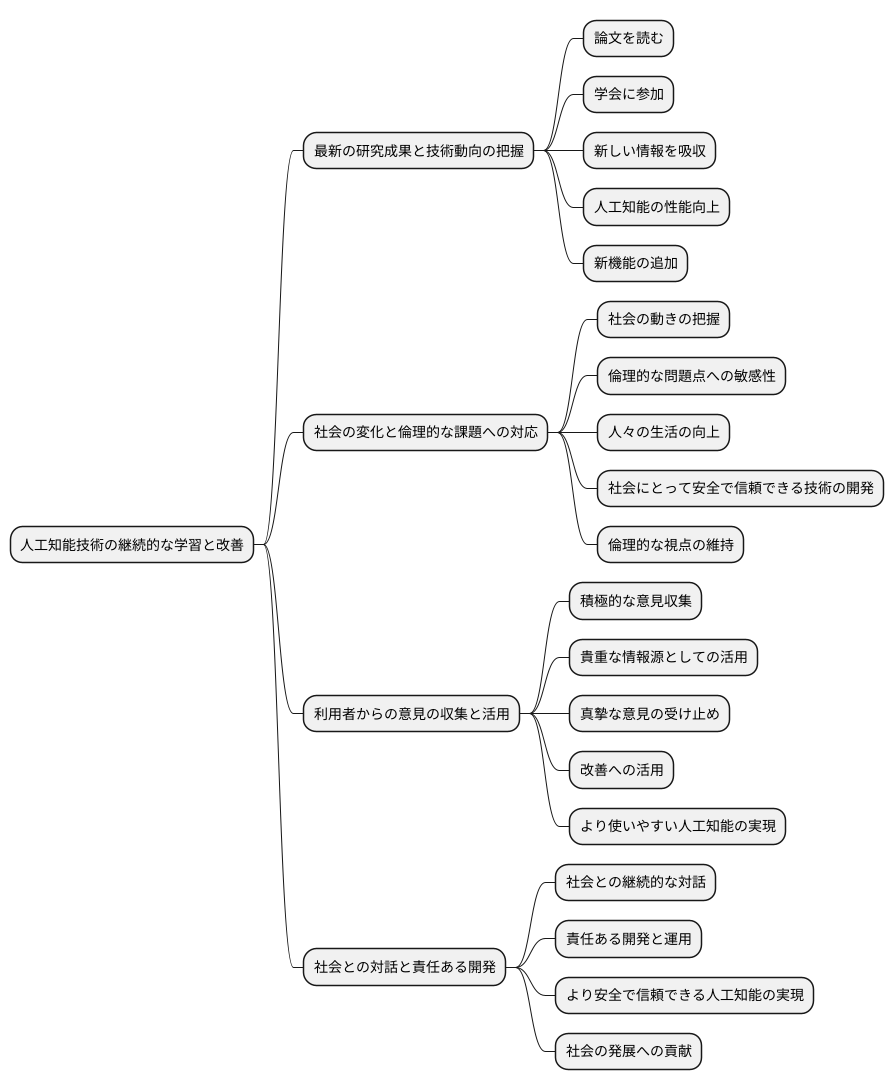

継続的な学習と改善

人工知能技術は、まるで生き物のように常に進化を続けています。それと同時に、私たちの社会のニーズや、私たちが抱える課題も変化し続けています。この変化の激しい状況の中で、人工知能開発に携わる私たちは、継続的な学習と改善を怠ることなく続けることが何よりも重要です。

まず、最新の研究成果や技術動向を常に把握しなければなりません。論文を読み、学会に参加し、常に新しい情報を吸収することで、人工知能の性能をさらに向上させ、より多くの機能を追加していくことができます。まるで、職人が技術を磨き続けるように、私たちも技術の進歩に遅れずについていく必要があるのです。

さらに、社会の変化や倫理的な課題についても学び続ける必要があります。人工知能は社会に大きな影響を与える技術だからこそ、社会の動きや倫理的な問題点について常に敏感でなければなりません。人工知能が人々の生活を豊かにするだけでなく、社会にとって安全で、信頼できる技術であるように、常に倫理的な視点を持ち続けることが大切です。

そして、利用者からの意見を積極的に集め、その声を人工知能の改善に役立てることも忘れてはなりません。実際に人工知能を使う人たちの意見は、開発の現場では気づかない貴重な情報源です。利用者の声を真摯に受け止め、改善に繋げることで、より使いやすい人工知能を実現できるのです。

人工知能は、社会を大きく変える力を持つ技術です。だからこそ、社会との対話を継続し、責任ある開発と運用を行っていく必要があります。継続的な学習と改善を通して、より安全で信頼できる人工知能を実現し、私たちの社会の発展に貢献していくことが、私たちの使命です。